- 目录

- 推荐序

- 前 言

- 1.1 互联网金融的发展和现状1

- 1.2 风险管理类型划分2

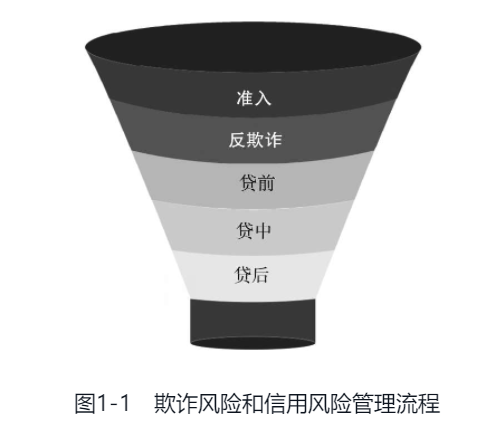

- 1.2.1 欺诈风险4

- 1.2.2 信用风险6

- 1.3 风险管理的重要性10

- 1.3.1 风险评估10

- 1.3.2 差异化定价12

- 1.3.3 整体利润最优13

- 1.4 本章小结14

- 2.1 人工审核15

- 2.1.1 纸质材料评估16

- 2.1.2 电话回访16

- 2.1.3 线下走访尽调17

- 2.2 专家模型17

- 2.2.1 业务规则库17

- 2.2.2 专家调查权重法18

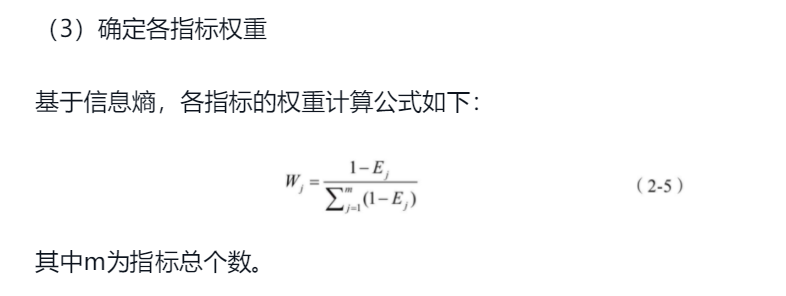

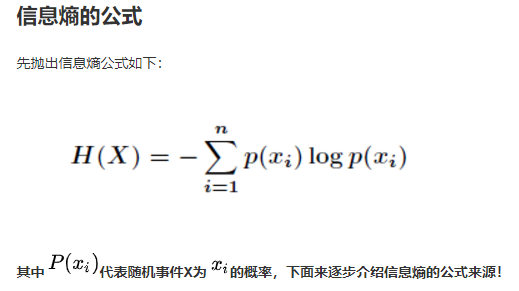

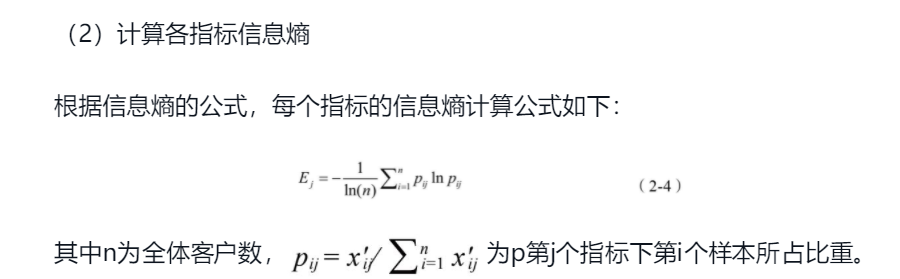

- 2.2.3 熵权法19

- 2.3 评分卡模型21

- 2.3.1 目标定义21

- 2.3.2 样本选取23

- 2.3.3 变量分箱24

- 2.3.4 变量筛选24

- 2.3.5 模型建立29

- 2.3.6 模型评估30

- 2.3.7 模型应用33

- 2.4 传统方法的问题和挑战34

- 2.5 本章小结35

- 3.1 大数据平台36

- 3.1.1 原始数据清洗37

- 3.1.2 数据仓库管理37

- 3.1.3 数据标签应用38

- 3.2 决策引擎38

- 3.2.1 规则配置39

- 3.2.2 模型部署40

- 3.2.3 冠军挑战者41

- 3.2.4 版本和权限管理42

- 3.3 智能反欺诈模型42

- 3.3.1 无监督学习43

- 3.3.2 图计算44

- 3.4 智能信用风险模型45

- 3.4.1 专家模型45

- 3.4.2 逻辑回归46

- 3.4.3 决策树46

- 3.4.4 集成树47

- 3.4.5 深度神经网络47

- 3.4.6 循环神经网络48

- 3.5 智能模型带来的提升48

- 3.5.1 数据广度和深度48

- 3.5.2 模型快速迭代和主动学习49

- 3.5.3 线上自动决策49

- 3.6 统计学与机器学习49

- 3.7 本章小结50

- 4.1 数据源类型51

- 4.1.1 征信报告52

- 4.1.2 消费能力54

- 4.1.3 资产状况54

- 4.1.4 基本信息54

- 4.1.5 黑名单55

- 4.1.6 多头借贷55

- 4.1.7 运营商56

- 4.1.8 地理位置56

- 4.1.9 设备属性57

- 4.1.10 操作行为57

- 4.2 特征工程方法57

- 4.2.1 统计量58

- 4.2.2 离散化58

- 4.2.3 时间周期趋势59

- 4.2.4 交叉项59

- 4.2.5 隐性特征60

- 4.2.6 用户画像61

- 4.3 数据测试与应用61

- 4.3.1 联合建模机制61

- 4.3.2 数据质量评估62

- 4.3.3 线上应用63

- 4.4 数据安全合规63

- 4.5 本章小结64

- 5.1 有监督学习68

- 5.1.1 逻辑回归69

- 5.1.2 决策树70

- 5.1.3 随机森林73

- 5.1.4 梯度提升决策树74

- 5.2 无监督学习76

- 5.2.1 聚类76

- 5.2.2 孤立森林79

- 5.3 深度学习80

- 5.3.1 深度神经网络80

- 5.3.2 循环神经网络83

- 5.3.3 词嵌入86

- 5.3.4 自编码器88

- 5.3.5 迁移学习89

- 5.4 图计算91

- 5.4.1 社区发现91

- 5.4.2 标签传播92

- 5.4.3 图嵌入93

- 5.5 强化学习97

- 5.6 本章小结99

- 6.1 数据清洗101

- 6.1.1 缺失值处理102

- 6.1.2 异常值处理103

- 6.1.3 重复值处理105

- 6.1.4 一致性检验105

- 6.1.5 有效性检验106

- 6.2 特征工程和特征筛选107

- 6.2.1 探索性数据分析107

- 6.2.2 稳定性108

- 6.2.3 重要性109

- 6.2.4 相关性110

- 6.2.5 解释性111

- 6.3 模型训练111

- 6.4 模型部署114

- 6.5 监控预警114

- 6.6 本章小结119

- 7.1 案例背景120

- 7.2 原始数据介绍120

- 7.3 探索性数据分析121

- 7.3.1 交易笔数121

- 7.3.2 交易时间122

- 7.3.3 交易类型123

- 7.3.4 交易IP地址124

- 7.4 特征工程124

- 7.4.1 特征加工124

- 7.4.2 特征筛选130

- 7.4.3 特征分组130

- 7.5 模型训练131

- 7.6 模型评估134

- 7.7 案例优化136

- 7.8 本章小结137

- 8.1 案例背景138

- 8.2 原始数据介绍139

- 8.3 特征工程139

- 8.4 探索性数据分析142

- 8.5 模型训练144

- 8.5.1 逻辑回归144

- 8.5.2 XGBoost150

- 8.5.3 Wide&Deep158

- 8.6 模型评估162

- 8.7 模型应用168

- 8.8 案例优化169

- 8.9 本章小结170

- 9.1 银行POS贷171

- 9.1.1 案例背景171

- 9.1.2 原始数据介绍172

- 9.1.3 特征工程173

- 9.1.4 模型训练173

- 9.1.5 模型应用176

- 9.2 汽车金融CP评级178

- 9.2.1 案例背景178

- 9.2.2 原始数据&特征工程179

- 9.2.3 模型训练179

- 9.2.4 模型评估181

- 9.3 案例优化182

- 9.4 本章小结183

- 10.1 对外输出的意义184

- 10.1.1 内部能力“走出去”185

- 10.1.2 外部资源“引进来”185

- 10.2 头部玩家介绍186

- 10.2.1 互联网公司186

- 10.2.2 银行科技子公司189

- 10.2.3 第三方技术提供商190

- 10.3 合作模式及案例191

- 10.3.1 SaaS 本地化模式192

- 10.3.2 对外输出案例193

- 10.4 金融科技创新与监管195

- 10.5 本章小结197

智能风控与反欺诈v1.0 作者: 蔡主希

备注:红黄蓝三种颜色,依次代表重要性程度,重要性表现为递减。

目录

目录

智能风控与反欺诈v1.0 作者: 蔡主希 1

目录 1

推荐序 6

前 言 6

第1章 互联网金融与风险管理1 6

1.1 互联网金融的发展和现状1 6

1.2 风险管理类型划分2 6

1.2.1 欺诈风险4 7

1.2.2 信用风险6 8

1.3 风险管理的重要性10 11

1.3.1 风险评估10 11

1.3.2 差异化定价12 12

1.3.3 整体利润最优13 12

1.4 本章小结14 13

第2章 传统风险管理体系15 13

2.1 人工审核15 13

2.1.1 纸质材料评估16 13

2.1.2 电话回访16 13

2.1.3 线下走访尽调17 13

2.2 专家模型17 14

2.2.1 业务规则库17 14

2.2.2 专家调查权重法18 14

2.2.3 熵权法19 14

2.3 评分卡模型21 16

2.3.1 目标定义21 16

2.3.2 样本选取23 17

2.3.3 变量分箱24 18

2.3.4 变量筛选24 18

2.3.5 模型建立29 21

2.3.6 模型评估30 21

2.3.7 模型应用33 22

2.4 传统方法的问题和挑战34 23

2.5 本章小结35 23

第3章 智能风控模型体系36 24

3.1 大数据平台36 24

3.1.1 原始数据清洗37 25

3.1.2 数据仓库管理37 25

3.1.3 数据标签应用38 26

3.2 决策引擎38 26

3.2.1 规则配置39 26

3.2.2 模型部署40 26

3.2.3 冠军挑战者41 27

3.2.4 版本和权限管理42 27

3.3 智能反欺诈模型42 27

3.3.1 无监督学习43 27

3.3.2 图计算44 27

3.4 智能信用风险模型45 28

3.4.1 专家模型45 28

3.4.2 逻辑回归46 28

3.4.3 决策树46 28

3.4.4 集成树47 28

3.4.5 深度神经网络47 28

3.4.6 循环神经网络48 28

3.5 智能模型带来的提升48 29

3.5.1 数据广度和深度48 29

3.5.2 模型快速迭代和主动学习49 29

3.5.3 线上自动决策49 29

3.6 统计学与机器学习49 29

3.7 本章小结50 29

第4章 风控大数据体系51 29

4.1 数据源类型51 29

4.1.1 征信报告52 30

4.1.2 消费能力54 30

4.1.3 资产状况54 30

4.1.4 基本信息54 30

4.1.5 黑名单55 30

4.1.6 多头借贷55 30

4.1.7 运营商56 30

4.1.8 地理位置56 31

4.1.9 设备属性57 31

4.1.10 操作行为57 31

4.2 特征工程方法57 31

4.2.1 统计量58 31

4.2.2 离散化58 31

4.2.3 时间周期趋势59 31

4.2.4 交叉项59 31

4.2.5 隐性特征60 32

4.2.6 用户画像61 33

4.3 数据测试与应用61 33

4.3.1 联合建模机制61 33

4.3.2 数据质量评估62 33

4.3.3 线上应用63 33

4.4 数据安全合规63 34

4.5 本章小结64 34

第5章 智能风控中的常用算法68 37

5.1 有监督学习68 37

5.1.1 逻辑回归69 37

5.1.2 决策树70 37

5.1.3 随机森林73 37

5.1.4 梯度提升决策树74 37

5.2 无监督学习76 37

5.2.1 聚类76 38

5.2.2 孤立森林79 38

5.3 深度学习80 38

5.3.1 深度神经网络80 38

5.3.2 循环神经网络83 38

5.3.3 词嵌入86 38

5.3.4 自编码器88 38

5.3.5 迁移学习89 38

5.4 图计算91 39

5.4.1 社区发现91 39

5.4.2 标签传播92 39

5.4.3 图嵌入93 40

5.5 强化学习97 40

5.6 本章小结99 40

第6章 智能模型训练流程101 40

6.1 数据清洗101 40

6.1.1 缺失值处理102 40

6.1.2 异常值处理103 40

6.1.3 重复值处理105 40

6.1.4 一致性检验105 40

6.1.5 有效性检验106 41

6.2 特征工程和特征筛选107 41

6.2.1 探索性数据分析107 42

6.2.2 稳定性108 42

6.2.3 重要性109 42

6.2.4 相关性110 43

6.2.5 解释性111 43

6.3 模型训练111 43

6.4 模型部署114 43

6.5 监控预警114 44

6.6 本章小结119 44

第7章 反欺诈案例120 44

7.1 案例背景120 45

7.2 原始数据介绍120 45

7.3 探索性数据分析121 45

7.3.1 交易笔数121 45

7.3.2 交易时间122 45

7.3.3 交易类型123 45

7.3.4 交易IP地址124 46

7.4 特征工程124 46

7.4.1 特征加工124 46

7.4.2 特征筛选130 46

7.4.3 特征分组130 46

7.5 模型训练131 47

7.6 模型评估134 47

7.7 案例优化136 48

7.8 本章小结137 48

第8章 个人信贷风控案例138 48

8.1 案例背景138 49

8.2 原始数据介绍139 49

8.3 特征工程139 49

8.4 探索性数据分析142 49

8.5 模型训练144 49

8.5.1 逻辑回归144 49

8.5.2 XGBoost150 49

8.5.3 Wide&Deep158 50

8.6 模型评估162 50

8.7 模型应用168 50

8.8 案例优化169 50

8.9 本章小结170 50

第9章 企业信贷风控案例171 50

9.1 银行POS贷171 51

9.1.1 案例背景171 51

9.1.2 原始数据介绍172 51

9.1.3 特征工程173 51

9.1.4 模型训练173 51

9.1.5 模型应用176 51

9.2 汽车金融CP评级178 51

9.2.1 案例背景178 51

9.2.2 原始数据&特征工程179 52

9.2.3 模型训练179 52

9.2.4 模型评估181 52

9.3 案例优化182 52

9.4 本章小结183 52

第10章 智能风控能力对外输出184 52

10.1 对外输出的意义184 52

10.1.1 内部能力“走出去”185 53

10.1.2 外部资源“引进来”185 53

10.2 头部玩家介绍186 53

10.2.1 互联网公司186 53

10.2.2 银行科技子公司189 53

10.2.3 第三方技术提供商190 53

10.3 合作模式及案例191 53

10.3.1 SaaS 本地化模式192 54

10.3.2 对外输出案例193 54

10.4 金融科技创新与监管195 54

10.5 本章小结197 54

推荐序

前 言

第1~3章涵盖风控业务的基础知识,主要介绍了什么是信用风险和欺诈风险,传统风险管理体系中搭建评分卡的思路,以及智能风控时代下大数据平台、决策引擎和智能模型的技术框架。

第4~6章介绍智能风控模型中常见的数据源和算法,其中数学原理和公式较多,适合想了解更多模型知识的业务人员以及想从事建模工作的读者。由于篇幅有限,笔者只选取了与风控和反欺诈场景相关的算法,很多公式的推导和求解过程并没有详细展开。

第7~9章讲解笔者参与过的风控和反欺诈的实战项目,希望帮助读者通过实际案例更好地将风控理念和建模技术融会贯通,缺乏项目经验的读者可以重点关注这部分内容。

第10章是行业内金融科技的头部玩家解析和案例介绍,可帮助读者初步了解智能风控和反欺诈在未来十年的应用方向。

1.1 互联网金融的发展和现状1

广义的互联网金融(简称“互金”)包括互联网贷款、第三方支付、众筹、数字货币、网上银行等多种商业模式。

随着2016年《网络借贷信息中介机构业务活动管理暂行办法》(即我们常说的“P2P管理办法”)、2019年《数据安全管理办法》、2020年《商业银行互联网贷款管理办法》等规定相继出台,国内的互联网贷款行业逐步告别高杠杆、高风险的野蛮扩张时期,转而进入风险可控的健康发展阶段。

注:广义互联网金融,互金包括互联网贷款、第三方支付、众筹、数字货币、网上银行。

1.2 风险管理类型划分2

互联网金融行业中的风险主要可以分为两类:欺诈风险和信用风险。

欺诈风险是指借款人带着欺诈的目的来申请贷款,资金被成功获取后再难收回。这是信贷场景中危害较大的一类风险,占比较低,但是必须严格防范。另外,欺诈风险存在专业性、团体性、变化性等特质,互联网金融行业的快速发展催生了一大批“羊毛党”和“黑中介”,他们通常拥有专业的欺诈技术,并且以团伙形式出现,不断攻击着各个平台的风控漏洞,长期考验着风控人员博弈的能力。欺诈风险多发生在贷款的申请和支用阶段,由于手段样式繁多。

信用风险:是指因借款人发生违约或借款人信用等级下降导致债权人到期不能完全收回本金和利息,从而产生损失的风险。

目前业界对欺诈风险并没有明确的类型划分。笔者结合自身业务经验,将欺诈风险从如下三个角度进行分类:

- ·从欺诈意愿上分为第一方和第三方;

- ·从欺诈主体上分为账户级和交易级;

- ·从欺诈组织上分为个人和团伙。

欺诈风险和信用风险管理环节的组合顺序如图1-1所示,在风险可控的前提下,尽量提升各个环节之间的转化率。

注:两种风险,欺诈风险(带着欺诈的目的来借款;从欺诈意愿上看有第一方、第三方欺诈,从欺诈主体上看有账户级、交易级,从欺诈组织上看有个体、团伙),信用风险(借贷人信用下降不能还款,导致债权人收不回本金的风险,要考虑借贷人的还款意愿和还款能力;信用风险可以从白名单、贷前识别、贷中管理、贷后催收这四个方面入手)。

债权人=是指银行等金融机构借贷人和供应商。

欺诈风险和信用风险管理环节:准入>反欺诈>贷前>贷中>贷后,在风险可控下尽量提高各个环节的转化率。

1.2.1 欺诈风险4

1.第一方和第三方

所谓第一方欺诈,是指借款人主动发起的欺诈行为;相对的,第三方欺诈是指借款人在身份被冒用或者账户被盗用的情况下,被动发生的欺诈行为。

对于第三方欺诈的识别,目前各大金融机构普遍采用四要素验证(姓名、身份证、手机号、银行卡号)和活体识别这两个技术手段,有效遏制了非本人操作行为的发生。但是,对于中介申请或者电信诈骗,由于借款人是在欺诈分子诱导下进行的本人操作,单纯利用四要素验证或者活体识别并不能很好地进行判断,因而还需要加入其他反欺诈策略,进一步提高召回率。

相较于第三方欺诈,第一方欺诈隐蔽性更强,并且手段灵活多变,提高了风控人员的工作难度,目前业界常用的手段是针对首支首逾和“羊毛党”这两类特定客群进行识别。

首支首逾是指借款人在首次支用后的首个还款日逾期的行为,如果逾期时间较长,则会被机构认定为欺诈客群。首支首逾率通常是各个机构考核反欺诈人员的重要指标,搭建针对性的模型和策略方案,是反欺诈人员的工作重点之一。

还有一类常见的第一方欺诈是“羊毛党”,“羊毛党”分子通过非法手段获取个人信息,注册虚假账户,用来“薅取”互联网金融机构发放的现金券、礼品券等,让机构受损失。对于“羊毛党”,可以从设备指纹、地理位置、WiFi MAC地址、注册时间这几个方面来识别,找出批量操作的客群。

2.账户级和交易级

区分了欺诈风险发生的意愿后,下一步需要确定欺诈的主体,进而制定不同的管控策略。例如首支首逾、“羊毛党”等第一方欺诈案件,在核实无误的情况下,可以将账户或者设备拉入黑名单,杜绝该账户或者设备之后发生的任何申请和支用行为。利用首支首逾的历史样本,还可以搭建离线的欺诈评分模型,定期在全量账户上进行批量预测,对于分数较低的账户可以提前预警或者冻结。

而对于中介申请、电信诈骗这类第三方欺诈案件,以及“羊毛党”等通过单一账户属性难以识别的第一方欺诈案件,则需要实时采集客户每笔交易的地理位置、设备属性和操作行为等数据,在保证拦截率的情况下尽可能提高召回率。交易级的实时模型和策略对于机构系统的实时采集和计算能力是个比较大的考验,但是只有真正具备了这一能力,机构才能更好地应对层出不穷的欺诈手段。

3.个人和团伙

常见的欺诈类型从组织上又可以分为个人和团伙两种。传统的反欺诈策略和模型多针对个人案件,而团伙案件一直是反欺诈人员比较头疼的问题。为了解决这一痛点,关联图谱被逐渐应用到团伙反欺诈的场景中。关联图谱基于客户的身份证、手机号、银行卡号、设备指纹、地理位置、WiFi MAC地址等属性,构建客户与客户之间的关系,从个人欺诈出发,深挖背后的团伙组织。关联图谱的应用方式有很多,简单的可以直接制定规则,提取客户之间的聚集度,识别中介申请和“羊毛党”;复杂的可以利用社区发现和标签传播等算法,智能地划分团伙并且量化个人的潜在欺诈风险。

1.2.2 信用风险6

1.白名单准入

白名单是信用风险管理的第一道门槛,与整个平台贷款产品的设计和定位有紧密的联系。白名单设立的初衷是圈定目标客户,有了目标客群之后才能更好地进行精准营销,并且使得后续的风控流程利润最大化。同时在贷款产品上线初期,由于缺乏足够的数据积累,难以搭建完善的风控模型,因此白名单也是冷启动阶段较为常见的一种风控手段。白名单的制定通常会从政策要求、风控能力和客户画像3个方面考虑。

首先,政策要求是重中之重,监管部门的相关政策是每个金融从业人员应该守住的底线,在互联网金融机构的信贷业务中,年龄和定价是两根红线。

年龄:22岁-60岁

定价:对于定价,监管条例中规定,现金贷产品的综合年化利率不得超过36%,因此对于前期测算综合成本有可能超过36%的客群,也不应当纳入白名单中。(目前我国的法律法规,并未明确否定该种模式。而结合最高人民法院、最高人民检察眼、公安部、司法部印发的《意见》规定,国家严厉打击的未经监管部门批准的非法放贷行为或者超越经营范围,以营利为目的,2年内向不特定多人以借款或其他名义出借资金10次以上的或者非法放贷的年利率超过36%等放贷行为。 36%是国家法律红线)

其次,作为风险管理的一部分,风控能力自然是影响白名单制定的重要因素。与后面的几个信用风控环节相比,白名单部分侧重于硬规则的制定,触碰硬规则的客群由于存在重大风险隐患,也会被风控人员排除在外。例如,大多数平台都会将注册时长和活跃度这两个因素放到准入规则中,理由是如果借款人在平台的注册时间过短或者活跃度过低,一方面平台方无法判断借款人是否是为了骗贷而特意注册开户的,另一方面这类客户在平台侧的数据量太少,给风控模型的信用判断造成了极大困难,因而不被白名单所接受。

最后是客户画像,客户画像规则通常与贷款产品关注的人群有关。对于纯粹的现金贷产品,由于此类产品适用于大多数人群,在白名单中可以不考虑特定的客户画像指标。但是,对于具有特定场景和人群的贷款产品,例如教育分期、医美分期、滴滴司机贷等,抓住这些指向性客群背后的信用规律,并且归纳成规则放入白名单准入环节中,可以大大降低风险,提升产品的运营效率。

2.贷前识别

贷前识别是整个信用风险管理中最重要的一个环节,一套良好的贷前识别体系能够规避70%以上的潜在风险。

同时,贷前识别环节具有客户触达人数多、数据维度丰富、信用风险存在规律性等先天优势,是大数据风控模型应用最为成熟的一个模块。

如本节开头所述,信用主要包含还款意愿和还款能力这两个方面,大多数信用风险的出现都是由于平台授予的贷款额度与客户这两方面情况不匹配所造成的。

因此基于客户申请授信环节准确的信用评估,并且给出最合理的额度和利率,是风控从业者永恒的话题。

对于还款意愿的衡量,行业内通常的做法是搭建申请评分卡(ApplicationCard)。

目前M1+的模型KS基本可以做到0.35,M3+的模型KS甚至可以达到0.45以上,已经远高于人工审核的准确率。

(补充:“m1”所指的时间段是“未还款的第二个账单日到第二次账单的最后还款日之间”。在这个时间段内,银行采取的是提醒式催收,并且对未还款项进行罚息,收取滞纳金。

“m2”所指的时间段是“未还款的第三个账单日到第三次账单的最后还款日之间”。在这个时间段内,银行催收员会打电话告知不还款的后果。如有必要会联系欠款人的亲属、朋友,协助欠款人还款。

“m3”所指的时间段是“未还款的第四个账单日到第四次账单的最后还款日之间”。在这个时间段内,银行采取的是强压式还款,催收员会通过电话、短信以及律师函等要求欠款人还款。

逾期账龄是指超过三年以上未收回的账款或未付的账款,财务上称逾期账龄。

逾期账龄所造成的逾期账款就是指在约定的账面应收回日期到期之后,仍然没有账面现金流入的应收帐款,有坏账风险,账龄越长,风险越大。在超过一定的账龄的时候需要对逾期应收账款做出坏账计提准备。

账龄(Account receivable age),指公司尚未收回的应收账款的时间长度,通常按照各自企业合理的周转天数将其划分为5个级别,如30天以内(合理的周转天数设定为30天)、30-60天、60-120天、120天以上及呆账(120天以上未产生销售额)。详细的账龄信息在财务报告附注有关应收账款的部分提供。

)

在贷前识别环节,只是评估客户的还款意愿显然是不够的,风控人员还需要将还款能力纳入评估体系内。这就要用到价值模型(Value Model)。相较于申请评分卡有是否逾期这一明确的目标定义,客户价值的高低在不同平台的定义各不相同,有些平台考虑客户的收入,有些平台则会考虑客户带来的利润,因而价值模型的目标可以根据平台的实际业务需求来制定。模型变量方面,价值模型通常更关注金融属性方面的指标,传统金融机构一般从收入、资产、负债三个角度来选取指标,而对于互联网金融机构来说,则会基于自身数据的特色,加入客户的商品消费习惯和金融场所出行习惯等,一定程度上丰富了价值模型的维度。

搭建兼具准确性、区分度和稳定性的申请评分卡和价值模型。

价值模型介绍:

客户价值模型是一个复杂的财务模型,但它可以表明与竞争产品相比,某个供应商能够提供的价值。客户价值模型的重要性和特色就在于:该模型是建立在彻底调查卖方产品所有的构成因素、尤其是卖方产品对其客户的成本构成和利润的影响的基础上。

https://wiki.mbalib.com/wiki/%E5%AE%A2%E6%88%B7%E4%BB%B7%E5%80%BC%E6%A8%A1%E5%9E%8B

3.贷中管理

借款人一旦在贷前环节通过了授信申请,就进入了贷中管理环节,这个环节主要是监控和调整,对于贷前识别的结果进行查漏补缺。目前市面上的互联网金融贷款产品额度授信方式主要分为一次性额度和循环额度两类,不同的授信方式带来的贷中管理策略也会有很大的不同。

首先解释下一次性额度和循环额度的区别。

一次性额度,就是在客户的贷款申请通过后,机构主动地、一次性地将全部额度打到客户的银行账户上,解决客户短期内的燃眉之急,常见于银行的房贷、经营贷等大额商业贷款。(一次性额度是房贷、经营贷等)

而循环额度是指客户在贷款申请通过后获得预授信的额度,在需要的时候由客户主动发起支用,并且在客户偿还账单后额度可以实时恢复,例如银行的信用卡业务就是一款非常典型的循环额度产品。(循环额度就是信用卡、花呗类型)

对于循环额度类的产品,搭建行为评分卡(Behavior Card)是一种常见的技术手段。与申请评分卡一样,行为评分卡的预测目标也是客户在未来一段时间内是否会发生逾期。不过模型指标在申请评分卡的基础上,又多了贷中行为这一大类数据,通过加入客户支用、还款、逾期等数据,行为评分卡可以更好地刻画出客户近期的还款能力和还款意愿,帮助机构做出相应的支用和额度策略的调整。

4.贷后催收

相比于贷前识别和贷中管理,贷后催收更重运营,如何在可控的成本范围内,根据逾期案件的严重程度,为不同账户分发不同的催收方式和催收团队,是贷后管理环节的风控人员需要考虑的问题。

司,暴力催收的行为也被整个行业严厉杜绝。在整个行业合规的大环境下,精细化和智能化的贷后运营成为了提高催回率最有效的方式。

为了实现精细化的分案,主要的方法是利用催收评分卡(Collection Card)衡量客户逾期的严重程度,根据严重程度分发给不同力度的催收方式和团队。催收评分卡基于已经发生逾期的样本群体建立,目标是预测这些样本是否会在未来一段时间内发生更严重的逾期。相比于贷前和贷中的特征,催收评分卡又多了与催收相关的贷后特征,比如进入催收队列的持续时长、催收阶段成功还款的金额等,这些特征都提升了模型对于贷后人群的区分能力。

1.3 风险管理的重要性10

互联网金融行业发展至今,早期头部机构的流量红利已经消失殆尽,取而代之的是互联网时代下半场的精细化运营。在这一阶段,风险管理就显得尤为重要。在传统认知中,风控人员只是一味“踩刹车”,大家普遍认为控制坏账率就是风控人员的全部工作。其实防范坏账发生只是风控人员工作的一部分,__风控的本质应该是在坏账率满足条件的情况下使得整体利润最优,风控人员更像是一个控制“刹车”和“油门”的节拍器,风险管理应该是从风险评估、差异化定价到最终实现整体利润最优的三级火箭模式。

1.3.1 风险评估10

对于传统银行来说,贷款可以按照风险程度划分为正常、关注、次级、可疑和损失五类,其中后三类合称为不良贷款,根据银保监会要求,不良贷款余额占总贷款余额的比重不得超过5%。

对于借款人风险的评估,主要还是从综合欺诈和信用两个方面入手。

对于存在欺诈风险和高信用风险的客户,平台一般不授予其贷款额度;对于信用风险较低的客户,风控人员会利用申请评分卡量化其风险水平,将不同的人匹配到不同的区间内,实现风险分层的目的,指导下一步的差异化定价。风险分层如表1-1所示,其中申请评分卡700分以上的为低风险客群,640分以下的为高风险客群,640~700分的为中风险客群。

1.3.2 差异化定价12

在风险评估的基础之上,下一步要做的事情就是给不同的客群分配不同的贷款额度和利率,也就是风险管理流程中的“第二级火箭”——差异化定价和利率。对于机构来说,定价模型直接决定了产品最终的利润。如果机构对于借款人都给予相同的额度和利率,势必会造成好客户额度过低、坏客户额度过高的情况,又由于坏客户的逾期概率一定高于好客户,则会导致在逾期人数相同的情况下,该机构会损失更多的利润。同时,由于好客户一定是市面上所有互联网金融机构的目标客群,如果一个机构给出的额度和利率吸引力不足,这些好客户必定会流向其他平台,这对于平台来说是一种更大的损失。考虑到以上两个问题,差异化定价应当是所有风控人员必备的能力。

简单的差异化定价,可以直接利用客户风险分层的结果,对于风险较小的客群给予高额度和低利率,对于风险较高的客群则给予低额度和高利率。而对于技术能力较强的机构,如果在申请评分卡以外还搭建了一个效果较好的价值模型,则可以通过二维矩阵的方式,综合考虑客户的还款能力和还款意愿,给出更为合理的额度。在定价模型中,利率通常直接与申请评分卡所预测的逾期风险挂钩,最高利率不得超过监管所设置的上限;额度则需要风控人员和财务人员一同制定,在财务人员测算的综合成本的基础上,风控人员考虑逾期损失,根据经验和计算给出能够盈利的最合理的额度。

1.3.3 整体利润最优13

上述的差异化定价是一种比较理想的情况,其中忽略了一些实际工作中存在的变量,这就要求专业的风控人员具备让整体利润最优的能力,也就是风险管理流程中的“第三级火箭”。

目前业内比较常见的方案有两种:息费敏感性测试和利用模型的在线学习。

息费敏感性测试,是指机构在线上配置多个实验组,不同的实验组给予不同的额度,利用线上的实际表现搜集客户关于额度的使用率、逾期表现等数据,再将这些实际数据纳入利润公式中,找出最优额度。不过由于风险表现的滞后性,通常需要3个月以上才能够观察到部分逾期表现,因而息费敏感性测试所需要的时间成本较高,适用于针对长期阶段的定价方案调整。

为了短期内优化已有的定价方案,在有一定放款数据的基础上,可以尝试利用模型的在线学习方式。这种方法拟合额度关于使用率、逾期表现等变量的曲线,以模型的方式进行预测,给出初始的授信额度,然后在模型上线后,实时调整使用率和逾期表现的拟合曲线,使得线上额度的分配逐步接近最优方案。

在实际应用中,建议两种方案相结合使用,模型的在线学习可以解决短期内额度不合适的痛点,但要想彻底根治,还是需要通过息费敏感性测试长期积累数据来优化。

1.4 本章小结14

本章首先回顾了国内互联网金融行业的发展和现状。在愈发强调合规的当下,监管部门对于各家互联网金融机构的风控能力提出了更高的要求。在互联网金融场景下,风险主要包括欺诈风险和信用风险,其中欺诈风险占比较低但是危害极大,信用风险则更为常见,需要两类风险管控环节有机的结合。风险管理不仅仅是控制机构的贷款坏账率,更应该实现从风险评估、差异化定价到最终实现整体利润最优的三级火箭模式。下一章我们将从传统风险管理体系入手,帮助读者了解风控领域的基础知识,同时认识到传统方法存在的一些问题和挑战。

2.1 人工审核15

信贷业务刚刚开展的早期,由于金融机构信息化建设较为落后,人工审核几乎是核验借款人资质和意图的唯一方式,信审团队的人员质量直接决定了机构的放款额以及逾期率。

智能风控时代的系统和模型,也正是借鉴了信审专员这两方面的思考路径。

2.1.1 纸质材料评估16

早期贷款申请的第一个步骤便是由客户提供一系列的纸质材料,包括个人信息表、身份证、户口本、银行流水、收入证明、征信报告等,部分类型贷款还需要营业执照、房产证明或其他担保证明。

2.1.2 电话回访16

电话回访的主要目的是核实借款人提供的材料的真实性,有时会通过联系借款人身边的朋友或者公司的同事来搜集更多关于借款人的信息,以此判断是否有信用风险和欺诈风险。

通常这些评价体系会围绕如下几个方面:及时接听情况,电话中的语气,回答的流畅程度和准确性,是否有其他负向信息等。一旦借款人在接听电话过程中出现异常行为,信审专员便有理由怀疑这笔贷款的申请目的,给出一个较低的额度甚至拒绝审批。对于贷款额度较大或者信用评估较低的客户,信审专员还会回访借款人身边的人,通过交叉比对的方式来证明材料的真实性和完整性。

2.1.3 线下走访尽调17

线下走访尽调是在经营类贷款和小微企业贷款中比较常见的风险管理方式,目的是实地了解借款人名下企业的经营状况和信用资质,避免材料造假的行为。

2.2 专家模型17

2.2.1 业务规则库17

形成规则库是专家模型中最简单也是最直观的方式,业务专家将多年的行业经验总结成一条条规则,提供给信审专员,用来比对借款人的资质和审核贷款流程。

业务规则库通常包括政策规则和风控规则两方面。

政策规则通常根据机构或者监管部门的硬性要求来制定,借款人的年龄和贷款的最高利率都属于这一范畴。政策规则通常较少,一旦制定很少会变动。

风控规则则更加多样和复杂,业务专家会从客户属性、还款能力、资产状况、信用历史、黑名单等多个维度来衡量和制定规则,大型的金融机构的风控规则甚至多达上千条,力求面面俱到,涵盖各类客群和贷款产品的信用风险以及欺诈风险。

由于业务规则存在较高的误拒率,在智能风控的体系中,除去白名单准入和反欺诈黑名单这两个硬性环节,其他风险管理环节都更建议利用模型的方式对借款人做出更精准的识别。

2.2.2 专家调查权重法18

随着规则库的不断增加,部分业务专家也开始考虑将多个弱指标融合成一个指标,这样可以解决单个弱指标制定的规则区分度不强的问题。在具体实施过程中,专家团队被要求独立地填写调查问卷,选取自己认为重要的指标并赋上对应权重,最后由大家讨论确定权重模型。

2.2.3 熵权法19

专家调查权重法还是更多依赖于专家团队的主观意见,这就可能造成给出的定性指标有可能脱离于当前业务的实际情况而存在的问题。为了杜绝这种经验主义,更为量化的熵权法(Entropy Weight Method)被引入风险管理的场景中来。

通过信息熵去确定权重。(有点类似变异系数法)

(来源:https://www.cnblogs.com/loubin/p/11330576.html)

这里我再说一个对信息熵的理解。信息熵还可以作为一个系统复杂程度的度量,如果系统越复杂,出现不同情况的种类越多,那么他的信息熵是比较大的。

如果一个系统越简单,出现情况种类很少(极端情况为1种情况,那么对应概率为1,那么对应的信息熵为0),此时的信息熵较小。

2.3 评分卡模型21

从20世纪80年代美国征信巨头Fair Isaac推出第一张评分卡FICO开始,评分卡模型(Scorecard Model)逐步替代专家模型,成为传统金融机构最为依仗的信用评级方法。

2.3.1 目标定义21

在评分卡模型中,逾期的定义即为模型学习的目标,不同的逾期定义会导致模型适用的场景发生变化。对于银行来说,通常M3+(历史最大逾期天数超过90天)会被定义为逾期。而对于互联网金融机构来说,由于贷款产品普遍期限较短,客户的逾期表现就会暴露得更早,因而需要通过滚动率分析(Roll Rate Analysis)找出最适合的逾期定义。滚动率分析通过观察客户在各个贷款状态间的转移概率提前找出稳定的逾期定义。

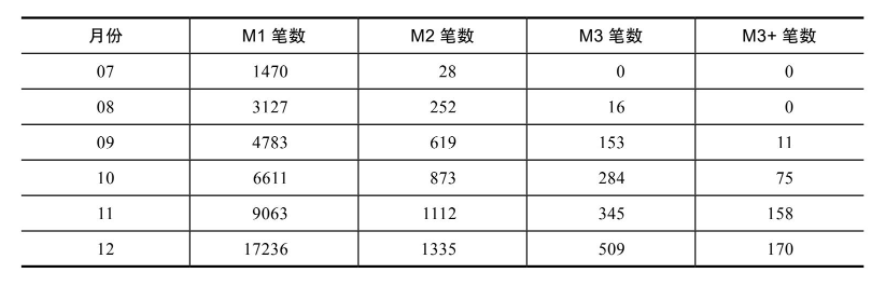

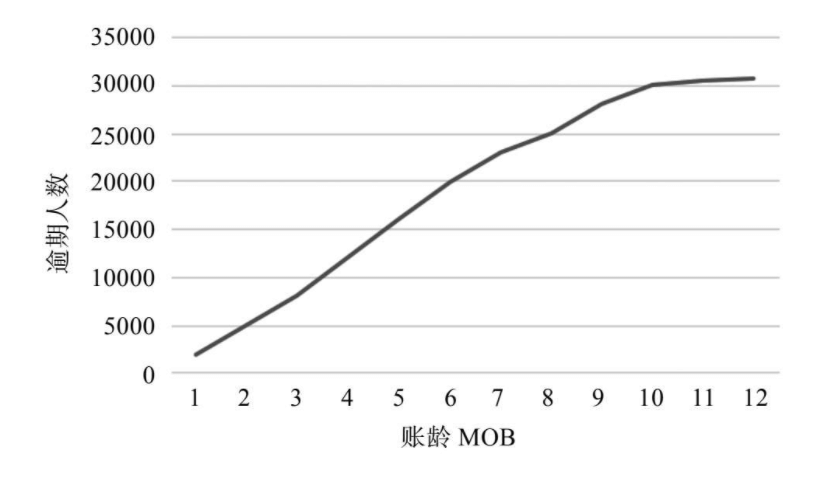

表2-5 某互联网金融平台逾期状态分布表

根据每个月的逾期状态,可以计算出每个月借据单的滚动率,如表2-6所示。例如2017年7月M1—M2的滚动率为2017年8月M2笔数除以2017年7月M1笔数,即252/1470=17.14%;2017年7月M2—M3滚动率为2017年9月M3笔数除以2017年8月M2笔数,即153/252=60.71%。

表2-6 某互联网金融平台滚动率分析表

从表2-6可知,该互联网金融平台客户M2—M3和M3—M3+的滚动率均超过50%,说明一旦客户逾期超过30天,很大概率会转化为逾期超过90天,可以考虑将M1+(历史最大逾期天数超过30天)定义为逾期。

注:预期的定义,银行通常是M3+,互金通常以滚动率来确认,滚动率突破50%的界限为逾期标准(比如M1-M2滚动率低于50%,M2-M3高于50%,M3-M3+高于50%,则定义M1+为逾期较好;也就是发现一个突变的临界条件)

2.3.2 样本选取23

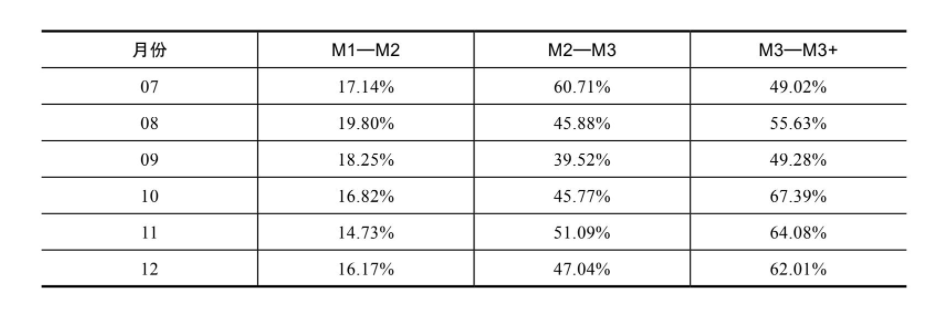

确定了逾期定义之后,我们需要选取建模样本来拟合得到评分卡模型。对于建模样本的选取,如果距今时间较长,选取的客户样本特性可能与当前的新增客户差异较大,导致用学习到的模型预测当前客户效果不佳;如果距今时间较短,近期申请客户的贷后表现还不充分,也会使得模型在学习过程中误把潜在的逾期客户当作正常客户,导致总结出错误的客户特性。因而我们需要定义观察期和表现期,观察期为建模样本横跨的历史区间,表现期则为模型预测的时间长度,如图2-1所示。

观察期 6-24个月

表现期 3-12个月

图2-1 观察期和表现期

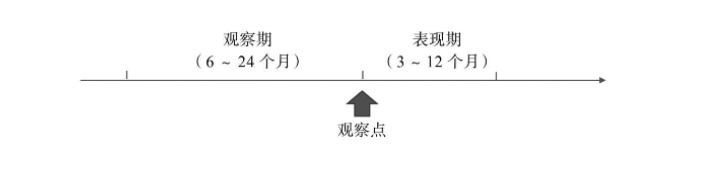

为了找到最合理的观察期和表现期,通常会利用账龄分析(Vintage Analysis)的方法,观察所有核准后的客户在每个账龄上的逾期表现,从而确定表现期的长度。

图2-2 某互联网金融平台账龄分析曲线

我们仍然以某互联网金融平台的逾期样本为例,观察不同账龄下逾期人数的变化,可以看到放款9个月后逾期人数的增长趋于平缓,说明9个月是账户的成熟期,可以作为该平台客户表现期的长度。

2.3.3 变量分箱24

在评分卡模型的开发中,风控人员会倾向于将所有的变量分箱做离散化处理,这样做一是可以提高模型的稳定性,二是可以更好地观察每个变量和逾期的趋势关系。通常一个连续型变量会按照样本个数平均分为10~20个区间,离散型变量不做操作或者合并一些较为接近的区间,缺失值单独作为一个区间。分箱后的变量在各个区间内的逾期样本数量占比要求具有一定的单调性,并且趋势与业务经验一致,否则去除该变量。

2.3.4 变量筛选24

传统的评分卡模型通常只能容纳10~15个变量,这是因为过多的变量会在线性模型中相互影响,降低每个变量权重的置信度,并且加重后期模型维护的负担。因此,需要一个变量筛选的环节,找出一个客户的若干个最具有代表性的特征。变量筛选通常从稳定性、信息值、相关性、解释性四个方面考虑。

(1)稳定性

PSI指标

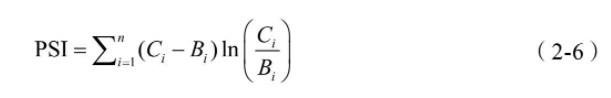

稳定性是评分卡入模变量需要考虑的首要条件,因为只有稳定的模型才能给业务人员的风险决策提供可靠的量化指标,稳定性通常利用群体稳定度指标(PopulationStability Index,PSI)来评估。PSI描述的是不同条件下样本分布的差异,计算公式如下:

其中n为区间数,Bi为基准组样本在第i区间内占比,Ci为对照组样本在第i区间内占比。一般而言,小于0.1说明变量稳定性高,0.1~0.25说明变量稳定性一般,0.25以上说明变量稳定性低。

(2)信息值

信息值(Information Value,IV)是评分卡模型中衡量变量重要性的指标。通常来说,小于0.02说明变量无预测能力,0.02~0.1说明变量具有弱预测能力,0.1~0.3说明变量具有中预测能力,0.3以上说明变量具有强预测能力。IV的计算基于证据权重(Weight of Evidence,WOE),WOE衡量了一个变量各个分箱区间内逾期样本的分布情况,绝对值越大说明该区间内逾期样本和正常样本的区隔程度越高。第i个区间WOE的计算公式如下:

好的分布比上坏的分布取对数。

其中Bi是该区间内的逾期样本数,BT是总的逾期样本数,Gi是该区间内的正常样本数,GT是总的正常样本数。

对于变量的IV,其实是该变量各个区间WOE的加权和,计算公式如下:

其实IV也就就是变量对区分好坏的一个标识情况。

其中n是该变量的分箱区间总数。

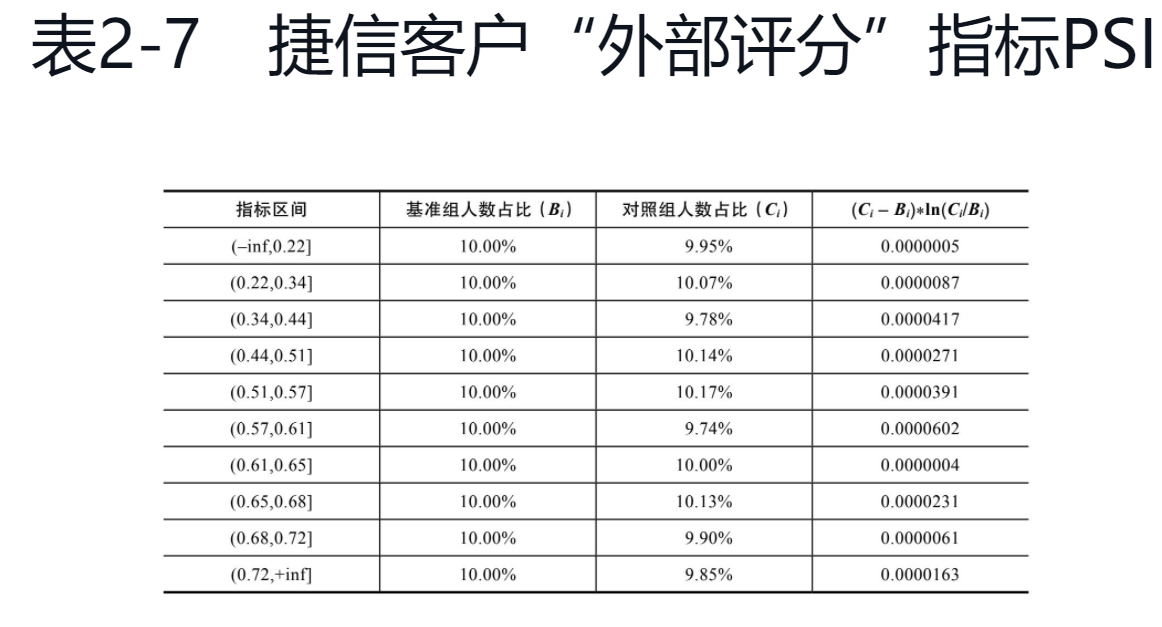

(3)相关性

变量的相关性包括单变量之间的相关性(Correlation)和多变量之间的共线性(Multicollinearity)。线性相关线,皮尔逊相关系数、斯皮尔曼相关系数、等阶什么的..

还要VIF 共线性检验。

(4)解释性

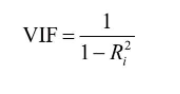

在最终进入模型训练之前,还需要检查每个入模变量的解释性。这里要求变量WOE的分布具有一定的单调性,说明逾期率在每个区间内呈现递增或者递减的趋势,方便后期给出客户信用评分的减分原因和优化意见。如果重要变量WOE不满足单调性,可以尝试合并相邻的区间重新计算WOE;如果调整区间后变量的单调性依然难以保证,则只能将该变量筛除。

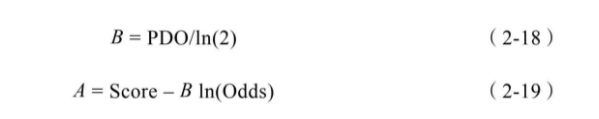

对于捷信客户样本中的另一个指标“贷款年费”,虽然IV值较高,但是WOE分布的单调性较差,客群的逾期率随着“贷款年费”先降低再升高,违背指标解释性的要求,所以从入模变量中剔除。该变量的WOE如图2-4所示。

2.3.5 模型建立29

因此评分卡模型采用最经典的逻辑回归(Logistic Regression,LR)

2.3.6 模型评估30

(1)准确性

AUC(与其他衡量准确性的指标相比,AUC具有较好的稳定性,不会受到正负样本分布不均衡的影响。)

(2)区分度

区分度(Kolmogrov-Smirnov,KS)主要衡量了模型对于正样本和负样本的最大间隔距离。某种意义上来说,在评分卡模型的评估指标中,区分度的重要性甚至更胜于准确性,因为区分度能够更好地看出正常客户和逾期客户分布上的差异,是对于模型排序能力的综合评估。绘制KS曲线,首先将样本按照模型的预测结果从小到大排序,计算不同分数下好坏样本的累积占比(Cumulative DistributionFunction,CDF)曲线,CDF曲线间隔的最大值即为KS。

在实际风控场景建模过程中,KS的上限与逾期定义具有很强的联系,逾期定义越严格意味着本身好坏人差异较大,利用模型也更加容易把坏人区分出来。通常M1+的评分卡模型KS在0.3左右,M3+的评分卡模型KS能够达到0.4。

(3)稳定性

与变量筛选时类似,对于最终模型的结果也要进行稳定性分析,评估指标与变量一样也是PSI,小于0.1可以证明模型结果较为稳定。

2.3.7 模型应用33

分数映射

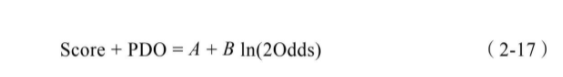

由于逻辑回归输出的是[0,1]区间内的概率,不利于业务人员直接使用,因而我们还需要做分数映射,得到最终的评分卡模型。传统的评分卡模型遵从如下映射公式:

其中Score代表模型最终输出的分数,Odds代表该分数对应的好坏比,A和B是需要确定的参数。

通常我们希望评分卡模型分数每隔一个固定值则对应的好坏比可以加倍,由此得到下式:

其中PDO(Point Double Odds)代表分数间隔的固定值。求解上式可得:

令Score=600,Odds=10,PDO=20,代入公式(2-18)和公式(219)中求得A和B,进而将A和B代入公式(2-16)计算得到每个客户的信用评分。

2.4 传统方法的问题和挑战34

(1)数据质量差

(2)人力成本高

(3)审批流程慢

(4)迭代周期长

2.5 本章小结35

本章介绍了传统风险管理体系中常用的三个方法:人工审核、专家模型和评分卡模型。在评分卡模型中,需要通过滚动率分析找到合适的逾期定义,并且利用账龄分析确定表现期的长度。在模型训练前从稳定性、信息值、相关性、解释性四个方面进行变量筛选,基于逻辑回归训练模型,随后从准确性、区分度和稳定性三个方面评估模型效果。传统的风控体系已经被验证是行之有效的,然而在互联网金融场景下却面临极大的挑战。本章中涉及了部分实战案例,更多内容将在第7~9章中详细展开。

第3章 智能风控模型体系36

在智能风控时代,许多头部的互联网金融公司已经能够实现纯线上自动化审贷,这无疑大大提升了客户申请贷款的效率和体验。自动化审贷主要依赖于三大核心技术:大数据平台、决策引擎和智能模型。其中大数据平台是基础,为线上的模型和策略提供了高质量的数据保障;决策引擎是媒介,承载了风控人员部署的模型和策略,输出客户的决策结果以及额度利率;智能模型是大脑,类似于传统风险管理体系中业务专家的角色,将原始数据提炼成组合规则和复杂模型,从而实时预测借款人的风险水平以及匹配的定价区间。

3.1 大数据平台36

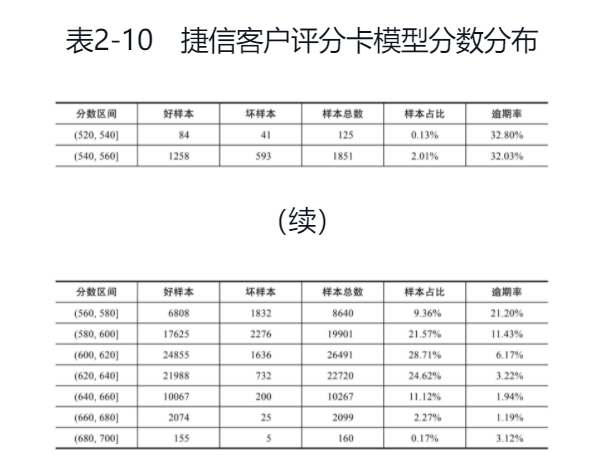

大体上来说,大数据平台可以分为ODS、DW和DM三层,分别对应着数据清洗、数据管理和数据应用这三个核心功能,一个典型互联网金融公司的数据架构通常如图3-1所示。

操作性数据(Operational Data Store) 简称ODS,作为数据库到数据仓库的一种过渡形式,与数据仓库在物理结构上不同。ODS存储的是当前的数据情况,给使用者提供当前的状态,提供即时性的、操作性的、集成的全体信息的需求。ODS作为数据库到数据仓库的一种过渡形式,能提供高性能的响应时间,ODS设计采用混合设计方式。ODS中的数据是”实时值”,而数据仓库的数据却是”历史值”,一般ODS中储存的数据不超过一个月,而数据仓库为10年或更多。

特征:

- ODS直接存放从业务抽取过来的数据,这些数据从结构和数据上与业务系统保持一致,降低了数据抽取的复杂性。

- 转移一部分业务系统的细节查询功能,因为ODS存放的数据与业务系统相同,原来有业务系统产生的报表,现在可以从ODS中产生。

- 完成数据仓库中不能完成的功能,ODS存放的是明细数据,数据仓库DW或数据集市DM都存放的是汇聚数据,ODS提供查询明细的功能。

- ODS数据只能增加不能修改,而且数据都是业务系统原样拷贝,所以可能存在数据冲突的可能,解决办法是为每一条数据增加一个时间版本来区分相同的数据。

数据仓库(Data Warehouse) 简称DW,顾名思义,数据仓库是一个很大的数据存储集合,出于企业的分析性报告和决策支持目的而创建,对多样的业务数据进行筛选与整合。它为企业提供一定的BI(商业智能)能力,指导业务流程改进、监视时间、成本、质量以及控制。

数据集市(Data Mart)简称DM,是为了特定的应用目的或应用范围,而从数据仓库中独立出来的一部分数据,也可称为部门数据或主题数据(subjectarea)。在数据仓库的实施过程中往往可以从一个部门的数据集市着手,以后再用几个数据集市组成一个完整的数据仓库。需要注意的就是在实施不同的数据集市时,同一含义的字段定义一定要相容,这样再以后实施数据仓库时才不会造成大麻烦。

具体参考:

https://zhuanlan.zhihu.com/p/263445563

https://mp.weixin.qq.com/s?src=11×tamp=1619321730&ver=3029&signature=O4WKgRl5wWVSQGGW1u6F8KlUT8Tz9syDOj9*0l7uB8awOKP4lA6BtOdtC4eHdwXRXRtoz5CmZZTFCDwde-HTbR-8OuiLE3CS3sdLCua0mfO-BoCtRGIv3nsu-FUrfV&new=1

3.1.1 原始数据清洗37

操作数据存储(Operational Data Store,ODS),又被称为贴源层,是原始数据经过ETL(Extract-Transform-Load)清洗后存储的位置。ODS通常有如下几个作用。

·在业务系统和数据仓库之间做了隔离,将业务系统产生的原始数据备份的同时,保证了两个系统之间数据的一致性。

·存储了业务侧的明细数据,方便后续的查询和加工以及报表的产出。

·完成数据仓库中不能实现的一些功能,相比于DW和DM层通常使用Hive查询,ODS一般利用更底层的编程语言加工而成,可以实现一些更复杂和更高效的ETL操作。

此外,ODS层保留了大量的历史明细数据,通常约定只能增加不能修改,利用时间分区的方式进行区分。

3.1.2 数据仓库管理37

数据仓库(Data Warehouse,DW)是企业级数据集中汇总的位置。DW层最大的特点是面向主题,根据不同的主题设计表的结构和内容,这样做的好处是排除了与主题无关的冗余数据,提高了特定主题下的查询和加工效率。另一方面,数据仓库作为连接原始数据和标签之间的中间层,必须保证数据质量,包括唯一性、权威性、准确性等。以风控主题为例,DW层中通常会包括授信、支用、还款、催收等一系列数据,方便后期相关标签的计算。另外,还会有一些公用的维度表被存在与DW层平行的DIM层中,这些表通常是一些城市、日期类的字典数据,贯穿多个主题数据。

3.1.3 数据标签应用38

整个数据平台的最上层是数据集市(Data Market,DM),也是与风控人员联系最紧密的一层。顾名思义,数据集市就是将数据仓库中的主题数据根据不同的业务需要挑选出来,构成特定的业务场景标签。例如想构建与客户逾期表现相关的标签,只需要将DW层中与还款相关的表抽取出来加工即可,这样不仅结构清晰,还保证了标签计算的效率。由于DM层的数据标签与业务联系较为紧密,建议在DM层逻辑设计的初期,让更多的业务人员参与进来,这样才能避免后期技术与业务在标签计算口径上不统一的问题。

3.2 决策引擎38

决策引擎作为风险管理领域中最具有代表性的模块系统,想必很多风控从业人员都与之打过交道。决策引擎各个模块的功能直接影响着一家机构风险管理能力的落地情况,如果没有一个功能齐全的决策引擎,经验再丰富的业务专家和建模人员也无法施展拳脚。

3.2.1 规则配置39

总的来说,风险管理体系中的策略就是由若干条规则组合而成的,因而规则配置是决策引擎中最基础也是最常被使用的功能。风险管理场景下的规则,可能会涉及如下几种形式:规则集、决策表、决策树和函数计算。

3.2.2 模型部署40

在智能风控时代,搭建和运用模型的能力越来越重要,因而一个成熟的决策引擎一定是可以支持多种模型的导入和部署的。在风险管理场景中,最常见的模型是评分卡模型和机器学习模型,它们的部署方式也不尽相同。

(1)评分卡模型部署评分卡模型的部署相对较为简单,只需要在决策引擎中选择最终入模的标签,同时设置每个标签的分箱及对应的分数,这样对于每一个借款人的申请,决策引擎都可以实时计算出该客户的评分,并且将模型分数作为一条规则。与规则集类似,由于整个风险管理流程中会涉及多张评分卡,因而需要注明每个评分卡的名称、有效时间、当前状态等,方便评分卡模型的统一管理。

(2)机器学习模型部署随着智能风控技术的发展,很多头部互联网金融机构早已不局限于传统的评分卡模型,而是开始大规模地使用机器学习技术来搭建模型。与评分卡模型相比,机器学习模型的入模变量更多,且不再是变量之间加权和的线性关系,而是一种非线性关系,因而普通的模型部署功能已经不再适用于复杂模型部署的需求。目前比较好的解决方案是在决策引擎中支持PMML文件的导入。PMML(Predictive ModelMarkup Language,全称预测模型标记语言)本质上是利用XML格式描述和存储了机器学习模型。PMML文件最大的优势是支持跨平台开发,风控建模人员可以在Python、R、Spark MLlib等环境中训练机器学习模型并产出PMML文件,进而导入决策引擎中进行实时预测。

3.2.3 冠军挑战者41

“冠军挑战者”也被称为A/B测试,目的是比较多个实验组策略和当前对照组策略的线上效果,从而找出其中最优的策略。风控人员首先通过离线回溯的方式制定几套实验策略,然后通过决策引擎中的“冠军挑战者”模块部署相应的规则和模型,通过观察一段时间内各个实验组的逾期率和核准率,来决定是否替换当前线上的对照组。“冠军挑战者”背后有如下几个关键的技术点需要保障。

“冠军挑战者”背后有如下几个关键的技术点需要保障。

1)样本随机性2)样本互斥性3)样本显著性4)实验完整性

3.2.4 版本和权限管理42

权限管理功能则保证了线上策略的安全性,各个策略模块由专人管控,最核心的策略只有风控团队内最资深的专家才可以浏览和修改,避免了核心策略泄露造成的欺诈隐患。

3.3 智能反欺诈模型42

3.3.1 无监督学习43

3.3.2 图计算44

图计算(Graph Computing)是以关联图谱为基础引申出来的一类算法的统称,主要解决了图数据模型的表示和计算问题。图计算是目前比较热门的一个研究方向,比较成熟的应用场景有社区发现、标签传播、图嵌入等。社区发现(Communication Detection)主要用于关联图中社区的划分,与聚类算法的目标类似,我们也希望社区划分后每个社区内部节点联系密切,而社区之间的连接较为稀疏,因而这里定义了模块度的概念。

标签传播(Label Propagation Algorithm,LPA)是一种基于关联图的半监督学习方法,利用已标记的样本来推论未标记的样本。标签传播算法的核心在于利用节点之间边的权重构建转移矩阵,每轮传播后更新除已标记样本外其他样本的标签,直至所有样本的标签收敛。标签传播算法最大的优势是简单高效,不过也存在结果不稳定等问题。图嵌入(Graph Embedding)借鉴了NLP中word2vec的思想,将关联图中的节点嵌入某个高维空间中,使得每个节点向量化,并且映射后的向量还能够保留图的结构和性质。图嵌入的方式有很多,例如DeepWalk、Line、node2vec、SDNE等,并没有绝对意义上最优的嵌入方式,需要建模人员根据数据的分布特性和实际业务效果,不断地尝试和迭代。图嵌入后的向量可以表示每个样本的社交属性,既可以作为入模特征放到欺诈或者风险模型中训练,又可以利用聚类算法进行客群间的划分。

3.4 智能信用风险模型45

对于智能信用风险模型,风控建模人员通常会将整个信贷生命周期划分为准入、贷前、贷中、贷后四大场景,由于每个场景中的目标和数据源存在差异,又会选择不同的算法来搭建模型。下面会简单介绍一些智能风控时代常用的模型算法及其适用的场景和原因,更多算法细节会在第5章中展开。

3.4.1 专家模型45

3.4.2 逻辑回归46

3.4.3 决策树46

3.4.4 集成树47

3.4.5 深度神经网络47

3.4.6 循环神经网络48

除了DNN算法,循环神经网络(Recurrent Neural Network,RNN)是另一种在智能风控领域被尝试的神经网络结构。RNN的特性是在时间维度上具有“记忆”功能,具体的实现原理是对于RNN的隐藏层,t-1时刻的输出会作为t时刻的输入,这样当前时刻的隐藏层会包括之前所有时刻隐藏层的信息。这个特性使得RNN被应用到行为评分模型和催收评分模型的搭建中,因为支用行为序列和催收行为序列都具有很强的时间属性,利用RNN可以自动提取这些时间序列中的隐性特征。在时间序列中我们通常更希望关注近期行为,忽略远期行为带来的噪声,因此便有了长短期记忆网络(Long Short Term Memory,LSTM)。与RNN相比,LSTM在各隐藏层节点之间传递信息的过程中,加入了输入门、遗忘门和输出门的结构,使得整个网络结构可以有选择性地“记忆”过去的信息,对于时间序列上的信息提取有了重大提升。

3.5 智能模型带来的提升48

3.5.1 数据广度和深度48

3.5.2 模型快速迭代和主动学习49

相比于评分卡模型,机器学习和深度学习算法更少地依赖于人工经验,而是从海量数据中自动提取特征并预测结果。通常一个智能风控模型的迭代周期是3~5天,远远短于评分卡模型,因而可以快速迭代,把近期的数据都考虑到模型范围内。同时,因为不需要人工经验,智能风控模型完全可以部署到线上实现主动学习,从而缓解评分卡模型由于开发时间较长,导致上线后模型效果偏移的问题。

3.5.3 线上自动决策49

3.6 统计学与机器学习49

3.7 本章小结50

本章介绍了目前互联网金融机构实现自动化审贷背后所依赖的三大核心技术:大数据平台、决策引擎和智能模型。大数据平台是基础,包括数据清洗、数据管理和数据应用的功能。决策引擎是媒介,需要支持规则配置和模型部署的需求,并且能够通过线上的“冠军挑战者”确定最优策略。模型部分是整个智能决策的大脑,既有能够主动识别的反欺诈模型,又有覆盖生命周期全流程的信用模型,具体算法细节将在第5章中展开。智能模型弥补了传统风控中数据较少和模型迭代慢等问题,并且基于机器学习算法能够自动学习数据规律进行预测。下一章我们将了解智能风控模型中常用的数据源和特征工程手段。

第4章 风控大数据体系51

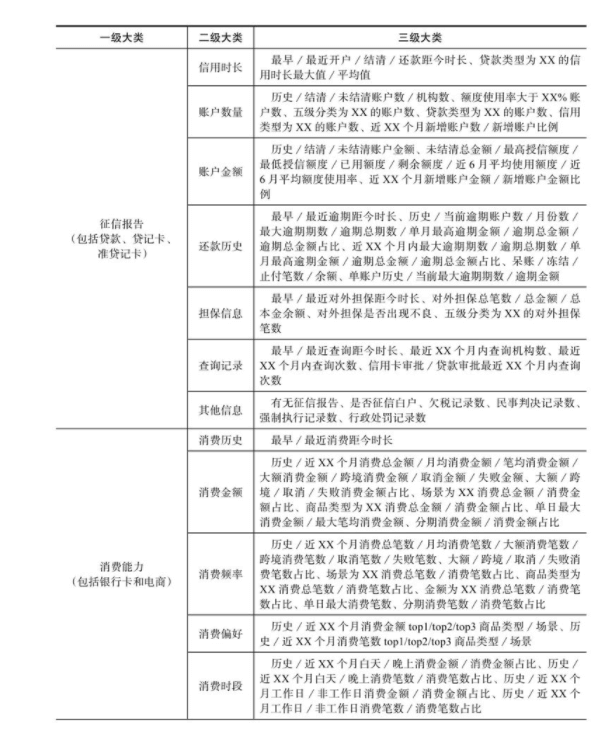

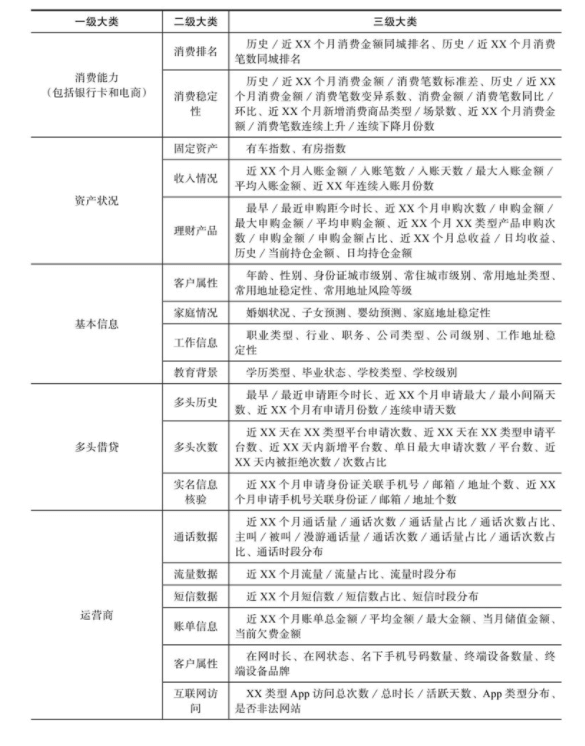

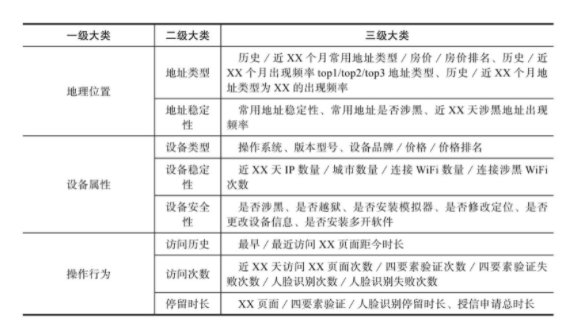

4.1 数据源类型51

风控场景下的数据源主要可以分为两类。一类是银行和互联网金融机构通过自身业务线产生的金融数据,包括征信报告、交易流水、理财产品等,这些强金融属性数据由于直接与客户的金融行为挂钩,因而能够比较好地刻画客户的风险状况。另一类是非金融机构产生的数据,例如运营商、地理位置、设备属性等,这些弱金融属性数据虽然不能直接反映客户的风险,但是通过特征和模型方式上的加工,能够对强金融属性数据起到较好的补充和增益作用,因此也被纳入风控大数据体系内。

4.1.1 征信报告52

4.1.2 消费能力54

4.1.3 资产状况54

4.1.4 基本信息54

4.1.5 黑名单55

4.1.6 多头借贷55

多头是指客户在多家借款机构发生注册、申请、贷款、逾期等行为,是信贷风控场景中一类具有特色并且非常重要的数据源。对于存在多头行为的借款人,通常代表该客户在近期内资金状况较差,在多个平台上寻求贷款并且身背大量共债,暗含着较高的信用风险和欺诈风险,是金融机构需要重点识别和筛选的客群。

基于多头的原始数据,可以结合机构类型、频率、金额、时间周期等维度,衍生出上百维特征,区分度较高的可以直接制定策略拦截,区分度较低的可以单独建立子模型或者融入主模型,通常能够给已有模型KS带来3~5个点的提升。需要注意的是,随着近年来资金平台数量越来越多,整个行业中借款人的多头情况都在增加,因而需要随时监控线上策略和模型中多头特征的稳定性,通过调整阈值或者迭代模型的方式避免多头特征波动导致的授信通过率持续走低。

4.1.7 运营商56

运营商数据主要通过与三大运营商直接或者间接合作获得,目前整体接入价格较高,机构会优先选择几个验真类服务接入,通过输入手机号码,运营商返回是否真实、是否小号、是否疑似养卡等字段,帮助机构进行反欺诈验证工作。除去验真类数据,在网时长和在网状态这两个特征,由于覆盖三网并且接入渠道较多,也经常被用于风控策略和模型中。

4.1.8 地理位置56

4.1.9 设备属性57

4.1.10 操作行为57

4.2 特征工程方法57

4.2.1 统计量58

4.2.2 离散化58

4.2.3 时间周期趋势59

对于积累时间较长的原始数据,还可以加工一些时间周期类特征,包括标准差、变异系数、同比、环比、新增数、连续增长、连续下降等,考察借款人的变化趋势。

4.2.4 交叉项59

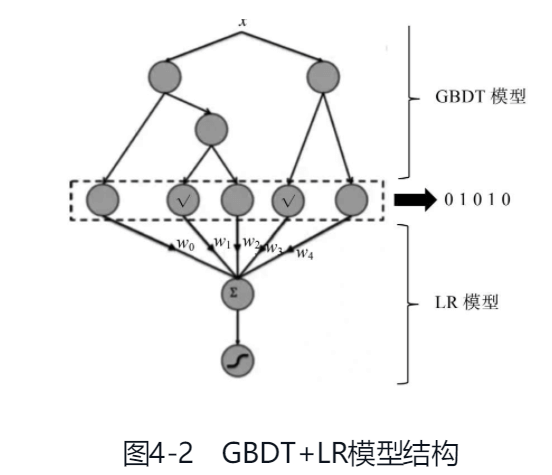

单一特征能够提取的信息总是有限的,因此还需要引入交叉项特征,综合考虑两个或者多个原始特征的影响。生成交叉项也有两种思路,基于经验和基于模型。基于经验的方法主要是从业务理解的角度出发,人为地构建一些交叉项组合,放到风控模型中去尝试。交叉项的两个原始特征最好是相关性不高的,例如近6个月的消费总金额和消费金额稳定性,这样构建的交叉项才能够在已有的原始特征之上带来增益。基于模型的方法则是利用树类模型学习目标函数生成大量叶子节点特征,比较经典的方案是Facebook在2014年提出的GBDT+LR模型,其模型结构如图4-2所示。

GBDT+LR模型, 该模型利用GBDT自动进行特征筛选和组合, 进而生成新的离散特征向量, 再把该特征向量当做LR模型的输入, 来产生最后的预测结果, 该模型能够综合利用用户、物品和上下文等多种不同的特征, 生成较为全面的推荐结果, 在CTR点击率预估场景下使用较为广泛。

4.2.5 隐性特征60

除去上面介绍的这些显性特征,还有一类没有具体业务含义的隐性特征,是通过深度模型挖掘得来的,是对客户商品购买、出行地点、点击行为的高维向量表示,已经在许多头部互联网金融机构的风控模型中得到了效果验证。这里介绍隐性特征挖掘中常用到的一类方法——Embedding。

4.2.6 用户画像61

4.3 数据测试与应用61

4.3.1 联合建模机制61

数据合作存在于风控场景中的各个玩家之间,大数据公司和互联网金融公司之间需要进行原始数据和底层特征的交互,互联网金融公司与传统金融机构之间也需要有模型分数和用户画像之间的交互。在当前的监管要求下,纯粹的数据合作已经越来越少,联合建模机制被广泛地应用于数据测试环节。联合建模是指数据需求方提供一批主键加密的客户样本,与数据提供方进行撞库,匹配出这批客户的底层数据,然后需求方在提供方的建模环境内进行数据分析和建模工作。最终需求方的线上模型也部署在数据提供方的机房内,大数据公司不输出任何明细字段。这样的机制保证了大数据公司的数据安全,互联网金融公司也没有泄露客户的任何信息,是满足当前监管要求的一种方案。

另外除去这种方式还有联邦学习,使得多家数据源公司能够将加密后的原始数据汇总到一起来共建模型。这一概念背后主要是利用了同态加密的原理,加密后的数字可以进行乘法和加法运算而无须解密;对于逻辑回归和深度学习模型,事实上可以拆分为加减乘除、sigmoid、tanh和指数函数等少数几个计算组件,后三个函数都可以通过泰勒展开无限逼近来实现,因而已经能够支持联邦学习。不过目前联邦学习还存在计算量大、通讯要求高等问题,或许未来可以将区块链和5G技术引入其中解决这些痛点。

4.3.2 数据质量评估62

在最终入模前,需要对内外部的数据源进行质量评估,主要从覆盖率、稳定性、模型效果和投资回报率(Return On Investment,ROI)四个方面考虑。

在外部数据源正式采购前,还需要详细计算该数据源的ROI。首先,在保证效果的前提下,同类数据源能否在市场上找到最便宜的提供方;其次,外部数据放在哪个环节调用对于整体策略的收益最大,是否需要梯度式调用,这些都是需要考虑的问题。

4.3.3 线上应用63

最终的应用环节,需要根据数据源的差异制定不同的线上方案。对于内部数据源,可以采用T+1或者T+7的形式跑批,模型结果线下批量更新完后再服务化;而对于外部数据源,由于成本较高,通常采用API调用的方式,线上实时计算模型结果并服务化。涉及外部数据源的模型,应先测试线上小流量,待确认数据提供方系统稳定后再放开流量。

4.4 数据安全合规63

4.5 本章小结64

智能风控模型中常用的数据源可以分为金融数据和非金融数据,金融数据对于客户的风险状况区分能力较强,而非金融数据需要通过特征工程从中提炼信息。特征决定了模型的上限,特征工程中既包括统计量、离散化、时间周期等传统加工方法,也有GBDT+LR模型和Embedding这些涉及算法的复杂衍生方式。对于数据的引入需要搭建一套完整的测试和应用流程,并且最重要的是要在安全合规的前提下使用数据。本章的最后,笔者结合前面讲述的数据源和特征工程方法,总结了一套风控指标体系,如表4-1所示,供读者们参考。下一章是全书最核心的部分,将详细介绍风控和反欺诈领域中常用的机器学习和深度学习算法,以及这些算法在特定场景中的应用方式。

表4-1 风控指标体系

5.1 有监督学习68

5.1.1 逻辑回归69

5.1.2 决策树70

5.1.3 随机森林73

5.1.4 梯度提升决策树74

此外,LightGBM还基于直方图的算法将连续特征分箱为离散特征,加快了模型训练和并行化处理。在相同的数据集和资源环境下,笔者利用LightGBM的训练速度大约是XGBoost的3倍。不过,在计算资源充足的情况下,建议风控建模人员优先考虑XGBoost算法,在实践中XGBoost的稳定性优于LightGBM,并且XGBoost目前已经支持Spark环境,这大大弥补了XGBoost原本计算开销较大的劣势。

5.2 无监督学习76

由于反欺诈业务中存在标签样本缺失或者稀疏的痛点,因此我们就需要无监督学习(Unsupervised Learning)来帮助提高识别能力。无监督学习从数据本身的分布特性出发,不依赖标签,主动发现数据背后隐藏的规律,找出疑似欺诈的客户,帮助反欺诈人员预警并进入案件调查阶段。常用的无监督学习算法有聚类和孤立森林,两种算法原理上存在差异,因此可以考虑结合使用。

5.2.1 聚类76

5.2.2 孤立森林79

5.3 深度学习80

5.3.1 深度神经网络80

5.3.2 循环神经网络83

5.3.3 词嵌入86

5.3.4 自编码器88

自编码器(Autoencoder)是深度学习中的一种无监督算法,与Embedding算法类似,也利用了空间映射的理念,不过自编码器要求输入层和输出层维度一致

5.3.5 迁移学习89

迁移学习大致可以分为如下四类。

- ·基于样本的迁移:从源领域中挑选出一部分标签数据,比如根据分布上的一致性判断,和目标领域中的少量标签数据一同学习。

- ·基于特征的迁移:找出一组好的特征表示能够尽量减少源领域和目标领域之间的差异,使得源领域中的模型可以直接应用到目标领域。

- ·基于参数的迁移:相似领域之间的学习任务会共享同样的参数或者超参数的先验分布。

- ·基于关系的迁移:这种迁移通常发生在相关的领域之间,比如社交网络类的数据,数据之间存在较强的联系。

上述四类迁移学习方法中,在深度学习算法中结合最多的是第三类基于参数的迁移,通过参数共享的方式大大提升深度模型的泛化能力,降低训练成本。目前业界将迁移学习应用到深度学习中的方式通常有如下三种:Pre-train+Finetuning、Freeze和Multi-task Learning。

Pre-train+Finetuning的原理是先在基础数据集上预训练网络的结构和参数权重,同时将预训练好的网络结构迁移到目标数据集上,重新训练并微调参数的权重。这个方法比较适用于源领域和目标领域之间存在一定差异,并且目标领域具有足够的标签数据可以支持网络的重新训练的情况。当目标领域与源领域非常相近,同时目标领域中并没有太多数据的时候,我们应该更加相信预训练的模型,尽可能少地做调整,这就是Freeze的思想。通过冻结预训练网络的中间结构,仅是修改输出层的函数来满足目标领域的标签定义,我们可以快速得到一个新的模型,这里其实是变相地把预训练的模型看作一个特征提取的工具。

无论是Pre-train+Finetuning还是Freeze,都是集中在单一领域中的单任务学习,还有一种多任务学习的方式,也可以实现迁移学习。在Multi-task Learning中,我们将源领域和目标领域的数据放在一起,通过共同的浅层网络进行训练,达到参数共享的目的。这种Multi-task Learning的方式对于深度学习模型确实行之有效,原因在于共同的浅层网络可以实现领域之间的信息互补,这样训练出来的模型泛化性能更好,解决了深度学习模型容易过拟合的问题。

迁移学习在风控和反欺诈场景中的应用还处在探索阶段,原因在于金融机构之间的信贷数据和模型无法互通,而金融机构内部各条业务线之间的客群又存在较大的分布差异,使得样本和特征层面的迁移难以实现。并且,由于风控行业的安全性要求,并不存在诸如图像识别领域中ImageNet这样标准化的公开数据,无法训练可以复用的大型网络结构来做Fine tuning或者Freeze。Multi-task Learning是目前迁移学习在风控领域可以尝试的方向,因为产品的额度和风险通常是相关的,可以将这两个任务共同训练,提取额度和风险之间的共同信息,同时构建定价模型和风控模型。

5.4 图计算91

5.4.1 社区发现91

也就是社交网络。

Louvain可以说是目前性能最好的社区发现算法之一,因为它快速准确,易于理解,并且不需要数据的标签,同时支持单机和分布式环境,非常适合建模人员在实际业务场景中应用。

5.4.2 标签传播92

标签传播(Label Propagation Algorithm,LPA)是基于关联图的半监督学习方法,主要目的是利用已标记的节点去预测未标记的节点。在标签传播过程中,节点的标记按照相似度转移给相邻节点,相似度越高则影响权重越大。未标记的节点根据周围节点标记的加权和更新自己标记的概率分布,所有节点的概率稳定后停止更新。可以看出,标签传播算法的关键在于权重矩阵和概率转移矩阵的确定。

5.4.3 图嵌入93

5.5 强化学习97

5.6 本章小结99

本章是全书的核心内容,详细介绍了有监督学习、无监督学习、深度学习、图计算和强化学习这5大类算法,以及它们在智能风控场景中的应用。有监督学习中的代表是逻辑回归和XGBoost,是目前业界贷前识别欺诈风险和信用风险最常用的两个算法。无监督学习包括聚类和孤立森林,能够主动区分欺诈客户。深度学习中的Wide&Deep是对XGBoost的补充,进一步提升贷前信用风险的识别能力;GRU则主要运用于贷中和贷后的风险管理;迁移学习可以比较好地解决小样本和冷启动的问题。图计算包括社区发现、标签传播和图嵌入,能够量化客户之间的关系,挖掘个人或者团伙的欺诈隐患。强化学习与风控的结合目前仍在探索阶段,已有的应用场景是在流量分发环节,提高用户的申请通过率。了解了智能风控中常用的算法,下一章我们将介绍模型的训练流程,只有建模流程规范,算法才能发挥出应有的威力。

第6章 智能模型训练流程101

6.1 数据清洗101

在数据清洗过程中,我们需要注意5个方面的问题:缺失值、异常值、重复值、一致性和有效性。

6.1.1 缺失值处理102

6.1.2 异常值处理103

6.1.3 重复值处理105

6.1.4 一致性检验105

数据不一致是大数据建模过程中经常面临的问题,无论是字段之间的不一致,还是相同字段线上线下的不一致,都可能导致线上模型的不可用,因此尽可能在建模初期的数据清洗阶段,就定位并解决这些不一致的问题。

(1)数据交叉验证在多个数据源中,可能存在多个字段具备相似的含义,这个时候就需要进行数据之间的交叉验证,来找出最权威的字段。

例如客户年龄,可能存在平台业务(电商、出行)中填写的年龄、金融业务中填写的年龄、身份证号中解析的年龄这三类,从权威性的角度来说,应该是身份证年龄高于金融年龄高于平台年龄,因为首先身份证信息一定是真实的,其次对于信贷客户来说,他们更愿意在金融业务中填写自己的真实信息。在实际数据清洗过程中,可以结合这三个数据来源构建一个新的年龄字段,对于实名客户选取身份证年龄,对于未实名客户优先选取金融年龄,这个新构建的年龄字段可以最大限度地保证数据的权威性。

(2)线上线下验证对于需要上线的模型,上线前的数据验证是一件让建模人员很头疼的事情,由于线上线下可能采用不同的数据源或者更新频率,会导致线上模型结果和离线模型结果对不齐。在数据清洗环节,如果线上数据已经落库,建议事先评估线上线下数据之间的差异性。在积累时间足够长的情况下,优先利用线上落库的数据分析建模;对于刚开始积累的线上数据,如果发现线上线下差异性过大,建议在本期建模项目中暂时不使用这些数据,以免导致模型上线前的返工。

6.1.5 有效性检验106

数据清洗本身也是一个数据摸底阶段,在处理完缺失值、异常值、重复值、一致性这些问题后,最后也可以从有效性的角度,对原始字段做一次初筛,进而从业务经验和数据分析这两个角度选择最有效的字段。

(1)业务经验

业务经验在风控建模过程中会起一定的作用。经验丰富的业务专家可以从海量数据中挑选出符合业务认知的字段,这些字段能够合理地评估客户的信用和欺诈风险,并且不容易受到外部环境的影响,从而保证模型的解释性和稳定性。

(2)数据分析

对于机构以外的第三方数据,在数据接入阶段可以利用少量样本进行数据分析,评估这些数据对于建模目标的区分能力,选取部分有效字段进入特征池建立最终的模型。这种有选择性的接入,能够保证机构在数据成本方面的投入产出比最优,并且不会因为太多的外部数据接口导致线上服务的时效性降低。

6.2 特征工程和特征筛选107

有了较为干净的原始数据,我们就可以开始特征工程的工作了。常用的特征工程方法和风控指标体系在第4章中已经详细展开,这里就不再赘述。由于头部的互联网金融机构很早就开始了模型搭建的工作,基本都沉淀了一套内部的特征平台,这样建模人员在每个建模项目中就不需要重复造轮子,只构建一些定制化的特征就可以了。

经过特征工程这一步,我们已经将原始数据转化为成百上千维的大宽表,但是直接将这个大宽表丢到模型里面去训练是不合适的,因为这些特征中存在很多冗余信息,会导致模型训练过程中时间和空间资源的浪费,并且特征本身的不稳定性、特征之间的强相关性,也都会影响最终模型的效果。这些问题都需要在特征筛选环节中解决。通常特征筛选可以通过探索性数据分析、稳定性、重要性、相关性、解释性这几个方面来进行。

6.2.1 探索性数据分析107

通常计算的统计量有字段类型、缺失率、异常率、非重复值数量、标准差、最小值、最大值、平均值、分位点等。

6.2.2 稳定性108

风控模型对于稳定性的关注总是第一位的,因此在特征筛选阶段我们也希望保留最为稳定的特征。特征稳定性的评估指标依然是PSI,通常将特征等频划分为10箱,默认值单独作为1箱,计算两组特征之间的PSI。

6.2.3 重要性109

在排除有问题和不稳定的特征之后,我们希望将所有特征对于预测目标的重要性进行排序,从而剔除对于目标贡献不大的特征。根据计算方式的不同,有IV值、树模型feature_importance和SHAP值3种。

(1)IV值

IV值我们在第2章中已经介绍过,是逻辑回归模型中常用来评估特征重要性的方式。IV值侧重于单变量的筛选,衡量的是每个变量单独对于目标的区分能力。如果一个变量在不同分箱中的正负比差异较大,那么IV值会相对较高。

(2)树模型feature_importance

对于各类树模型,都可以输出特征重要性(feature_importance)的排序。以XGBoost为例,XGBoost由多棵决策树构成,每个变量在单棵决策树中都可以计算出对应的信息增益,增益值越大,说明这个变量对于这棵决策树的性能提升越大。这个变量在所有决策树增益值的加权平均再归一化,就是这个变量在XGBoost模型中的feature_importance。从计算原理上来说,feature_importance考虑了变量之间的相互作用,能够更好地反映出变量在非线性模型中的重要性。

(3)SHAP值除去IV值和feature_importance这两种方法,近年来又有一种新的SHAP值的方法被提出,它能够很好地解释XGBoost或者神经网络这类黑箱模型中特征的贡献程度。之前我们介绍了feature_importance可以衡量树类模型中变量的重要性,但是通过feature_importance却没有办法知道每个变量与目标之间的正负向关系,SHAP值可以很好地解决这个问题。SHAP来源于由Shapley Value启发的可加性解释模型,对于每个预测样本,模型都会产生一个预测值,SHAP值就是该样本中每个特征对应的数值。假设第i个样本为xi,第i个样本的第j个特征为xij,模型对第i个样本的预测值为yi,模型的基线(通常是所有样本的目标变量的均值)为ybase,那么SHAP值满足:

其中f(xi,j)为xi,j的SHAP值。可以看出,当SHAP值为正,该样本中该特征对于目标的贡献度为正向;反之则为负向。

在Python中,可以通过shap函数包轻松实现SHAP值的计算,并且该函数包还提供了多个维度下SHAP值的可视化,方便建模人员分析不同样本中特征的贡献程度。

关于这三种特征重要性的计算方法应该如何选择,从笔者的经验来讲,在特征较多的情况下,可以先利用IV值进行粗筛,将单变量预测能力极低(IV<0.03)的特征剔除;如果运用树类模型的话,可以利用feature_importance进一步筛选,剔除feature_importance较低的特征;最后可以利用SHAP值验证IV值和feature_importance的结果,观察每个样本在不同特征上的SHAP值,判断该特征的贡献度方向是否符合预期。

6.2.4 相关性110

6.2.5 解释性111

特征筛选的最后,还需要业务人员从解释性的角度出发,对筛选后的特征进行最终的确认。这一步的目的在于保证模型考虑的因素符合业务人员的认知,并且建模人员可以提前从模型中剔除一些未来可能发生变动的因素。

这里举两个例子,比如信用模型和反欺诈模型通常会在贷前策略中交叉使用,因而业务人员希望这两个模型的入模变量能够尽量正交,信用模型集中在长期稳定的特征,而反欺诈模型更偏重短期内的变化。再例如营销类的特征和定价类的特征一般不建议加入模型中,因为营销活动本身并不稳定,定价也是随时会调整,这两类变量都不建议直接入模。

6.3 模型训练111

为了得到一个兼具区分度和稳定性的模型,我们需要将样本集分为三部分:训练集(training set)、验证集(validation set)和测试集(testing set)。

6.4 模型部署114

相比于传统评分卡,机器学习和深度学习模型的部署要复杂得多,需要专门的工程团队配合模型团队完成。在这个环节,建模人员通常需要提供两个文件,即特征工程脚本和训练好的模型。

特征工程脚本中包含数据清洗和特征加工的所有逻辑,目的是将数仓中的原始数据转化为最终入模的特征。

对于模型文件,机器学习模型训练完可以保存为PMML文件,深度学习模型则通常保存为PB文件,这两种格式的优势是支持跨平台开发,方便工程团队的人员在Java环境中调用模型文件来实现计算的功能。由于离线开发环境和线上生产环境的数据管道通常存在差异,模型部署过程中还有一个重要的工作就是数据验证,包括原始数据、模型特征和端到端的预测结果。对于公司内部的数据源,我们希望线上线下能够完全对齐;对于外部数据源和实时数据,我们允许一定范围内的误差。

6.5 监控预警114

至此整个模型的训练和上线工作都已经完成,但是这并不代表着建模项目的结束,因为还有最后一个环节,那就是对于线上模型的监控预警。智能模型由于特征更多、结构更复杂,因此需要持续的更新迭代,通常一个模型的生命周期为3~6个月,因而监控预警在智能模型中就显得尤为重要。监控报表的呈现形式可以以图表为主,方便相关人员快速地了解模型现状,报表中可以包含以下几方面信息。

(1)模型效果指标

(2)评分分布表

(3)模型稳定性趋势图

(4)模型区分度趋势图

(5)变量稳定性分析

(6)业务效果指标(可选)

(7)线上线下误差分析(可选)

6.6 本章小结119

本章介绍了智能模型的训练流程,分为数据清洗、特征工程、特征筛选、模型训练、模型部署和监控预警这6个环节。其中数据清洗部分需要特别注意缺失值、异常值、重复值、一致性和有效性的问题。特征筛选部分可以基于探索性数据分析,从稳定性、重要性、相关性和解释性这4个方面剔除冗余特征。模型训练部分介绍了逻辑回归、XGBoost和Wide&Deep这3个常用模型的调参技巧,注意越复杂的模型结构越需要避免过拟合现象的出现。模型训练结束后是部署和监控的工作,风控模型的监控尤为重要,当模型评分出现较大波动时,需要建模人员及时响应并解决。接下来的第7章到第9章,我们将详细讲述反欺诈、个人信贷和企业信贷这3个方面的实战案例。

第7章 反欺诈案例120

实战篇的第一个案例是笔者参与的某股份制银行的电子银行交易反欺诈项目,主要是利用无监督模型识别出交易流水异常的用户。

7.1 案例背景120

某股份制银行有2016年行内客户的全部8000万条电子银行交易流水,覆盖320万名用户。由于行内对欺诈用户的拦截较为谨慎,现存的欺诈样本极少,希望建模人员先利用无监督的方式识别出异常用户,再利用行内已有的欺诈样本来评估模型效果。

7.2 原始数据介绍120

7.3 探索性数据分析121

7.3.1 交易笔数121

7.3.2 交易时间122

7.3.3 交易类型123

在行内电子银行交易流水表中,现存308种交易类型,如果直接将这些交易类型进行独热处理显然是不合理的,因为会导致特征矩阵的稀疏问题。

这里我们从三个角度将交易类型进行划分,保证交易类型特征的解释性和稠密性。

第一个角度是按照交易属性,将交易类型划分为转账、支付、账户操作这三类,用来观察用户在电子银行的交易习惯。

第二个角度是按照交易类型占比,将交易类型划分为高频、中频、低频,如果一个低频交易类型在一个用户过去一年的交易流水中出现次数过多,我们有理由认为这个用户和普通用户相比存在差异。

第三个角度是从反欺诈场景出发,筛选出敏感、风险、失败交易,其中敏感交易是从数据层面分析较容易出现失败的交易类型,例如“资产管理类理财产品赎回”;风险交易是从行内业务人员经验分析较容易出现欺诈的交易类型,例如“找回登录名”;失败交易通过交易状态代码直接判断。这三种交易类型都直接与反欺诈业务相关,任何一种类型发生的次数过多都可能意味着欺诈行为。

7.3.4 交易IP地址124

7.4 特征工程124

7.4.1 特征加工124

这里周期性主要计算用户每笔交易行为之间的时间间隔分布,波动性计算滑动窗口内交易笔数和时间间隔的标准差。欺诈模式则是来自行内业务专家的建议,把几种常见的欺诈行为规律作为0-1特征加入模型中来,最终生成238个原始特征,分类如表7-5所示。

除了常见的分组求统计值外,还会遇到例如计算前后变动次数、连续最多次数、是否存在子列、滑动窗口等复杂逻辑。笔者以这个案例中的特征为例,向大家展示在Python中如何实现上述逻辑。代码见书。

7.4.2 特征筛选130

以K-means为例,将238个原始特征输入模型训练并预测,基于预测的正常和异常客群,计算两个客群之间每个特征平均值的差,差值越大则说明这个特征在该模型中的重要性越大。iForest计算特征重要性的方式也是一样。基于以上筛选逻辑,我们保留23个特征作为最终的入模变量。

7.4.3 特征分组130

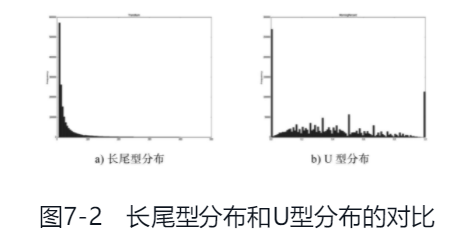

在分析两个子模型重要特征的时候,我们发现了一个有趣的现象,就是相同的特征在两个子模型中的重要性差异较大。为了探寻这一现象背后的原因,我们画出了23个重要特征的分布图,发现特征在不同子模型中重要性的排序与其本身的数据分布相关。在这23个特征中,可以根据数据分布分为两类:长尾型分布和U型分布,横轴代表特征的取值范围,纵轴代表人数,如图7-2所示。

长尾型分布的特征例如交易总笔数,随着交易笔数的增大,对应的人数不停减少;U型分布的特征例如敏感交易类型比例,大部分用户的敏感交易类型比例极低,但是存在少部分疑似异常用户的敏感交易比例较高,使得这个特征的分布呈现头尾人数多、中间人数低的情况。对于长尾型分布的特征,在iForest子模型中重要性较高,因为iForest中每棵iTree随机分裂的特性,使得长尾的离群点更容易被识别成异常。而在K-means中,簇的生成基于误差平方和最小的目标,倾向于将距离较近的样本划分到一起,U型特征分布上的特性,恰好天然地能够将整体样本划分为两个簇,因此U型特征的重要性在K-means中排名更靠前。

基于特征分布和两个子模型的特性,我们将23个重要特征进行分组,其中8个长尾型特征输入iForest,剩余15个U型特征(U型特征 正好分成两个簇)输入K-means,这样也更好地保证了两个子模型的独立性,提高了最终Ensemble模型的效果。

7.5 模型训练131

本次案例中选取了两个经典的无监督算法:K-means和iForest。先各自训练子模型,再将子模型预测的异常用户结果相结合,得到最终Ensemble模型的结果。在K-means模型中,我们令簇的个数为2,则聚类后人数较少的簇被认为是异常簇,人数较多的簇被认为是正常簇,异常簇中每个样本到正常簇中心的距离定义为异常度得分,距离越大则异常度得分越高;在iForest模型中,可以根据算法定义,每个样本距离根结点的平均距离越短,则异常度得分越高。根据异常度得分的排名,选取适当的阈值,就可以得到子模型对于异常用户的预测结果。两个子模型训练和计算异常度得分的Python代码如下所示:

7.6 模型评估134

在本章的案例中,我们将子模型异常度得分排名前1%的用户作为子模型预测的异常用户,两个子模型共同预测为异常用户的共208人。为了对比Ensemble模型和各个子模型对于异常用户的识别能力,我们抽取了一些疑似异常用户的交易流水,来分析不同模型预测出来的异常用户的不同特性。

K-means子模型倾向于静态指标,识别出某种类型或者某个时间段交易笔数占比过高的用户,例如表7-6和表7-7中的这两个用户(截取部分交易流水),用户A总共6笔手机支付全部出现手机号码不匹配的问题,是K-means子模型中异常度得分排名较高的用户;用户B总共21笔交易中存在3笔手机支付超出当日累计支付限额的问题,并且还有3笔午夜支付,相较于用户A排名较低。

iForest子模型侧重于动态指标,捕捉用户交易周期性和波动性的突然变化,或者较为明显的欺诈模式。异常度得分越高的用户,从交易流水上来看越异常。例如表7-8和表7-9中的这两个用户(截取部分交易流水),用户C的所有109笔交易均发生在一天的15分钟内,并且一直在尝试兑换积分礼品,是iForest子模型中异常度得分最高的用户;用户D总共282笔交易,大部分呈现周期性,但是在某一天出现连续4次尝试预约理财产品失败的情况,不排除被他人盗号的可能性。

Ensemble模型则综合了子模型的优点,从用户静态和动态两方面特征考虑,提升了模型的准确率。例如表7-10中的这个用户E(截取部分交易流水),同时出现了转账交易比例过高和短时间内交易笔数突增的问题,经行内业务专家判定,该用户确实属于一个跨国欺诈团伙。

7.7 案例优化136

(1)特征优化

(2)算法优化

无监督算法可以尝试Autoencoder,通过神经网络的方式找出欺诈用户背后隐藏的分布规律;周期性和波动性特征的构建,可以利用时间序列模型,自动提取数据中的时序特征;对于反欺诈这种正负样本极度不均衡的问题,当下流行的PU-learning、self-training、co-training等半监督算法,都可以通过算法的方式增强正样本,相比于纯粹的无监督算法,相同召回率下模型的准确率更高。

(3)场景优化

为了提高模型的准确性,还可以针对不同的欺诈场景建立多个子模型,例如识别用户主动发起的第一方欺诈,或者是账户被盗用后产生的第三方欺诈。同时,除了账户维度的反欺诈模型之外,还可以搭建交易维度的反欺诈模型,识别单笔交易是否异常,与账户反欺诈配合使用效果更佳。

7.8 本章小结137

本章从某股份制银行的电子银行交易反欺诈项目出发,介绍了无监督算法在反欺诈领域的应用。通过探索性数据分析,项目组从交易笔数、交易时间、交易类型和交易IP地址这4个方面挖掘出欺诈用户的特性,并且归纳成238个原始特征。模型方面,分别利用筛选后的长尾型分布和U型分布特征,建立K-means和iForest子模型,再将子模型预测的结果相结合,构成最终的Ensemble模型。针对Ensemble模型预测的疑似异常用户,项目组和行内业务专家一同进行了样例分析,证实了该模型确实能够从静态和动态两方面识别出用户的交易欺诈行为。下一章我们将介绍有监督算法在个人信贷风控场景中的应用。

第8章 个人信贷风控案例138

个人信用类贷款是目前互联网金融领域中最常见的业务场景,蚂蚁“借呗”、腾讯“微粒贷”、京东“金条”都属于这一业务范畴。个人信贷的特点在于无抵押,金融机构根据自身对于客户的信用评估来决定贷款额度和利率。由于个人信贷每天申请量大、件均放款额度小,传统人工审核的方式显然是不适合的,因此建立智能风控模型是机构开展个人信贷业务的前提条件。笔者参与过很多银行和互联网金融机构个人信贷模型搭建的项目,但由于风控和数据安全的原因,在本书中无法直接介绍。本章基于Kaggle社区上一个经典的比赛题目“Home Credit DefaultRisk”,来分享一些笔者在个人信贷风控建模中的经验。

8.1 案例背景138

捷信(Home Credit)作为业内头部的消费金融公司,主要为没有足够征信记录的人群,也就是我们常说的次贷人群,提供贷款服务。捷信基于公司内部数据和外部征信、通信、消费类数据,利用统计和机器学习等方式,对客户的信用状况进行评估,从而帮助更多的人得到贷款服务。本题中给出30万条贷款申请样本及逾期表现,以及申请节点客户的各维度数据,希望搭建风控模型并做出预测,以AUC作为评估指标。

8.2 原始数据介绍139

8.3 特征工程139

本节参考了本题排名比较靠前的一位参赛者的思路,利用离散化和统计量这两种比较粗暴直接的加工方式,生成了814维的客户大宽表。主要的特征工程思路如下。

- ·离散特征:对于字符型的原始数据进行独热处理,生成0-1编码类的特征,解决字符型数据无法进行模型训练的问题。

- ·统计特征:对于月维度的原始数据,通过聚合成统计量的方式,关联到客户样本。

- ·比例特征:对于具有一定业务含义的,比如收入还款比等,计算了相关比例。

- ·交叉特征:针对历史申请数据中的通过和拒绝,征信数据中额度的激活和关闭,分别衍生了更细颗粒度的相关特征,属于人工生成的交叉项。

8.4 探索性数据分析142

8.5 模型训练144

8.5.1 逻辑回归144

8.5.2 XGBoost150

非线性模型首推XGBoost,既是Kaggle比赛的“大杀器”,近几年也在互联网金融的风控领域被广泛使用。

XGBoost的一大优势就是特征容纳能力强,成百上千的变量都可以直接丢到模型中去训练。但是,在实际项目中我们还是建议进行变量筛选,首先过多的变量会降低模型训练时的效率;其次在模型上线阶段,入模变量过多会加重线上模型维护的负担,应当尽量简化线上模型结构。变量筛选的方式有很多,可以参考LR模型从多个维度考虑,笔者通常利用的方法是基于XGBoost输出的feature_importance对变量重要性排序,根据不同的重要性阈值进行筛选,观察每组变量筛选后模型在验证集或者测试集上的效果,选择保持模型效果且入模特征数量较少的阈值。

确定最终入模特征,就进入了模型调参和训练的环节,XGBoost调参可以沿用LR模型GridSearchCV的方法,也可以利用贝叶斯优化的思想。贝叶斯优化的优点在于,每次调参都会考虑上一组超参数的信息,迭代次数少,调参效率更高;同时针对非凸的损失函数,贝叶斯优化也不容易陷入局部最优,能够得到全局最优的超参数组合。在Python中有调参工具hyperopt已经实现了类似的思想,笔者在本题中迭代了20次,得到最优超参数组合,如表8-4所示。

利用SHAP值进行XGBoost模型白盒化,解释入模特征对于目标的贡献度和贡献方向。以SHAP值排名第一的某外部评分EXT_SOURCE_2为例,深色样本多集中在SHAP=0的纵轴左侧,说明EXT_SOURCE_2越大对于逾期目标的负向贡献越大,也就是正常用户越多,与我们的经验相符。本题中SHAP值排名前20的散点图和柱形图如图8-3和图8-4所示。

8.5.3 Wide&Deep158

8.6 模型评估162

8.7 模型应用168

8.8 案例优化169

8.9 本章小结170

本章基于Kaggle社区上的公开数据集,构建了个人信贷风控建模案例,旨在帮助读者更好地掌握本书第3~6章介绍的方法论内容。本章中的案例是典型的分类问题,在特征工程和探索性数据分析之后,尝试使用逻辑回归、XGBoost和Wide&Deep3种算法分别建模。逻辑回归模型需要从稳定性、重要性、相关性和解释性这4个维度对特征进行筛选,防止特征过多导致模型系数不置信的问题。XGBoost模型通过重要性阈值搜索,确定最合适的入模特征数,在不降低模型效果的前提下提升模型训练效率;利用贝叶斯优化和早停确定最优的超参数组合,并且通过SHAP值解释特征的贡献度。Wide&Deep模型中,将独热特征放到deep结构,其余特征保留在wide结构,虽然模型效果不如XGBoost,但是后期提升空间较大。下一章我们将介绍两个企业信贷风控案例,帮助大家比较C端和B端风控的差异性。

第9章 企业信贷风控案例171

第7章和第8章的案例主要聚焦在个人用户的反欺诈和风控,本章我们来聊一聊智能模型在企业风控场景下的运用。相较于个人贷款,小微企业贷款通常金额较大,且企业的抗风险能力与垂直行业和宏观环境的经济情况密切相关,因此传统的企业授信完全依赖于业务专家的主观判断。在大数据时代,金融机构可以通过搜集企业和企业主的相关信息,搭建小微企业评级模型,实现定性+定量的授信模式,尽量减少人的主观因素。下面从笔者参与过的两个小微企业信贷风控项目,来看一看数据和模型在实战中的应用。

9.1 银行POS贷171

9.1.1 案例背景171

在移动支付大规模普及之前,POS机是商户收款的主要方式,银行通过掌握本行发行POS机的交易流水,便能够了解到商户的经营状况,从而给出一定的授信额度。某城商行有2万个POS机签约商户,希望从中筛选出白名单商户开展POS贷业务,并给出风险评估和建议额度。

9.1.2 原始数据介绍172

9.1.3 特征工程173

9.1.4 模型训练173

9.1.5 模型应用176

我们结合图9-2,来介绍下POS贷模型与行内系统的结合,以及后续线上的应用方式,其中数据仓库POS流水、数据仓库商户主信息、手机银行、征信系统、信贷系统是行内已有的系统和数据,白名单模型、决策引擎、风险模型、额度模型、贷后监控模型是项目方搭建的模型,白名单、风险分、额度、贷后监控数据是模型的输出,客户申请时数据补录商户号、终端编码是商户主在申请贷款时需要补录的信息。

9.2 汽车金融CP评级178

本章第一个案例中,银行通常只会选取一部分信用较好的头部企业授信,并且可以通过查询征信报告和调用企业外部数据等方式,夯实自己的风控策略。而更多的非银行机构,由于贷款利率上的劣势,并不能吸引到头部企业来平台申请贷款,如何通过数据和模型的方式从腰部企业中筛选出优质资产,成了他们最紧迫的问题。本章第二个案例是一家头部汽车金融公司,介绍了它如何利用营运车生态内的数据,为与其合作的汽车租赁公司提供信用评级和贷款服务。

9.2.1 案例背景178

汽车租赁公司(Car Partner,CP)是营运车生态圈中的重要节点。目前市面上超过90%的营运车司机通过CP公司的租赁服务取得汽车的使用权,这种资源共享的模式大幅度降低了营运车司机的前期投入和准入门槛,带动了整个营运车行业的蓬勃发展。行业的发展又反哺上游的CP公司,使这些企业有了更强的融资购车需求。本项目中,某头部汽车金融公司通过授权的方式,获得了与其合作CP公司下属车辆和司机的数据,希望通过这些C端数据为2800家CP公司建立B端评级模型,并联合银行进行贷款服务。

9.2.2 原始数据&特征工程179

9.2.3 模型训练179

9.2.4 模型评估181

9.3 案例优化182

9.4 本章小结183

本章在前两章C端案例的基础上,补充了银行POS贷和汽车金融CP评级两个B端风控案例,帮助大家对智能模型的应用有个更全面的认识。在银行POS贷案例中,由于是个冷启动问题,项目组主要利用Delphi法和PCA权重法,从无监督算法的角度帮助行内专家筛选出重要特征。而在汽车金融CP评级案例中,项目组围绕熵权法,比较了无监督算法和半监督算法的效果差异,并且对于半监督模型的预测结果进行了线下尽调。通过上述两个案例可以看出,对于小微企业信贷风控场景,智能模型在现阶段尚不能完全替代业务专家,未来需要从数据和算法的角度进一步优化。下一章是全书的最后一章,我们将从金融机构内部走向外部,看看智能风控模型如何对外输出,助力金融行业的智能化升级。

第10章 智能风控能力对外输出184

10.1 对外输出的意义184

与内部自建风控相比,将这些能力对外输出是一件看似性价比很低的事情。首先在合作初期双方缺乏了解,这就带来了较高的沟通成本,服务方和采购方要明确项目需求,并且拉齐工作范围和既定的目标。在实施阶段,服务方需要花费时间和人力对采购方的业务和技术现状进行摸底,给出定制化的解决方案,确认后进行远程或者驻场开发。最后是交付阶段,双方需要联调测试,如果项目上线初期效果较差,还要及时跟进和优化。既然对外输出障碍重重,这些头部机构为什么还要致力于开展金融科技业务呢?原因可以从“走出去”和“引进来”两个方面来阐述。

10.1.1 内部能力“走出去”185

10.1.2 外部资源“引进来”185

10.2 头部玩家介绍186

10.2.1 互联网公司186

10.2.2 银行科技子公司189

10.2.3 第三方技术提供商190

数据层面,这些头部提供商起步较早,并且与业内绝大多数金融机构都有合作,从而积累了覆盖全网的黑名单库,包括虚假号码、通信小号、代理IP、作弊设备、垃圾邮箱、身份证黑名单、手机号黑名单等。同时它们有一套成熟的设备指纹技术,能够生成稳定且唯一的设备ID,准确识别模拟器、作弊工具、root等各类作弊行为。在风控方面,这些公司既有云端的标准化评分和策略产品,也有底层上千个指标,覆盖银行、P2P、小贷、现金分期、消费分期、代偿等多个场景的多头数据,支持定制化的联合建模开发。

在数据合作的基础上,这些头部提供商通过多年业务经验的积累,沉淀了一套贯穿贷前、贷中、贷后的全流程信贷风控解决方案,实现云到端的连接,赋能银行和保险客户。某头部公司为银行客户提供贷前识别欺诈客户风险、准确评估申请人、贷中实时动态监控预警、贷后有效触达的服务,支持云风控平台和本地化风控两种方案,同时也为保险公司提供精准的客户画像和客户信息管理,并构建分层营销方案。

10.3 合作模式及案例191

头部的金融科技公司必须有一套完整的对外合作模式,目前常见的合作模式有SaaS、本地化和SaaS+本地化这三种。

10.3.1 SaaS 本地化模式192

SaaS(Software-as-a-Service,软件即服务)是金融科技公司最早对外提供风控服务的方式,SaaS模式最大的优势是使用成本低廉。

10.3.2 对外输出案例193

10.4 金融科技创新与监管195

本章的最后,笔者想聊一聊自己对金融科技行业中创新与监管的一些思考。不可否认,创新是金融科技公司的第一生产力,早期的“互联网+”模式将传统金融中的支付、贷款、保险、理财等业务搬到了线上,丰富与C端客户接触面、提升运营效率的同时,缔造了许多行业内的独角兽公司。然而,P2P公司的良性退出、蚂蚁集团暂缓上市、小贷公司纳入银行监管体系等一系列事件的发生,已经证明了过去金融科技公司商业模式上的创新并不符合监管的要求,联合贷款、资产证券化等模式造成了过大的杠杆率和资金问题。

10.5 本章小结197

本章我们从金融科技的角度,介绍了智能风控能力对外输出方面的内容,主要包括对外输出的意义、头部玩家介绍以及具体合作案例。风控能力对外输出虽然不如机构自营业务利润率高,但是通过金融科技的方式,可以整合机构内外部资源,更重要的是可以突破自身流量或者组织架构的“天花板”。目前金融科技行业内的头部玩家可以分为互联网公司、银行科技子公司和第三方技术提供商这三类,其中模型能力是互联网公司的优势,优质的流量入口掌握在银行渠道,第三方技术提供商则主要从数据和系统的层面切入。这些头部玩家主要是通过SaaS+本地化的模式提供风控服务,这种模式能够在数据安全的前提下,打通提供方和采购方内外部的数据和模型能力。