BERT一直作为一个双向的编码器,主要应用场景都是自然语言理解。

然后出现了一种思路,把BERT用来做Seq2Seq的生成

UNILM

思路如下:

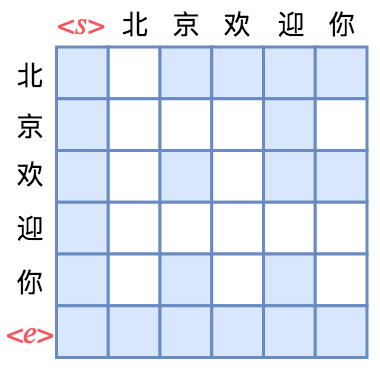

- BERT这种Self-Atten的核心就是Attention矩阵,代表着模型“可见范围”

- Seq2Seq需要观察到部分内容,生成下一部分的内容,即自回归形式

因此,BERT做Seq2Seq就是需要处理Attention Mask矩阵

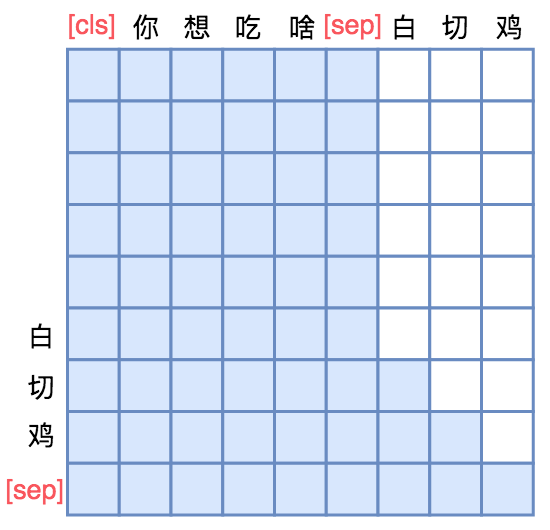

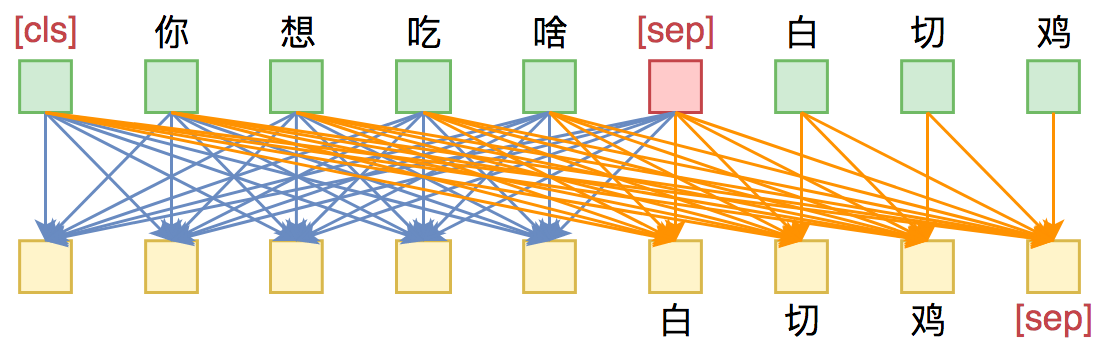

例子如下,需要生成“白切鸡”,蓝色代表可见。

即在编码“你想吃啥”是完全互相课件的,在生成“白切鸡”的时候,生成白只能看到前面的

生成切,可以看到前面的和白。以此类推。

XLNet