这也是一篇受控生成的文章(最近不知道为啥,经常读到这个类型的)

这个文章利用Guide和Prompt组合

Guide这里指的是关键词,关键词就是从原文选择Oracle的句子集(让ROUGE最高),然后选择和reference最长匹配子串,再移除停用词等冗余词汇。

Prompt和下游的任务有关

控制的对象有

- 用关键词

- 实体中心,例如体育新闻,可以关注詹姆斯还是库里的表现情况来生成不同关注的摘要

- 长度控制,可以利用给定关键词的数量来约束模型产生不同长度的摘要

- 同时用关键词和Prompt(关键词在Encoder端额外输入,Prompt是作为Decoder的前缀输入)

- 科研贡献,ArXiv上论文概括作者的Contributions

- 专利研发目的:学习专利证书,概括作者的研究目的(研发这个用来干啥)

- 问题导向的摘要

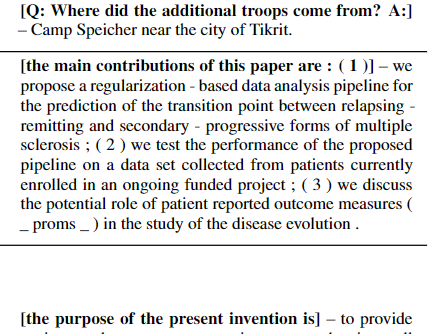

三个下游用途的Prompt设计比较显然,设计的思路其实就是文本续写的感觉,把问题或者提示写在前面,然后让模型接着写(这里的prompt只用在Decoder的input,作为前缀,之前看的一篇专门做NLG Prompt的论文也是这么弄的)(下图黑体加粗部分,后面是生成的结果):

结果

- 关键词来实体导向效果不错,定义的倾向实体在摘要里顺利出现(代表了生成倾向注入成功)

- 长度控制,BART这种模型已经能够很好的判断出Target Reference的长度,已经做的不错,但是这里可以控制的更加准确。

- 问答导向的摘要

- BART在Zero-Shot下,效果不行(我估计就是Copy了原文)

- BART普通的摘要任务Fine-tuing,有了巨额提升

- 利用问题作为Prompt,获得了进一步的大提升

- 说明了摘要问题和QA问题有一定的共通性质,把原文概括就可以比较好的回答问题