刚好看到了论文,里面提到了VAE(变分自编码机)然后读相关材料,看到VAE和GAN有点像

于是阅读了解GAN

原理

GAN的目标只有一个:从给定的一个分布里,生成目标分布

已有材料

- 现有的一个分布

- 目标分布的若干样本

从已有材料和训练目的可以显然得到我们需要一个生成器,生成所谓的目标分布数据。

显然我们需要一个标准评定生成的质量,并作为生成器训练的损失。

但是人工构造的存在一定的问题。

于是用一个生成器,从给定分布计算出“虚构样本”,和目标分布的样本分别为正例和负例,让判别器学习。

原理:

示例

原理里讲的还是很理论化的,同时讲的是WGAN-GP,和简单的GAN也不大一样。于是找到例子:

写的灰常好,很简洁,还有很多注释

不过有一个点:看到很多实现在训练判别器的时候,生成伪造数据的时候用了Detach,其实应该是没有必要的,唯一的优点就是可能跑的比较快。因为两个参数是分开用两个不同的Optimizer优化的,在训练生成器的时候,伪造数据和错误标签的时候,也是不希望更新判别器的,但是没有单独的detach。

# coding=utf-8import torch.autogradimport torch.nn as nnfrom torch.autograd import Variablefrom torchvision import transformsfrom torchvision import datasetsfrom torchvision.utils import save_imageimport os# 创建文件夹if not os.path.exists('./img'):os.mkdir('./img')def to_img(x):out = 0.5 * (x + 1)out = out.clamp(0, 1) # Clamp函数可以将随机变化的数值限制在一个给定的区间[min, max]内:out = out.view(-1, 1, 28, 28) # view()函数作用是将一个多行的Tensor,拼接成一行return outbatch_size = 128num_epoch = 100z_dimension = 100# 图像预处理img_transform = transforms.Compose([transforms.ToTensor(),transforms.Normalize((0.5,), (0.5,)) # (x-mean) / std])# mnist dataset mnist数据集下载mnist = datasets.MNIST(root='./data/', train=True, transform=img_transform, download=True)# data loader 数据载入dataloader = torch.utils.data.DataLoader(dataset=mnist, batch_size=batch_size, shuffle=True)# 定义判别器 #####Discriminator######使用多层网络来作为判别器# 将图片28x28展开成784,然后通过多层感知器,中间经过斜率设置为0.2的LeakyReLU激活函数,# 最后接sigmoid激活函数得到一个0到1之间的概率进行二分类。class discriminator(nn.Module):def __init__(self):super(discriminator, self).__init__()self.dis = nn.Sequential(nn.Linear(784, 256), # 输入特征数为784,输出为256nn.LeakyReLU(0.2), # 进行非线性映射nn.Linear(256, 256), # 进行一个线性映射nn.LeakyReLU(0.2),nn.Linear(256, 1),nn.Sigmoid() # 也是一个激活函数,二分类问题中,# sigmoid可以班实数映射到【0,1】,作为概率值,# 多分类用softmax函数)def forward(self, x):x = self.dis(x)return x# ###### 定义生成器 Generator ###### 输入一个100维的0~1之间的高斯分布,然后通过第一层线性变换将其映射到256维,# 然后通过LeakyReLU激活函数,接着进行一个线性变换,再经过一个LeakyReLU激活函数,# 然后经过线性变换将其变成784维,最后经过Tanh激活函数是希望生成的假的图片数据分布# 能够在-1~1之间。class generator(nn.Module):def __init__(self):super(generator, self).__init__()self.gen = nn.Sequential(nn.Linear(100, 256), # 用线性变换将输入映射到256维nn.ReLU(True), # relu激活nn.Linear(256, 256), # 线性变换nn.ReLU(True), # relu激活nn.Linear(256, 784), # 线性变换nn.Tanh() # Tanh激活使得生成数据分布在【-1,1】之间,因为输入的真实数据的经过transforms之后也是这个分布)def forward(self, x):x = self.gen(x)return x# 创建对象D = discriminator()G = generator()if torch.cuda.is_available():D = D.cuda()G = G.cuda()# 首先需要定义loss的度量方式 (二分类的交叉熵)# 其次定义 优化函数,优化函数的学习率为0.0003criterion = nn.BCELoss() # 是单目标二分类交叉熵函数d_optimizer = torch.optim.Adam(D.parameters(), lr=0.0003)g_optimizer = torch.optim.Adam(G.parameters(), lr=0.0003)# ##########################进入训练##判别器的判断过程#####################for epoch in range(num_epoch): # 进行多个epoch的训练for i, (img, _) in enumerate(dataloader):num_img = img.size(0)# view()函数作用是将一个多行的Tensor,拼接成一行# 第一个参数是要拼接的tensor,第二个参数是-1# =============================训练判别器==================img = img.view(num_img, -1) # 将图片展开为28*28=784real_img = Variable(img).cuda() # 将tensor变成Variable放入计算图中real_label = Variable(torch.ones(num_img)).cuda() # 定义真实的图片label为1fake_label = Variable(torch.zeros(num_img)).cuda() # 定义假的图片的label为0# ########判别器训练train###################### 分为两部分:1、真的图像判别为真;2、假的图像判别为假# 计算真实图片的损失real_out = D(real_img) # 将真实图片放入判别器中real_label = real_label.reshape(-1,1)#print(real_out.shape,real_label.shape)d_loss_real = criterion(real_out, real_label) # 得到真实图片的lossreal_scores = real_out # 得到真实图片的判别值,输出的值越接近1越好# 计算假的图片的损失z = Variable(torch.randn(num_img, z_dimension)).cuda() # 随机生成一些噪声fake_img = G(z).detach() # 随机噪声放入生成网络中,生成一张假的图片。 # 避免梯度传到G,因为G不用更新, detach分离fake_out = D(fake_img) # 判别器判断假的图片,fake_label = fake_label.reshape(-1,1)d_loss_fake = criterion(fake_out, fake_label) # 得到假的图片的lossfake_scores = fake_out # 得到假图片的判别值,对于判别器来说,假图片的损失越接近0越好# 损失函数和优化d_loss = d_loss_real + d_loss_fake # 损失包括判真损失和判假损失d_optimizer.zero_grad() # 在反向传播之前,先将梯度归0d_loss.backward() # 将误差反向传播d_optimizer.step() # 更新参数# ==================训练生成器============================# ###############################生成网络的训练################################ 原理:目的是希望生成的假的图片被判别器判断为真的图片,# 在此过程中,将判别器固定,将假的图片传入判别器的结果与真实的label对应,# 反向传播更新的参数是生成网络里面的参数,# 这样可以通过更新生成网络里面的参数,来训练网络,使得生成的图片让判别器以为是真的# 这样就达到了对抗的目的# 计算假的图片的损失z = Variable(torch.randn(num_img, z_dimension)).cuda() # 得到随机噪声fake_img = G(z) # 随机噪声输入到生成器中,得到一副假的图片output = D(fake_img) # 经过判别器得到的结果g_loss = criterion(output, real_label) # 得到的假的图片与真实的图片的label的loss# bp and optimizeg_optimizer.zero_grad() # 梯度归0g_loss.backward() # 进行反向传播g_optimizer.step() # .step()一般用在反向传播后面,用于更新生成网络的参数# 打印中间的损失if (i + 1) % 100 == 0:print('Epoch[{}/{}],d_loss:{:.6f},g_loss:{:.6f} ''D real: {:.6f},D fake: {:.6f}'.format(epoch, num_epoch, d_loss.data.item(), g_loss.data.item(),real_scores.data.mean(), fake_scores.data.mean() # 打印的是真实图片的损失均值))if epoch == 0:real_images = to_img(real_img.cpu().data)save_image(real_images, './img/real_images.png')fake_images = to_img(fake_img.cpu().data)save_image(fake_images, './img/fake_images-{}.png'.format(epoch + 1))# 保存模型torch.save(G.state_dict(), './generator.pth')torch.save(D.state_dict(), './discriminator.pth')

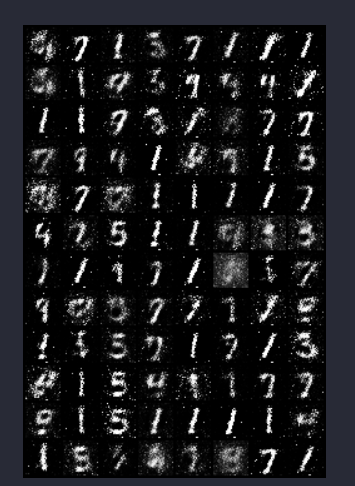

结果

epoch 1,40,100: