AAAI2022 From Dense to Sparse: Contrastive Pruning for Better Pre-trained Language Model Compression

主要是做模型压缩的,随手看了一下,顺便还有一些关于科普

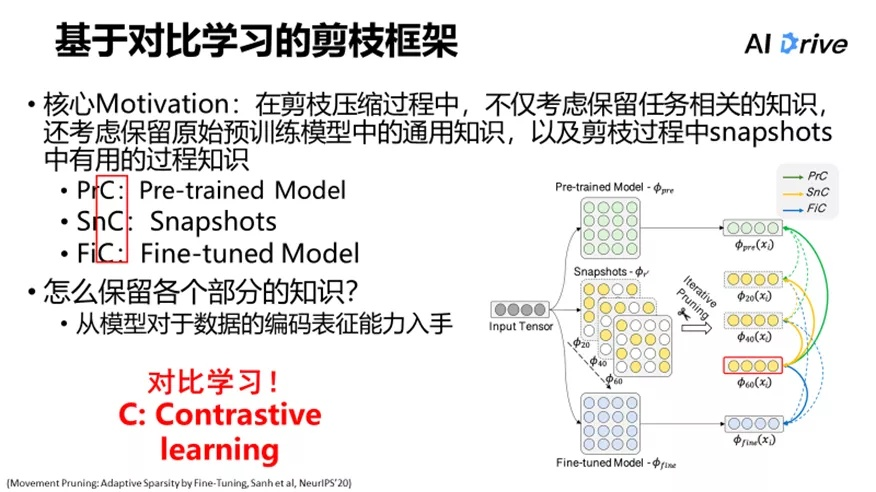

主要思路就是

- 让目标模型编码的结果和当前模型的结果尽可能的相似

- 让当前模型编码其他数据的表示和目标模型当前数据的表示尽可能的远

在训练的过程中保留PLM,不同剪枝程度的模型,以及Fine-tuing之后的模型,同时利用上面的策略进行学习。

这样的话就是在训练的过程里尽可能的保留了可以泛化的知识,以及任务知识。