无监督分词和句法分析!原来BERT还可以这样用

利用BERT作为表示(之前统计学习反正也是要有一个表示的,BERT表示的还更好)

用到的思路是MASK A,然后比较MASK前后某个token表示的差别,就可以得到影响力。

说实话,这个思路和最近的那篇论文真的好像,利用mask前后来获得文档对摘要的影响力,进而得到了事实一致性的评估。

Google新作Synthesizer:我们还不够了解自注意力

自注意力可以使用一个简单的Dense替代,甚至是随机初始化的效果都很不错

假设现在有A、B两支球队,每支各五人。A球队属于明星球队,实力超群;B球队则是新手球队,待训练。为了训练B球队,我们从B球队中选1人,替换掉A球队中的1人,然后让这个“4+1”的A球队不断的练习、比赛。经过一段时间,新加入的成员实体会提升,这个“4+1”的球队就拥有接近原始A球队的实力。重复这个过程,直到B球队的人都被充分训练,那么最终B球队的人也能自己组成一支实力突出的球队。 相比之下, 如果一开始就只有B球队,只是B球队的人自己训练、比赛,那么就算他们的实力逐渐提升,但由于没有实力超群的A球队帮助,其最终实力也不一定能突出。

线性Attention的探索:Attention必须有个Softmax吗?

由于Softmax的存在,导致了计算必须要先计算出K和V的乘积,也就是一个N*N的矩阵

所以有多种方法来避免这个问题

- 利用一个映射函数保证非负性

- 在Q和K内部自己先softmax,等价于计算乘积之后的softmax

还有很多集中于其他的思路包括使用

稀疏的attention矩阵来保证大多数的矩阵位置都是0减小计算量

还有一些用的是下采样的思路,只不过这么做相当于压缩了整个序列,就很难用于生成类型的任务了

我们真的需要把训练集的损失降低到零吗?

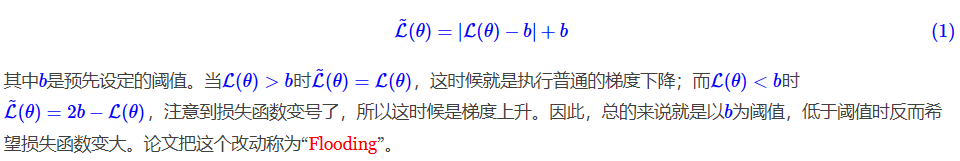

把损失函数修改为