Insight & target problem

提升Abstractive模型的事实一致性

Solution

强化学习方法来训练模型

一个是要求Reward,即要优化的指标,另外一个是要求输出足够稳定,不要过多的偏离参数

然后利用这个方法可以训练出很多的Expert,这些Expert可以倾向于各个方面,然后可以用模型融合的方法来实现进一步的上升。模型融合也包括直接融合参数,和融合输出概率

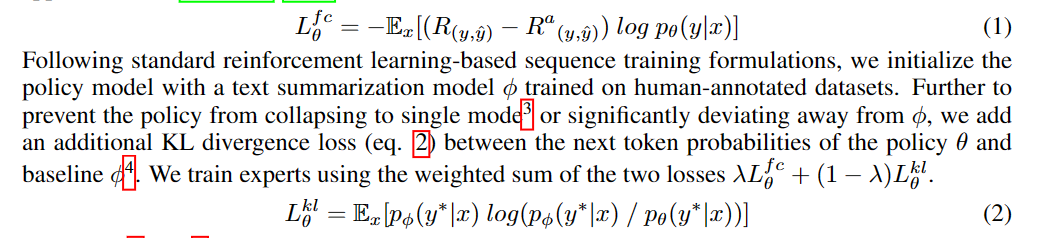

我个人理解的训练方法就是

- 用Pivot summary计算一个分数(举个例子,用reference计算DAE分数)

- 用当前贪心生成的一个摘要,计算分数

- 然后把分数差值乘到普通的MLE Loss上,相当于是放大了loss(假如生成达不到目标)

- 最后KLloss要求更新的大小不能够太大

对于训练数据也有讲究

一个使用reference作为训练数据,一个使用Expert生成的summary作为训练数据

前者经过filter之后可以获得一个比较干净的环境,对训练比较有利。后者是在前者不能够做到足够干净的时候提供一个数据的来源。

然后是论文对于外部错误的定义,外部错误是出现了原文里面没有的内容,对应的判断方法就是看一下摘要里面是不是出现了Document没有的实体,内部错误用的是DAE,一种Entailment的方法