相比起SimpleCLS,这一篇其实就是把评估模型换成了生成模型,而不是Roberta

方案:

用BART-CNN产生一堆candidate

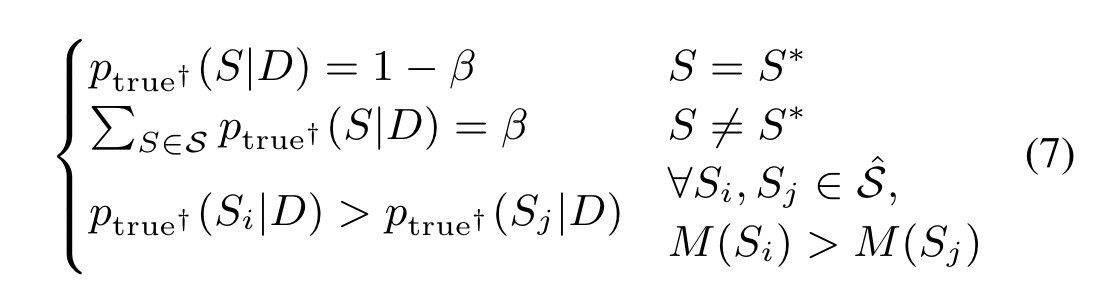

然后要求

- 生成Loss

- candidate 分数为1-beta

- golden分数为beta

- 用ROUGE 弄一个ranking Loss

第一部分就是普通的Loss

第二三部分是类似于Labeling Smoothing

第三部分就是对比学习,要求高质量摘要分数高

分析部分

- candidate多了更好,100的时候最好

- 用这种方法训练的BART-MUL喜欢大beam-size,普通的BART是4

- base版本用BARTCNN一开始生成好的,后面换成BART-InLoop还能涨一点

- 优化的ranking指标也可以是别的,比如Bertscore

- 模型估计自己生成的时候会过于自信,但BART-MUL评估pegasus的生成也不错

- 可以在few-shot上面用

- case study表明可以过滤一些噪音pattern