Q-learning

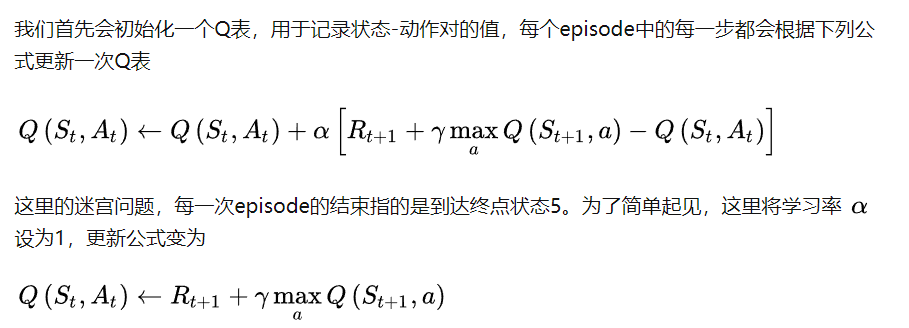

首先是这个Q-Learning,相当于是更新当前位置用的是前一个位置的值,和Reward一起计算,这样一步步的计算直到收敛为止

比如说从0出发的一个实际问题

那么我更新 “从0走到2”这个位置的值,用的就是 Reward(2到3)+ y * “从0走到3”(类似的这种感觉)

DQN

DQN就是把Q-learning的table用一个神经网络来代替了

更新当前位置用的是前一个位置,这里可以看作是两张表格,更新当前位置看作是往新表格里填写,计算依据是Reward和旧表格

对应在Q-learning里就是一个Eval Net和Target Net以及记忆库