模型广场介绍

更新时间:2024-03-16 13:52:13 在这里您可以根据业务所需挑选通义系列大模型、行业大模型或领域大模型、第三方大模型等接入到企业解决方案中。重要

模型广场介绍列表

模型更名

| 模型名称 | 更名后的模型 |

|---|---|

| 通义千问-Max | qwen-max |

| 通义千问-Turbo | qwen-turbo |

| 通义千问-Plus | qwen-plus |

| 通义千问-摘要增强版 | bailian-summary |

| 通义千问-开源版-72B | qwen-72b-chat |

| 通义千问-开源版-14B | qwen-14b-chat |

| 通义千问-开源版-7B | qwen-7b-chat |

| 通义千问-开源版-1.8B-长文本 | qwen-1.8b-longcontext-chat |

| 通义千问-MAX-长文本 | qwen-max-longcontext |

| 通义千问-开源版-1.8B | qwen-1.8b-chat |

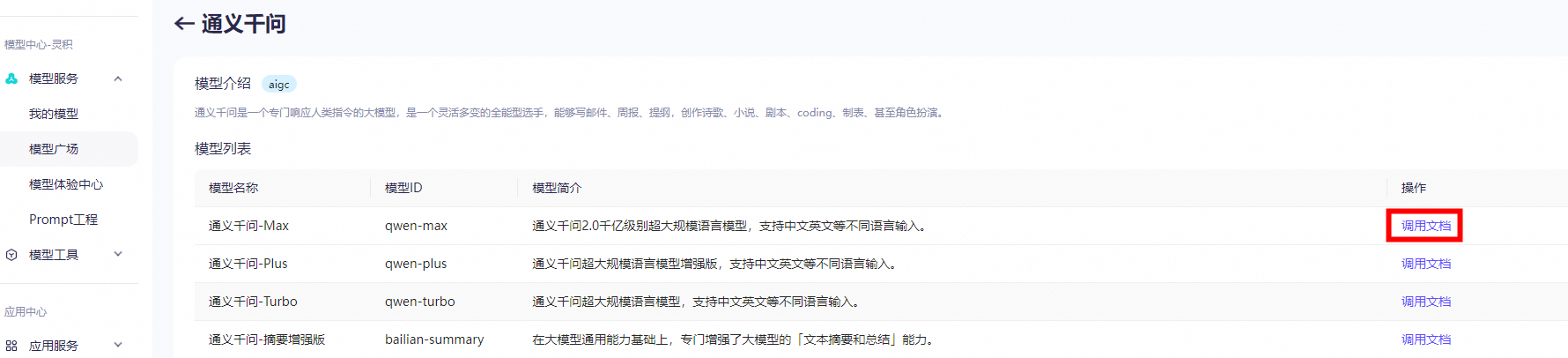

如何查看/调用大模型详情

请先开通百炼推理服务后再创建模型。点击模型广场查看详情按钮,查看预置模型的模型简介、模型名称、及模型调用文档内容。

通义千问

更新时间:2024-04-17 14:52:14模型简介

通义千问是由阿里云自主研发的大语言模型,用于理解和分析用户输入的自然语言,在不同领域、任务内为用户提供服务和帮助。您可以通过提供尽可能清晰详细的指令来获取符合您预期的结果。 通义千问VL是阿里云研发的大规模视觉语言模型(Large Vision Language Model, LVLM),可以以图像、文本、检测框作为输入,并以文本和检测框作为输出,支持中文多模态对话及多图对话,并具有更好的性能,是首个支持中文开放域的通用定位模型和首个开源448分辨率的大规模视觉语言模型。模型概览

| 模型服务 | 模型名称 | 模型描述 | 应用场景 |

|---|---|---|---|

| 通义千问 | qwen-turbo | 通义千问超大规模语言模型,支持中文、英文等不同语言输入。 | 1. 文字创作:撰写故事、公文、邮件、剧本和诗歌等。 2. 文本处理:润色文本和提取文本摘要等。 3. 编程辅助:编写和优化代码等。 4. 翻译服务:提供各类语言的翻译服务,如英语、日语、法语或西班牙语等。 5. 对话模拟:扮演不同角色进行交互式对话。 6. 数据可视化:图表制作和数据呈现等。 |

| qwen-plus | 通义千问超大规模语言模型增强版,支持中文、英文等不同语言输入。 | ||

| qwen-max | 通义千问千亿级别超大规模语言模型,支持中文、英文等不同语言输入。 | ||

| qwen-max-0403 | 通义千问千亿级别超大规模语言模型,支持中文、英文等不同语言输入。该模型为qwen-max的2024年4月3号的历史快照稳定版本,预期维护到下个快照版本发布时间(待定)后一个月。 | ||

| qwen-max-0107 | 通义千问千亿级别超大规模语言模型,支持中文、英文等不同语言输入。该模型为qwen-max的2024年1月7号的历史快照稳定版本,仅推荐特定需求客户访问。 | ||

| qwen-max-1201 将于2024年4月22日下线 |

通义千问千亿级别超大规模语言模型,支持中文、英文等不同语言输入。 | ||

| qwen-max-longcontext | 通义千问千亿级别超大规模语言模型,支持中文、英文等不同语言输入。 | ||

| 通义千问VL | qwen-vl-plus | 通义千问大规模视觉语言模型增强版。大幅提升细节识别能力和文字识别能力,支持超百万像素分辨率和任意长宽比规格的图像。在广泛的视觉任务上提供卓越的性能。 | + 看图做题; + 图文识别; + 增强分辨率; |

| qwen-vl-max | 通义千问超大规模视觉语言模型。相比增强版,再次提升视觉推理能力和指令遵循能力,提供更高的视觉感知和认知水平。在更多复杂任务上提供最佳的性能。 |

计费和限流信息

为了保证用户调用模型的公平性,通义千问对于普通用户设置了基础限流。限流是基于模型维度的,并且和调用用户的阿里云主账号相关联,按照该账号下所有API-KEY调用该模型的总和计算限流。如果超出调用限制,用户的API请求将会因为限流控制而失败,用户需要等待一段时间待满足限流条件后方能再次调用。| 模型名称 | 计费单价 | 免费额度 | 基础限流 |

|---|---|---|---|

| 模型名称 | 计费单价 | 免费额度 | 基础限流 |

|---|---|---|---|

| qwen-turbo | 0.008元/1,000 tokens | 200万tokens 领取方式:新用户开通后自动发放到账户中。点击计费管理开通阿里云百炼服务。 有效期:180天 |

以下条件任何一个超出都会触发限流: + 调用频次 ≤ 500 QPM,每分钟不超过500次API调用; + Token消耗 ≤ 500,000 TPM,每分钟消耗的Token数目不超过500,000。 |

| qwen-plus | ¥0.02/1,000 tokens | 100万tokens 领取方式:新用户开通后自动发放到账户中。点击计费管理开通阿里云百炼服务。 有效期:180天 |

以下条件任何一个超出都会触发限流: + 调用频次 ≤ 200 QPM,每分钟不超过200次API调用; + Token消耗 ≤ 200,000 TPM,每分钟消耗的Token数目不超过200,000。 |

| qwen-max | ¥0.12/1,000 tokens | 100万tokens 领取方式:新用户开通后自动发放到账户中,点击计费管理开通阿里云百炼服务。 有效期:30天 |

以下条件任何一个超出都会触发限流: + 调用频次 ≤ 60 QPM,每分钟不超过60次API调用; + Token消耗 ≤ 100,000 TPM,每分钟消耗的Token数目不超过100,000。 |

| qwen-max-0403 | 以下条件任何一个超出都会触发限流(限时免费开放中,限流策略可能随时变化): + 调用频次 ≤ 60 QPM,每分钟不超过60次API调用; + Token消耗 ≤ 100,000 TPM,每分钟消耗的Token数目不超过100,000。 |

||

| qwen-max-1017 | |||

| qwen-max-1201 将于2024年4月22日下线 |

关闭,qwen-max-1201的维护时间已经到期,4月22日即将下线,请及时迁移到更新版本模型。(4月8日开始模型限流也会逐步调低直至下线) | ||

| qwen-max-longcontext | 以下条件任何一个超出都会触发限流: + 调用频次 ≤ 5 QPM,每分钟不超过5次API调用; + Token消耗 ≤ 1500,000 TPM,每分钟消耗的Token数目不超过1,500,000。 |

||

| qwen-vl-plus | 0.008元/1,000 tokens | 100万tokens 领取方式:新用户开通后自动发放到账户中。点击计费管理开通阿里云百炼服务。 有效期:30天 |

以下条件任何一个超出都会触发限流: + 流量 ≤ 60 QPM,每分钟处理不超过60个完整的请求; + Token消耗 ≤ 100,000 TPM,每分钟消耗的Token数目不超过100,000。 |

| qwen-vl-max | 0.02元/1,000 tokens | 以下条件任何一个超出都会触发限流: + 流量 ≤ 15 QPM,每分钟处理不超过15个完整的请求; + Token消耗 ≤ 25,000 TPM,每分钟消耗的Token数目不超过25,000。 |

说明

超出基础限流配额申请

将以下信息补充完整并发送到邮箱:modelstudio@service.aliyun.com,会有专员进行评估。 UID: 需调整的模型名称: 每分钟请求数: 每分钟使用量(token): 联系电话: 申请原因(需要尽可能的详细): 反馈通义千问VL-开源

更新时间:2024-03-21 09:34:34 通义千问VL是阿里云研发的大规模视觉语言模型(Large Vision Language Model, LVLM),可以以图像、文本、检测框作为输入,并以文本和检测框作为输出,支持中文多模态对话及多图对话,并具有更好的性能,是首个支持中文开放域的通用定位模型和首个开源448分辨率的大规模视觉语言模型。 通义千问VL模型主要有以下特点:- 强大的性能:在四大类多模态任务的标准英文测评中(Zero-shot Captioning/VQA/DocVQA/Grounding)上,均取得同等通用模型大小下最好效果;

- 多语言对话模型:天然支持英文、中文等多语言对话,端到端支持图片里中英双语的长文本识别;

- 多图交错对话:支持多图输入和比较,指定图片问答,多图文学创作等;

- 首个支持中文开放域定位的通用模型:通过中文开放域语言表达进行检测框标注;

- 细粒度识别和理解:相比于目前其它开源LVLM使用的224分辨率,Qwen-VL是首个开源的448分辨率的LVLM模型。更高分辨率可以提升细粒度的文字识别、文档问答和检测框标注。

- Qwen-VL: Qwen-VL 以 Qwen-7B 的预训练模型作为语言模型的初始化,并以Openclip ViT-bigG作为视觉编码器的初始化,中间加入单层随机初始化的 cross-attention,经过约1.5B的图文数据训练得到。最终图像输入分辨率为448。

- Qwen-VL-Chat: 在 Qwen-VL 的基础上,我们使用对齐机制打造了基于大语言模型的视觉AI助手Qwen-VL-Chat,其训练数据涵盖了 QWen-7B 的纯文本 SFT 数据、开源 LVLM 的 SFT 数据、数据合成和人工标注的图文对齐数据。

基本信息

| 模型服务 | 模型名称 | 模型描述 | 应用场景 |

|---|---|---|---|

| 通义千问VL | qwen-vl-v1 即将上架 |

以 Qwen-7B 语言模型初始化,添加图像模型,图像输入分辨率为448的预训练模型。 | + 支持英文、中文等多语言对话,端到端支持图片里中英双语的长文本识别; + 支持多图输入和比较,指定图片问答,多图文学创作等; + 通过中文开放域语言表达进行检测框标注; |

| qwen-vl-chat-v1 即将上架 |

通义千问VL支持灵活的交互方式,包括多图、多轮问答、创作等能力的模型。 |

计费和限流信息

限流是基于模型维度的,并且和调用用户的阿里云主账号相关联,按照该账号下所有API-KEY调用该模型的总和计算。说明

限流是基于模型维度的,并且和调用用户的阿里云主账号相关联,按照该账号下所有API-KEY调用该模型的总和计算限流。| 模型名称 | 计费单价 | 免费额度 | 基础限流 |

|---|---|---|---|

| 模型名称 | 计费单价 | 免费额度 | 基础限流 |

|---|---|---|---|

| qwen-vl-v1 即将上架 |

限时免费 | 10万tokens 领取方式:开通阿里云百炼大模型后,自动发放; 有效期:180天 |

以下条件任何一个超出都会触发限流: + 流量 ≤ 60 QPM,每分钟处理不超过60个完整的请求; + Token消耗 ≤ 10,000 TPM,每分钟消耗的Token数目不超过10,000。 |

| qwen-vl-chat-v1 即将上架 |

说明

超出基础限流配额申请

将以下信息补充完整并发送到邮箱:modelstudio@service.aliyun.com,会有专员进行评估。 阿里云主账号UID: 需调整的模型名称: 每分钟请求数: 每分钟使用量(token): 联系电话: 申请原因(需要尽可能的详细): 反馈大语言模型

更新时间:2024-04-28 18:21:59模型简介

Qwen1.5

Qwen1.5是Qwen开源系列的下一个版本。与之前的版本相比,Qwen1.5显著提升了聊天模型与人类偏好的一致性,改善了它们的多语言能力,并具备了强大的链接外部系统能力。灵积上提供API服务的是新版本qwen模型的chat版本,在chat能力上大幅提升,即便在英文的MT-Bench上,Qwen1.5-Chat系列也取得了优秀的性能。 阿里云百炼平台上提供的0.5B模型、1.8B模型、7B模型、14B模型、32B模型和72B模型基于千问开源版本,进行了针对性的推理性能优化,为广大开发者提供便捷的API服务。各个版本均对应魔搭社区开源的各个尺寸的模型版本,详细参考链接。CodeQwen1.5

CodeQwen1.5是专门针对代码的Qwen1.5版本。与Qwen1.5相比,CodeQwen1.5在大量的代码数据上训练得到。它拥有强大的代码生成能力,在一系列基准测试中展现出不凡的竞争力。其支持92种编程语言,上下文长度可达64K,在SQL生成和bug修复方面均有出色的表现。 阿里云百炼平台上提供的7B模型基于千问开源版本,进行了针对性的推理性能优化,为广大开发者提供便捷的API服务。各个版本均对应魔搭社区开源的各个尺寸的模型版本,详细参考链接。Qwen

通义千问为阿里云研发的大语言系列模型。千问模型基于Transformer架构,在超大规模的预训练数据上进行训练得到。预训练数据类型多样,覆盖广泛,包括大量网络文本、专业书籍、代码等。同时,在预训练模型的基础之上,使用对齐机制打造了模型的chat版本。其中千问-1.8B是18亿参数规模的模型,千问-7B是70亿参数规模的模型,千问-14B是140亿参数规模的模型,千问-72B是720亿参数规模的模型。 阿里云百炼平台上提供的1.8B模型、7B模型、14B模型和72B模型基于千问开源版本,进行了针对性的推理性能优化,为广大开发者提供便捷的API服务。其中1.8B模型基于最新在魔搭社区开源的最新版本,7B模型基于最新在魔搭社区上开源的V1.1版本,而14B模型同样基于魔搭社区上最新版本提供,72B模型基于魔搭社区开源的最新版本提供。| 模型服务 | 模型名称 | 模型描述 | 应用场景 |

|---|---|---|---|

| 通义千问110B | qwen1.5-110b-chat | 通义千问1.5对外开源的110B规模参数量的经过人类指令对齐的chat模型。 | 1. 文字创作:撰写故事、公文、邮件、剧本和诗歌等。 2. 文本处理:润色文本和提取文本摘要等。 3. 编程辅助:编写和优化代码等。 4. 推理服务:语言编程。 |

| 通义千问72B | qwen1.5-72b-chat | 通义千问1.5对外开源的72B规模参数量的经过人类指令对齐的chat模型。 | |

| qwen-72b-chat | 通义千问对外开源的72B规模参数量的经过人类指令对齐的chat模型。 | ||

| 通义千问32B | qwen1.5-32b-chat | 通义千问1.5对外开源的32B规模参数量的经过人类指令对齐的chat模型 | |

| 通义千问14B | qwen-14b-chat | 通义千问对外开源的14B规模参数量的经过人类指令对齐的chat模型。 | |

| qwen1.5-14b-chat | 通义千问1.5对外开源的14B规模参数量的经过人类指令对齐的chat模型。 | ||

| 通义千问7B | qwen1.5-7b-chat | 通义千问1.5对外开源的7B规模参数量是经过人类指令对齐的chat模型。 | |

| qwen-7b-chat | 通义千问对外开源的7B规模参数量的经过人类指令对齐的chat模型。 | ||

| codeqwen1.5-7b-chat | 通义千问1.5对外开源的7B规模参数量的经过人类指令对齐的针对代码场景的chat模型。 | ||

| 通义千问1.8B | qwen-1.8b-longcontext-chat | 通义千问对外开源的1.8B规模参数量的经过人类指令对齐的chat模型。 | |

| qwen-1.8b-chat | 通义千问对外开源的1.8B规模参数量的经过人类指令对齐的chat模型。 | ||

| qwen1.5-1.8b-chat | 通义千问1.5对外开源的1.8B规模参数量的经过人类指令对齐的chat模型。 | ||

| 通义千问0.5B | qwen1.5-0.5b-chat | 通义千问1.5对外开源的0.5B规模参数量的经过人类指令对齐的chat模型。 |

计费和限流信息

说明

限流是基于模型维度的,并且和调用用户的阿里云主账号相关联,按照该账号下所有API-KEY调用该模型的总和计算限流。| 模型名称 | 计费单价 | 免费额度 | 基础限流 |

|---|---|---|---|

| qwen1.5-110b-chat | 限时免费中 | 100万tokens 领取方式:新用户开通后自动发放到账户中,点击计费管理开通阿里云百炼服务。 有效期:1个月 |

以下条件任何一个超出都会触发限流(限时免费开放中,限流策略可能随时变化): + 流量 ≤ 10 QPM,每分钟处理不超过10个完整的请求; + Token消耗 ≤ 20,000 TPM,每分钟消耗的Token数目不超过20,000。 |

| qwen-72b-chat | 0.02元/1,000tokens | 以下条件任何一个超出都会触发限流(限时免费开放中,限流策略可能随时变化): + 流量 ≤ 80 QPM,每分钟处理不超过80个完整的请求; + Token消耗 ≤ 130,000 TPM,每分钟消耗的Token数目不超过130,000。 |

|

| qwen-72b-chat | 限时免费中 | 以下条件任何一个超出都会触发限流: + 流量 ≤ 10 QPM,每分钟处理不超过10个完整的请求; + Token消耗 ≤ 20,000 TPM,每分钟消耗的Token数目不超过20,000。 |

|

| qwen-14b-chat | 0.008元/1,000tokens | 以下条件任何一个超出都会触发限流: + 流量 ≤ 300 QPM,每分钟处理不超过300个完整的请求; + Token消耗 ≤ 500,000 TPM,每分钟消耗的Token数目不超过500,000。 |

|

| qwen-7b-chat | 0.006元/1,000tokens | ||

| qwen-1.8b-chat | 限时免费中 | 限时免费中 | 以下条件任何一个超出都会触发限流: + 流量 ≤ 120 QPM,每分钟处理不超过120个完整的请求; + Token消耗 ≤ 200,000 TPM,每分钟消耗的Token数目不超过200,000。 |

| qwen-1.8b-longcontext-chat | 限时免费中 | 限时免费中 | / |

| qwen1.5-7b-chat | 0.006元/1,000tokens | 100万tokens 领取方式:新用户开通后自动发放到账户中,老用户自动补发免费额度。点击计费管理开通阿里云百炼服务。 有效期:1个月 |

/ |

| qwen1.5-14b-chat | 0.008元/1,000tokens | / | |

| qwen1.5-72b-chat | 0.02元/1,000tokens | / |

说明

超出基础限流配额申请

将以下信息补充完整并发送到邮箱:modelstudio@service.aliyun.com,会有专员进行评估。 阿里云主账号UID: 需调整的模型名称: 每分钟请求数: 每分钟使用量(token): 联系电话: 申请原因(需要尽可能的详细): 反馈