深度学习,监督学习,无监督预训练

Deep Learning (2015)

概括

这篇文章是于2015年,深度学习三大神(Yann LeCun,Yoshua Bengio & Geoffrey Hinton),为了纪念人工智能60周年,合作在Nature上发表深度学习的综述性文章,介绍了深度学习的基本原理和核心优势,详细介绍了CNN、分布式特征表示、RNN及其不同的应用,并对深度学习技术的未来发展进行展望。

思想提炼

深度学习vs传统机器学习

- 深度学习就是一种特征学习方法,把原始数据通过一些简单的但是非线性的模型转变成为更高层次的,更加抽象的表达。通过足够多的转换的组合,非常复杂的函数也可以被学习。

- 深度学习的核心方面是,上述各层的特征都不是利用人工工程来设计的,而是使用一种通用的学习过程从数据中学到的。

传统的方法是手工设计良好的特征提取器,这需要大量的工程技术和专业领域知识。

监督学习,最常见的机器学习模式

反向传播前馈网络

- 反向传播算法的核心思想是:目标函数对于某层输入的导数(或者梯度)可以通过向后传播对该层输出(或者下一层输入)的导数求得。

- 简单的梯度下降会让整个优化陷入到不好的局部最小解。

预训练

文中提及:

2006年前后,加拿大高级研究院(CIFAR)聚集了一个研究员团队,他们使得人们重燃了对于深度前馈网络的研究兴趣。研究者们介绍了不需要有标签数据就可以创建多层特征检测器的无监督学习方法。在学习过程中,每一层的特征检测器的目标是希望能够在下一层重建或模拟特征检测器(或原始数据)的活动。通过利用重构目标预训练出更加复杂的若干层特征提取器,网络的权重可以被初始化为合适的值。输出层加在网络的顶部后,整个网络可以通过标准的BP算法做出相应的调整。这个方法在手写体识别和行人检测方面有很好的效果,特别是当有标签数据十分有限的时候。

并且提及了GPU计算的出现,让这种巨大计算量的预训练成为了可能。

卷积神经网络

卷积神经网络的4个核心思想: 局部连接; 权值共享; 池化操作; 多层次结构。

局部连接: 原始数据的局部关联性, 如图像数据, 它可以形成比较容易被探测到的具有区分性的局部特征.

权值共享: 局部特征与位置无关, 使用具有平移不变性.

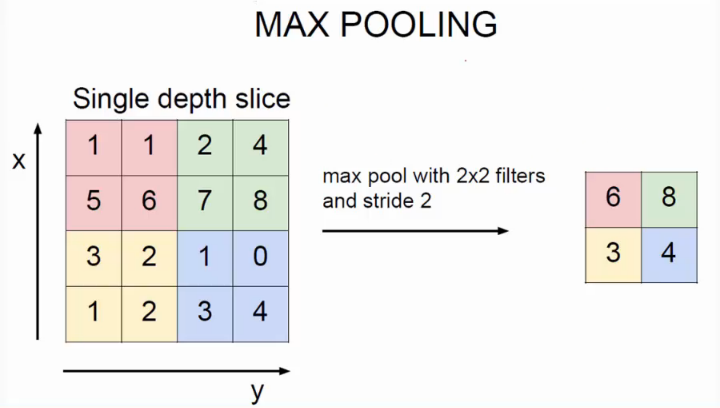

池化操作: 池化的操作是将语意相似的特征合并起来, 它可以减少表达的维度, 还可以做到缩放不变性, 提高鲁棒性(creating an invariance to small shifts and distortions).

多层次结构: 挖掘数据的多层次语意特征(像素—>形状—>图案—>部件—>物体)——得益于硬件性能升级。

循环神经网络

- 循环神经网络很强大, 但训练上存在问题, 会存在梯度消失或梯度爆炸的问题

- 理论和经验证实RNN很难学习并长期保存信息, 为了解决这个问题, 引入了网络存储的问题, 提出了LSTM, 它也可以解决梯度消失的问题(但不能解决梯度爆炸的问题)

分布式表示与语言处理

深度学习理论表明,与不使用分布式表示的传统学习算法相比,深度网络具有两种不同的指数级的优势:

- 学习分布式表示使泛化成为学习特征值的新组合,超出了在训练期间看到的值。(比如,n元特征就有2n种可能的组合)

- 在深层网络中构成表示法层可能带来另一个指数级的优势(指数级的深度)。

这两个优点都源于组合的强大功能,并且依赖于具有适当组件结构的底层数据生成分布。

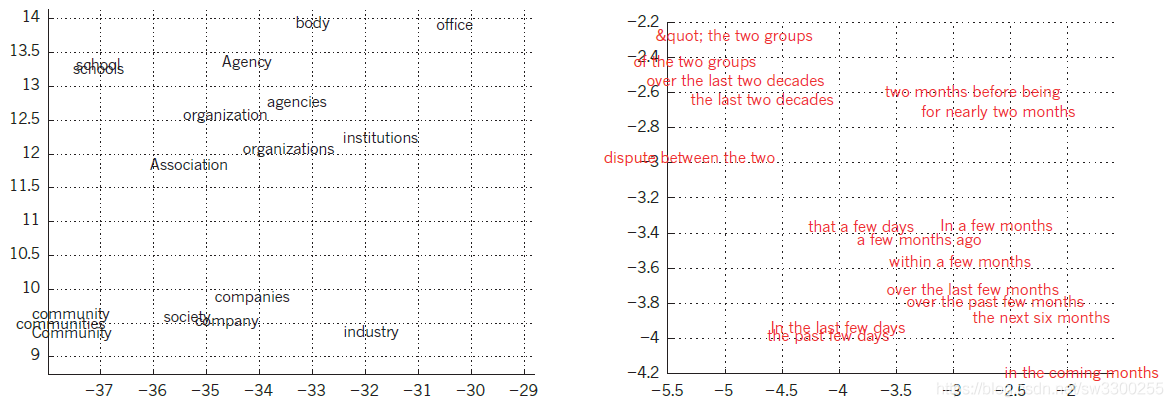

左图是为语言建模所学习的单词表达的图解,使用t-SNE算法将其非线性映射到2维实现可视化。右图是由一个英语-法语编解码递归神经网络学习到的单词的2维表达。可以观察到语义上相似的单词会在图上表达在相近的区域。单词表达的分布是由BP算法对每个单词表达的共同学习和一个可以预测目标总量的函数得到的,例如一句话中的下一个单词(针对语言模型)或一整句话的译文(针对机器翻译)。

未来展望

- 无监督学习——人类和动物学习是无监督的:我们通过观察去发现世界的结构,而不是被告知每个物体的名字。

- 计算机视觉方面——结合深度学习与强化学习的系统。

- 自然语言理解方面——希望使用循环神经网络的系统学会选择性地一次能够进入某一部分的策咯,从而使得它们理解句子或整个文档的效果变得更好。

- 结合表示学习与复杂推理的系统。

参考文献

论文笔记 - 《Deep Learning》(Yann LeCun Yoshua Bengio & Geoffrey Hinton) 精典_Tom的专栏-CSDN博客

LeCun、Bengio和Hinton综述论文《deep learning》_忧郁一休-CSDN博客

Deep Learning(LeCun、Bengio、Hinton在Nature上发表的综述)学习笔记_stu14jzzhan的博客-CSDN博客

《 Deep Learning 》全文翻译 Yann LeCun, Yoshua Bengio, Geoffrey Hinton_陆羽飞的博客-CSDN博客

Deep Learning for AI (2021)

概况

由Yann LeCun,Yoshua Bengio & Geoffrey Hinton写于2021年的简短的综述性文章,回顾了深度学习的基本概念和一些突破性成果,讲述了深度学习的起源、发展及未来的发展面临的挑战。

思想概况

深度学习的兴起

- 随着架构和训练程序的不断进步,人们认识到更深层次的神经网络可能更加强大。更深层的网络能够更好地概括「输入-输出关系类型」,而这不仅只是因为参数变多了。深度网络通常比具有相同参数数量的浅层网络具有更好的泛化能力。

- GPU和大型数据集以及具有自动区分功能、开源、灵活的软件平台(如Theano、Torch、Caffe、TensorFlow等)是深度学习兴起的基础。

无监督的预训练

- 预训练将输入转换为一种表示形式,从而使分类更容易,这在当下计算成本低廉、标记数据昂贵的条件下是很有效的方法。

- 预训练+大量无标签数据,使得训练非常大的模型成为可能。

- 预训练和微调的一般原则已成为深度学习工具箱中的重要工具。

线性整流单元的成功之谜

- 早期通常使用sigmoid非线性函数或与之密切相关的双曲正切函数,对隐藏层进行无监督的预训练。

- 人们惊喜地发现,非线性整流(relu)通过反向传播和随机梯度下降,让训练深度网络变得更加便捷,无需进行逐层预训练。

语音和物体识别方面的突破

- 声学模型将声波转换为音素片段的概率分布。Robinson、Morgan 等人分别使用了晶片机和DSP芯片,他们的尝试均表明,如果有足够的处理能力,神经网络可以与最先进的声学建模技术相媲美。

- 2012年,谷歌显着改善了 Android 上的语音搜索,深度学习在 ImageNet 竞赛中取得了戏剧性的胜利。

- 计算机视觉领域,卷积神经网络的优越性无可争议。

深度学习近期的主要成就

- 主要提及了soft attention与Transformer架构,无监督与自监督学习中的对比学习,以及生成模型(包括生成对抗模型与变分自编码器)。

未来的挑战

对于深度学习而言,提升它的性能表现有简单直接的办法——提升模型规模(例,GPT1,2,3)。但是对于深度学习而言仍然存在着靠提升参数模型和计算无法解决的缺陷。

- 监督学习需要太多的数据标注,而无模型强化学习又需要太多试错。对于人类而言,像要学习某项技能肯定不需要这么多的练习。

- 如今的系统对于分布变化适应的鲁棒性比人类差的太远,人类只需要几个范例,就能够快速适应类似的变化。

- 如今的深度学习对于感知而言无疑是最为成功的,也就是所谓的系统1类任务,如何通过深度学习进行系统2类任务(需要计算机思考的部分),则需要审慎的通用步骤。在这方面的研究令人期待。

上述三点问题导致:即便如今最厉害的人工智能,从实验室投入到实际应用中时,其性能仍然会大打折扣。

展望

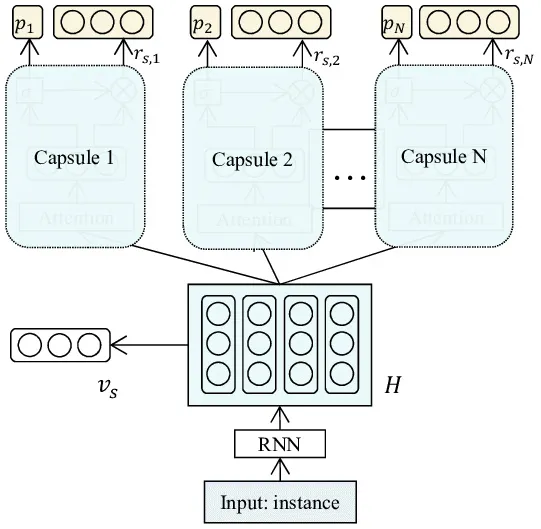

- 从同质层到代表实体的神经元组:胶囊架构,在单元中的元素与一个向量相关联,从中可以读取关键向量、数值向量(有时也可能是一个查询向量)。

- 适应多个时间尺度:大多数神经网络只有两个时间尺度:权重在许多示例中适应得非常慢,而行为却在每个新输入中对于变化适应得非常快速。通过添加快速适应和快速衰减的“快速权重”的叠加层,则会让计算机具备非常有趣的新能力。多时间尺度适应的功能在元学习(meta-learning)中正在逐渐被采纳。

- 更高层次的认知:希望机器可以利用已经掌握的知识和通用技能,以新的方式动态地重新组合它们,从而完成新的任务。举例:机械学习依赖于归纳偏差或者先验经验,那么是否可以通过归纳偏差发现这个世界潜在的一些因果属性。

参考文献

三巨头近期共同撰文:Deep Learning for AI - 简书 (jianshu.com)

Hinton,Lecun和Bengio三巨头联手再发万字长文:深度学习的昨天、今天和明天 (qq.com)

Deep Learning for AI | July 2021 | Communications of the ACM

总结

- 2021年的Deep Learning for AI相比2015年的Deep Learning,重心从监督学习转向了无监督学习,匹配当今计算成本低,数据规模大,标签数据昂贵的大环境。

- 2015年的展望中希望用RNN系统来做自然语言理解,如今已变为Transformer架构。

- 提升泛化的鲁棒性。

- 如今,感知任务以及做的很好了,人们的注意力转向了系统2的逻辑推理能力。