工作机制

- 上报所有块信息:默认1小时(刚启动的时候就会发送一次)

- 心跳机制:3秒

- 节点不可用判定:10分钟

- 节点判定死亡:10分钟+30秒

数据完整性

客户端上传数据的时候,block块会生成checksum

datanode接收到client传过来的数据后,会重新计算checksum值(.crc文件)

如果两个值不相同,则证明数据不完整

掉线时限参数设置

如果定义超时时间为TimeOut,则超时时长的计算公式为:

需要注意的是hdfs-site.xml 配置文件中的heartbeat.recheck.interval的单位为毫秒,dfs.heartbeat.interval的单位为秒

<property><name>dfs.namenode.heartbeat.recheck-interval</name><value>300000</value></property><property><name>dfs.heartbeat.interval</name><value>3</value></property>

服役新数据节点(添加新服务器)

1)环境准备

(1)在hadoop104主机上再克隆一台hadoop105主机

(2)修改IP地址和主机名称

(3)删除原来HDFS文件系统留存的文件(/opt/module/hadoop-3.1.3/data和logs,/tmp/*),

如果不删除那么102和105不能同时在线。如果同时在线,那么会发现一会102在线一会105在线

注:/etc/hosts里的文件一定要有hadoop105

(4)配置worker(群起命令需要读取这个配置文件,不设置则,则start-dfs.sh群起不会启动105,需要另外启动)

(5)source一下配置文件

[atguigu@hadoop105 hadoop-3.1.3]$ source /etc/profile

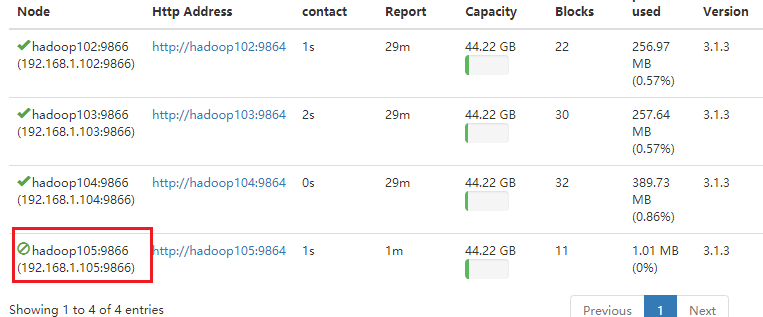

3)服役新节点具体步骤

(1)直接启动DataNode,即可关联到集群(如果设置了worker则群起即可,不设置则要输入下面指令)

[atguigu@hadoop105 hadoop-3.1.3]$ hdfs --daemon start datanode//启动datanode[atguigu@hadoop105 hadoop-3.1.3]$ sbin/yarn-daemon.sh start nodemanager//启动nodemanager

(2)在hadoop105上上传文件

[atguigu@hadoop105 hadoop-3.1.3]$ hadoop fs -put /opt/module/hadoop-3.1.3/LICENSE.txt /

负载聚恒问题

什么是负载不均衡?新加入的服务器存储的数据量很少,负载均衡则是要分配一部分数据到新服务器中,以到达平衡

(3)如果数据不均衡,可以用命令实现集群的再平衡

[atguigu@hadoop102 sbin]$ ./start-balancer.shstarting balancer, logging to /opt/module/hadoop-3.1.3/logs/hadoop-atguigu-balancer-hadoop102.outTime Stamp Iteration# Bytes Already Moved Bytes Left To Move Bytes Being Moved

退役旧数据节点

添加白名单

添加到白名单的主机节点,都允许访问NameNode,不在白名单的主机节点,都会被退出。

配置白名单的具体步骤如下:

1)在NameNode的/opt/module/hadoop-3.1.3/etc/hadoop目录下创建dfs.hosts文件

添加如下主机名称hadoop102hadoop103hadoop104hadoop105

2)在NameNode的hdfs-site.xml配置文件中增加dfs.hosts属性

<property><name>dfs.hosts</name><value>/opt/module/hadoop-3.1.3/etc/hadoop/dfs.hosts</value></property>

3)配置文件分发

[atguigu@hadoop102 hadoop]$ xsync hdfs-site.xml

4)刷新NameNode

[atguigu@hadoop102 hadoop-3.1.3]$ hdfs dfsadmin -refreshNodesRefresh nodes successful

5)更新ResourceManager节点

[atguigu@hadoop102 hadoop-3.1.3]$ yarn rmadmin -refreshNodes17/06/24 14:17:11 INFO client.RMProxy: Connecting to ResourceManager at hadoop103/192.168.1.103:8033

6)在web浏览器上查看

7)如果数据不均衡,可以用命令实现集群的再平衡

[atguigu@hadoop102 sbin]$ ./start-balancer.shstarting balancer, logging to /opt/module/hadoop-3.1.3/logs/hadoop-atguigu-balancer-hadoop102.outTime Stamp Iteration# Bytes Already Moved Bytes Left To Move Bytes Being Moved

添加黑名单

在黑名单上面的主机都会被强制退出。

1)在NameNode的/opt/module/hadoop-3.1.3/etc/hadoop目录下创建dfs.hosts.exclude文件

添加如下主机名称(要退役的节点)hadoop105

2)在NameNode的hdfs-site.xml配置文件中增加dfs.hosts.exclude属性

<property><name>dfs.hosts.exclude</name><value>/opt/module/hadoop-3.1.3/etc/hadoop/dfs.hosts.exclude</value></property>

3)刷新NameNode、刷新ResourceManager

[atguigu@hadoop102 hadoop-3.1.3]$ hdfs dfsadmin -refreshNodesRefresh nodes successful[atguigu@hadoop102 hadoop-3.1.3]$ yarn rmadmin -refreshNodes17/06/24 14:55:56 INFO client.RMProxy: Connecting to ResourceManager at hadoop103/192.168.1.103:8033

4)检查Web浏览器,退役节点的状态为decommission in progress(退役中),说明数据节点正在复制块到其他节点 退役ing

退役ing 退役完成

退役完成

5)等待退役节点状态为decommissioned(所有块已经复制完成),停止该节点及节点资源管理器。注意:如果副本数是3,服役的节点小于等于3,是不能退役成功的,需要修改副本数后才能退役

[atguigu@hadoop105 hadoop-3.1.3]$ hdfs --daemon stop datanodestopping datanode[atguigu@hadoop105 hadoop-3.1.3]$ sbin/yarn-daemon.sh stop nodemanagerstopping nodemanager

6)如果数据不均衡,可以用命令实现集群的再平衡、

[atguigu@hadoop102 hadoop-3.1.3]$ sbin/start-balancer.shstarting balancer, logging to /opt/module/hadoop-3.1.3/logs/hadoop-atguigu-balancer-hadoop102.outTime Stamp Iteration# Bytes Already Moved Bytes Left To Move Bytes Being Moved

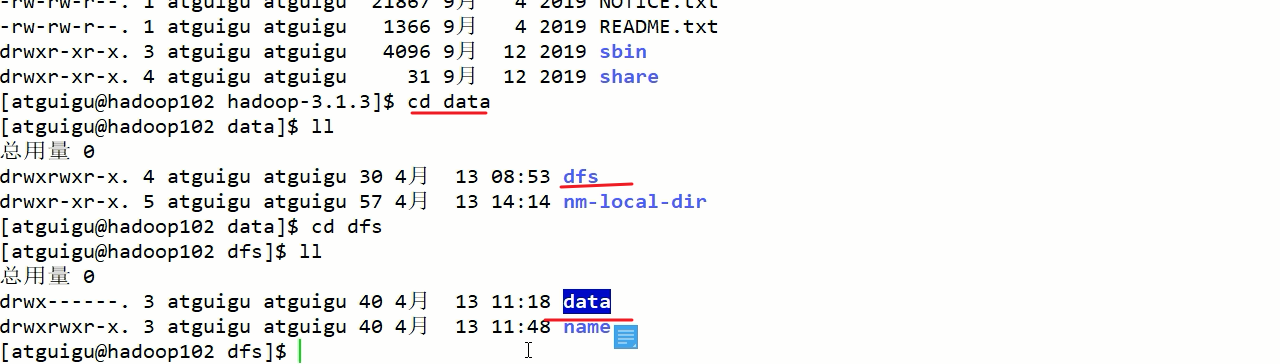

Datanode多目录(磁盘)配置

1)DataNode也可以配置成多个目录,每个目录存储的数据不一样。即:数据不是副本

解释:这个是为了解决磁盘不够,用服务器另外存在的磁盘来存储数据的问题

2)具体配置如下

hdfs-site.xml

<property><name>dfs.datanode.data.dir</name><value>file:///${hadoop.tmp.dir}/dfs/data1,file:///${hadoop.tmp.dir}/dfs/data2</value></property>------------------------------------------------------说明:${hadoop.tmp.dir}=/opt/module/hadoop-3.1.3/data位置:[core-site.xml]

↓

配置后重启datanode

配置前:

配置后: