日志文件

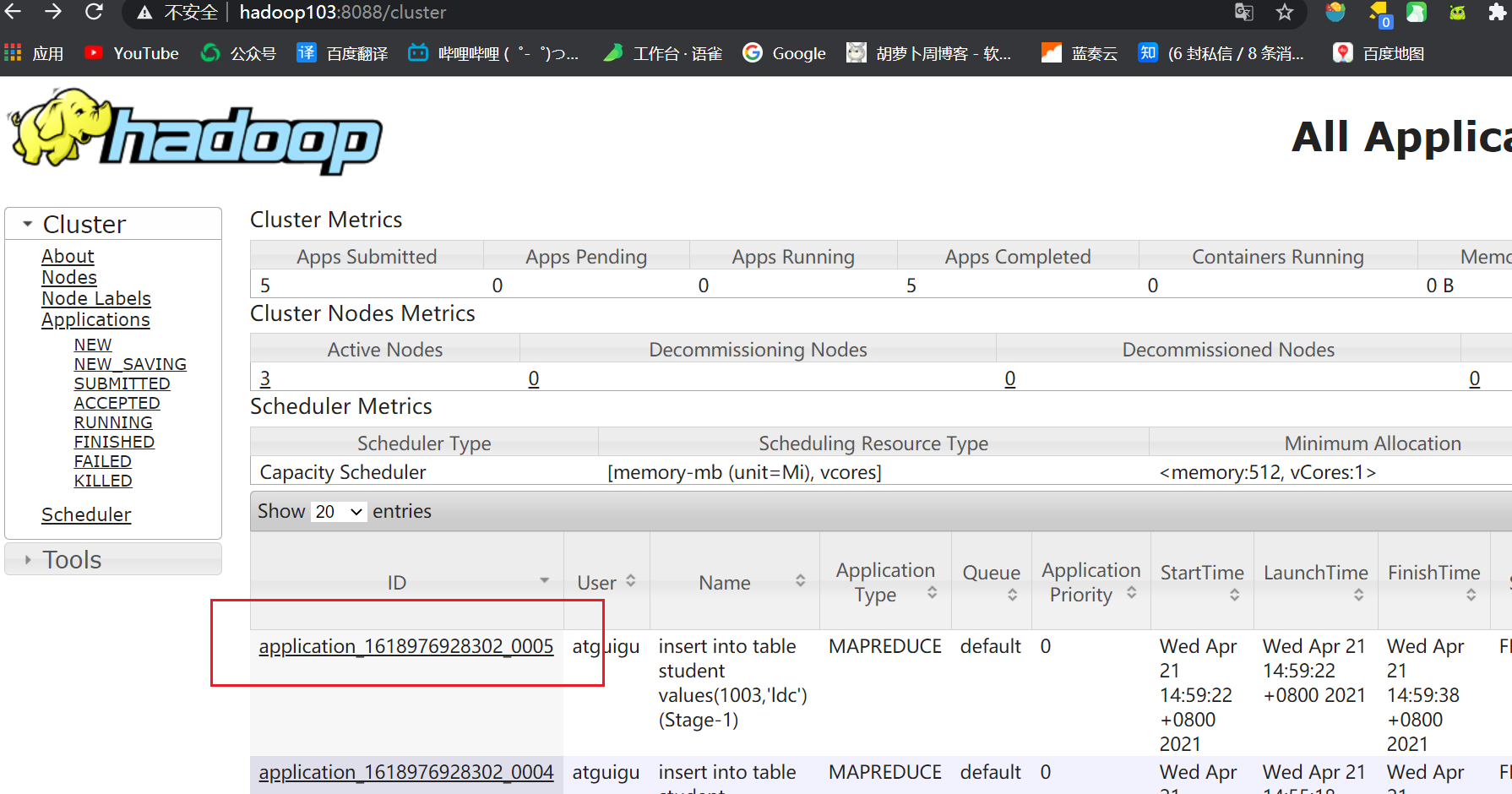

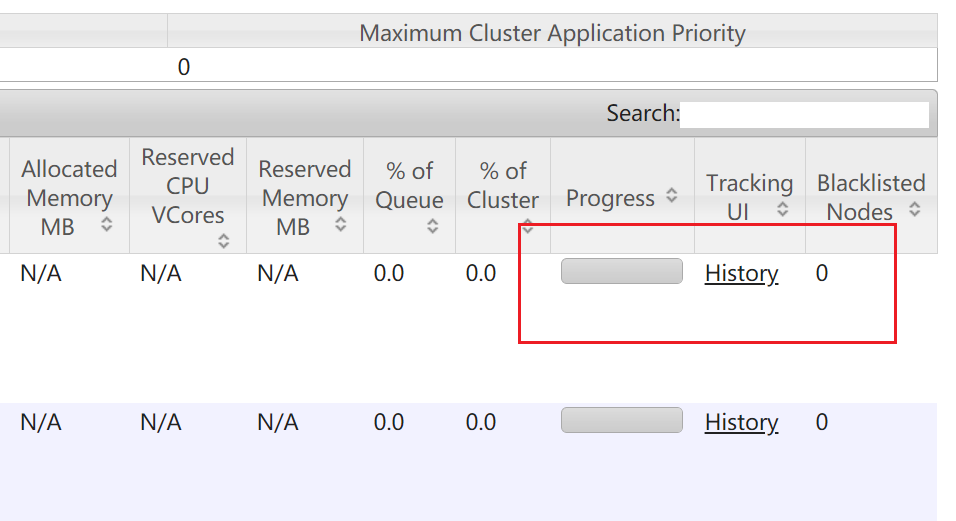

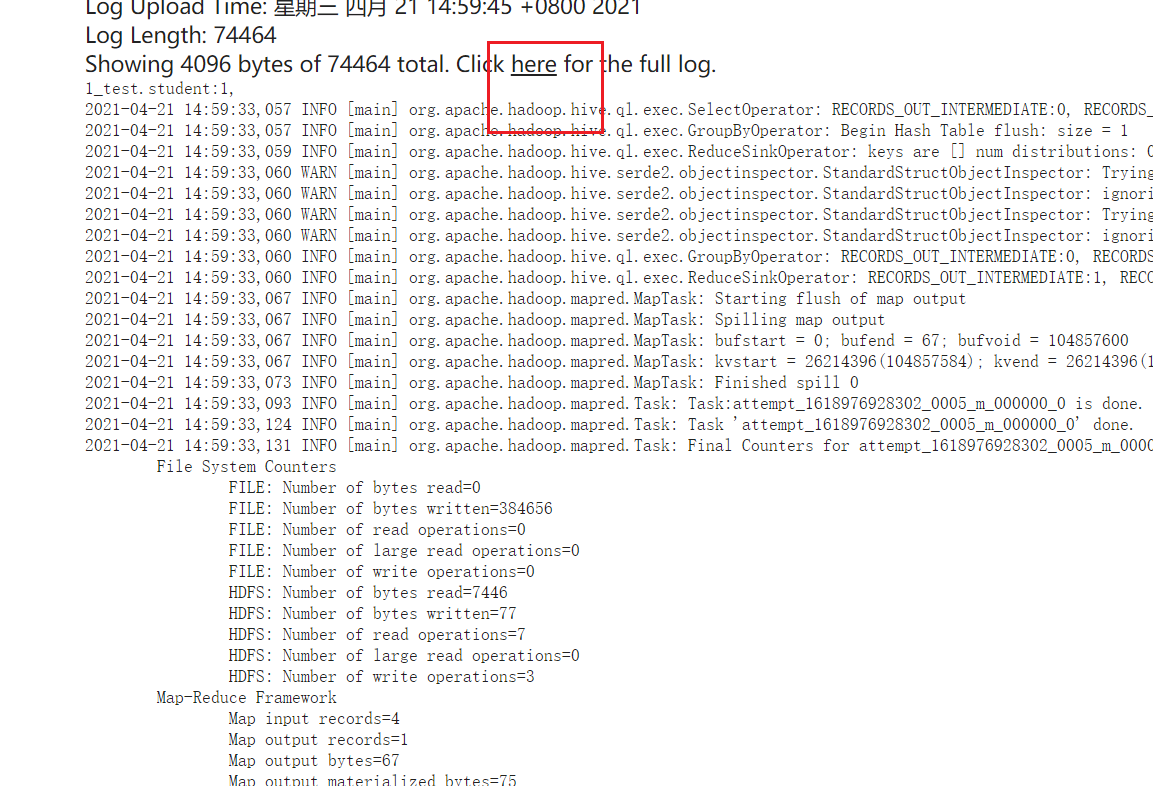

hadoop—yarn

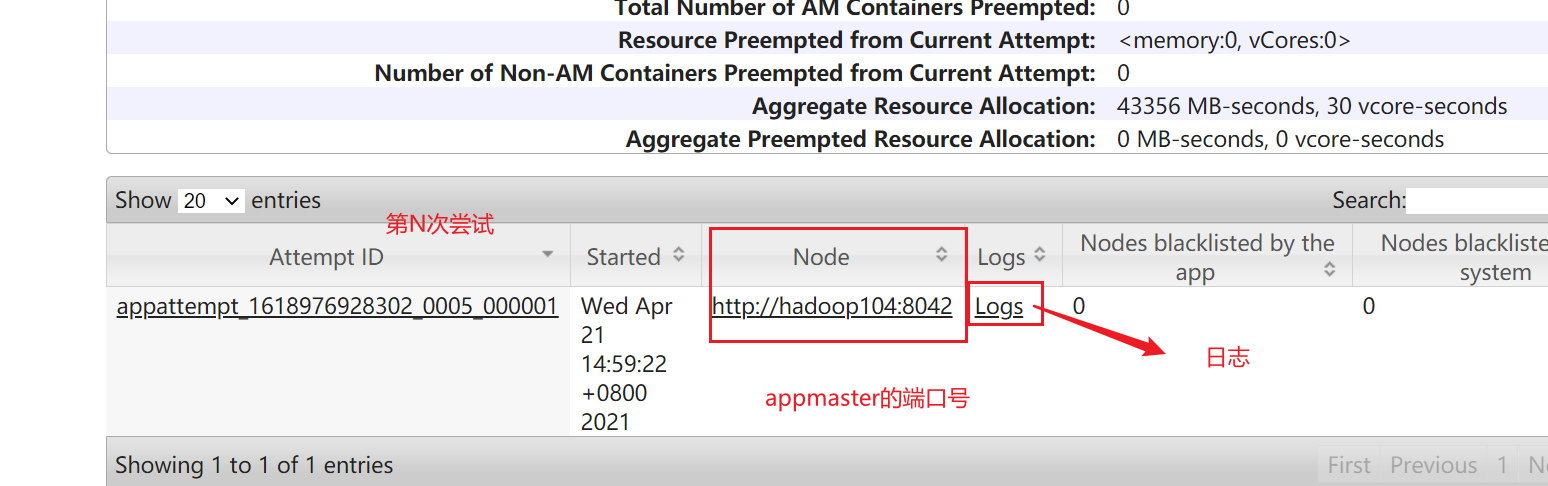

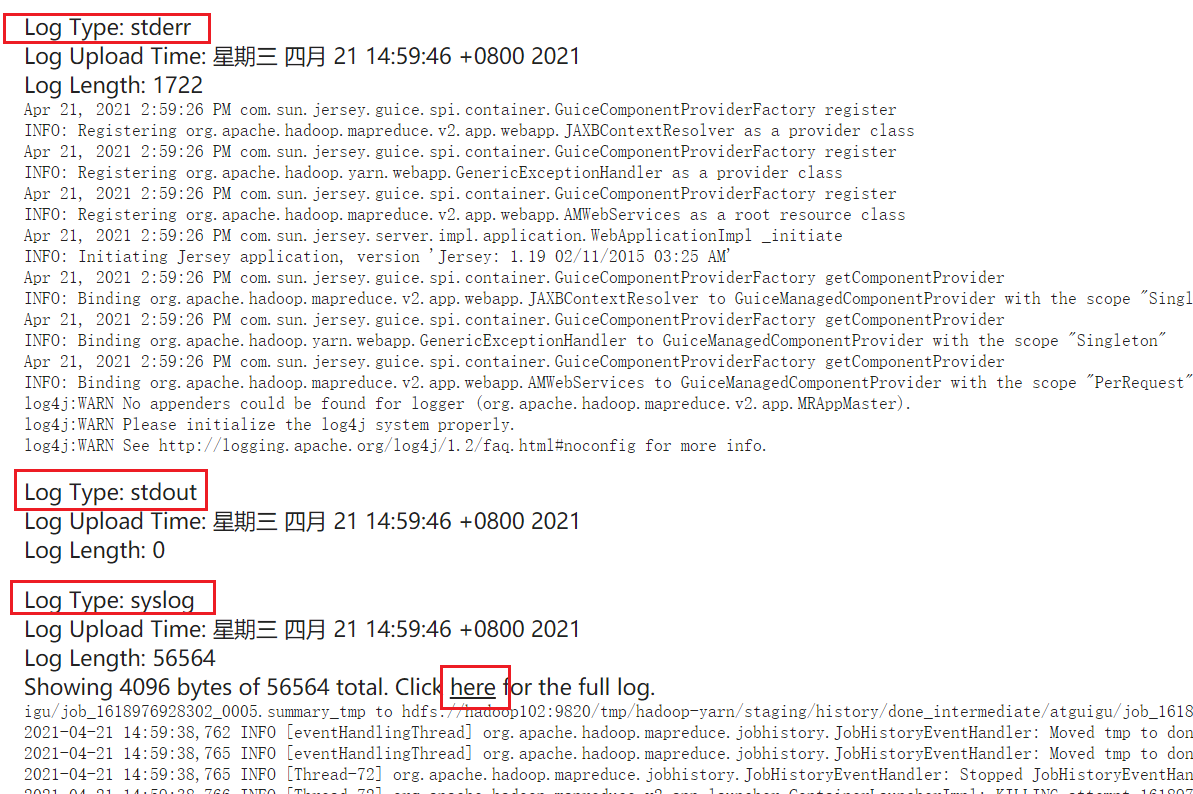

appmaster输出的logs

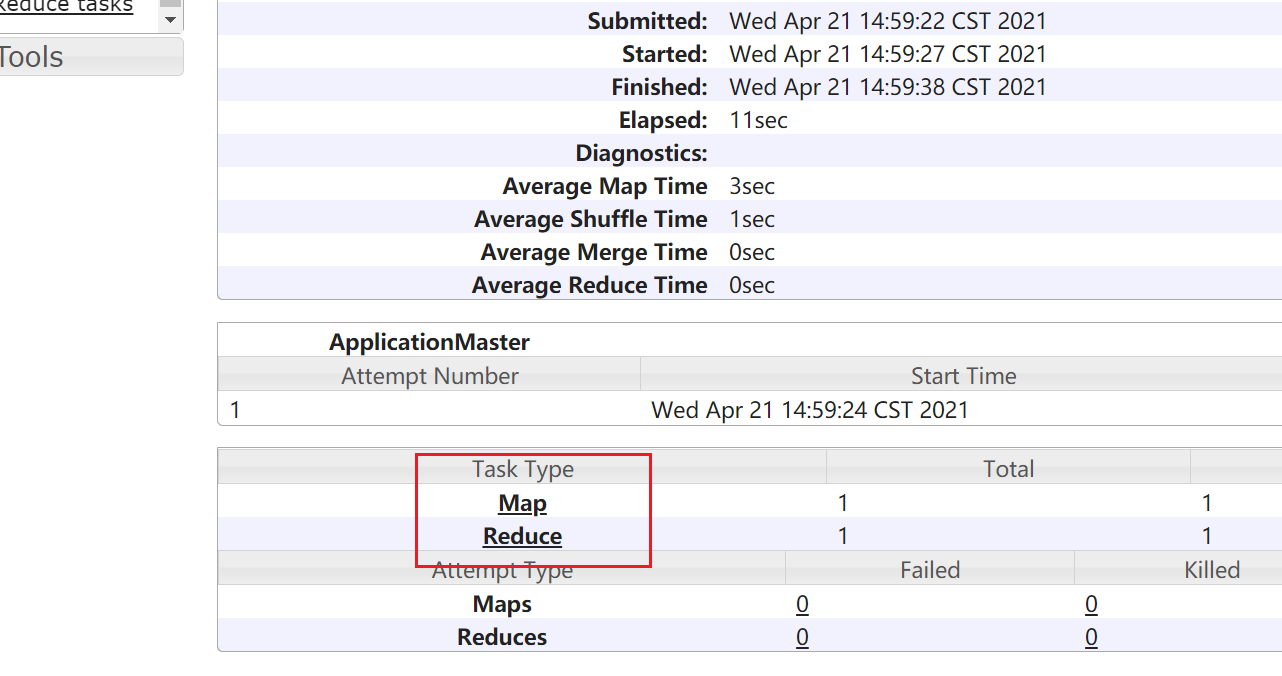

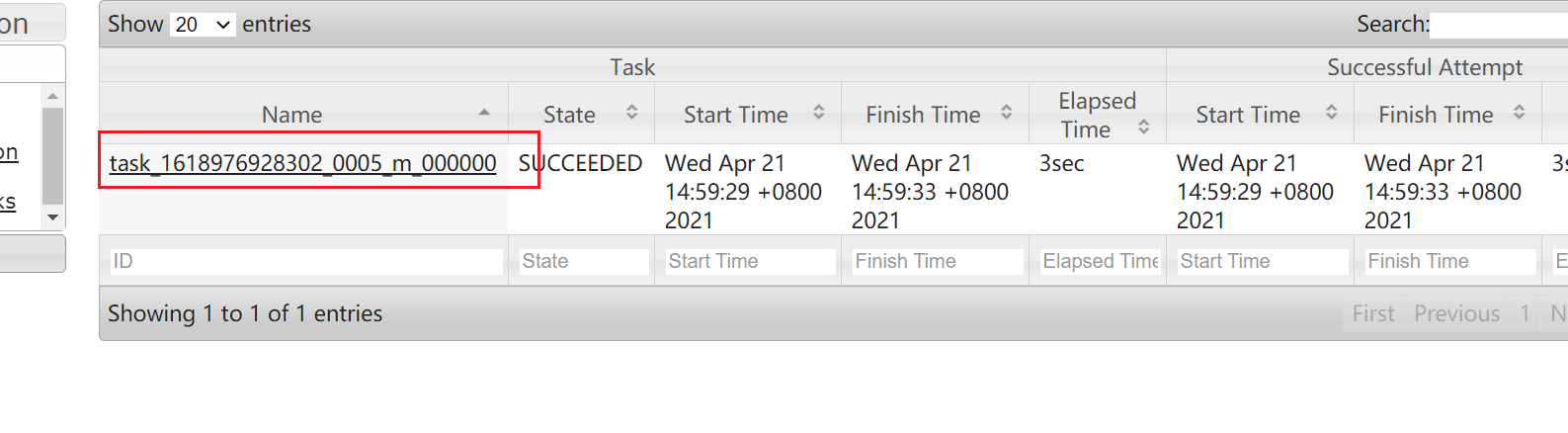

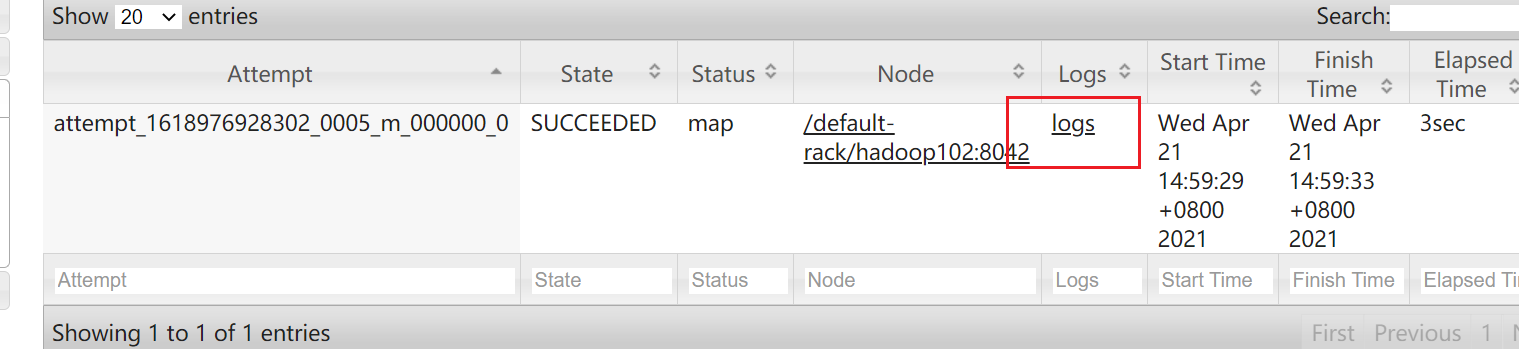

Map和Reduce日志

与历史服务器hadoop:19888展示的是一样的

需要:启动历史服务器

mapred --daemon start historyserver

点进去

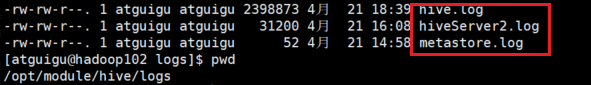

HIVE

logs存储位置:

默认路径是/tmp

设置好配置文件路径

mv hive-log4j.properties.template hive-log4j.properties设置:property.hive.log.dir=/opt/module/hive/logs

HDFS同一任务不同阶段:

注意hadoop找history的时候同一个任务有不同阶段,寻找日志时注意阶段数

常见错误

hadoop、hbase

异常原因:

在数据传输过程中,因强关电源,导致block块损坏,而不能启动安全模式

解决方案:

先离开安全模式

hdfs dfsadmin -safemode leave

检查根目录下的所有并删除坏块

hdfs fsck -delete /结果:The filesystem under path '/' is HEALTHY

hbase 断电后异常现象:

1、web端显示backup状态

2、logs日志文件显示不断重连

原因:断电导致hdfs出现坏块!!!

解决方法:

步骤:

1、hdfs离开安全模式

此时再看web端hbase发现dead region servers,并且系统表缺失

2、删除坏块即可

flink

yarn-node-健康英文

如果不健康

—>hdfs删除flink临时文件