这篇文章基本是对于https://mp.weixin.qq.com/s?__biz=MzI5MDUyMDIxNA==&mid=2247486778&idx=2&sn=23582d015eff1d0d5ba0c6f71ca86296&chksm=ec1fe0c3db6869d588af077e6041377193cee8c8eeb069f283bdf6b9a2613bb7dc6b4c7b365a&mpshare=1&scene=1&srcid=0318W4ZKu3BiCVeuKx6lLMrc#rd这篇文章的总结, 感谢人家精彩的分享.

加快模型训练

选用更大的batch size

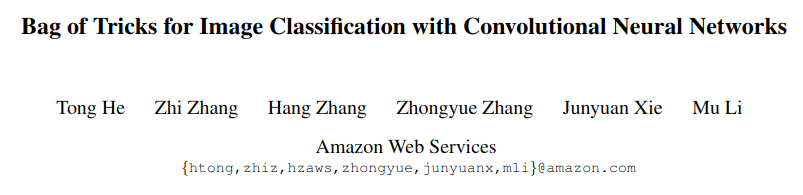

选用更大的batch size能够在整体上加快模型的训练,但是一般而言如果只增大batch size,效果不会太理想.这部分目前有比较多的研究论文,比如Facebook的这篇:Accurate, Large Minibatch SGD:Training ImageNet in 1 Hour. 作者也总结了主要的几个解决方案:

- 增大学习率, 因为更大的batch size意味着基于每个batch数据计算得到的梯度更加贴近整个数据集(数学上来讲就是方差更小),因此当更新方向更加准确后,迈的步子也可以更大了.

- 一般而言将batch size修改为原来的几倍,那么初始学习率也需要修改为原来的几倍。

- 用一个小的学习率先训几个epoch(warmup), 因为网络的参数是随机初始化的,假如一开始就采用较大的学习率容易出现数值不稳定,这是使用warmup的原因。等到训练过程基本稳定了就可以使用原先设定的初始学习率进行训练了。

- 作者在实现warmup的过程中采用线性增加的策略.

- 举例而言,假设warmup阶段的初始学习率是0,warmup阶段共需要训练m个batch的数据(实现中m个batch共5个epoch),假设训练阶段的初始学习率是L,那么在batch i的学习率就设置为i*L/m。

- 每个残差块的最后一个BN层的γ参数初始化为0,我们知道BN层的γ、β参数是用来对标准化后的输入做线性变换的,也就是γx^+β,一般γ参数都会初始化为1,作者认为初始化为0更有利于模型的训练。

- 不对bias参数执行weight decay操作,weight decay主要的作用就是通过对网络层的参数(包括weight和bias)做约束(L2正则化会使得网络层的参数更加平滑)达到减少模型过拟合的效果。

采用16位浮点型进行训练。

采用低精度(16位浮点型)训练是从数值层面来做加速。一般而言现在大部分的深度学习网络的输入、网络参数、网络输出都采用32位浮点型,现在随着GPU的迭代更新(比如V100支持16为浮点型的模型训练),如果能使用16位浮点型参数进行训练,就可以大大加快模型的训练速度,这是作者加速训练最主要的措施,不过目前来看应该只有V100才能支持这样的训练。

优化网络结构部分

文章主要用的是resnet, 所以关注了对于其结构的改造. 关于residual block的改进可以参考Figure2,主要有3点。

- ResNet-B,改进部分就是将stage中做downsample的residual block的downsample操作从第一个1x1卷积层换成第二个3x3卷积层.

- 如果downsample操作放在stride为2的1x1卷积层,那么就会丢失较多特征信息(默认是缩减为1/4),可以理解为有3/4的特征点都没有参与计算,而将downsample操作放在33卷积层则能够减少这种损失,因为即便stride设置为2,但是卷积核尺寸够大,因此可以覆盖特征图上几乎所有的位置。

- ResNet-C,改进部分就是将Figure1中input stem部分的7x7卷积层用3个3x3卷积层替换。

- 这部分借鉴了Inception v2的思想,主要的考虑是计算量,毕竟大尺寸卷积核带来的计算量要比小尺寸卷积核多不少,不过如果仔细计算会发现ResNet-C中3个3x3卷积层的计算量并不比原来的少,这也是Table5中ResNet-C的FLOPs反而增加的原因。

- ResNet-D,改进部分是将stage部分做downsample的residual block的支路从stride为2的1x1卷积层换成stride为1的卷积层,并在前面添加一个池化层用来downsample。

- 这部分参考文章的作者的个人理解是虽然池化层也会丢失信息,但至少是经过选择(比如这里是均值操作)后再丢失冗余信息,相比stride设置为2的1*1卷积层要好一些。

模型训练调优部分

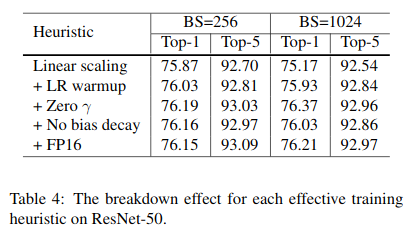

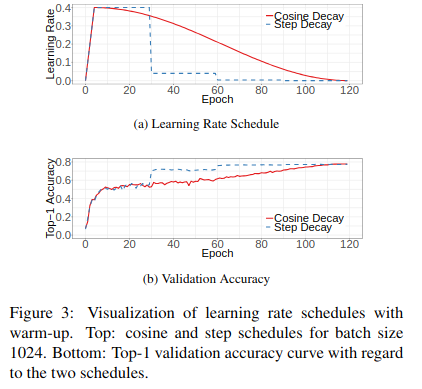

- 学习率衰减策略采用cosine函数,这部分的实验结果对比可以参考Figure3.

- 其中(a)是cosine decay和step decay的示意图,step decay是目前比较常用的学习率衰减方式,表示训练到指定epoch时才衰减学习率。

- (b)是2种学习率衰减策略在效果上的对比

- 采用label smoothing,这部分是将原来常用的one-hot类型标签做软化,这样在计算损失值时能够在一定程度上减少过拟合。

- 知识蒸馏(knowledge distillation),这部分其实是模型加速压缩领域的一个重要分支,表示用一个效果更好的teacher model训练student model,使得student model在模型结构不改变的情况下提升效果。

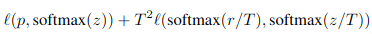

- 作者采用ResNet-152作为teacher model,用ResNet-50作为student model,代码上通过在ResNet网络后添加一个蒸馏损失函数实现,这个损失函数用来评价teacher model输出和student model输出的差异,因此整体的损失函数原损失函数和蒸馏损失函数的结合.

- 其中p表示真实标签,z表示student model的全连接层输出,r表示teacher model的全连接层输出,T是超参数,用来平滑softmax函数的输出。

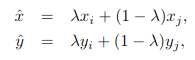

- 引入mixup,mixup其实也是一种数据增强方式,假如采用mixup训练方式,那么每次读取2张输入图像,假设用(xi,yi)和(xj,yj)表示,那么通过下面这两个式子就可以合成得到一张新的图像(x, y)(注意, 只使用这个新的样本, 不再使用合成用的样本),然后用这张新图像进行训练,需要注意的是采用这种方式训练模型时要训更多epoch。

- 式子中的λ是一个超参数,用来调节合成的比重,取值范围是[0,1], 服从分布Beta(alpha, alpha)

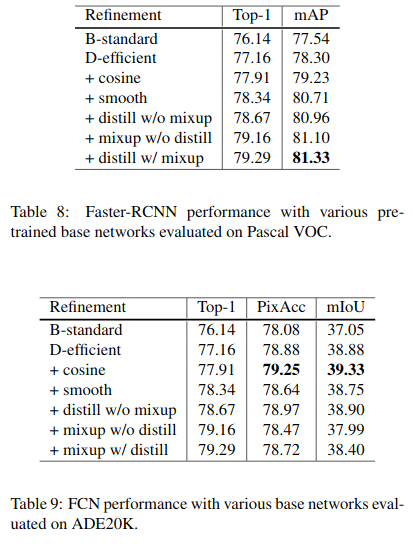

在目标检测与语义分割任务上的测试

参考链接

- mixup: https://blog.csdn.net/sumangshang/article/details/78675724

- https://mp.weixin.qq.com/s?__biz=MzI5MDUyMDIxNA==&mid=2247486778&idx=2&sn=23582d015eff1d0d5ba0c6f71ca86296&chksm=ec1fe0c3db6869d588af077e6041377193cee8c8eeb069f283bdf6b9a2613bb7dc6b4c7b365a&mpshare=1&scene=1&srcid=0318W4ZKu3BiCVeuKx6lLMrc#rd