一、爬虫基本架构

url管理模块

实现方式

通过url下载

from urllib.request import urlopentest_url = "https://wztlink1013.github.io"response = urlopen(test_url)print (response.getcode()) # 200 表示访问成功print (response.read())

通过Request访问

- 通过cookie访问

网页解析模块

从已经下载的网页中爬取数据,实现方式有:

- 正则表达式

- html.parser

- BeautifulSoup:结构化解析网页

- lxml

- 结构化解析

- DOM(Document Object Model),树形结构,就是html的基本骨架

二、BeautifulSoup解析网页

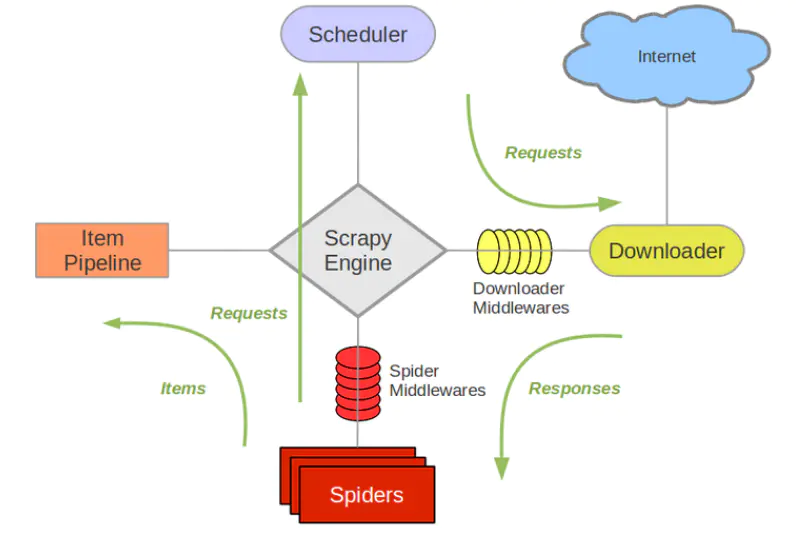

三、Scrapy

Scrapy基础

下载方法以及问题,在anaconda博客中

四、Scrapy使用

使用SOP

- 创建工程

- 键入

cmdcd到需要下载的目录下 - 输入

scrapy startproject tutorial(最后是项目名字) - !此后所有有关命令的操作,均在下一级文件夹下,也有是有cfg文件后缀的文件夹下

- 键入

- 定义Item,构造爬取的对象

- 编写spider,爬虫主体

scrapy genspider amazon_spider https://……

- pipelines,默认return item

- 编写其他配置,其中pipeline用于处理爬取后所得到的结果

- 执行爬虫

scrapy crawl amazon_spider

常用命令

参考

- 查看其官方文档

- 简书