本次实验中所有命令,不在任何docker容器当中。

准备

Anaconda的安装和配置

安装

wget https://repo.anaconda.com/archive/Anaconda3-5.3.0-Linux-x86_64.sh

sudo bash Anaconda3-5.3.0-Linux-x86_64.sh

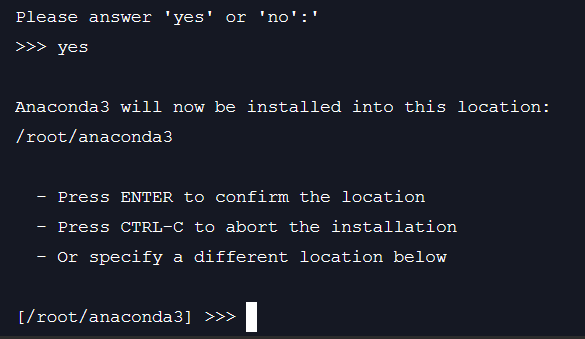

上面命令输入完之后不停回车,直到下面这种情况出现,输入

yes

安装完之后,有两个选项

第一个是让你把Anaconda添加到root环境变量中,输入yes

第二个是是否安装vscode,yes和no都可以

- 添加并激活环境变量

在文件末尾添加如下配置sudo vim /etc/profile

激活变量:export PATH=/usr/loacl/anaconda3:$PATH

source /etc/profilesource ~/.bashrc

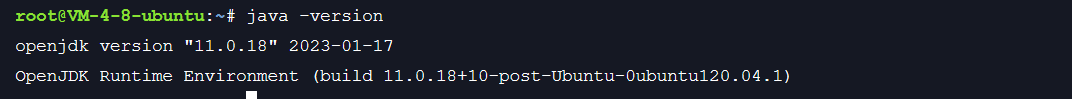

安装JDK

查看jdk版本sudo apt-get updatesudo apt-get install default-jresudo apt-get install default-jdk

java -version

实现

获取Spark安装包

wget https://mirrors.tuna.tsinghua.edu.cn/apache/spark/spark-3.2.3/spark-3.2.3-bin-hadoop3.2.tgz

复制安装包

sudo cp -r spark-3.2.3-bin-hadoop3.2.tgz /usr/local/spark

解压安装包

cd /usr/local/sparksudo tar -zxvf spark-3.2.3-bin-hadoop3.2.tgz

修改配置

vim ~/.bash_profile

修改配置如下

export SPARK_HOME=/usr/local/spark/spark-3.2.3-bin-hadoop3.2export PATH=$PATH:$SPARK_HOME/bin

激活配置文件:

source ~/.bash_profile

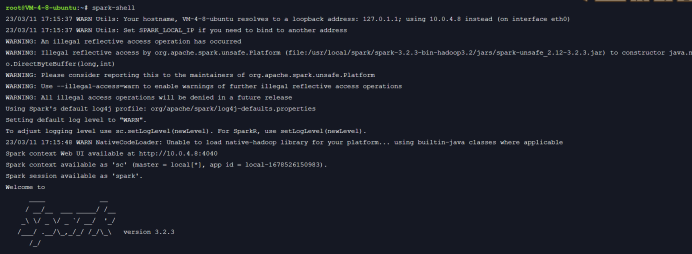

验证是否安装成功

spark-shell

修改配置

输入以下命令退出spark

:quit

接下来修改配置

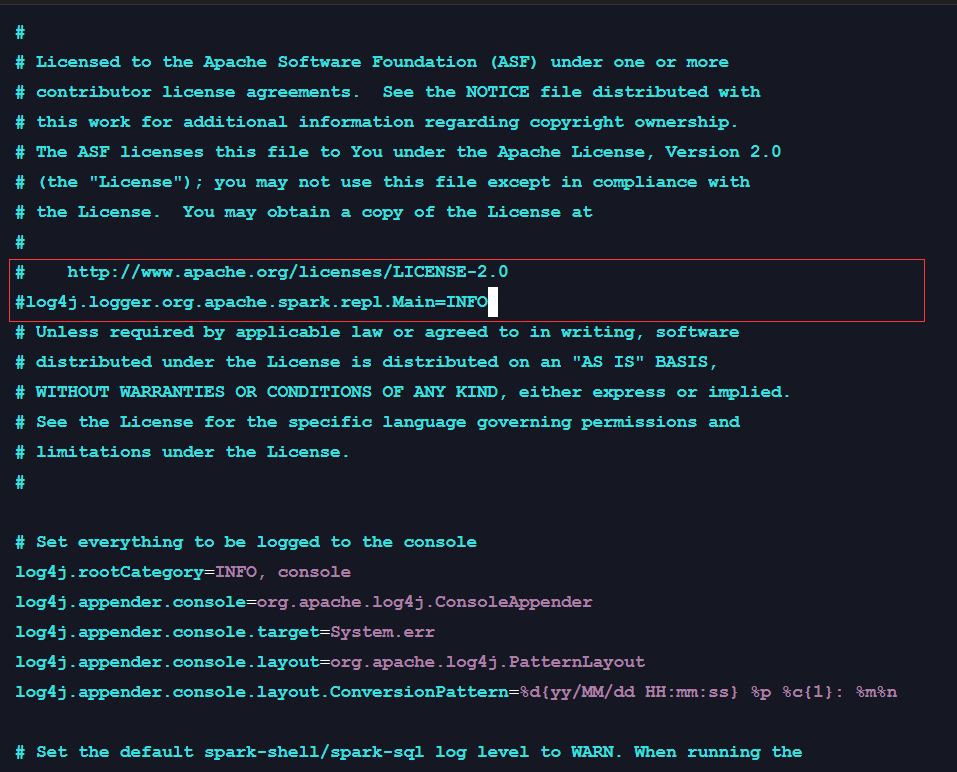

cd /usr/local/spark/spark-3.2.3-bin-hadoop3.2/confsudo cp log4j.properties.template log4j.propertiessudo vim log4j.properties

修改内容如下:

# http://www.apache.org/licenses/LICENSE-2.0#log4j.logger.org.apache.spark.repl.Main=INFO

- 安装PySpark

pip install pysparkpip install findspark