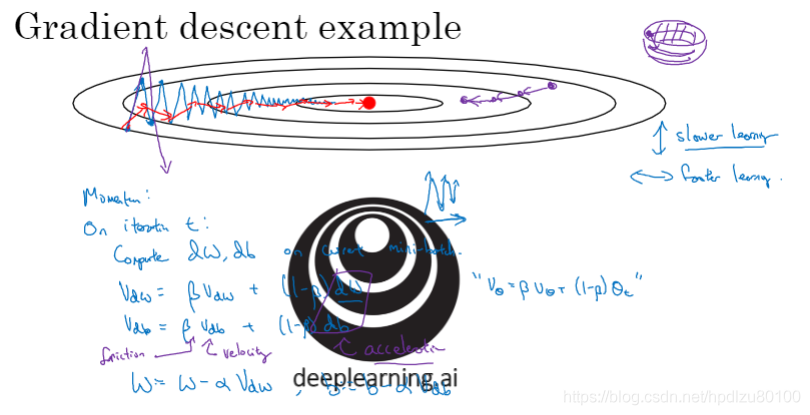

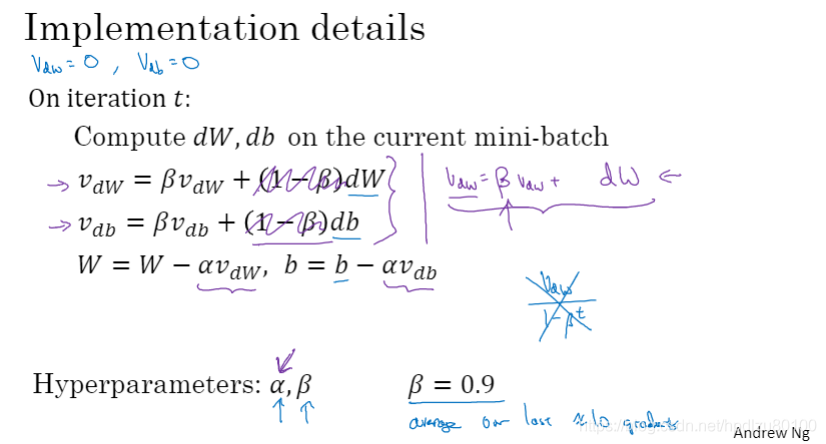

1.6 动量梯度下降法

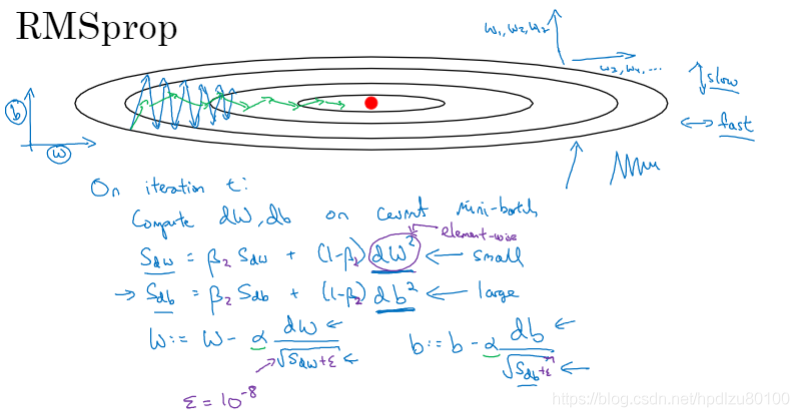

1.7 RMSprop

RMSprop(Root Mean Square Prop)算法

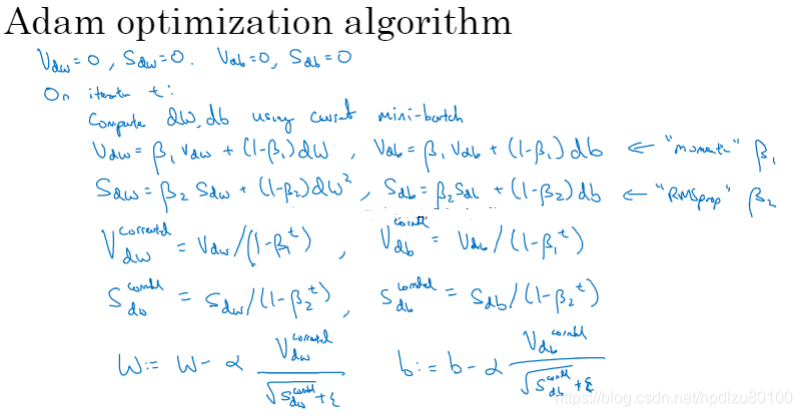

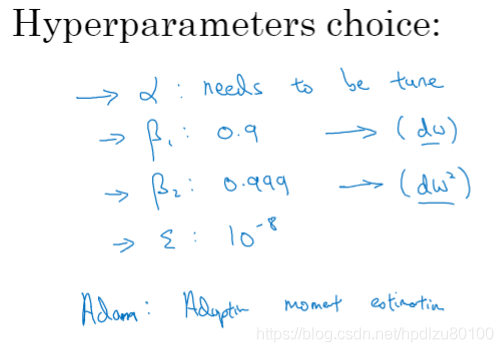

1.8 Adam 优化算法

Adam(Adaptive Moment Estimation)优化算法

Adam优化算法超参数的选择

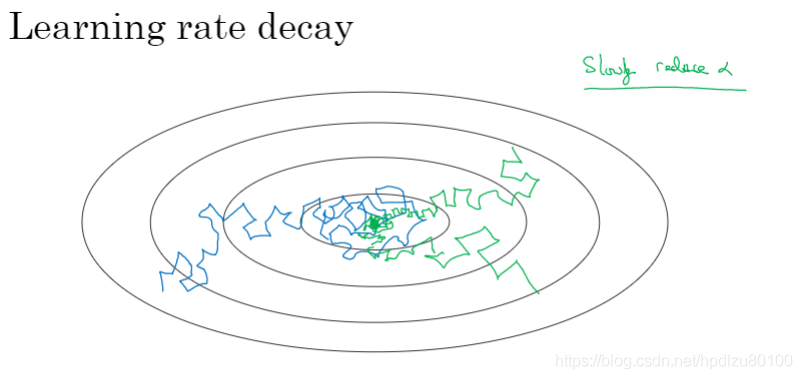

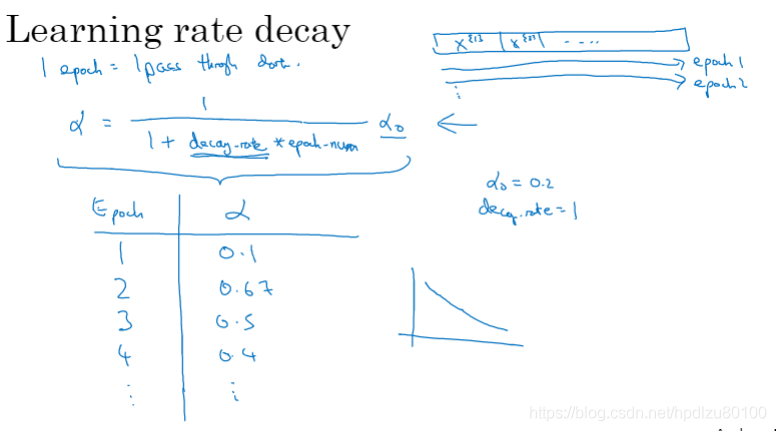

1.9 学习率衰减

梯度下降过程中,接近最优解时,应降低学习率,以减轻梯度下降曲线“漂移不定“的程度

学习率衰减公式

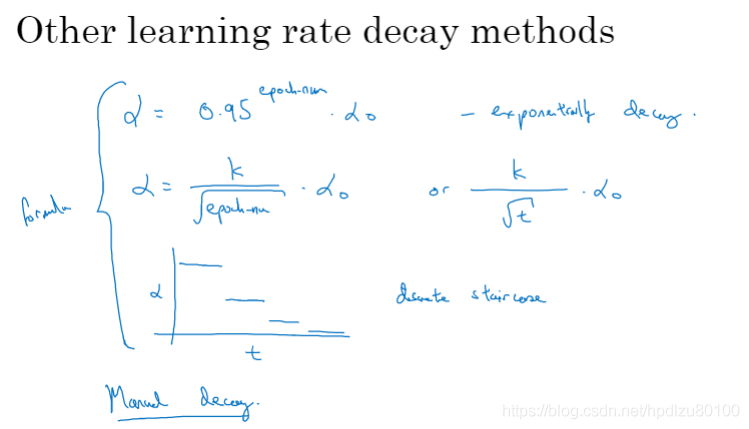

其他学习率衰减方法(如,指数衰减、均方根衰减、离散衰减、手动衰减等)

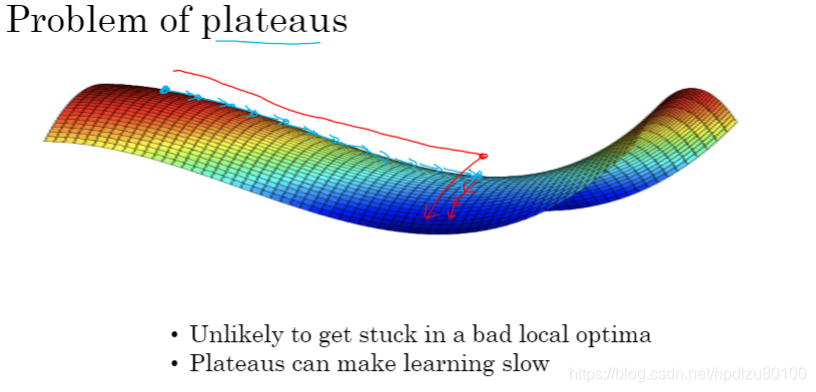

1.10 局部最优的问题

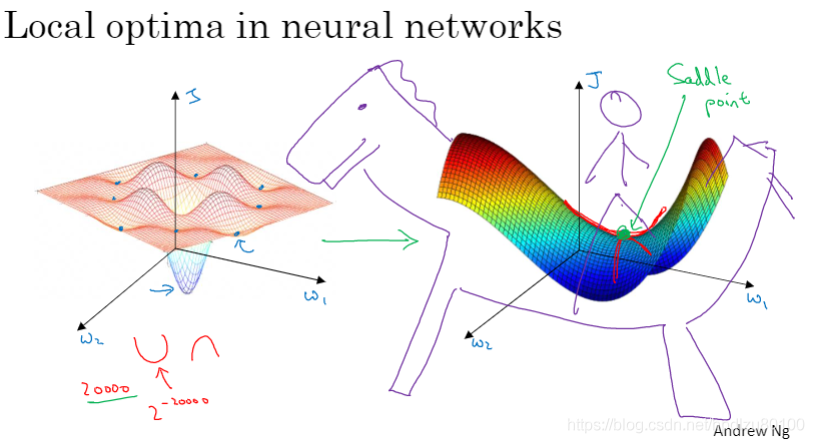

神经网络中的局部最优问题

“梯度高原(平稳段)”问题

“梯度高原“是指梯度下降过程可能会进入到梯度下降非常缓慢的平稳段(plateau),使得训练速度非常缓慢