1.1 训练 / 开发 / 测试集

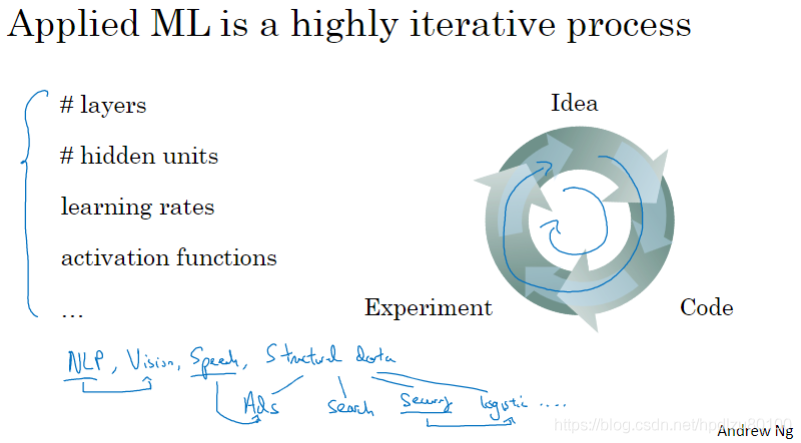

机器学习的应用是个高度迭代的过程

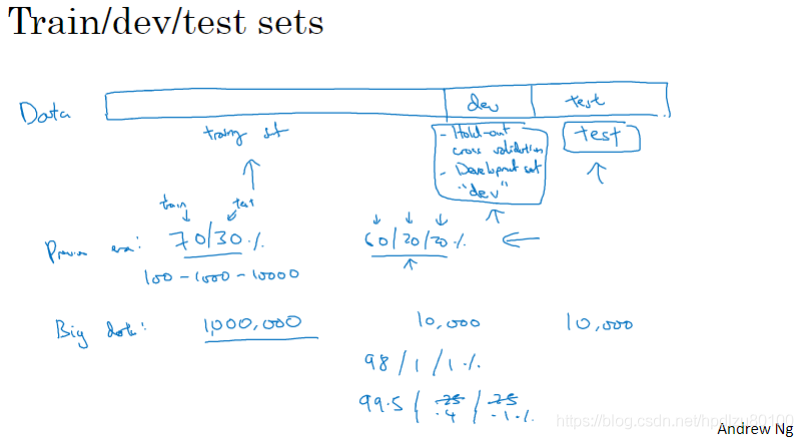

数据集的划分:训练集、开发集及测试集

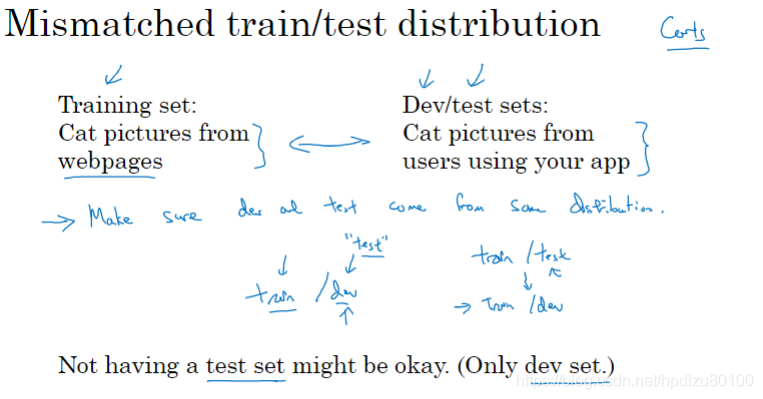

训练集和测试集的分布应该相同(匹配)

例如:在“识猫”应用中,若训练时使用高清图片,而开发、测试时使用低清晰度、较模糊的图片,则模型的可靠性值得怀疑

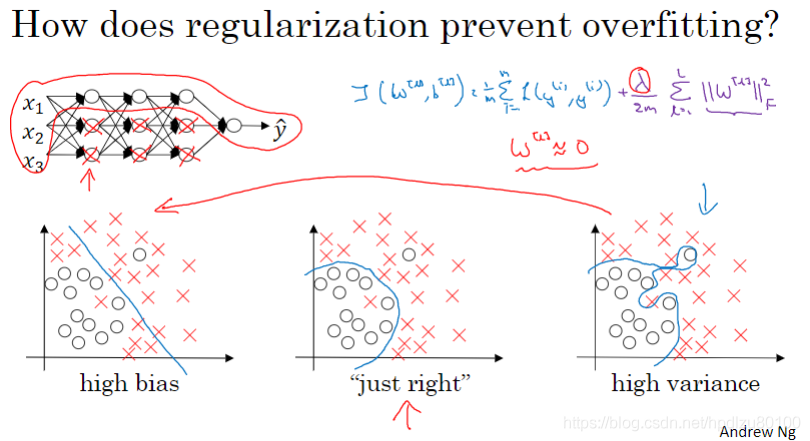

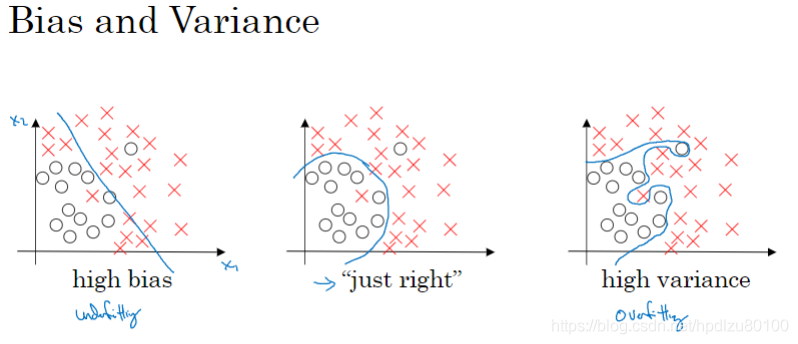

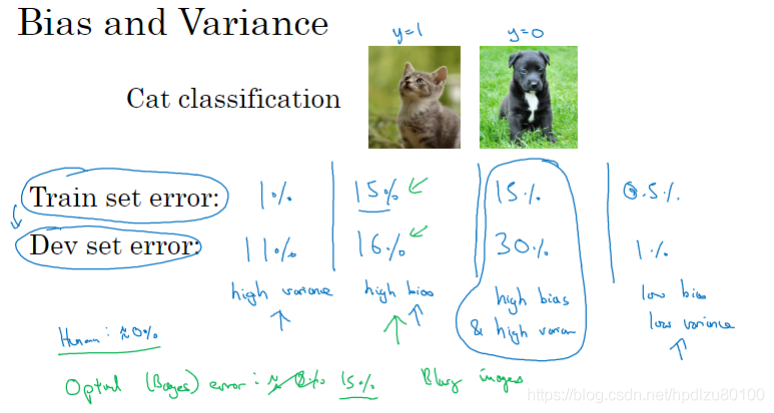

1.2 偏差 / 方差

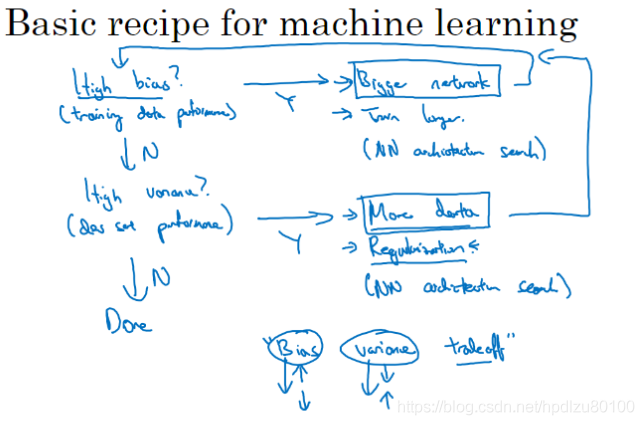

1.3 机器学习基本流程

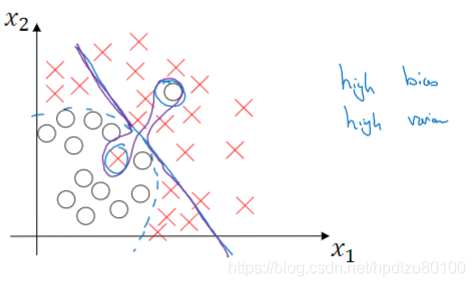

注:高偏差(high bias):训练集错误率高,相当于欠拟合(underfitting)

高方差(high various):训练集错误率低,但验证集(开发集)错误率高,相当于过拟合(overfitting)

在深度学习中,如果模型中使用更大规模的网络,有利于消除高偏差,但并不用担心会引起高方差的问题。又比如,如果使用更多的数据,有利于消除高方差,但并不用担心会引起高偏差的问题。可以说,在深度学习中,高偏差和高方差的对立相比早期机器学习时期有所缓解,不再需要强调偏差——方差的权衡(bias - various tradeoff)。

1.4 正则化

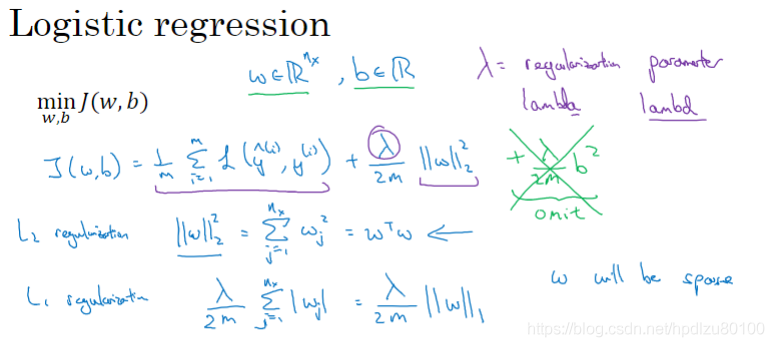

Logistic回归的正则化

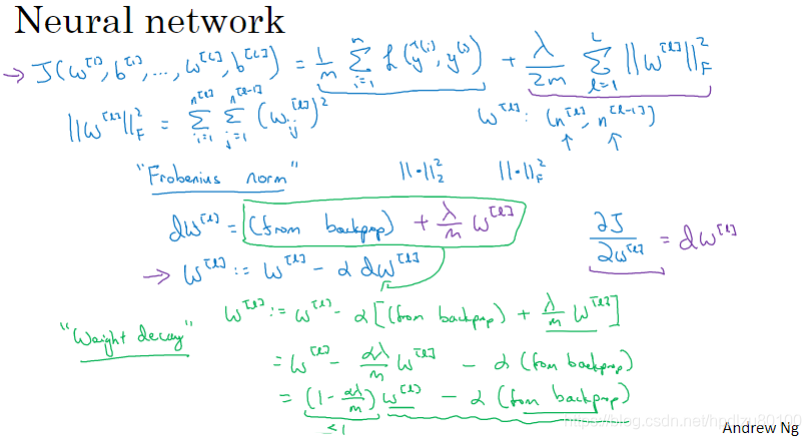

神经网络的正则化

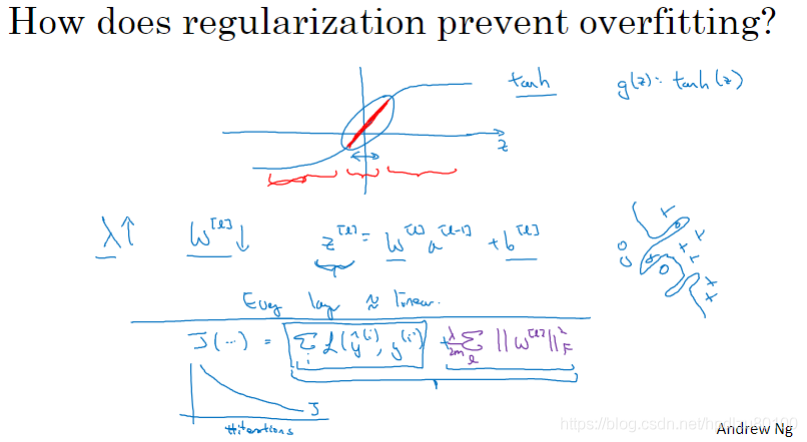

1.5 为什么正则化可以降低过拟合?

两个直观说明:

- 假设正则化系数λ很大,则成本函数J中的权重系数可忽略不计,即趋近于零,相当于消除了网络中部分神经元,从而有利于降低过拟合。

- 若激活函数为tanh,正则化系数λ增加后,权重系数倾向于减少,相当于将线性运算结果z的范围控制在tanh函数中心位置区域。而这块区域是比较“线性”的,从而可以减轻模型过拟合的程度。