1.1 为什么要进行实例探究?

1.2 经典网络

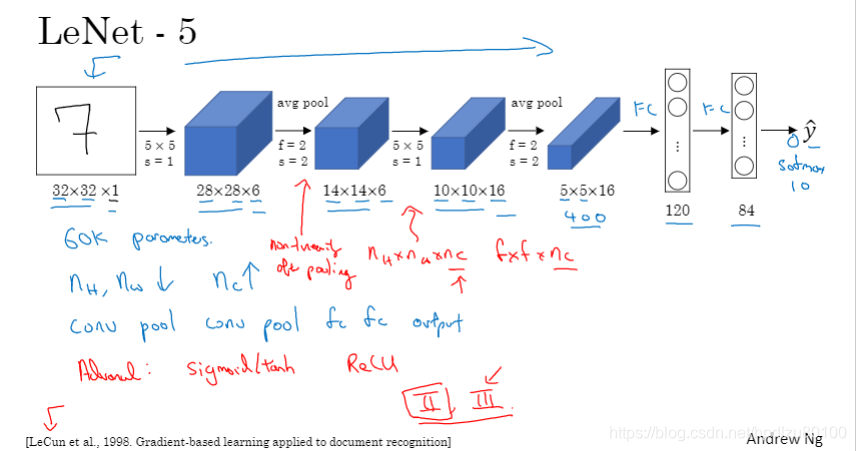

LeNet-5(论文较难懂)

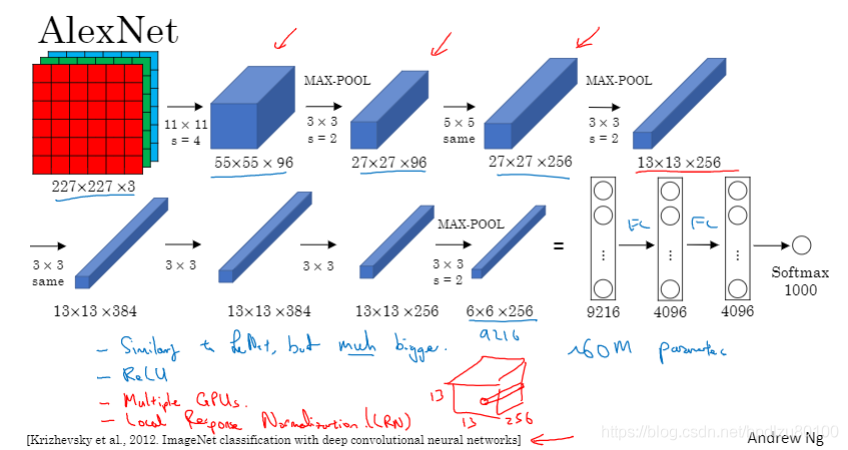

AlexNet(论文容易读,建议先读此篇论文)

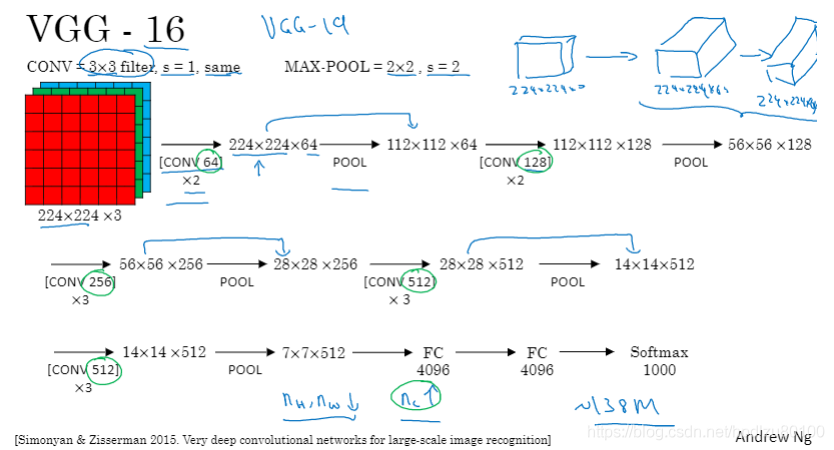

VGG-16(设计比较优雅,卷积层长、宽减半递减的同时,通道数在倍增)

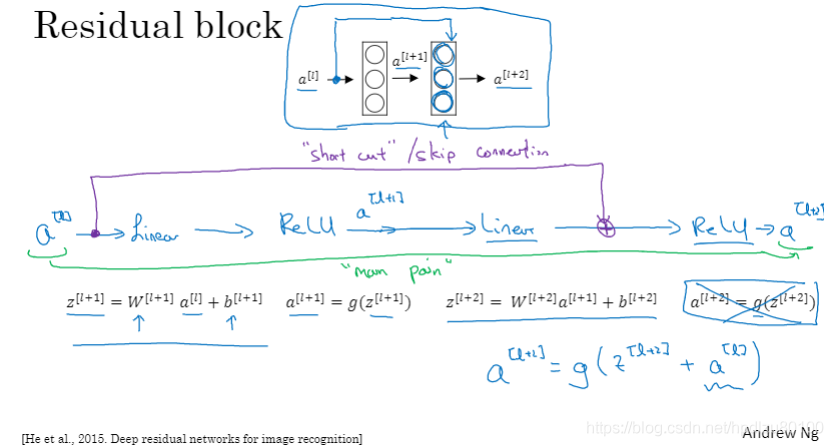

1.3 残差网络(ResNet)

残差网络是在普通网络(Linear+ReLU)基础上,引入了“跳接”(shortcut, skip connection),产生了残留块(如,a[l+2]=g(z[l+2]),故称“残差”网络。

理论上,训练误差应该随着网络深度的增加而一直下降(甚至出现过拟合而下降到零),但实际上,在普通网络(plain network)中,网络层数增加到一定数量后,训练误差会不降反增。残差网络可以减轻深度网络中的梯度消失和梯度爆炸问题,从而减轻上述问题。

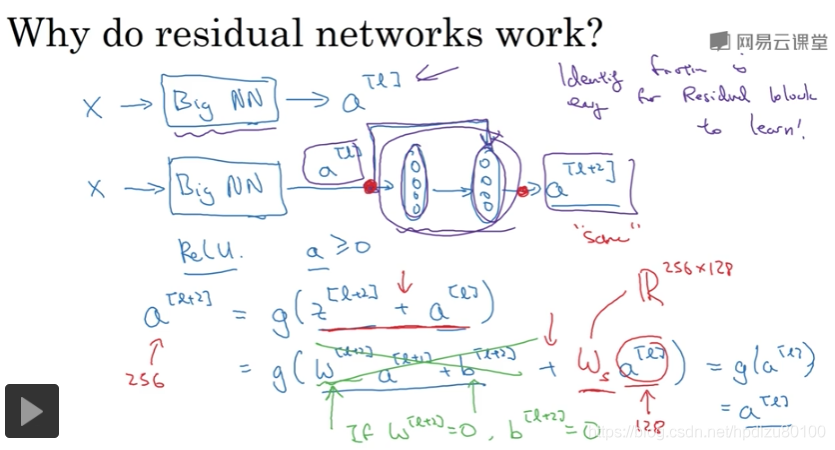

1.4 残差网络为什么有用?

残差网络更容易学习到恒等函数(identify function),即a[l+2]等于a[l],相当于直接将a[l]复制到a[l+2],这样,不容易给模型造成性能损失。

ResNet示例图