1.6 Batch Norm 为什么奏效?

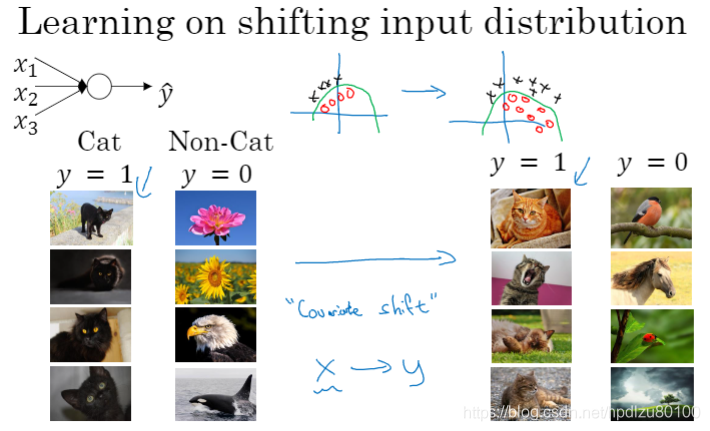

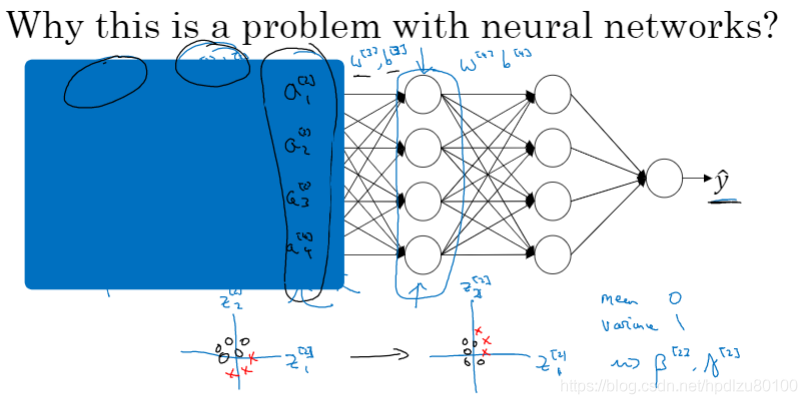

样本变动(covariate shift)会使得模型的确定变得困难

在不同的mini-batch中,激活函数a可能会变化较大,batch norm可使其更加“归一”

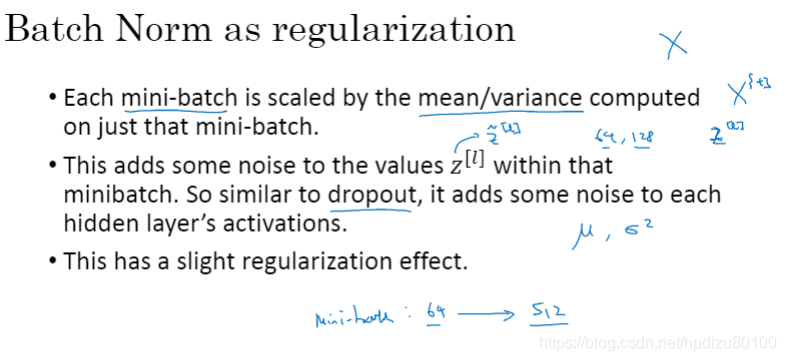

Batch Norm具有轻微的“正则化”效应,但这不是其目的,其目的在于加快训练速度

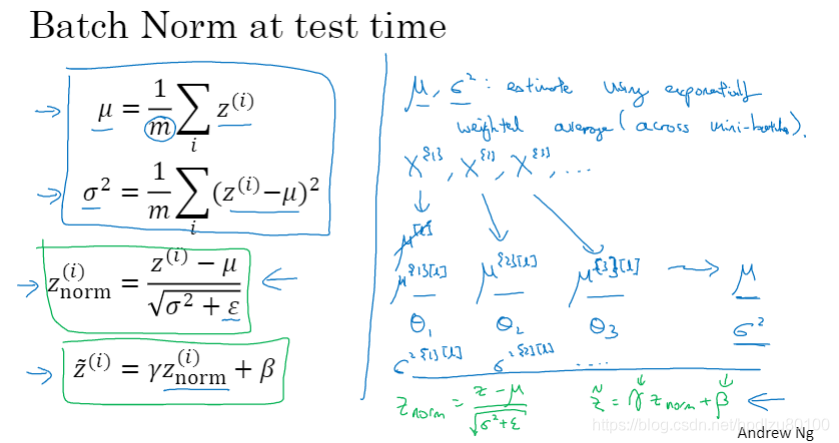

1.7 测试时如何使用Batch Norm?

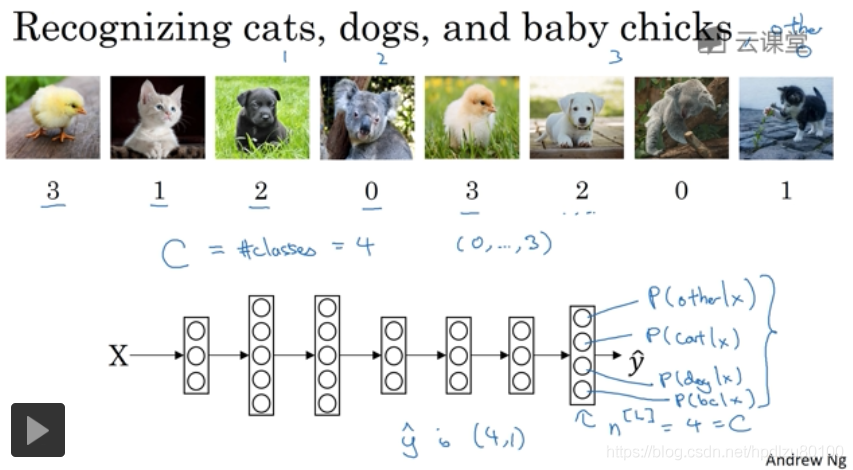

1.8 Softmax 回归

Softmax可用于多分类,是二分类logistic回归的一般形式

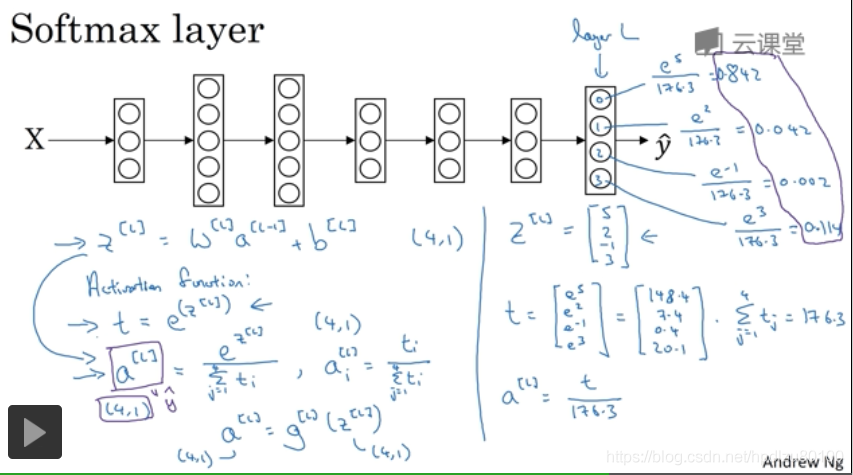

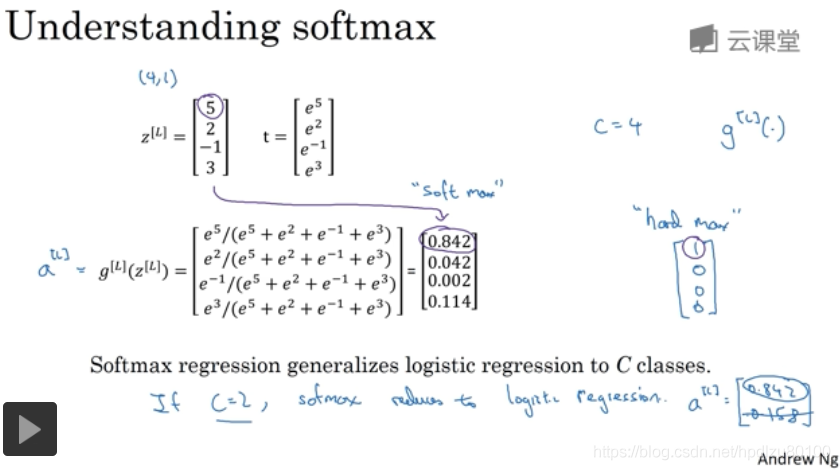

Softmax层的计算

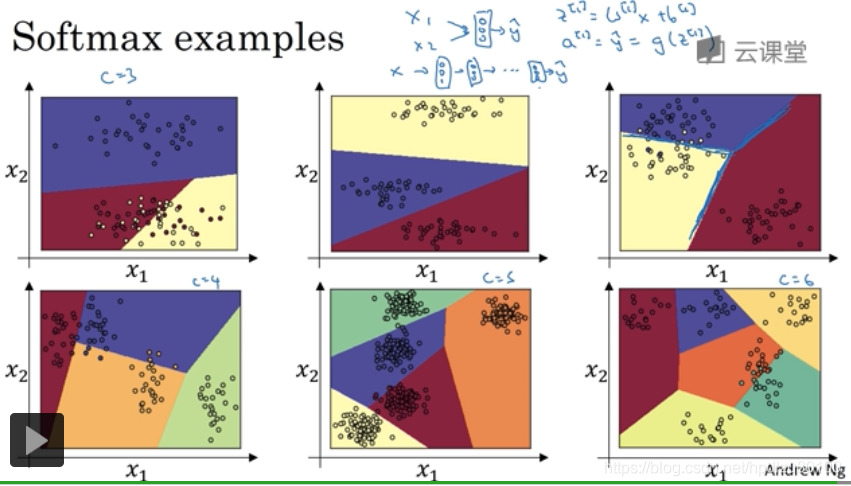

Softmax示例

1.9 训练一个 Softmax 分类器

理解Softmax回归

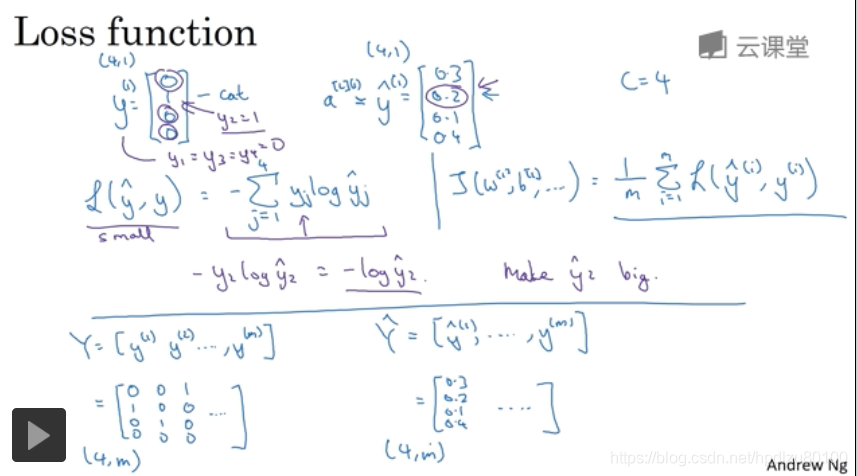

Softmax回归的损失函数

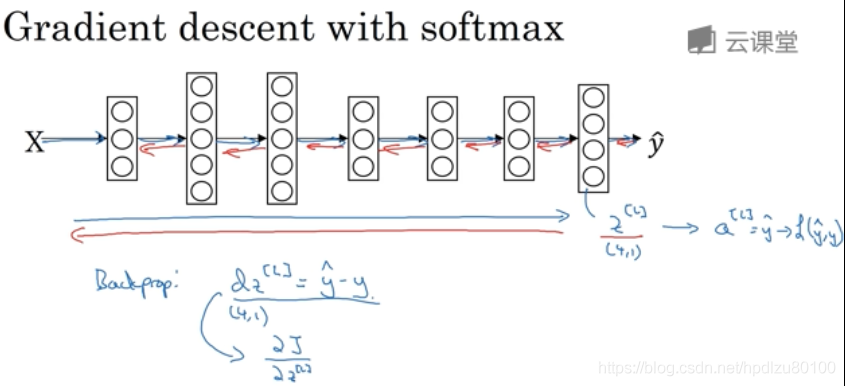

Softmax的梯度下降

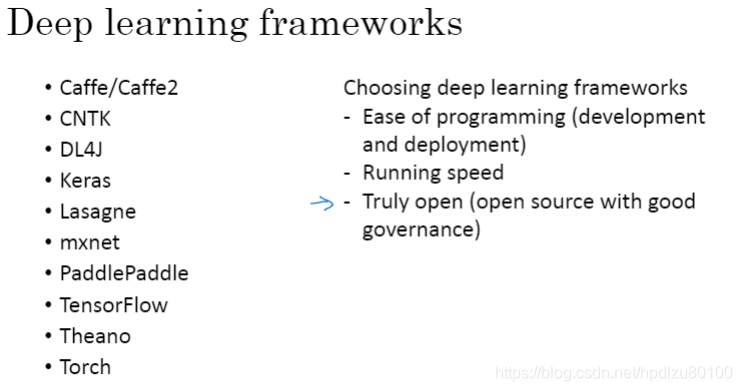

1.10 深度学习框架

1.11 TensorFlow

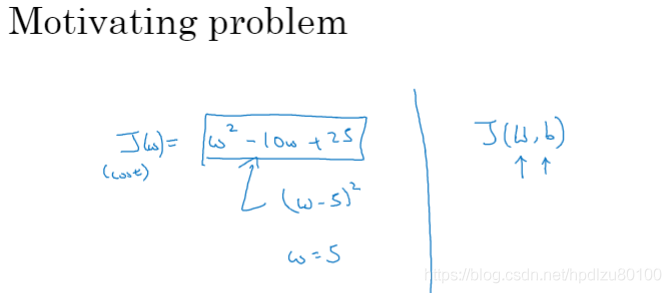

问题引入

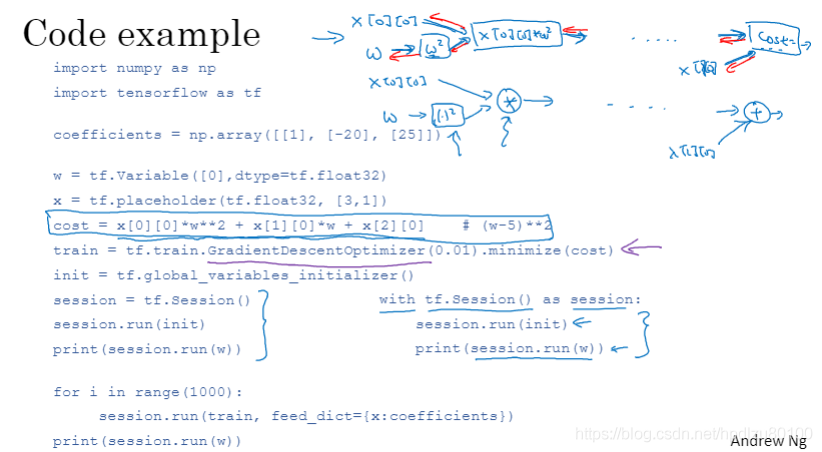

Tensorflow代码示例