Yang 等。 - 2019 - LRW-1000: A Naturally-Distributed Large-Scale Benchmark for Lip Reading in the Wild

研究问题

制作了词语级唇读数据集,包含1,000个分类,718,018个样本,来自2,000多名演讲者,包含超过100万个汉字实例,涵盖286个汉字音节。每一类对应一个由一个或几个汉字组成的普通话单词的音节。

研究背景

经典唇读数据集LRW,以及word-level的OuluVS/OuluVS2。没有汉语唇读数据集。

文中汉语写作 Mandarin,表示简体中文/官话。

研究方法

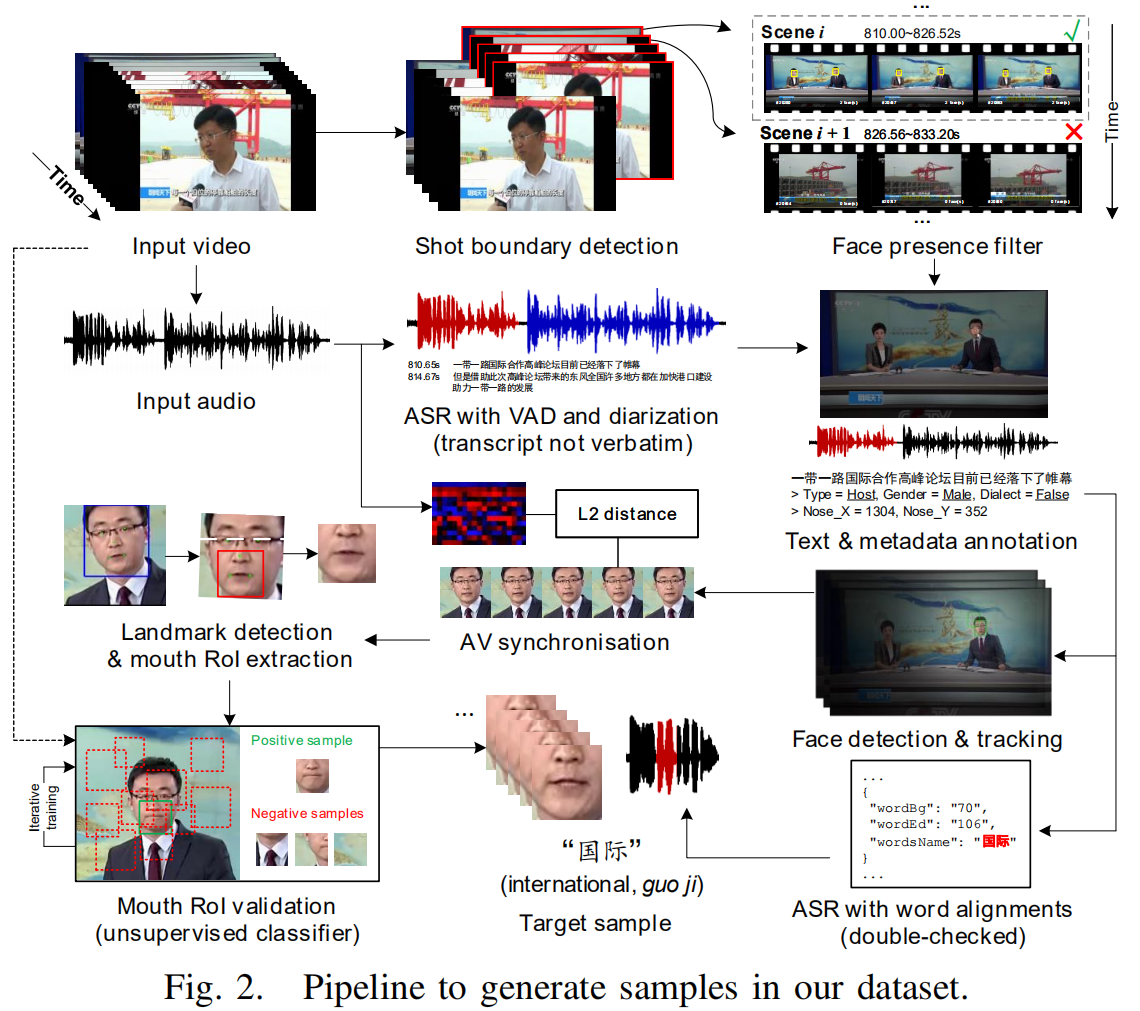

构建数据集,主要是选择电视节目,然后数据处理程序将自动处理与手动注释和额外的过滤努力交织在一起,使数据在研究中保持一致。

研究思路

- 建立一个词语级的中文唇读数据集。

- 数据集 in the wild,光照、分辨率、姿态、语速、年龄、性别、妆造等变化都有。

以此为基准验证了几个流行的唇读方法在不同情境下的表现,分析不同因素对唇读的影响,包括图像尺度、单词长度、演讲者的姿态和模型在自然分布数据上的能力。

主要内容

1. 获取视频

The final program list is composed by 26 broadcast sources with 51 programs and yields more than 500 hours of raw videos over the two-month data collection period. 总共840个视频、508小时。

The broadcast collection described above is retrieved daily through an IPTV streaming service in China, hosted by Northeastern University.

2. 视频处理

shot 边界检测,方法是比较相邻帧的颜色直方图。在每个检测到的镜头中,我们选择三个均匀间隔的帧,并使用 SeetaFaceEngine2 工具包中的多视图人脸检测器执行人脸检测,如果照片中没有一张脸大于20 × 20像素,我们就会认为这张照片中没有任何潜在的发言人。

- 语音识别,按句子分离,在句子水平上时间对齐。手动为每个视频剪辑添加演讲者的位置、性别、演讲的确切端点以及演讲内容。再用讯飞语音识别与手动添加的文稿进行核对。重复几轮手动和自动交叉检查。

- 讲话人识别,为了将每个话语与对应说话人的面部相关联,我们在第一帧使用 SeetaFaceEngine2 中的地标检测器,并通过将每个检测到的面部坐标与人工注释进行比较来进行检查。然后,在给定的时间段内,利用核相关滤波(KCF)跟踪器对选定的人脸进行跟踪,获得整个说话序列。在跟踪过程中,我们每15帧使用SeetaFaceEngine2中基于cnn的人脸检测器对跟踪质量进行自动验证。不行啊,还是手动标注的。

- 音视频同步,也是用的SyncNet,offset小于7帧就算是同步的。

- 检测面部地标(还是用的 SeetaFaceEngine2),旋转人脸使其眼睛位于水平线,然后框出嘴唇区域。

- 验证提取的嘴唇区域,训练了一个CNN过滤掉 俯仰角度较大导致人脸地标预测失败的视频。

3. 实验

对目前流行的唇读方法的评价结果,并给出详细的分析,以说明提出的基准的特点和挑战。

略。研究结论

在本文中,我们提出了一个用于野外唇读的大规模自然分布词水平基准,命名为LRW-1000。

用此数据集评估了有代表性的唇读方法,以比较不同因素对唇读的影响。

通过这个新的数据集,我们希望向社区呈现唇读任务规模、姿势和单词持续时间变化的一些挑战。创新点

创建唯一的大规模中文数据集,词语级。