迁移学习

以EfficientNet为主干网络,用comprecars训练,而后用KITTI测试

- 不同距离(不同方法) 绝对误差和相对误差,图和表,设置和人家不同距离范围和分组的统计数据()

- 不同角度(对比福大) 两种误差

- 遮挡度(对比福大)

- 截断程度 (kitti图10示例,截断程度0.8;)

可视化

数据集:10示例,截断程度0.8;424侧面车身

评价标准:测距速率和准确率和鲁棒性

通过修剪网络提高速度

距离几何模型:车身高度、

宽度(18微软):20-36m(通过类别确定真实宽度,kitti数据集测试结果,静态图片);、

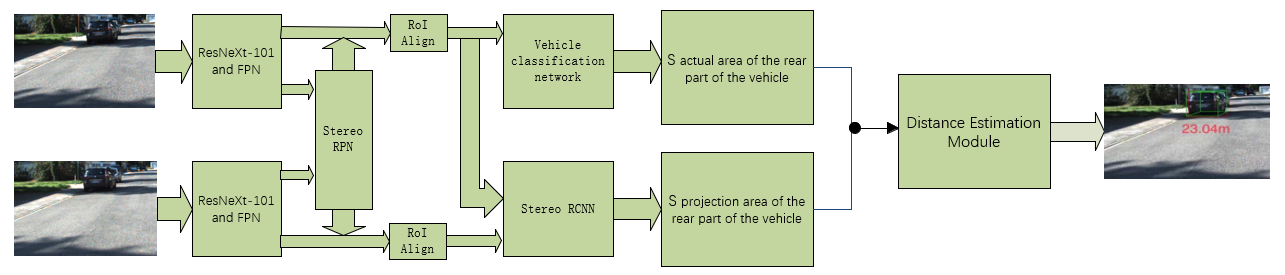

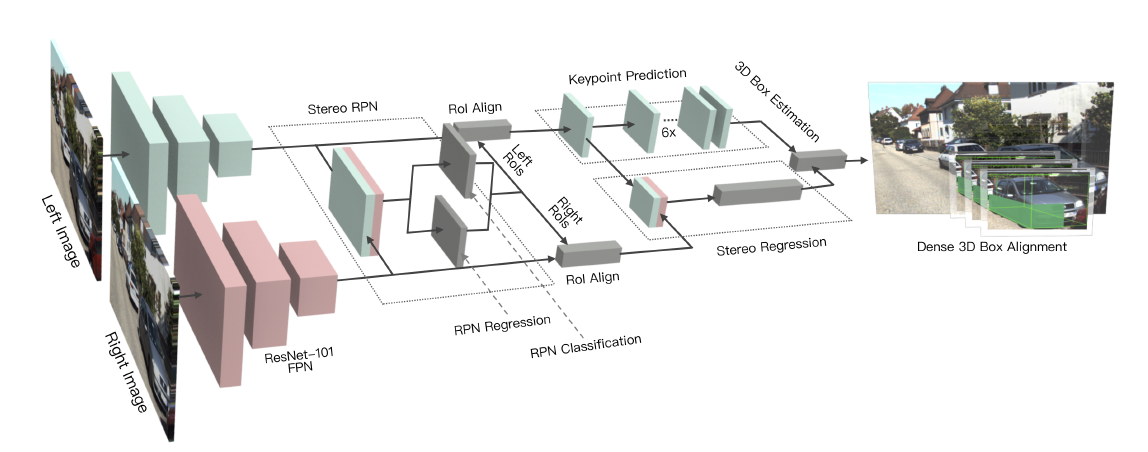

面积之比(19福大acess):通过训练cnn获取车辆角度和实际尺寸,但是压根没说怎么做的

(18福大4区):分类模型的检测和评估(通过类型确定车辆实际尺寸);验证对比

(20福大trans):距离(对比不同方法)、遮挡度、视角(无对比只看自己结果);3D检测模块的优势;面积距离模型的优势;可视化

尤其是车牌实际尺寸都有国标确定(同济19文章结尾有说)

高度(16北科大):将gps距离作为GT,测了5-30米的数据

面积之比(16长大):5-50米的数据,相对误差,包括静态和动态

车牌宽度(19同济):0-120米,相对误差

(看能否尝试,在雨雾黑夜天气,使用:基于可见光通信的低分辨率摄像机的车距估计方法)

激光雷达的问题,通过反射获取目标信息,对于白色车子效果明显,对于黑色车子则不好

测试子集:不同的距离范围,截断度、遮挡度和视角。

数据标签:

Pedestrian 0.00 0 -0.20 712.40 143.00 810.73 307.92 1.89 0.48 1.20 1.84 1.47 8.41(距离) 0.01

物体类别 截断程度 遮挡程度 观察角度 二维边界框xmin,ymin,xmax, ymax 高 宽 长 3维物体位置 空间方向

统一以车辆Z坐标为车距(严谨来说,只有车辆在正前方车距才为Z)

已证明在车辆某一面与本车前进方向垂直的情况下,如果Zc相等,在不同观察角度和不同rotation_y角度下投影长度相同

系统模型