Li 等。 - 2019 - GS3D An Efficient 3D Object Detection Framework f.pdf

摘要

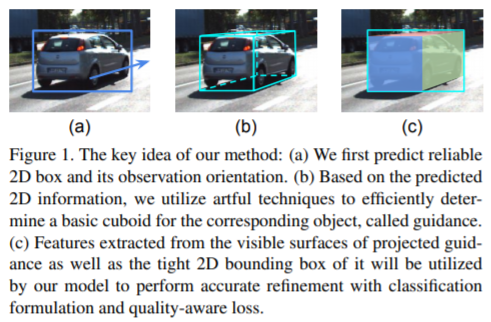

我们提出了一种在自动驾驶场景下基于单个RGB图像的高效3D对象检测框架。我们的工作是提取2D图像中的基础3D信息,并确定没有点云或立体数据的对象的准确3D边界框。利用现成的2D对象检测器,我们提出了一种巧妙的方法来为每个预测的2D框有效地获得粗糙的长方体。粗糙的长方体具有足够的精度,可以指导我们通过细化确定对象的3D框。与仅使用从2D边界框提取的特征进行框精炼的现有技术方法相反,我们通过使用可见表面的视觉特征来探索对象的3D结构信息。利用曲面的新特征来消除仅使用2D边界框带来的表示歧义的问题。此外,我们研究了3D框优化的不同方法,并发现具有质量感知损失的分类公式比回归模型具有更好的性能。通过KITTI基准评估,我们的方法优于基于单个RGB图像的3D对象检测的最新技术。

1. Introduction

3D对象检测是自动驾驶的关键组件之一。 在最近的计算机视觉社区中,它引起了越来越多的关注。 使用3D LIDAR激光扫描仪,可以获取点云形式的对象的离散3D位置数据,但是设备非常昂贵。 相反,车载彩色摄像机对于大多数车辆而言更便宜,更灵活,而它们只能提供2D照片。 因此,对于经济的自动驾驶系统而言,使用单个RGB相机进行3D对象检测变得非常重要,同时也具有挑战性。 本文着重于仅使用单眼RGB图像检测完整的3D对象内容。

本文提出了一种有效的框架,该框架基于3D引导并使用表面特征进行精修(GS3D)仅使用单眼RGB图像检测完整的3D对象内容。

典型的单图像3D检测方法,例如 Mono3d [2]采用传统的2D检测框架,其中将3D空间中的详尽滑动窗口用作建议,任务是选择能很好覆盖对象的窗口。 问题在于3D空间要比2D空间大得多,这会花费更多的计算时间,因此没有必要。

我们的第一个观察结果是,可以从2D检测和现场的先验知识中恢复3D粗糙结构。 由于最新的2D对象检测方法可以提供非常高精度的2D边界框,因此对它们的正确利用可以显着减少搜索空间,这已在几种基于点云的方法中应用[20,12]。 此外,借助对自动驾驶场景(例如投影矩阵)的先验知识,即使缺少点云,我们甚至可以为2D框中的对象获得一个近似的3D边界框(立方体)。 受此启发,我们设计了一种算法,可通过2D检测器有效地确定预测对象的基本长方体。 基本的长方体虽然粗略,但具有可接受的精度,可以指导我们确定对象的3D设置,大小(高度,宽度,长度)和方向。 因此,我们将基本的长方体称为指导。

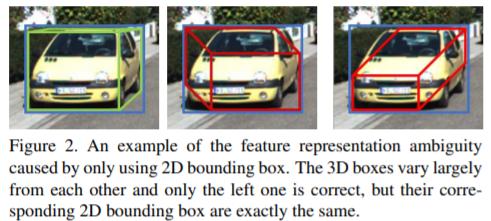

作为我们的第二个观察结果,可以通过研究3D盒子的可见表面来利用底层3D信息。根据指导,为了实现高精度,需要进一步分类以消除误报,并进行适当的细化以更好地定位。然而,当仅将2D边界框用于特征提取时丢失的信息带来了表示歧义的问题。如图2所示,彼此相差很大的不同3D框可以只具有相同的对应2D边界框。因此,模型将具有与输入相同的特征,但是分类器将为它们预测不同的置信度(图2中左置置信度高,其他置信度低),这是冲突。并且残差(Δx,Δy等)的预测也很困难。仅通过2D边界框,该模型几乎无法知道(指导的)原始参数是什么,但是它旨在基于这些参数预测残差。因此训练是非常无效的。为了解决此问题,我们探索了2D图像中的基础3D信息,并提出了一种新方法,该方法采用了从3D盒子投影的可见表面解析的特征。如图1(c)所示,分别提取可见表面中的特征,然后将其合并,以便利用结构信息来区分3D框的不同形式。

对于3D框优化,我们将常规回归形式重新构造为分类形式,并为此设计了质量感知损失,从而显着提高了性能。 我们的主要贡献如下:

我们提出了一种基于单眼数据的方法,基于可靠的二维检测结果,可以有效地获得物体的粗略基本长方体。 基本的长方体提供了对象位置,大小和方向的可靠近似值,并作为进一步完善的指导。

我们利用2D图像上投影的3D盒子的可见表面中潜在的3D结构信息,并提出利用从这些表面提取的特征来克服仅使用2D盒子的特征时先前方法中的特征歧义的问题 。 通过融合表面特征,该模型具有更好的判断能力改善了精化精度。

我们设计并研究了几种优化方法。 并且我们得出结论,对于3D框优化任务,基于离散分类的具有质量感知损失的方法比直接回归方法的性能要好得多。

我们根据KITTI对象检测基准[7]评估了我们的方法。 实验表明,我们的方法超越了仅使用单个RGB图像的最新技术,甚至可以与使用立体声数据的方法媲美。 为了便于与我们的作品进行比较,我们提供了有关val1和val2的结果。

2. Related Work

随着3D对物体和场景的理解越来越引起人们的关注。 早期作品[26、6、29、9、5]使用低级功能或统计分析来解决3D识别或恢复任务。 虽然3D对象检测任务更具挑战性[7]。

3D物体检测方法可以按数据分为三类,即点云,多视图图像(视频或立体数据)和单眼图像。 基于点云的方法,例如 [4、20、28、12、22]可以直接获取3D空间中对象表面上点的坐标,因此与没有点云的方法相比,它们可以轻松实现更高的精度。 基于多视图的方法,例如 [3],可以使用从不同视图的图像计算出的视差来获得深度图。 尽管点云和立体方法可提供更准确的3D信息,但单眼RGB相机的设备更方便且更便宜。

与我们最相关的作品是在自动驾驶场景中使用单个RGB图像进行3D对象检测的作品。 对于缺少3D空间信息的情况,此设置最具挑战性。 许多新近的著作都将重点放在这一背景上,因为这是一个具有重大影响的根本问题。 Mono3d [2]通过使用3D滑动窗口解决了这个问题。 它从可能会出现对象的几个预定义3D区域中详尽地采样3D提议。 然后,它利用细分,形状,上下文和位置的复杂特征来过滤出不可能的提议,并最终通过分类器选择最佳候选者。 Mono3d的复杂性带来了效率低下的严重问题。 鉴于我们在合理假设的基础上设计了一种基于纯射影几何的方法,该方法可以有效地生成数量少得多但精度更高的3D候选框。

由于采用了最先进的2D检测器[21、18、13、17、16,15]可以为对象提供可靠的2D边界框,许多作品都先使用2D框来缩小3D框的搜索范围[1,19]。 [1]使用CNN基于2D框预测零件坐标,可见性和模板相似度,并匹配最佳的对应3D模板。 虽然[19]首先使用CNN来基于裁剪后的2D框区域预测尺寸和方向,然后通过投影后3D框应紧密适合2D检测框的约束条件来确定位置坐标。 这些方法只是从2D边界框中提取特征,这带来了表示歧义的问题。 虽然我们利用表面特征来消除问题。

基于最新技术的单眼方法更加注意额外的3D信息,以便于检测。 [25,1,14]尝试通过学习子类别或中间阶段的3D关键点或部分来利用更多3D信息。 [1,14]使用2D-3D匹配来确定对象的3D坐标。 他们俩都需要带有附加结构或关键点标签的CAD模型。 [27]使用视差预测生成的深度信息获得近似点云,然后使用2D盒子特征和点云的融合来确定3D盒子。 尽管仅单眼图像用于预测,但视差模型的训练需要立体数据。 与这些方法相比,我们的工作利用了单眼图像中的3D结构信息,而无需额外的数据或标签。

3. Problem Formulation

我们从KITTI数据集中采用3D坐标系:坐标原点位于相机中心; x轴指向2D图像平面上的右侧; y轴指向下方; z轴指向与像平面正交的内部方向,代表深度。 3D边界框表示为B =(w,h,l,x,y,z,θ,φ,ψ)。 在这里,w,h,l是框的大小(分别为宽度,高度和长度),x,y,z是底部中心的坐标,该坐标紧随KITTI注释。 尺寸和中心坐标以米为单位。 θ,φ,ψ分别是绕y轴,x轴和z轴的旋转。 由于我们的目标物体都在地面上,因此我们仅像以前所有工作一样考虑θ旋转。 2D边界框带有指定标记,即B2d =(x 2d,y2d,w2d,h2d),其中(x 2d,y2d)是框的中心。

4. GS3D

4.1. Overview

图5显示了所提出框架的概述。 该框架将单个RGB图像作为输入,并包括以下步骤:1)利用基于CNN的检测器来获得可靠的2D边界框和对象的观察方向。该子网称为2D + O子网。 2)将获得的2D边界框和方向与关于驾驶场景的先验知识一起使用,以生成称为向导的基本长方体。 3)引导投影在图像平面上。 从其2D边界框和可见曲面中提取要素。 这些特征被融合为可区别的结构信息,以消除特征歧义。 4)融合的功能由另一个称为3D子网的CNN使用,以完善指导。 3D检测被视为分类问题,质量意识分类损失用于学习分类器和CNN特征。

4.2. 2D Detection and Orientation Prediction

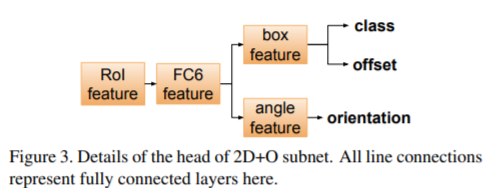

对于2D检测,我们通过添加方向预测的新分支来修改更快的R-CNN框架。 图3中示出了细节。

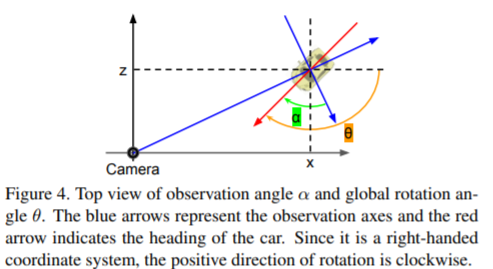

具体来说,使用称为2D + O子网的CNN从图像中提取特征,然后区域提议网生成候选2D框提议。 从这些建议中,将ROI池用于提取RoI特征,然后将其用于分类,边界框回归和方向估计。 在2D + O子网中估算的方向是与物体外观直接相关的物体观察角度。 为了将其与整体旋转θ区别开,我们将观察角表示为α。 在KITTI数据集中标注了α和θ,它们的几何关系如图4所示:

4.3. Guidance Generation

基于可靠的2D检测结果,我们可以为每个2D边界框估计一个3D盒。具体地说,我们的目标是获得制导Bg=(wg,hg,lg,xg,yg,zg,θg),给定2D盒B2d=(x2d,y2d,h2d,w2d),观察角α和相机固有矩阵K。