我们都知道,卷积核的作用在于特征的抽取,越是大的卷积核尺寸就意味着更大的感受野,当然随之而来的是更多的参数。早在 1998 年,LeCun 大神发布的 LetNet-5 模型中就会出,图像空域内具有局部相关性,卷积的过程是对局部相关性的一种抽取。

但是在学习卷积神经网络的过程中,我们常常会看到一股清流般的存在—1*1 的卷积!

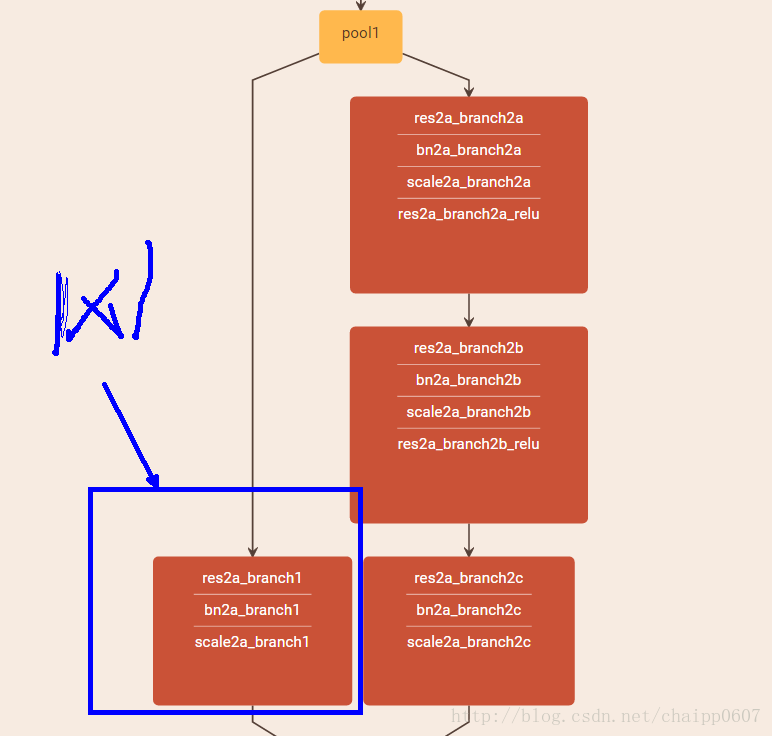

比如在残差网络的直连里:

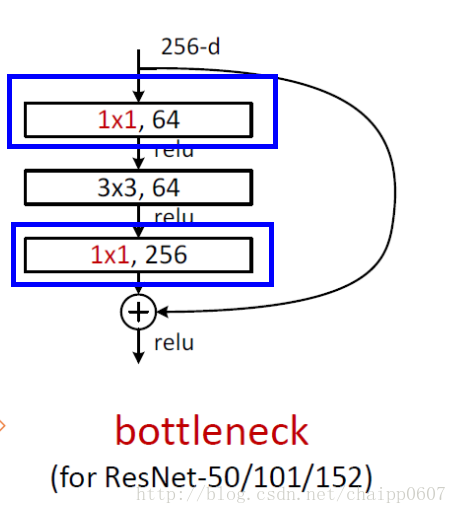

残差网络的 Bootleneck 残差模块里:

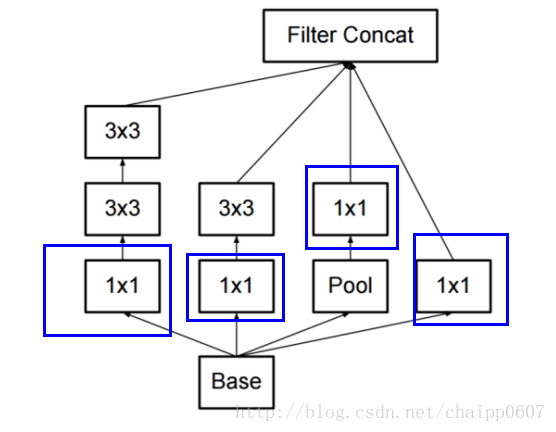

在 GoogleNet 的 Inception 模块里:

都有 11 卷积核的出现,那么它到底是做什么的?我们应该如何理解 11 卷积的原理?

当 1*1 卷积出现时,在大多数情况下它作用是升 / 降特征的维度,这里的维度指的是通道数(厚度),而不改变图片的宽和高。

举个例子,比如某次卷积之后的结果是 WH6 的特征,现在需要用 11 的卷积核将其降维成 WH_5,即 6 个通道变成 5 个通道:

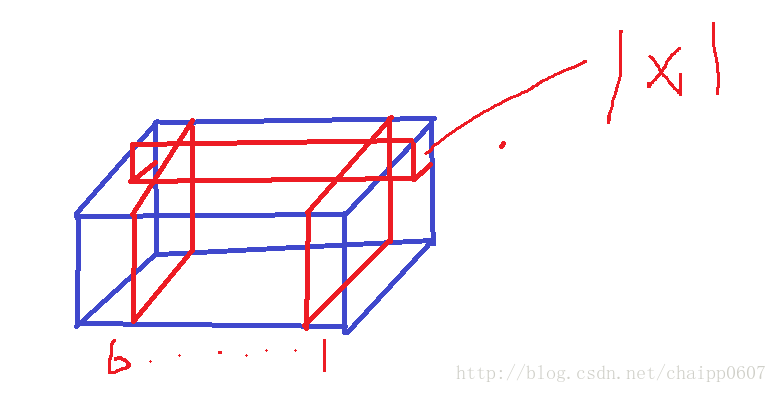

如下图就是一个 WH6 的特征,而 1_1 的卷积核在图上标出,卷积核自身的厚度也是 6(图画的好难看!!)

通过一次卷积操作,WH6 将变为 WH1,这样的话,使用 5 个 11 的卷积核,显然可以卷积出 5 个 WH1,再做通道的串接操作,就实现了 WH5。

在这里先计算一下参数数量,一遍后面说明,5 个卷积核,每个卷积核的尺寸是 11*6,也就是一种有 30 个参数。

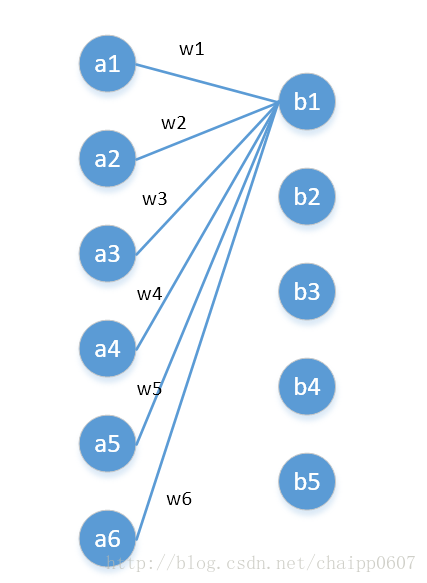

我们还可以用另一种角度去理解 1*1 卷积,可以把它看成是一种全连接,如下图:

第一层有 6 个神经元,分别是 a1—a6,通过全连接之后变成 5 个,分别是 b1—b5,第一层的六个神经元要和后面五个实现全连接,本图中只画了 a1—a6 连接到 b1 的示意,可以看到,在全连接层 b1 其实是前面 6 个神经元的加权和,权对应的就是 w1—w6,到这里就很清晰了:

第一层的 6 个神经元其实就相当于输入特征里面那个通道数:6,而第二层的 5 个神经元相当于 1*1 卷积之后的新的特征通道数:5。

w1—w6 是一个卷积核的权系数,如何要计算 b2—b5,显然还需要 4 个同样尺寸的核。

最后一个问题,图像的一层相比于神经元还是有区别的,这在于是一个 2D 矩阵还是一个数字,但是即便是一个 2D 矩阵的话也还是只需要一个参数(1*1 的核),这就是因为参数的权值共享。

https://blog.csdn.net/chaipp0607/article/details/60868689?utm_medium=distribute.pc_relevant.none-task-blog-BlogCommendFromMachineLearnPai2-3.channel_param&depth_1-utm_source=distribute.pc_relevant.none-task-blog-BlogCommendFromMachineLearnPai2-3.channel_param