摘要

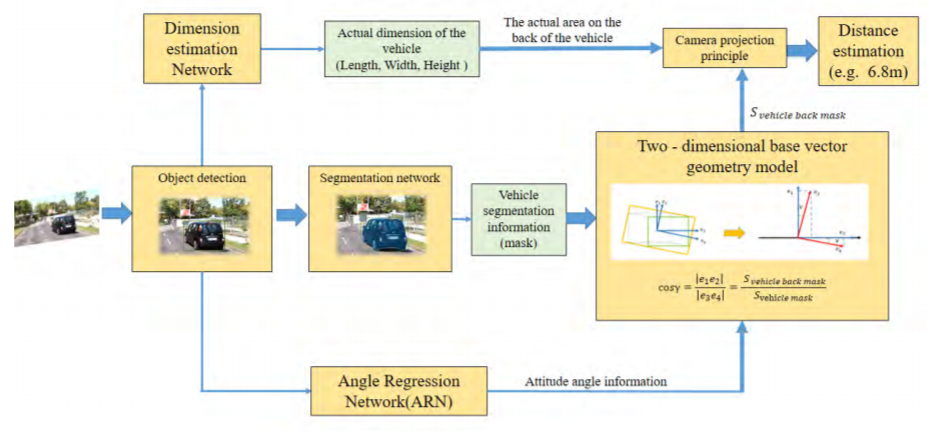

基于单眼视觉的高级驾驶员辅助系统(ADAS)迅速成为流行的研究主题。在ADAS中,基于单眼视觉的车载摄像机的车距估计至关重要。当前,基于单目视觉的用于测量前方车辆的绝对距离的相关方法在测距结果(低)以及不同类型的车辆之间的测距结果的偏差(大且容易)方面遇到精度问题。受姿态角变化的影响。为了提高距离估计系统的鲁棒性,本文提出了一种基于目标车辆的检测和分割来估计单目视觉车辆距离的改进方法,以解决车辆姿态角问题。角度回归模型(ARN)用于获取目标车辆的姿态角信息。尺寸估算网络确定目标车辆的实际尺寸。然后,根据图像解析几何原理设计二维基本矢量几何模型,以准确地恢复目标车辆的后方区域。最后,基于摄像机投影原理进行区域距离建模,以估计距离。在现实世界中的计算机视觉基准测试KITTI上的实验结果表明,与其他针对不同类型车辆(包括前向和侧向车辆)的现有现有方法相比,我们的方法具有更高的性能。

II. RELATED WORK

近年来,基于几何模型的单目视觉车辆距离估计方法的研究主要分为反透视映射变换方法[3],投影几何关系方法[5]和拟合建模方法[16]。 ],取得了可观的成绩。在[4],[17],[18],[20]中,提出了一种基于IPM的距离估计方法。这些研究之间的区别在于对象检测方法,例如道路去除算法[4],[17],阈值调整[18]以及色相,饱和度和值(HSV)色彩映射[20]。总体思路是将原始图像转换为鸟瞰图,该视图近似于从上到下的观察场景获得的图像。通过转换获得的IPM图像用于计算目标车辆的距离值。通过获取摄像机的内部和外部参数信息,将原始图像转换为IPM图像。该方法简单可行,但是在移动时不考虑车辆的姿态角信息,从而在车辆移动时导致相当大的距离误差。

……

本文创新点:

- 为了提高估计结果的准确性和系统在不同驾驶条件下的鲁棒性,本研究提出基于车辆分割信息整合车辆姿态角信息,以实现对前方车辆的距离估计。

- 根据图像解析几何原理设计二维基本矢量几何模型,得到车辆后方与车辆整体投影信息之间的关系。 该关系用于确定车辆后方的投影面积。

- 改进了获取车辆尺寸信息的方法,以提高系统效率并通过我们训练有素的尺寸估算网络获取车辆的实际尺寸。

IV. EXPERIMENT

在这项研究中,提出的距离估计系统主要应用于自动驾驶场景中的车辆摄像头系统。 研究场景是现代车辆的实际交通场景。 研究设备是安装在车辆挡风玻璃后方的摄像头,用于获取图像。

我们根据国际车辆碰撞警告系统[29]中的定义确定车辆的位置。 前方车辆分为两种:前方车辆和侧向车辆。 前方车辆意味着对象车辆和目标车辆的纵向中心线之间没有偏差。 如果存在偏差,则前方车辆为侧向车辆。

Segmentation Network: 在这项工作中,使用了最新的实例分割网络,即Mask R-CNN作为分割网络,并在像素级别分割了目标检测网络的候选区域,以获得了用于计算车辆距离。相对于Faster R-CNN,Mask R-CNN具有三个优势。首先,Mask R-CNN通过使用带有特征金字塔网络[28]的ResNeXt-101作为特征提取网络来增强网络的基础。其次,Mask R-CNN将RoIPool替换为RoIAlign,以解决由池的直接采样导致的不对齐问题。第三,Mask R-CNN可以独立预测每个类别的二进制掩码。每个二进制掩码的分类取决于感兴趣的网络区域(ROI)分类分支给出的分类预测,因此不会引起类别之间的竞争。 Mask R-CNN在实例分割方面表现出出色的性能。与2D边界框代表的方法相比,使用遮罩获取目标车辆的详细信息,并减少了矩形中的冗余度,从而提高了距离估算系统的准确性。因此,选择Mask R-CNN作为我们的距离估计系统的分割网络,可以获取图像中目标车辆的分割信息,以确保系统的准确性。

Angle Regression Network And Dimension Estimation Network: 鉴于角度回归和尺寸估算网络基于CNN网络框架,我们使用相同的回归网络结构来获取所需的车辆参数,即训练一个深度CNN来回归车辆的角度及其尺寸。 在KITTI数据集中,车辆,货车,卡车和公共汽车位于不同的类别下,类别实例的对象尺寸分布是低方差和单峰的。 例如,车辆和骑车人的尺寸差异大约是几厘米。 因此,我们直接使用L2损失。 为了回归车辆参数,我们使用了没有FC层的预训练VGG网络[33],并添加了角度和尺寸估计模块。 在训练过程中,每种地面真相作物的大小都调整为224×224。为使网络对视点变化和遮挡更加鲁棒,地面真相框会抖动,并且地面真相角会发生变化,以考虑到中心光线的移动。 庄稼

Datasets::本研究中提出的距离估计系统中涉及的网络是Mask R-CNN,ARN和尺寸估计网络。 我们使用了COCO和KITTI数据集[30]进行训练,从而最终在KITTI检测基准上验证了我们的方法。 KITTI包含7481张图像的训练集和7518张测试的图像集,并且由于我们的距离估算系统适用于自动驾驶场景,因此它仅关注“汽车”类别。 KITTI测试数据集没有地面真相标签。 按照“规则”,我们将部分数据从KITTI训练集中分离出来作为测试集。 “规则”如下。 首先,训练和测试集的数据必须来自不同的视频序列。 其次,所选数据应包含两个方案:前台和非前台。 第三,必须对不同距离的车辆进行测距。 因此,所选的验证图像应包括不同远近情况下的车辆样本。 根据此“规则”,我们将训练集中的3481张图像用作测试集,以验证和分析我们的距离估算方法。

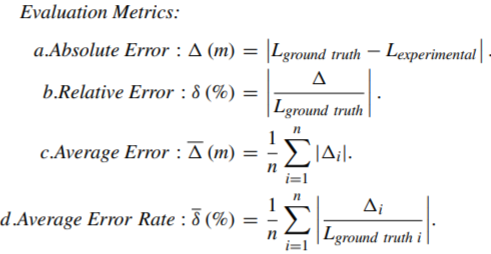

A. ACCURACY VERIFICATION OF THE ENTIRE SYSTEM MODEL

我们将距离估计结果的平均误差与[1]和[31]中提出的不同方法进行比较,结果示于表1。在[1],[31]中提出的方法的系统框架中, 通过使用透视原理估计距离来建立一个“非区域-距离”几何模型,而我们建议使用区域投影原理来建立“区域-距离”几何模型来实现距离估计。

实验表明,我们的方法的结果对于不同距离范围内的距离估计是最佳的。 与其他方法相比,在10 m范围内,使用我们的距离估计方法的估计结果的平均误差最大减少了0.43 m。 即使在大于20 m的距离范围内,我们的距离估计结果的平均误差也可以保证约为2 m。 与[1],[31]中提出的方法相比,平均误差大大降低,获得了最佳结果,并且提高了系统的距离估计精度。 此外,不同距离范围内的平均误差之间的最大偏差约为1.8 m。 与[31]中提出的方法相比,减少了不同距离的系统估计结果之间的偏差,并且整个距离估计系统更加稳定和健壮。

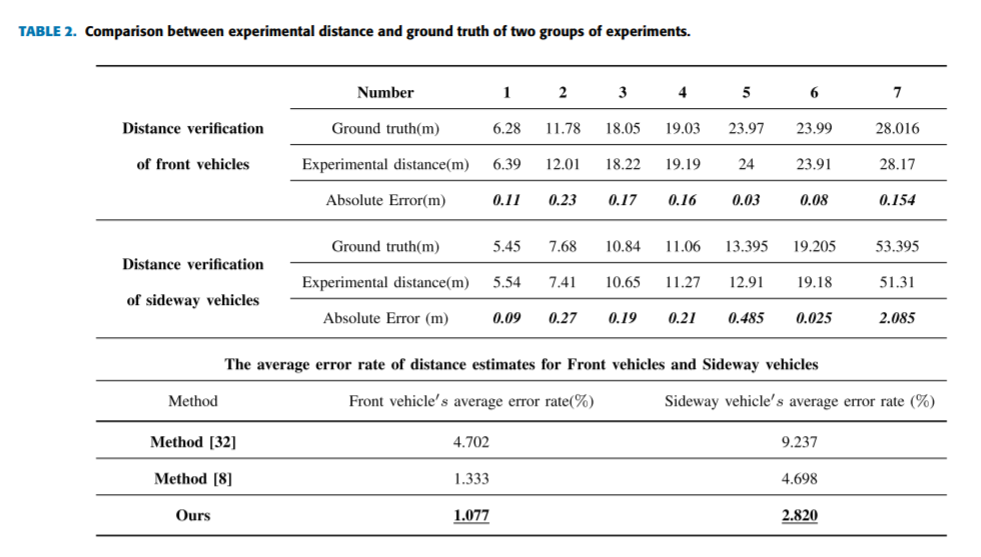

C. SYSTEM ROBUSTNESS VERIFICATION

为了更全面地评估所提出方法的性能并验证系统的鲁棒性,测试中使用了具有不同姿态角信息的前向和侧向车辆。 同时,将不同类型车辆的距离估计结果的平均错误率与[8]和[32]中提出的方法进行了比较。 结果列于表2。

V. CONCLUSION

这项研究将车辆的姿态角信息与其分割信息相结合,并提出了一种基于单眼视觉的车载摄像头可靠的车距估计方法。考虑到复杂交通场景下不同类型车辆的姿态角变化,基于角度信息的距离估计可以解决不同类型车辆测距精度差异较大的问题,从而解决了检测距离受限的系统问题,系统的鲁棒性和准确性,可帮助驾驶员专注于前方情况,并减少交通事故的发生。

从实验结果来看,该方法可以适应大多数交通情况,并针对前方车辆的不同驾驶状态表现出良好的鲁棒性。将来,我们将分析在不同场景(例如高速公路,拐角和乡村街道场景)中行驶的车辆,以进一步扩展我们的距离估算系统。另外,对于前部遮挡车,在现有的距离估计方法中没有简单的方法具有高精度和高效率。为了提高我们方法的适用性,我们将集中在这一方面,并不断完善我们的距离估计系统。