CsdnWujinming 2019-04-21 13:41:06

2134

收藏 6

最后发布: 2019-04-21 13:41:06 首发: 2019-04-21 13:41:06

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。

参考

1.Unsupervised Deep Tracking

论文

2.KCF 目标跟踪方法分析与总结

摘要

本文基于DCFnet 跟踪方法为其设计一种无监督的训练方法。训练只需无标签的视频数据。实验结果表明其准备度和性能能接近最好的方法。

方法实现

相关滤波回顾

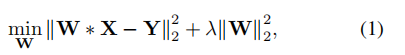

参考 KCF 目标跟踪方法分析与总结,滤波器为样本 (X,Y) (X,Y) 下岭回归的解 W W。

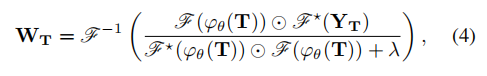

将计算过程转换为傅里叶域下的计算,得到解为

F \mathcal{F} 为傅里叶变换。推导可参考博客 2.

同样在傅里叶域里快速检测得到响应图。

DCF 框架方法通过目标模板 X 学习目标过滤器 W,然后使用 W 与搜索区域 Z 卷积得到响应图。

原型无监督学习

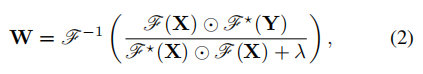

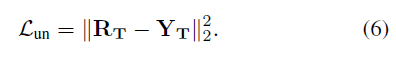

无监督学习过程是经过前向跟踪再反向跟踪,比较反向预测与初始的响应图之间的一致性,具体如下

如 a 图所示,对于一个样本对第 1 帧 template patch 和第 2 帧 search patch ,先前向跟踪,对应图 a,图 b 中浅蓝区域,即在第 1 帧中随机初始化一个框即红框,在第 2 帧中计算响应图(图 b 浅蓝区域的响应图)得到跟踪位置为第 2 帧中的蓝框。再反向跟踪,对应图 a,图 b 中蓝色区域,将前向跟踪在第 2 帧中的蓝框作为初始框,在第 1 帧中搜索目标,计算响应图得到位置为响应图上的绿框,最后一致性检验,计算初始框(第 1 帧的红框)与反向跟踪得到的绿框之间的误差,作为训练时一个样本对的损失。理想情况下,反向跟踪的结果与初始框一致。图 b 对应的跟踪网络为 CFnet,实际代码中使用的是 DCFnet。

前向跟踪过程

在第 1 帧 P1 P_1 中初始化边框,裁剪出目标模板 templat patch T,计算相关滤波

φθ(⋅) \varphi_\theta(\centerdot) 是 CNN 特征提取网络。YT Y_T 是模板 T 对应的高斯响应,峰值在初始框中心。得到 WT W_T 后就可以计算 P2 P_2 帧搜索区域 S 的响应图

如果有 P2 P_2 帧对应的 label,就可以使用监督训练一个跟踪器。

反向跟踪

根据前向跟踪,我们得到了 P2 P_2 的响应图 RS R_S,根据响应图我们构造一个中心在响应图最大处的高斯伪 label,记为 YS Y_S,以第 2 帧 P2 P_2 为目标模板在第一帧 P1 P_1 中搜索目标,计算过程与前向跟踪一致,就替换模板和搜索区域,以及相应的 label,得到在第 1 帧中的响应图 RT R_T。

一致性损失计算

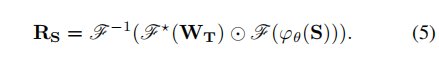

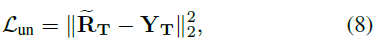

比较前后向跟踪的一致性。经过前后向跟踪,我们得到在第一帧中的响应图 RT R_T,以及初始化的真实 labelYT Y_T。理想的跟踪器应反向跟踪结果与初始 label 相同,计算方式为对应位相减计算二范式。

改进无监督跟踪

原型的计算方式并未考虑中间结果。实际中,可能前向跟踪结果与目标位置偏离但反向跟踪后目标位置与初始目标位置一致,这样一致性的计算并不能反应跟踪器的好坏。另外,视频可能包括无用信息如背景,目标阻塞问题。

多帧验证

在原两帧基础上将样本增加一帧,即三帧作为一个训练样本。增加样本的作用是,放大偏离,如果第一次前向跟踪偏离了目标,那么第二次前向跟踪再次偏离目标,反向跟踪相同,这样损失函数就可以考虑到前后向跟踪偏离的问题。

左边是原型的无监督跟踪一致性计算,右图是改进地无监督跟踪一致性计算。包括 P1 P_1 至 P2 P_2,P2 P_2 至 P3 P_3 两个前向跟踪预测过程,P3 P_3 至 P1 P_1 一个反向跟踪过程,注意不是两个反向跟踪过程。这样我们在反向跟踪后也得到了在 P1 P_1 帧的响应图 R~T \widetilde{R}_T。再计算一致性损失。

Cost-sensitive Loss 成本敏感的损失函数

多帧验证放大了偏离,但因为初始框是初始化的,图片中背景信息远多于前景目标信息,并且背景信息如天空,绿植等是不会运动的,为了减少这些目标对损失的贡献,我们为每个样本的损失增加权重。

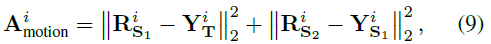

先计算目标的运动信息。

i i 是样本索引,RS1 R{S_1} 为第一个前向跟踪的响应图,YT Y_T 为初始目标对应的 label,RS2 R{S2} 为第二个前向跟踪的响应图,YS1 Y{S1} 为 RS2 R{S2} 对应的伪 label。对于运动的目标该值更大,对损失贡献也就越大。另外作者还过滤 10% 的小样本,用二元变量 Adropi A{drop}^i 表示是否将样本 i 的损失放入总损失函数中。

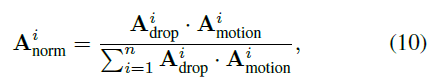

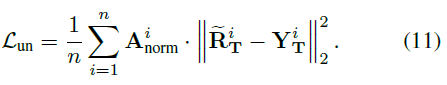

最后计算一个 batch 每个样本的运动信息在整个 batch 中运动总信息所占比例,值越大说明该样本越重要,则权重应越大。一致性损失计算方式为

实验

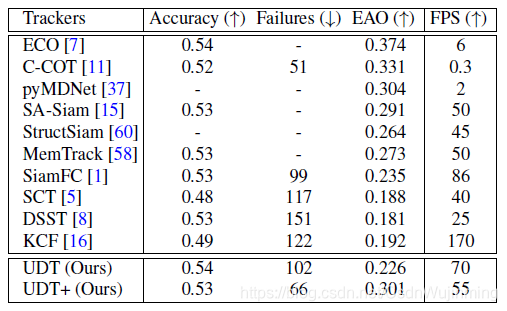

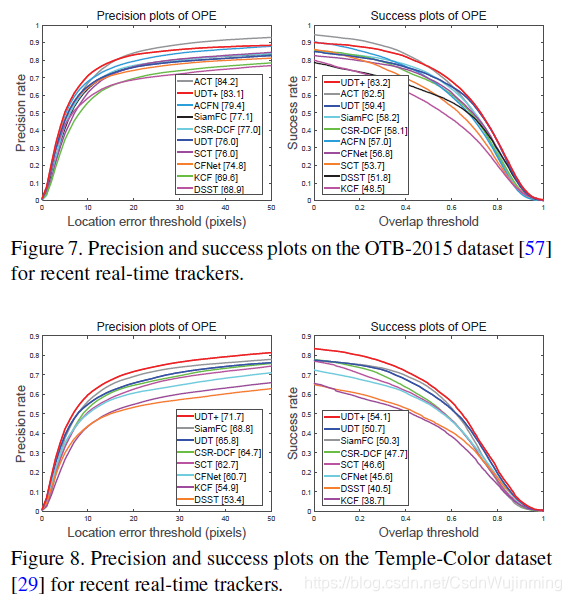

与其它跟踪算法的比较

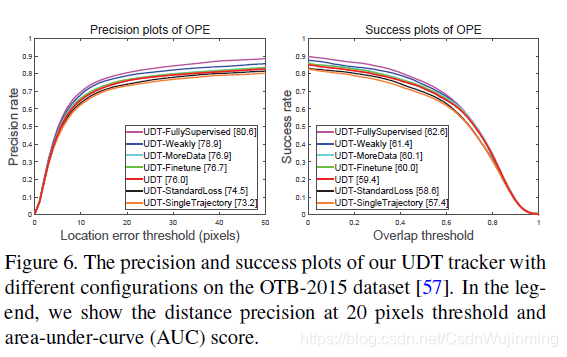

在原型 UDT 基础止增加多帧验证,增加数据等改进方法止的比较。

总结

为目标跟踪设计一种无监督的训练方法,并为其增加多帧验证技术,设计成本敏感损失函数。实验表明,与其它跟踪算法相比,其性能达到了基准线。

https://blog.csdn.net/CsdnWujinming/article/details/89334683