简介

客户端的 AdminClient是Kafka运维的工具类

AdminClient 提供的功能:

- 主题管理:包括主题的创建、删除和查询。

- 权限管理:包括具体权限的配置与删除。

- 配置参数管理:包括 Kafka 各种资源的参数设置、详情查询。所谓的 Kafka 资源,主要有 Broker、主题、用户、Client-id 等。

- 副本日志管理:包括副本底层日志路径的变更和详情查询。

- 分区管理:即创建额外的主题分区。

- 消息删除:即删除指定位移之前的分区消息。

- Delegation Token 管理:包括 Delegation Token 的创建、更新、过期和详情查询。

- 消费者组管理:包括消费者组的查询、位移查询和删除。

- Preferred 领导者选举:推选指定主题分区的 Preferred Broker 为领导者。

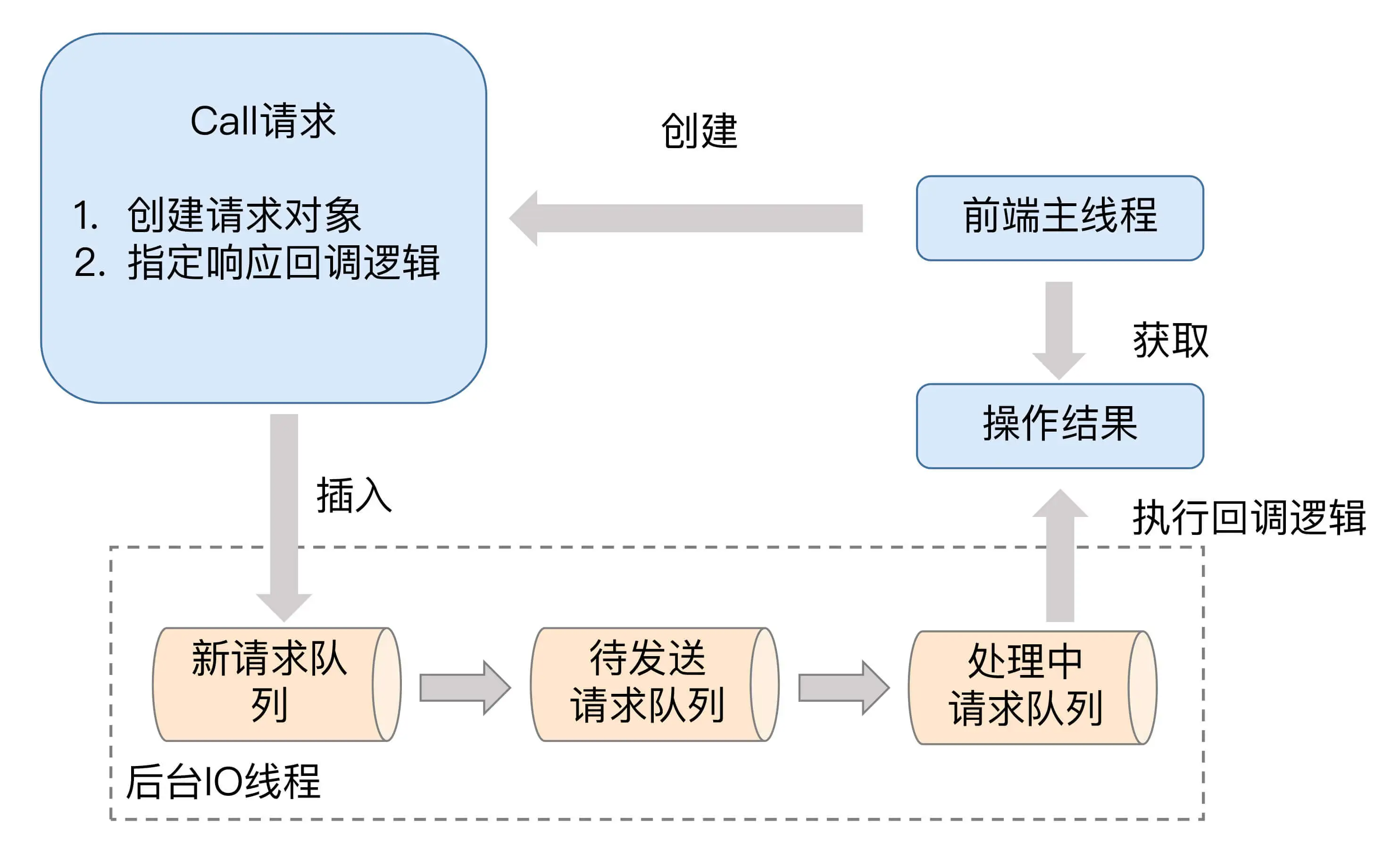

设计

使用

AdminClient的完整类路径是 org.apache.kafka.clients.admin.AdminClient,而不是 kafka.admin.AdminClient。后者就是我们刚才说的服务器端的 AdminClient,它已经不被推荐使用了。

引入依赖

<dependency><groupId>org.apache.kafka</groupId><artifactId>kafka-clients</artifactId><version>2.3.0</version></dependency>

构建和销毁 AdminClient 实例

Properties props = new Properties();props.put(AdminClientConfig.BOOTSTRAP_SERVERS_CONFIG, "kafka-host:port");props.put("request.timeout.ms", 600000);try (AdminClient client = AdminClient.create(props)) {// 执行你要做的操作……}

常用操作

创建主题

String newTopicName = "test-topic";try (AdminClient client = AdminClient.create(props)) {NewTopic newTopic = new NewTopic(newTopicName, 10, (short) 3);CreateTopicsResult result = client.createTopics(Arrays.asList(newTopic));result.all().get(10, TimeUnit.SECONDS);}

查询消费者位移

String groupID = "test-group";try (AdminClient client = AdminClient.create(props)) {ListConsumerGroupOffsetsResult result = client.listConsumerGroupOffsets(groupID);Map<TopicPartition, OffsetAndMetadata> offsets =result.partitionsToOffsetAndMetadata().get(10, TimeUnit.SECONDS);System.out.println(offsets);}

获取Broker磁盘占用

try (AdminClient client = AdminClient.create(props)) {DescribeLogDirsResult ret = client.describeLogDirs(Collections.singletonList(targetBrokerId)); // 指定Broker idlong size = 0L;for (Map<String, DescribeLogDirsResponse.LogDirInfo> logDirInfoMap : ret.all().get().values()) {size += logDirInfoMap.values().stream().map(logDirInfo -> logDirInfo.replicaInfos).flatMap(topicPartitionReplicaInfoMap ->topicPartitionReplicaInfoMap.values().stream().map(replicaInfo -> replicaInfo.size)).mapToLong(Long::longValue).sum();}System.out.println(size);}

补充: Kafka可视化管理工具