机器学习有两个核心的议题:

1、优化

2、正则化

其中,正则化就是避免机器学习过拟合的一种手段。

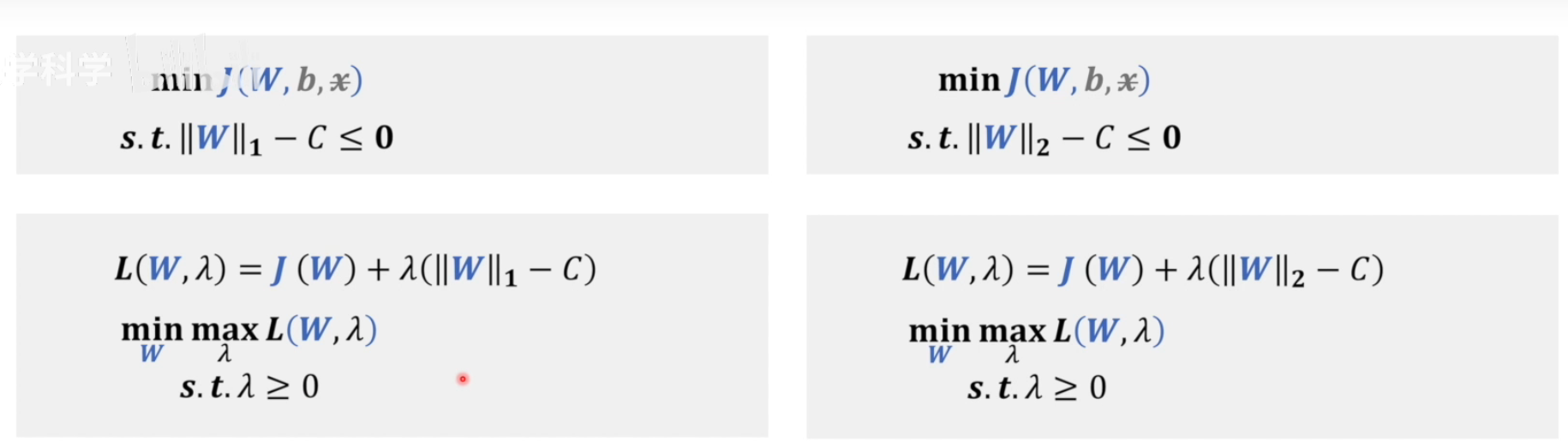

正则化最常用的方法就是对模型的权重进行L1和L2的正则化。

——减少泛化误差,而不是减少训练误差的方法都可以叫做正则化。

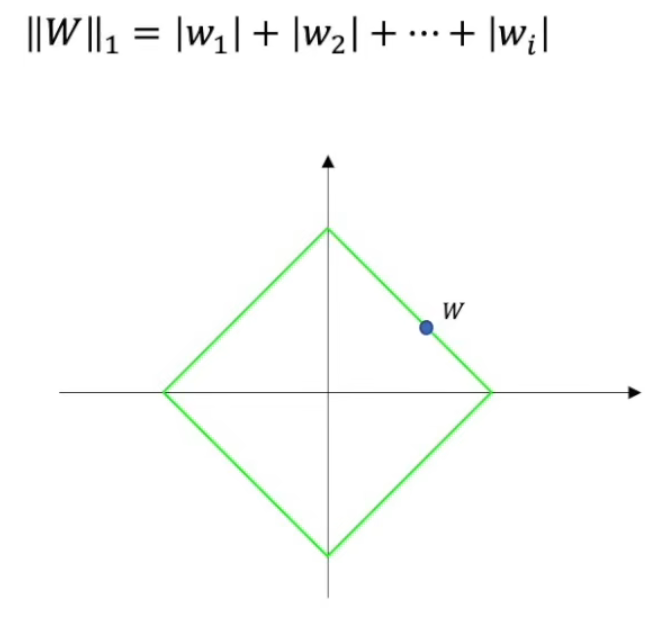

L1范数

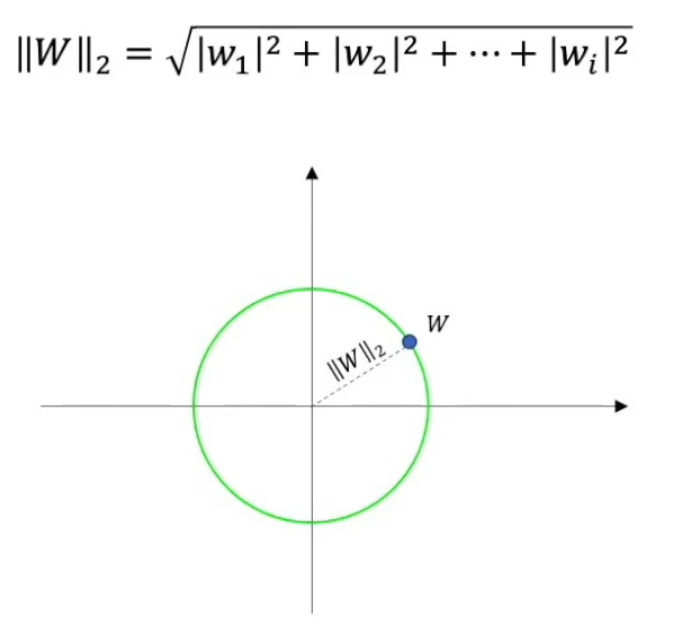

L2范数

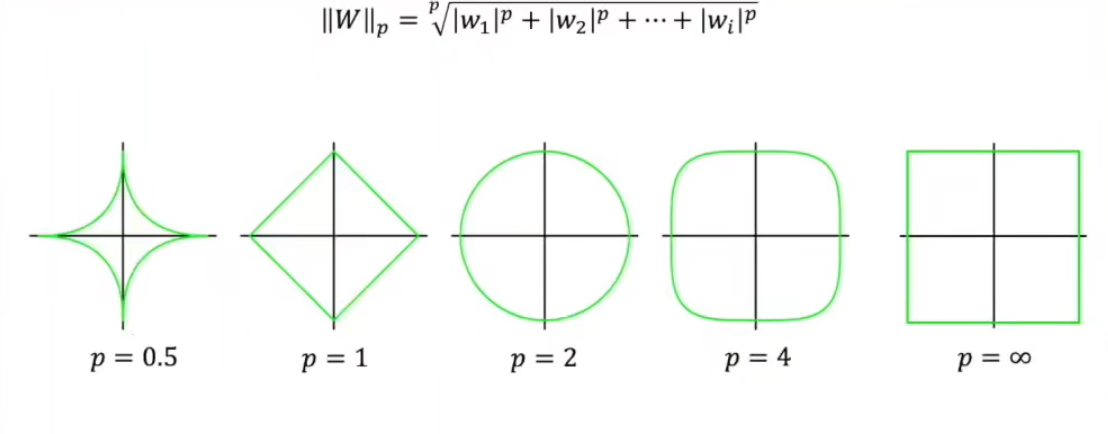

LP范数,只有P大于等于1的时候,LP范数才是一个凸集,我们才能用凸优化来解决。

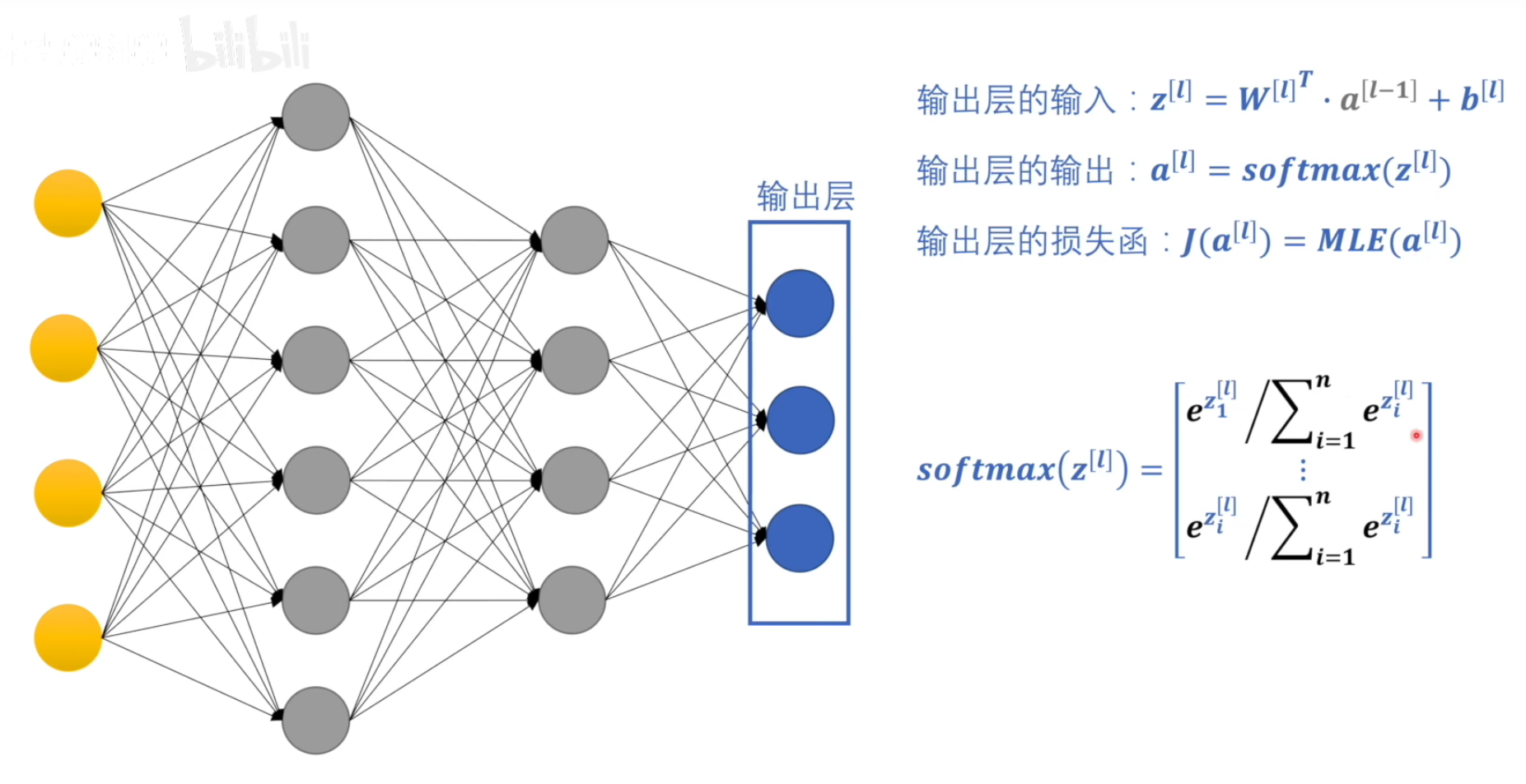

神经网络为什么会产生过拟合

神经网络的目的是寻找损失函数最小的W和b

现在有个问题就是,这个W和b的组合不是固定的。是有多种解的。

如果我们训练集是全集那么W和b的大小是无所谓的。但是现在我们的训练集不可能是全集,因为我们用神经网络/机器学习的目的就是为了能够让机器有预测的能力。

如果W和B太大,就容易放大自然的噪声和误差,导致结果错误。

??????

这里的softmax是干嘛用的

如果怕参数太大,那么就给一个可行域范围

这样问题就变成了拉格朗日问题了。。

正规化是在损失函数里面起作用的。正规化的目的就是增加额外的误差。