GBDT

DT-Decision Tree决策树,GB是Gradient Boosting,是一种学习策略。GBDT的含义就是用Gradient Boosting的策略训练出来的DT模型,模型的结果是一组回归分类树组合(CART Tree Ensemble):。其中

学习的是之前

课树预测结果的残差,这种思想就像是准备考试前的复习,先做一遍练习册,然后把做错的题目挑出来,再做一次,然后把做错的题目挑出来再做一次,反复多轮训练,取得最好的成绩。

而模型最后的输出,是一个样本在各个树中输出的结果的和:

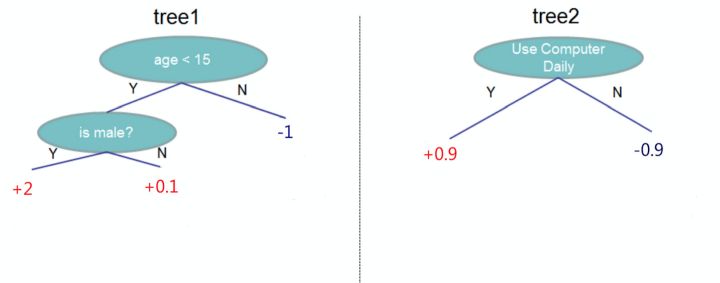

假设我们要预测一个人是否会喜欢电脑游戏,特征包括年龄,性别是否为男,是否每天使用电脑。标记(label)为是否喜欢电脑游戏,假设训练出如下模型

图1. 训练模型

该模型由两棵树组成,使用

和

作为内节点,叶子节点是输出的分数。

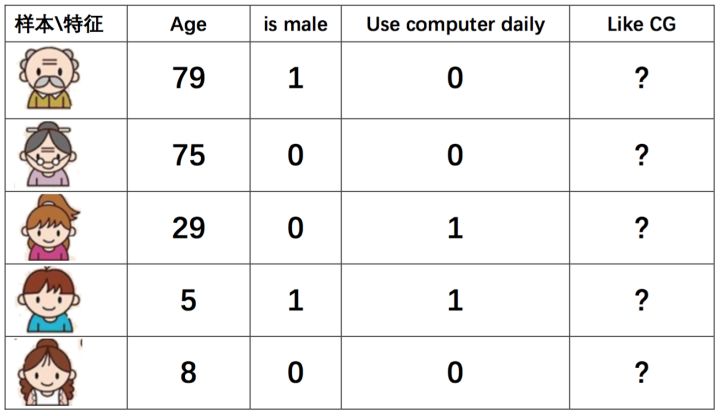

使用是否每日使用电脑作为根节点。假设测试样例如下:

图2. 测试样例

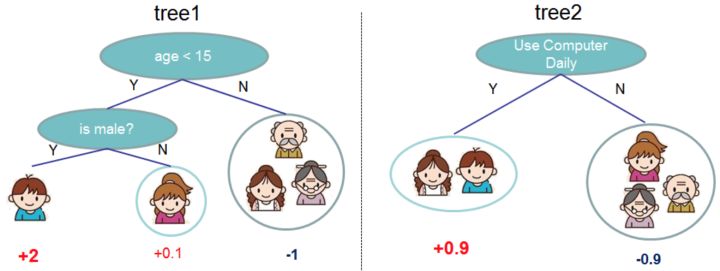

样本在两棵树中所在的节点如下:

图3. 样本所在节点

最后对某样本累加它所在的叶子节点的输出值,例如:

图4. 累加叶子结点的输出值

GBDT+LR

单独地使用GBDT模型,容易出现过拟合,在实际应用中往往使用GBDT+LR的方式做模型训练,算法更多细节参考[Practical Lessons from Predicting Clicks on Ads at Facebook].

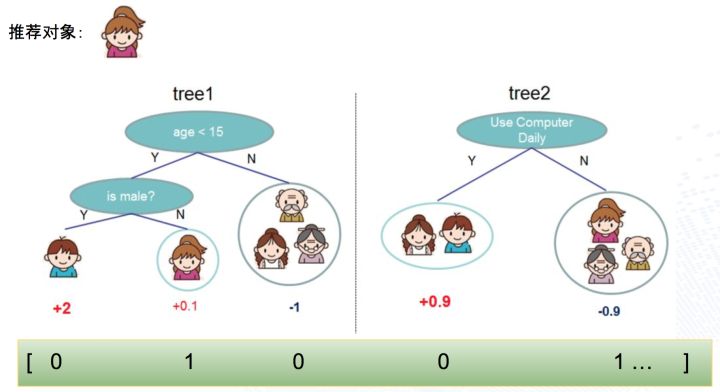

首先根据样本训练出GBDT树,对于每个叶子节点,回溯到根节点都可以得到一组组合特征,所以用叶子节点的标号可以代表一个新的组合特征。结合上面的图,用一个样本为例,直观表达如下:

图5. 叶子节点回溯

其中 0号 组合特征的含义是:ageLessThan15 && IsMale,该样本取值 0

其中 1号 组合特征的含义是:ageLessThan15 && IsNotMale,该样本取值 1

其中 2号 组合特征的含义是:ageLargerOrEqualThan15,该样本取值 0

其中 3号 组合特征的含义是:useComputerDaily,该样本取值 0

其中 4号 组合特征的含义是:notUseComputerDaily,该样本取值 1

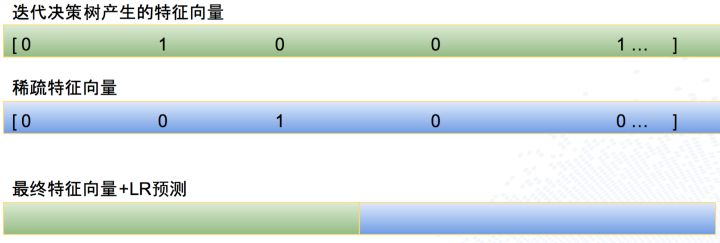

这部分特征是GBDT生成的组合特征,再结合LR固有的稀疏特征,就组成了GBDT+LR模型。生成样本向量阶段,样本首先过GBDT模型,生成组合特征部分的输入向量,再结合固有的稀疏特征向量,组成新的特征向量,示例如下:

图6. 组合特征+稀疏特征

在该例子中,第一行绿颜色是通过 GBDT 模型生成的特征向量,每个值都代表一个叶子节点的输出(样本在某棵树只在一个叶子节点有输出),第二行表示 LR 模型的稀疏特征向量,第三行表示把两部分特征向量拼接在一起,组成一个最终的特征向量,并使用该向量训练LR模型。