- 分享主题:Time Series Forecasting

- 论文标题:An Experimental Review on Deep Learning Architectures for Time Series Forecasting

- 论文链接:https://arxiv.org/pdf/2103.12057.pdf

1.Summary

This is a review of deep learning models used in time series prediction. Three types of deep learning models are mentioned: (1) Fully connected neural networks, (2) Recurrent neural networks, and (3) Convolutional networks. Among them, MLP belongs to fully connected neural networks, ERNN, LSTM, ESN and GRU belong to recurrent neural networks, and CNN and TCN belong to convolutional networks. This paper briefly describes the seven deep learning models. Experiments are carried out on these seven models mainly based on forecasting accuracy and computing time. A total of 12 public data sets are used, and the prediction tasks are very rich. In order to deepen my understanding of this paper, I can refer to some papers related to these seven deep learning models to understand what tasks they are often used for and how they can be extended or combined with other models or ideas.2.你对于论文的思考

这是一篇深度学习模型用于时间序列预测的综述,文中一共提到了7种深度学习模型,现在比较常用的,如MLP、LSTM、CNN等基本都包含在里面了,并且文中对于不同的模型提供了许多不同的模型配置,再加上有12个数据集(数据集都是一维的时间序列),所以一共弄了38000多个模型,为了避免不合适的参数而使得模型效果下降的情况,可以看出,实验还是相当充分的。之后,文中还探讨了各个模型的准确率以及训练和预测所需的时间,分析了对于时序预测问题而言,比较好的模型是什么,但是他在分析准确率时,只用了WAPE一个指标,感觉评价的指标太少了。3. 其他

模型

1.Fully connected neural networks:

(1)MLP: Multi-layer perceptron

2.Recurrent neural networks

(1)ERNN: Elman recurrent neural network

(2)LSTM: Long short-term memory network

(3)ESN: Echo state network

(4)GRU: Gated recurrent units network

3.Convolutional networks

(1)CNN: Convolutional neural network

(2)TCN: Temporal convolutional networkFully connected neural networks

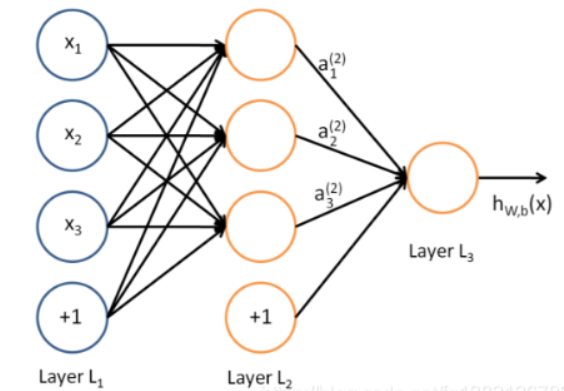

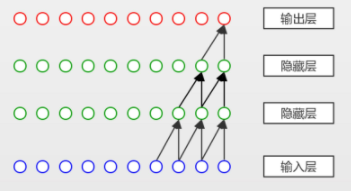

MLP

MLP只包含全连接层,包含一个输入层、若干个隐藏层以及一个输出层,结构比较简单。

Recurrent neural networks

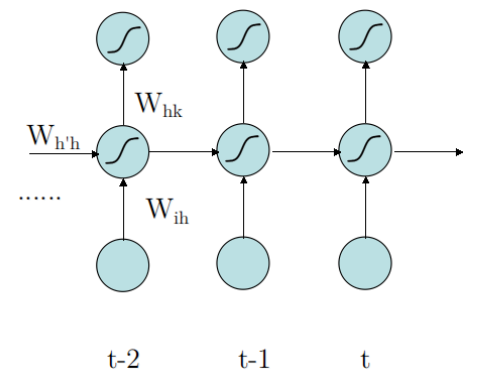

ERNN

ERNN是RNN中结构最简单的一个变种,如下图所示,t-1时刻的隐藏层会接收来自t-2时刻的状态,并传递到t时刻,ERNN经常会面临梯度爆炸和梯度消失的问题。

LSTM

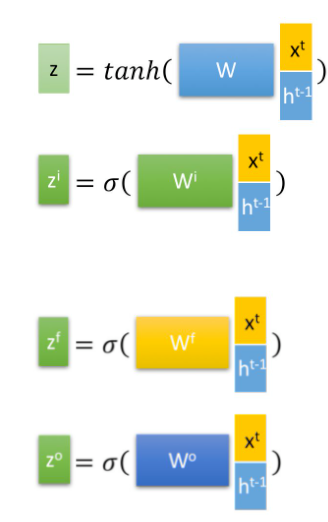

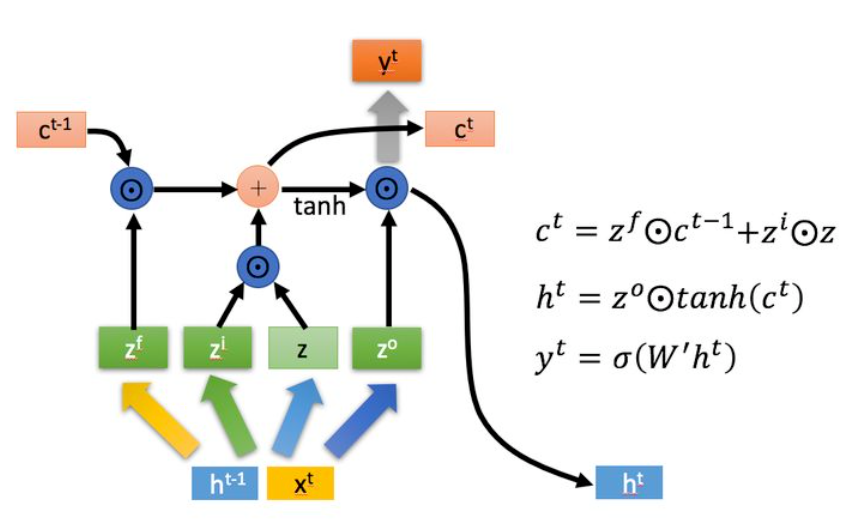

相比于ERNN,LSTM不仅会传递隐藏层的状态h,而且还会传递一个状态c,c的改变会比较慢。

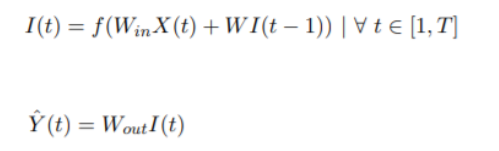

ESN

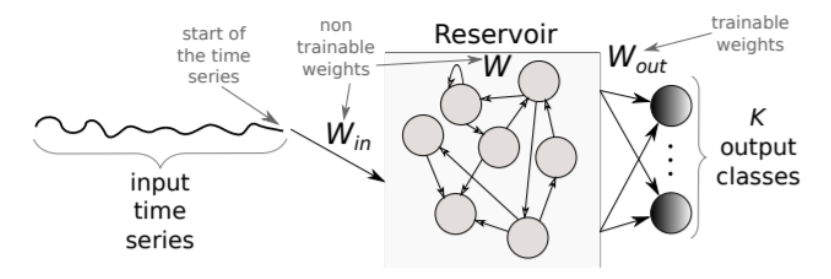

ESN的结构如下图所示,之前所有的状态都会存储到一个储备池中,也就是矩阵W。其中Win和W是不需要训练的,随机初始化就好了,只有Wout需要训练。

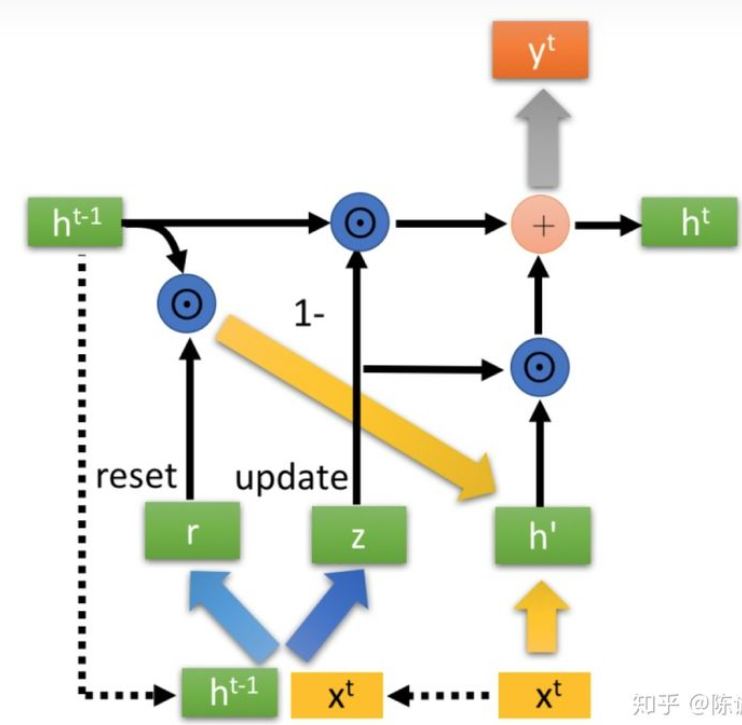

GRU

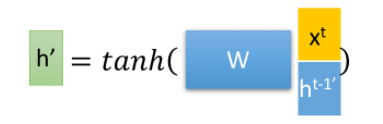

GRU和LSTM的结构有些类似,但是GRU只传递了隐藏层状态h,没有传递其它什么东西,而且GRU只使用了一个门控z就同时可以进行遗忘和选择记忆了,而LSTM需要zi和zf两个门控。

Convolutional networks

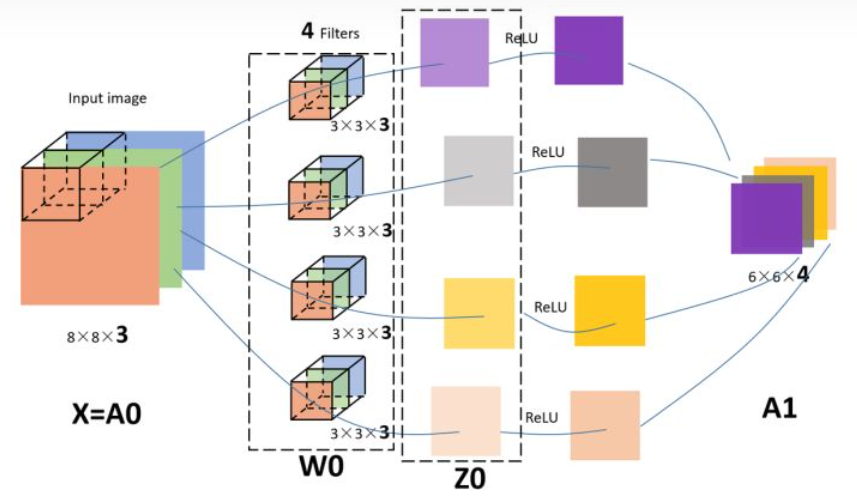

CNN

CNN主要由多个卷积层组成,卷积层需要用卷积核来计算,这样可以提取某一片地方的特征,最初的几层可能只能提取到一些边边角角的信息,但是随着层数的增多,提取到的信息会越来越完整。

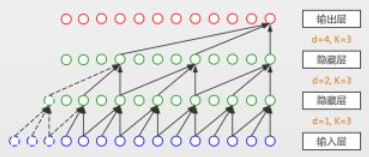

TCN

TCN利用了因果卷积和膨胀卷积,把全连接层全部替换为了卷积层。

因果卷积示意图如下,这是K=2的情况,t处的元素需要考虑上一层中t和t-1处的元素。

为了使模型能够追溯到更久以前的情况,而又不至于考虑太多的元素,所以就有了膨胀卷积,如下图所示,d越大,取值就越稀疏。

实验

准确率

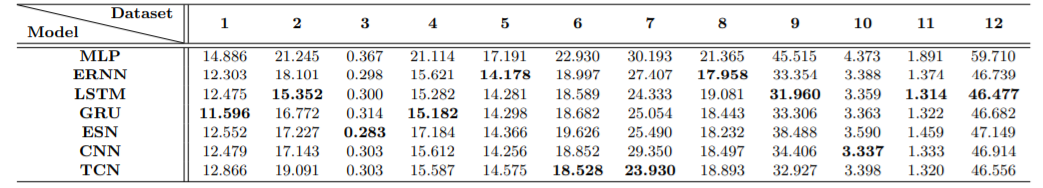

下表为各个模型在12个数据集上的WAPE,因为每一种模型都有不同配置的多种模型,下表的WAPE表示为平均值。

可以看出,MLP的表现是最差的,因为它的结构最简单,无法准确捕捉到时间序列中的复杂关系。LSTM和GRU的表现相对来说是最好的。

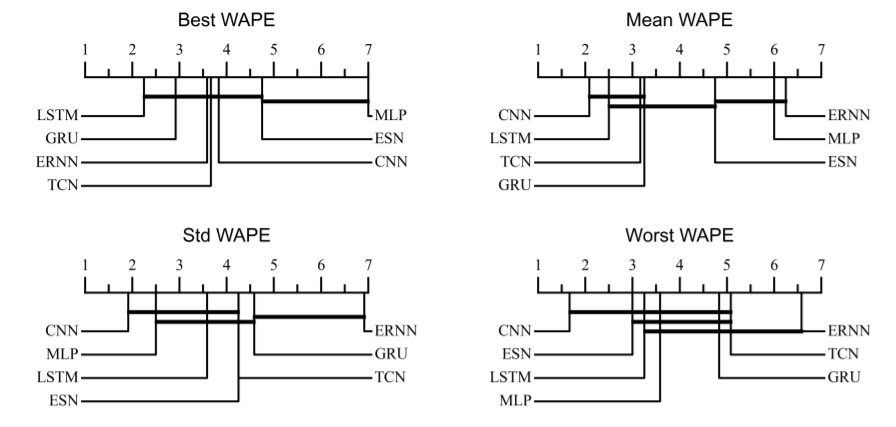

如下图所示,在Best WAPE中,LSTM的表现是最好的,而在Mean WAPE、Std WAPE和Worst WAPE中,CNN的表现是最好,说明在最佳参数下LSTM的精度是最高的,但是由于LSTM的结构比CNN复杂太多了,所以LSTM的最佳参数比较难寻找,而且对于参数的变化比较敏感,CNN则相反,在大多数情况下都能很好的适应参数的变化,比较容易找到合适的参数。

计算时间

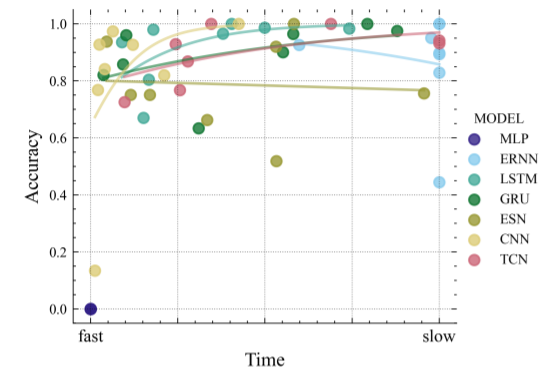

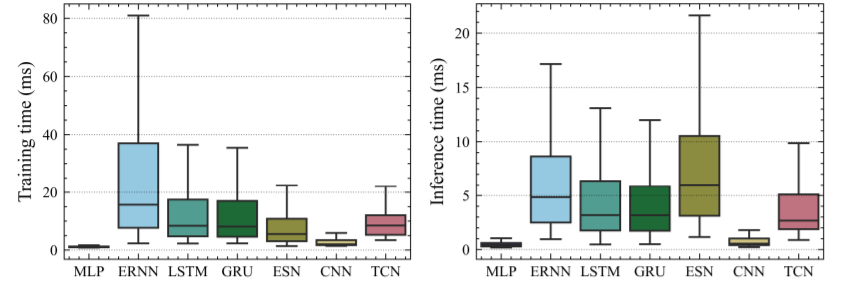

下图中,左边是训练时间,右边预测时间,可以看出,很明显,MLP由于结构简单,所需时间最短,CNN次之,也很短,远远胜过其它模型。

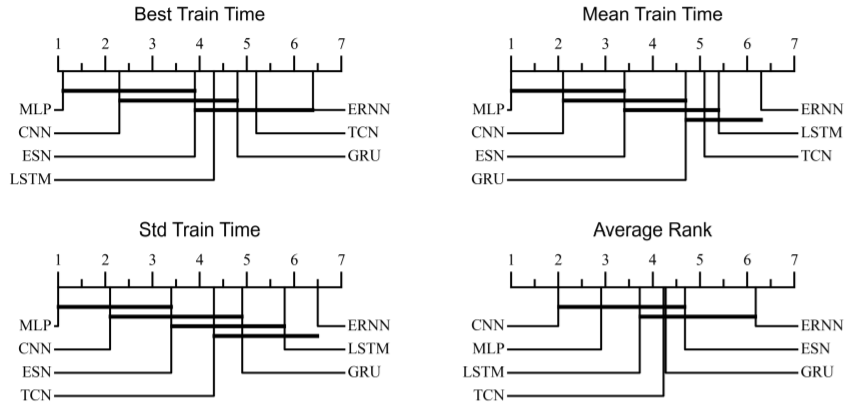

下图所示,除了MLP,CNN的时间都是最短的,RNN类的模型时间则都相对较长。

下图表示精度与计算速度的权衡,MLP速度最快却精度最差,LSTM精度高,计算速度也还可以,CNN计算速度快,精度也尚可。通过以上这些实验,可以得出,MLP并不适合时序预测,其它的模型就准确率来说都还可以,其中LSTM准确率最高,但是调参比较难,CNN准确率也还可以,而且它计算速度快,调参也比较容易。