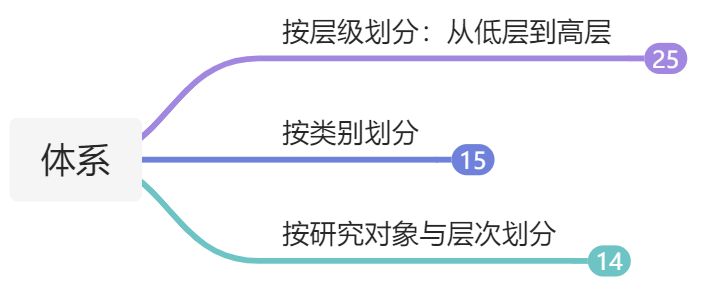

1.3 任务层级

NLP的一大特点是涉及的任务繁多

1.4 发展历史

- 基于理性主义的规则方法,通过专家总结的符号逻辑知识处理通用的自然语言现象

- 基于统计学习方法,大规模语料库统计模型发展。

- 2010-2017,基于深度神经网络的表示学习方法兴起,由于其避免了统计方法的手工特征操作,并且表示学习得到的特征军备通用性可以跨任务、跨语种甚至跨模态迁移,引起了一系列变革。

- 2018年后,基于预训练语言模型的学习方法,预训练模型有效地缓解了深度神经网络方法依赖标注数据的缺点,帮助自然语言处理取得了一系列突破,使得包括阅读理解在内的所有NLP任务都得到了大幅度提升,在某些数据集上升至达到或超越人类水平。

补充知识:自监督和无监督的概念辨析 文本自身的顺序性就是一种天然的标注数据,通过若干连续出现的词语预测下一个词语(又称语言模型)就可以构成一项原任务。由于图书、网页等文本数据规模近乎无限,所以,可以非常容易地获得超大规模的预训练数据。有人将这种不需要人工标注数据的预训练学习方法称为无监督学习(Unsupervised Learning),其实这并不准确,因为学习的过程仍然是有监督的(Supervised),更准确的叫法应该是自监督学习(Self-supervised Learning)。