support Vector Machine,简称SVM。既可以解决分类问题又可以解决回归问题。

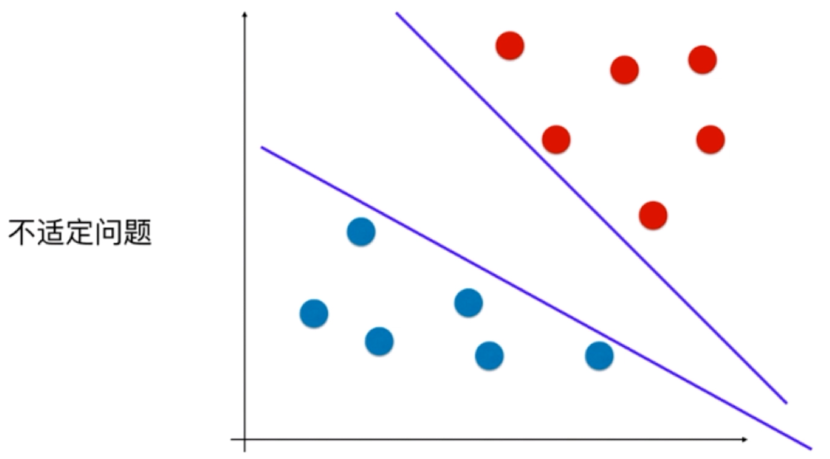

对于决策边界不唯一的问题称之为,不适定问题。在逻辑回归中使用求损失函数的方法,所以不存在不适定问题。

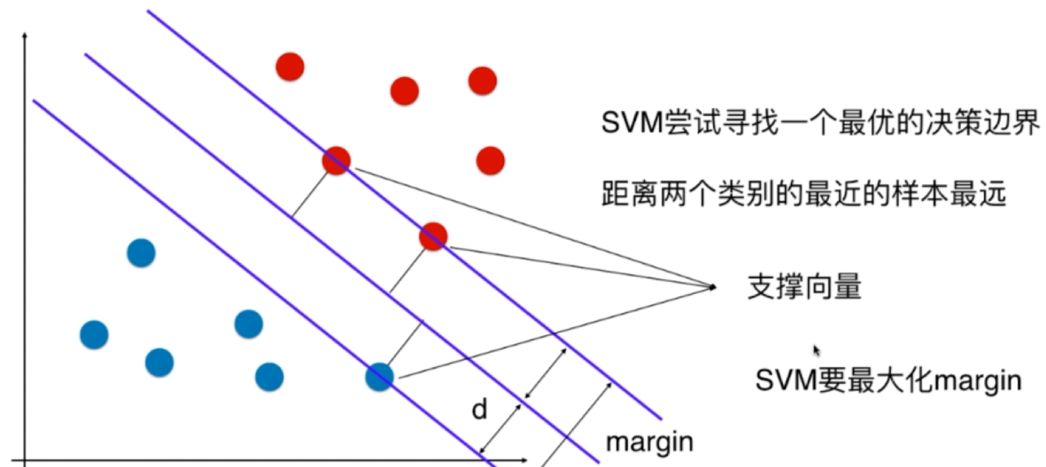

svm希望对未来新来点的泛化能力尽可能的好,但是没有寄希望于数据的预处理或者对模型正则化,而是将对泛化能力的考量直接放在了算法内,也就是我们要找到一条决策边界使得,这条决策边界离两个分类的样本都尽可能的远,也就是离决策边界最近的几个分类样本(支撑向量)尽可能都离决策边界尽可能远。这几个支撑向量组成的平行线的中间那条线也就是决策边界。

margin = 2d

上述svm解决的是线性可分问题称为:Hard Margin SVM。

那么解决线性不可分问题的svm就是:Soft Margin SVM。

sklearn使用SVM

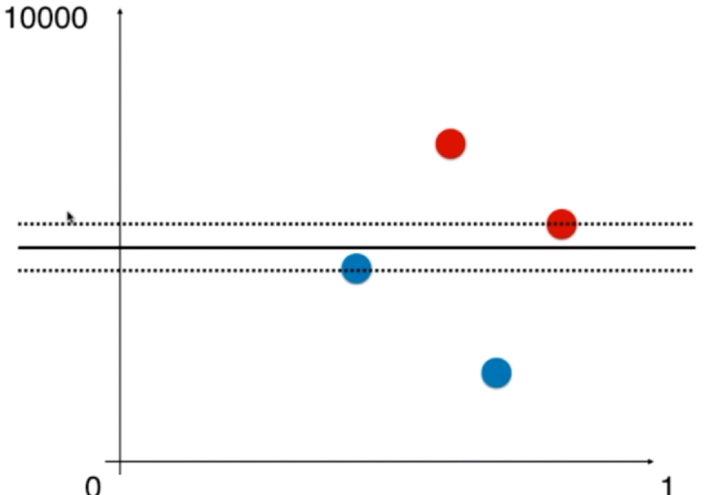

使用svm算法要像knn一样进行标准化处理。 不标准化示例,求最大margin,支撑向量只有俩个点。

不标准化示例,求最大margin,支撑向量只有俩个点。

# p11-4超参数c代表的是容错空间,c越大容错空间越小,c越小代表容错空间越大