简介

长期视觉定位是指外观随着时间变化估计给定查询图像的相机姿态的问题,比如在自动驾驶和机器人视觉中十分关键。在长期运行过程,比如季节更替场景外观发生了巨大变化,但是场景的语义并没有变,比如无论有没有叶子都是树。为了对时间变化拥有稳健性,长期定位一般使用语义分割表示不变的场景。但是这种不变性使用定位精度换来的,因为由于可用类比较少。如果想要增加类,则需要昂贵的代价去注释。

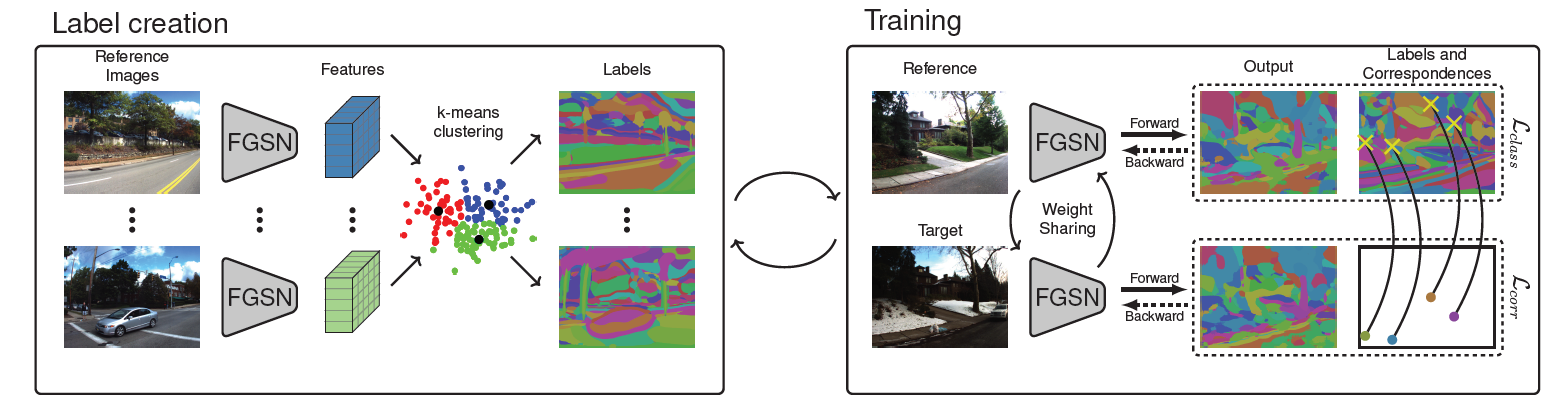

本文提出了细粒度分割网络(FGSN),基于聚类索引输出密集属性的予以分割图,消除了对人工类定义的需要,同时可以使用自监督学习的方法定义类。本方法可以用于提供具有大量标签的图像分割,同时保证类在季节性和视点变化下是稳定的。将此方法集成到现有的定位算法中,可以显著提高定位性能

方法核心

和传统语义分割相同,给定输入图像产生密集分割图,然而本方法是在自监督产生的分割图上进行训练,将训练集的图像中提取特征后,使用k-means对每个像素进行聚类,然后在训练期间作为标签用于监督。

在训练期间还是用了一组2D-2D点对应,以保证在季节性和视点变化的稳定。数据集中的每个样本包含了同一场景不同季节的两个图像,每一对中都有一张在良好的天气下捕获,在统一对图像中,鼓励网络为每一对的两个点预测相同的类别,可以附加损失来实现。

总结

本文使用了基于K-means聚类算法的密级属性分割的卷积神经网络,将图像的特征进行聚类分割,可以在图像中输入任意多类,无需手动创建注视。同时可以保证类在季节和视点变化下是稳定的。

本文和细粒度图像分类几乎没有任何关系,因为细粒度图像的背景往往各不相同,所以对同一视点的季节性变化也没有相应的联系,也很难找到有意义的内容。