简介

在安全领域和医学领域,视觉人工智能的可解释性和类别区分度至关重要,前者对了解其工作原理,揭示模型缺点,改进模型,理解失败案例提供了指示,后者对医学领域任务尤为重要,比如毛细血管出血,这要求模型区分不同颜色通道的信息,发现训练数据的颜色偏差,当用户了解模型的决策过程后,并能预测到输出后,也会更加信任模型。

同时,也要防止对抗性证据对图像分类的攻击和破坏,所以还需要在网络中加入约束或者正则化来防止错误的的解释,但是这样和显示细粒度证据相冲突。

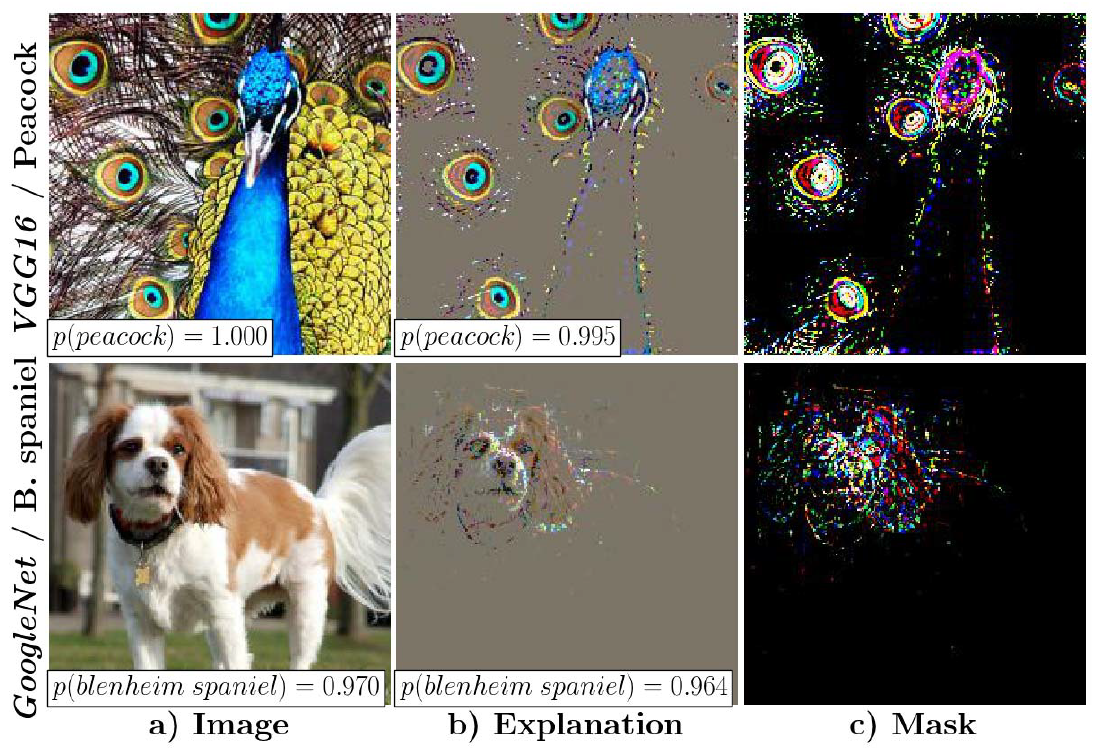

本文提供了一种基于事后优化的视觉解释方法,突出显示了输入图像中对特定预测的线索。这些线索有助于对决策进行细粒度解释,这些解释通常是视觉的类似图像的,并保留图像的边缘和颜色这样的特征,这些解释信息人类可以理解,同时也能作为模型的有效输入。

这种方法还是一种对抗性防御技术,在优化过程中选择性的过滤梯度。使用这种防御技术不依赖超参数,而是产生细粒度的图像级解释的关键。

和其他防御技术一样,本方法计算原始图像的扰动版本,删除所有不相关的像素,所以产出的解释还可以当做模型的输入。本方法是第一种能够直接产生图像级细粒度解释的方法,作者定性定量的评估了防御效果

方法核心

基于扰动的视觉解释

基于扰动的视觉解释方法可以定义为

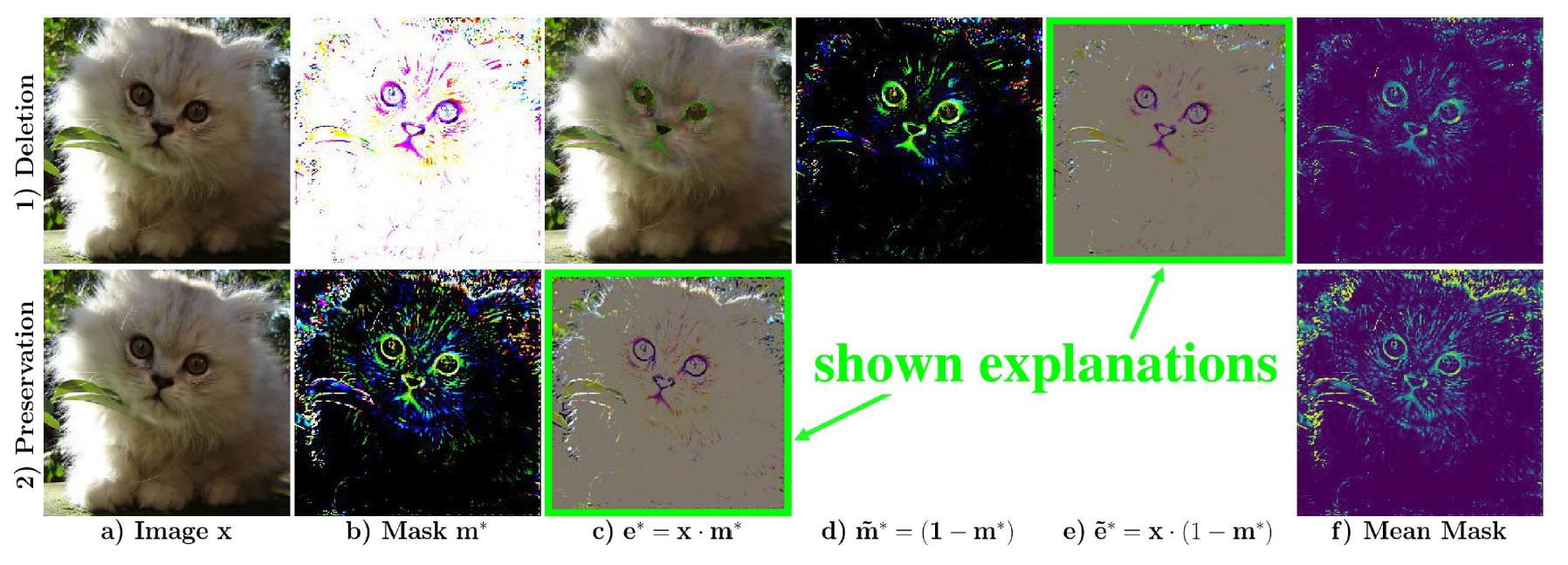

- 保留解释,想要获得原始输出所必须保留的最小区域

- 删除说明,想要改变原始输出所需要删除的最小区域

通过保留解释,仅在最重要的像素处包含大值,再通过删除说明选择掩码和像素中的最小条目,为目标类别提供了最突出的证据

对扰动图像的防御

本文使用了有针对性的方式,在反向传播时过滤梯度,核心思想是,如果一个神经元也被原始图像激活,则只允许解释图像的神经元被激活

这样强制性约束保留解释只能包含存在于原始图像相同位置的特征,防止生成新的证据

总结

本文介绍的是图像对抗算法的内容,和细粒度识别基本无关

不过本文提出的保留解释和删除说明为未来提取特征可能有一部分帮助,结合这两种方法,找出特征图中最重要的区域,也可以是各个部件,然后在对其进行单独的操作,可以试特征强调、融合、或者和本文一样,拿出来进行可视化,这点上值得进一步研究。