特征scale相差大时的代价函数图,以二维特征变量为例,这时J的等高线是一个又瘦又高的椭圆。此时使用梯度下降,它会来回波动,需要很长一段时间才能收敛。

所以

我们需要对数据集,对特征值进行Feature Scaling 特征缩放

X的尺度归一化 -1 , 1

converge 聚焦

Feature sacling与Mean normalization

mean normalization是特征缩放的一个小类型

学习率太大,不收敛甚至发散

学习率太小,迭代次数太多

polynomial regression 多项式回归

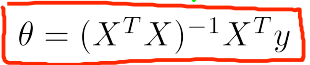

Normal Equation正规方程

quadratic 二次的

- 正规方程(区别于迭代方法的直接解法)

梯度下降法:缺点是需要选择学习速率和多次迭代。适合n很大时(n>10000)使用.需要进行特征缩放

正规方程法:不需要选择学习速率和多次迭代。不适合n很大(<10000)的时候。不需要进行特征缩放。

X是训练集,y是正确值。thelta是求出来的,令J(thelta)最小的参数值。

这样即可求出最佳的回归参数

正规方程在矩阵不可逆情况下的解决方法

造成X’X不可逆的可能原因:

1.有线性相关的冗余特征(如果可以找出来)

2.特征维度大于数据量(删除某些特质,或者使用regularization)