准备数据

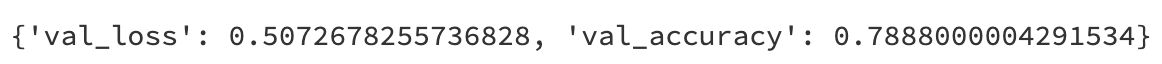

imdb数据集的目标是根据电影评论的文本内容预测评论的情感标签。

训练集有20000条电影评论文本,测试集有5000条电影评论文本,其中正面评论和负面评论都各占一半。

文本数据预处理较为繁琐,包括中文切词(本示例不涉及),构建词典,编码转换,序列填充,构建数据管道等等。

在torch中预处理文本数据一般使用torchtext或者自定义Dataset,torchtext功能非常强大,可以构建文本分类,序列标注,问答模型,机器翻译等NLP任务的数据集。

torchtext常见API一览:

- torchtext.data.Example : 用来表示一个样本,数据和标签

- torchtext.vocab.Vocab: 词汇表,可以导入一些预训练词向量

- torchtext.data.Datasets: 数据集类,getitem返回 Example实例, torchtext.data.TabularDataset是其子类。

- torchtext.data.Field : 用来定义字段的处理方法(文本字段,标签字段)创建 Example时的 预处理,batch 时的一些处理操作。

- torchtext.data.Iterator: 迭代器,用来生成 batch

- torchtext.datasets: 包含了常见的数据集

import numpy as npimport pandas as pdfrom collections import OrderedDictimport re,stringMAX_WORDS = 10000 # 仅考虑最高频的10000个词MAX_LEN = 200 # 每个样本保留200个词的长度BATCH_SIZE = 20train_data_path = '../data/imdb/train.tsv'test_data_path = '../data/imdb/test.tsv'train_token_path = '../data/imdb/train_token.tsv'test_token_path = '../data/imdb/test_token.tsv'train_samples_path = '../data/imdb/train_samples/'test_samples_path = '../data/imdb/test_samples/'

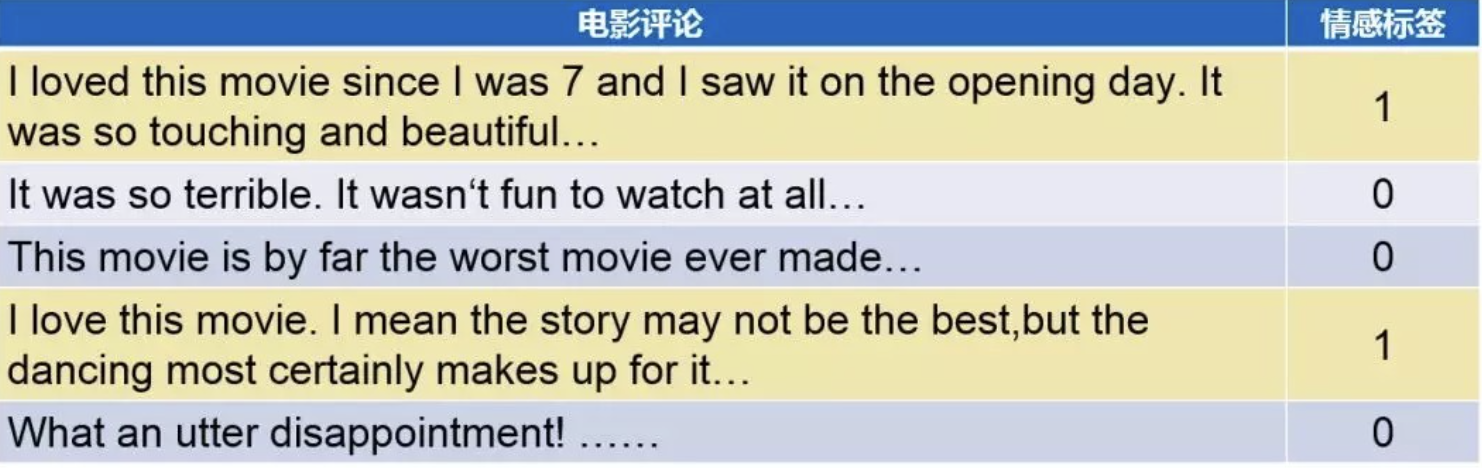

首先我们构建词典,并保留最高频的MAX_WORDS个词。

##构建词典word_count_dict = {}#清洗文本def clean_text(text):lowercase = text.lower().replace("\n"," ")stripped_html = re.sub('<br />', ' ',lowercase)cleaned_punctuation = re.sub('[%s]'%re.escape(string.punctuation),'',stripped_html)return cleaned_punctuationwith open(train_data_path,"r",encoding = 'utf-8') as f:for line in f:label,text = line.split("\t")cleaned_text = clean_text(text)for word in cleaned_text.split(" "):word_count_dict[word] = word_count_dict.get(word,0)+1df_word_dict = pd.DataFrame(pd.Series(word_count_dict,name = "count"))df_word_dict = df_word_dict.sort_values(by = "count",ascending =False)df_word_dict = df_word_dict[0:MAX_WORDS-2] #df_word_dict["word_id"] = range(2,MAX_WORDS) #编号0和1分别留给未知词<unkown>和填充<padding>word_id_dict = df_word_dict["word_id"].to_dict()df_word_dict.head(10)

然后我们利用构建好的词典,将文本转换成token序号。

#转换token# 填充文本def pad(data_list,pad_length):padded_list = data_list.copy()if len(data_list)> pad_length:padded_list = data_list[-pad_length:]if len(data_list)< pad_length:padded_list = [1]*(pad_length-len(data_list))+data_listreturn padded_listdef text_to_token(text_file,token_file):with open(text_file,"r",encoding = 'utf-8') as fin,\open(token_file,"w",encoding = 'utf-8') as fout:for line in fin:label,text = line.split("\t")cleaned_text = clean_text(text)word_token_list = [word_id_dict.get(word, 0) for word in cleaned_text.split(" ")]pad_list = pad(word_token_list,MAX_LEN)out_line = label+"\t"+" ".join([str(x) for x in pad_list])fout.write(out_line+"\n")text_to_token(train_data_path,train_token_path)text_to_token(test_data_path,test_token_path)

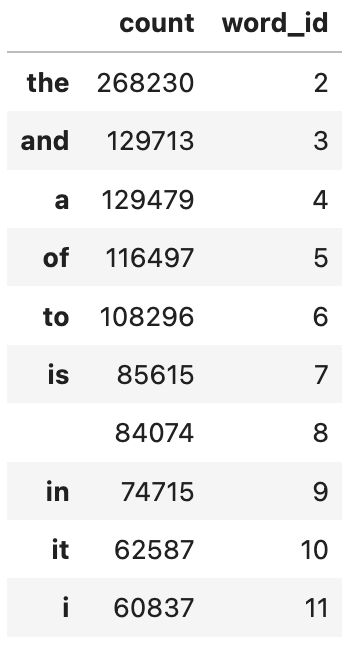

接着将token文本按照样本分割,每个文件存放一个样本的数据。

# 分割样本import osif not os.path.exists(train_samples_path):os.mkdir(train_samples_path)if not os.path.exists(test_samples_path):os.mkdir(test_samples_path)def split_samples(token_path,samples_dir):with open(token_path,"r",encoding = 'utf-8') as fin:i = 0for line in fin:with open(samples_dir+"%d.txt"%i,"w",encoding = "utf-8") as fout:fout.write(line)i = i+1split_samples(train_token_path,train_samples_path)split_samples(test_token_path,test_samples_path)

print(os.listdir(train_samples_path)[0:100])

一切准备就绪,我们可以创建数据集Dataset, 从文件名称列表中读取文件内容了。

import osfrom torch.utils.data import Dataset,DataLoaderclass imdbDataset(Dataset):def __init__(self,samples_dir):self.samples_dir = samples_dirself.samples_paths = os.listdir(samples_dir)def __len__(self):return len(self.samples_paths)def __getitem__(self,index):path = self.samples_dir + self.samples_paths[index]with open(path,"r",encoding = "utf-8") as f:line = f.readline()label,tokens = line.split("\t")label = torch.tensor([float(label)],dtype = torch.float)feature = torch.tensor([int(x) for x in tokens.split(" ")],dtype = torch.long)return (feature,label)

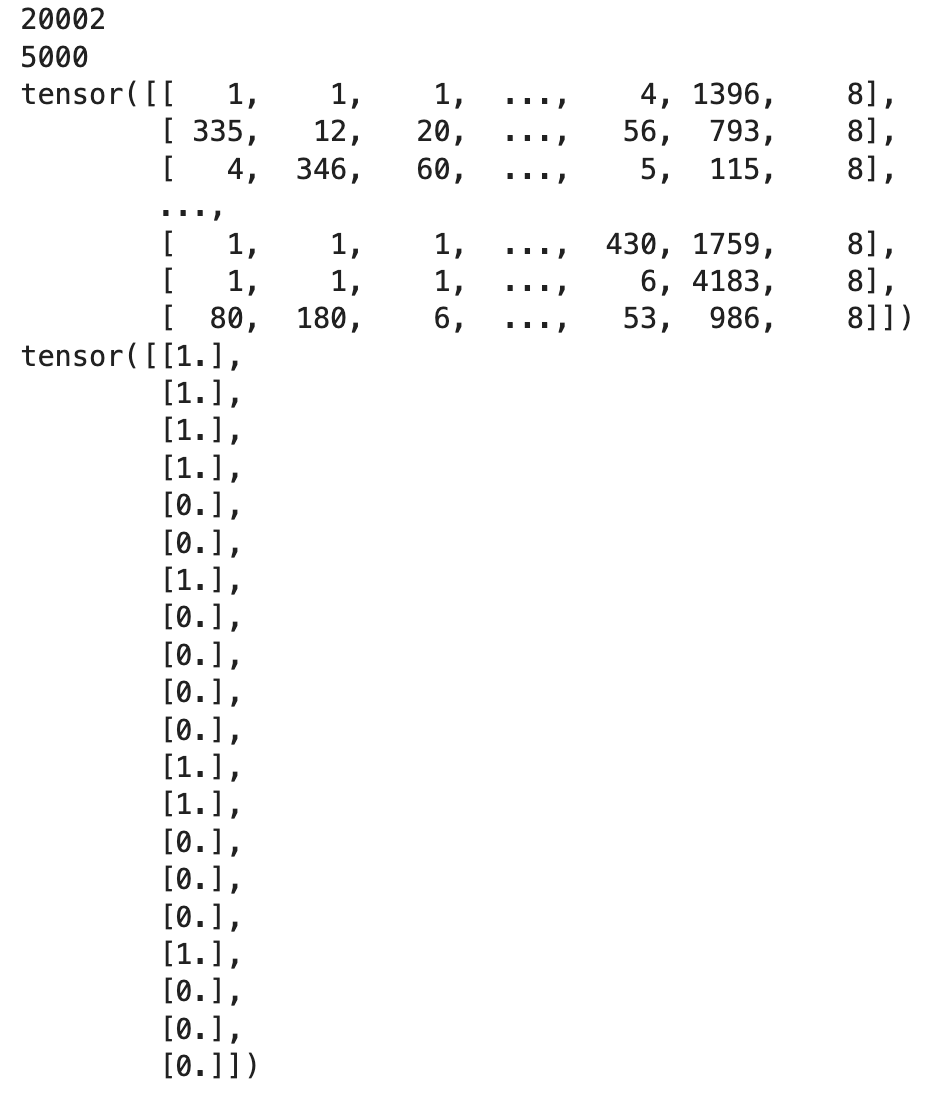

ds_train = imdbDataset(train_samples_path)ds_test = imdbDataset(test_samples_path)print(len(ds_train))print(len(ds_test))dl_train = DataLoader(ds_train,batch_size = BATCH_SIZE,shuffle = True,num_workers=0)dl_test = DataLoader(ds_test,batch_size = BATCH_SIZE,num_workers=0)for features,labels in dl_train:print(features)print(labels)break

定义模型

使用Pytorch通常有三种方式构建模型:

- 使用nn.Sequential按层顺序构建模型;

- 继承nn.Module基类构建自定义模型;

- 继承nn.Module基类构建模型并辅助应用模型容器(nn.Sequential,nn.ModuleList,nn.ModuleDict)进行封装。

此处选择使用第三种方式进行构建。由于接下来使用类形式的训练循环,我们将模型封装成torchkeras.Model类来获得类似Keras中高阶模型接口的功能。Model类实际上继承自nn.Module类。

MacBook torchkeras包没导入成功,后边没实现。

把torchkears.py文件放到/Users/huang/miniforge3/lib/python3.9/site-packages是可以正常导入了,但后边训练部分还是报错。

torchkeras.py

import torchfrom torch import nnimport torchkeras

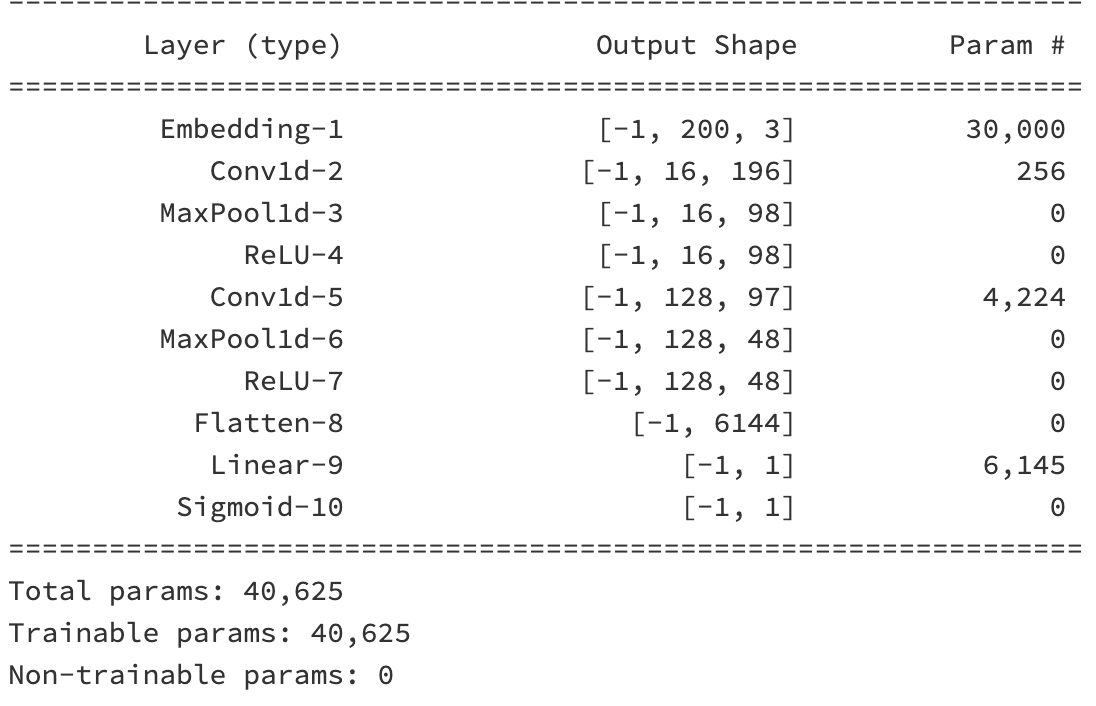

torch.random.seed()import torchfrom torch import nnclass Net(torchkeras.Model):def __init__(self):super(Net, self).__init__()#设置padding_idx参数后将在训练过程中将填充的token始终赋值为0向量self.embedding = nn.Embedding(num_embeddings = MAX_WORDS,embedding_dim = 3,padding_idx = 1)self.conv = nn.Sequential()self.conv.add_module("conv_1",nn.Conv1d(in_channels = 3,out_channels = 16,kernel_size = 5))self.conv.add_module("pool_1",nn.MaxPool1d(kernel_size = 2))self.conv.add_module("relu_1",nn.ReLU())self.conv.add_module("conv_2",nn.Conv1d(in_channels = 16,out_channels = 128,kernel_size = 2))self.conv.add_module("pool_2",nn.MaxPool1d(kernel_size = 2))self.conv.add_module("relu_2",nn.ReLU())self.dense = nn.Sequential()self.dense.add_module("flatten",nn.Flatten())self.dense.add_module("linear",nn.Linear(6144,1))self.dense.add_module("sigmoid",nn.Sigmoid())def forward(self,x):x = self.embedding(x).transpose(1,2)x = self.conv(x)y = self.dense(x)return ymodel = Net()print(model)model.summary(input_shape = (200,),input_dtype = torch.LongTensor)

训练模型

训练Pytorch通常需要用户编写自定义训练循环,训练循环的代码风格因人而异。

有3类典型的训练循环代码风格:

- 脚本形式训练循环;

- 函数形式训练循环;

- 类形式训练循环。

此处介绍一种类形式的训练循环。

我们仿照Keras定义了一个高阶的模型接口Model,实现 fit, validate,predict, summary 方法,相当于用户自定义高阶API。

# 准确率def accuracy(y_pred,y_true):y_pred = torch.where(y_pred>0.5,torch.ones_like(y_pred,dtype = torch.float32),torch.zeros_like(y_pred,dtype = torch.float32))acc = torch.mean(1-torch.abs(y_true-y_pred))return accmodel.compile(loss_func = nn.BCELoss(),optimizer= torch.optim.Adagrad(model.parameters(),lr = 0.02),metrics_dict={"accuracy":accuracy})

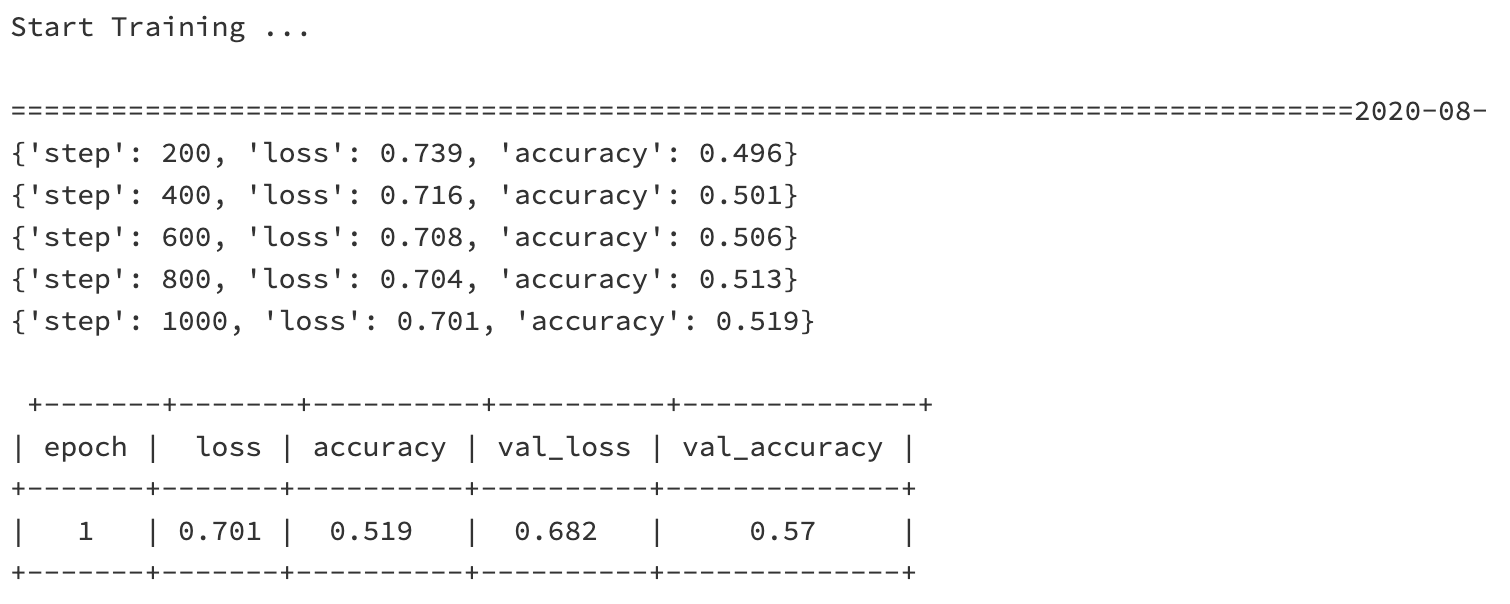

# 有时候模型训练过程中不收敛,需要多试几次dfhistory = model.fit(20,dl_train,dl_val=dl_test,log_step_freq= 200)

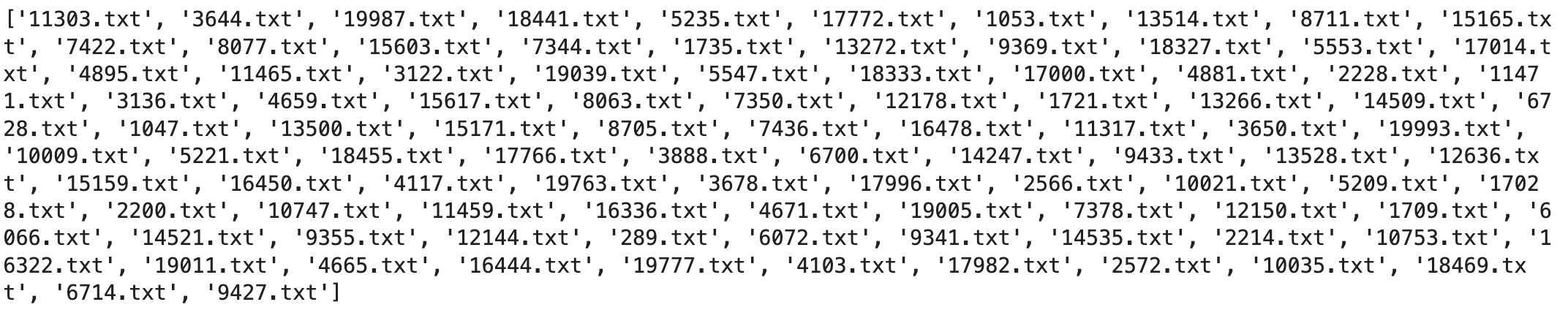

评估模型

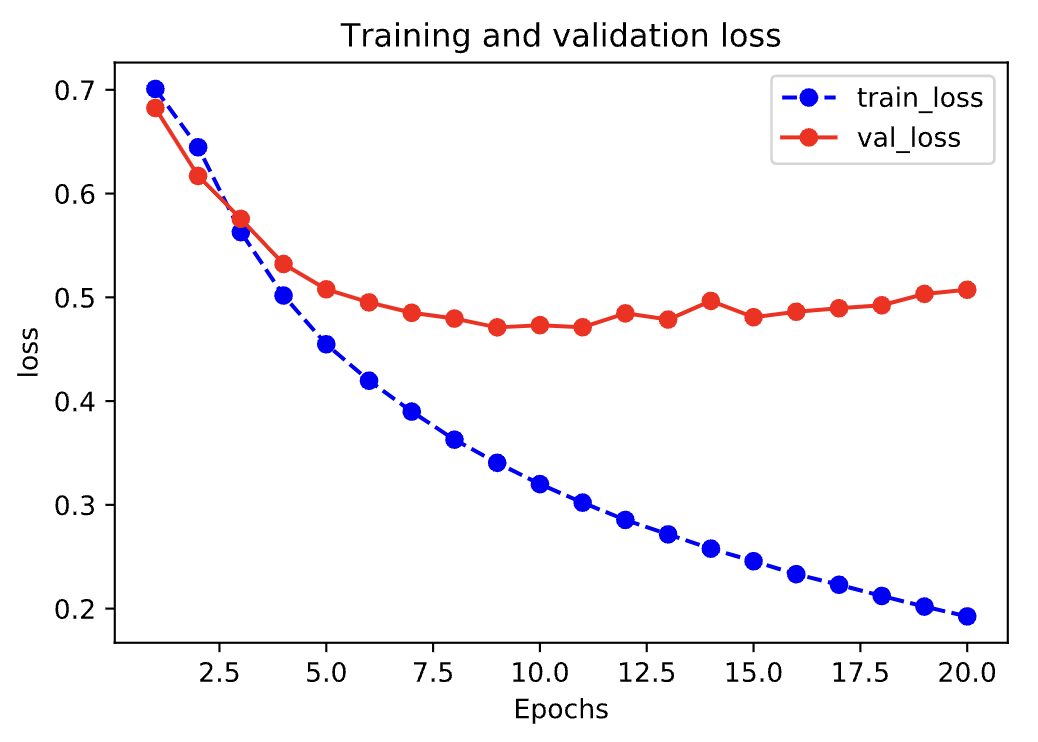

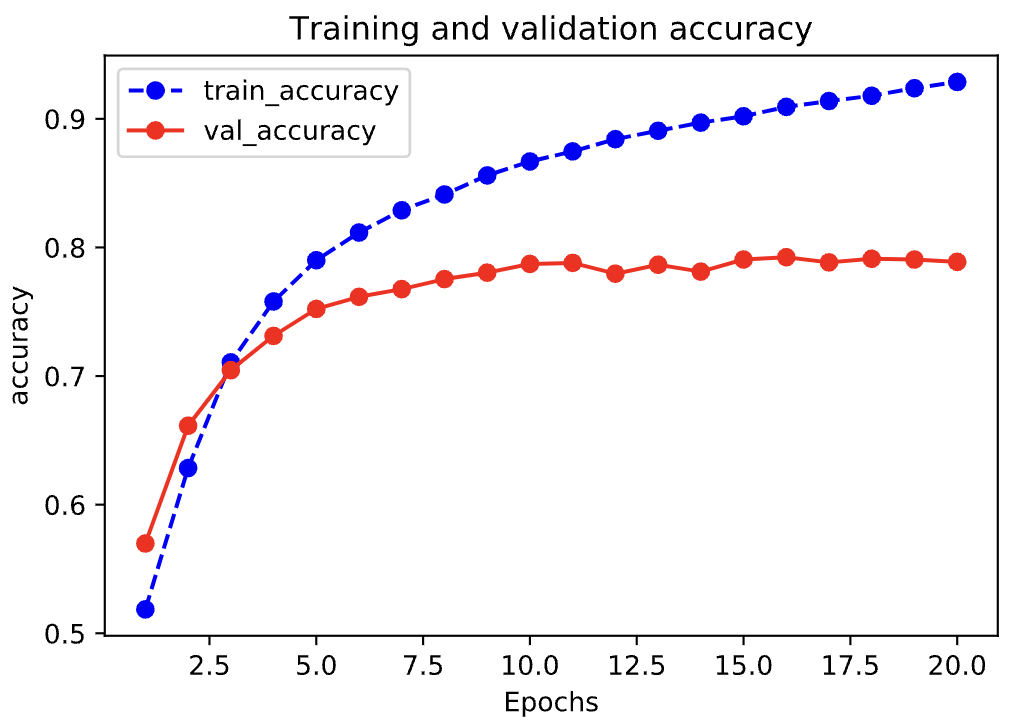

%matplotlib inline%config InlineBackend.figure_format = 'svg'import matplotlib.pyplot as pltdef plot_metric(dfhistory, metric):train_metrics = dfhistory[metric]val_metrics = dfhistory['val_'+metric]epochs = range(1, len(train_metrics) + 1)plt.plot(epochs, train_metrics, 'bo--')plt.plot(epochs, val_metrics, 'ro-')plt.title('Training and validation '+ metric)plt.xlabel("Epochs")plt.ylabel(metric)plt.legend(["train_"+metric, 'val_'+metric])plt.show()plot_metric(dfhistory,"loss")

plot_metric(dfhistory,"accuracy")

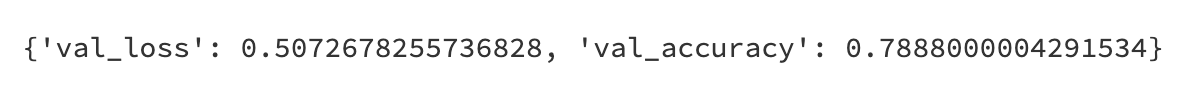

# 评估model.evaluate(dl_test)

使用模型

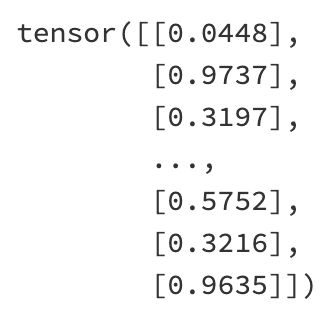

model.predict(dl_test)

保存模型

推荐使用保存参数方式保存Pytorch模型。

print(model.state_dict().keys())

# 保存模型参数torch.save(model.state_dict(), "./data/model_parameter.pkl")model_clone = Net()model_clone.load_state_dict(torch.load("./data/model_parameter.pkl"))model_clone.compile(loss_func = nn.BCELoss(),optimizer= torch.optim.Adagrad(model.parameters(),lr = 0.02),metrics_dict={"accuracy":accuracy})# 评估模型model_clone.evaluate(dl_test)