Title

EnlightenGAN: Deep Light Enhancement without Paired Supervision

代码:https://github.com/yueruchen/EnlightenGAN

Summary

在数据不成对的情况下,将光照信息作为attention权重,用global+local gan loss和改进的content loss实现图像增强。

Contribution(s)

- 非成对数据,用无监督方法训练,实现图像增强

- 提出了global-local判别器的结构

- self-regularization,包括特征保持损失(feature preserving loss)和self-regularized attention机制。

作者说self-regularization对文中的非监督情况下的模型非常重要Problem Statement

没有成对数据的情况下,获得较好的图像增强效果Method(s)

![[EnlightenGAN]EnlightenGAN: Deep Light Enhancement without Paired Supervision - 图1](/uploads/projects/grace-gu2@cv/2288a8713c917578b23961076c2bc598.png)

网络结构图还是挺清楚的,生成网络基于attention guided U-Net,判别网络用了双判别器分别判断全局和局部信息。Global-Local Discriminators

global和local判别器均使用patchGAN的结构(关于patchGAN之前有专门研究过)。

local discriminators则是从真实图像和生成图像中随机裁剪5个patch送入判别器.

全局判别器中,作者使用了relativistic discriminator loss。这个loss更看重真实图像和生成图像间的差距,简单来说相比标准GAN,训练更稳定。![[EnlightenGAN]EnlightenGAN: Deep Light Enhancement without Paired Supervision - 图2](/uploads/projects/grace-gu2@cv/7eb7e422f1f008af39ddd401d0a67af2.png)

xr:真实图像,xf:虚假图像,C:判别器,sigma:sigmoid函数。作者把这儿的sigmoid改成了LSGAN loss(最小二乘GAN)。

最后的discriminator loss为:![[EnlightenGAN]EnlightenGAN: Deep Light Enhancement without Paired Supervision - 图3](/uploads/projects/grace-gu2@cv/e04c3a14b79bf44a6f697e349f9b4194.png)

![[EnlightenGAN]EnlightenGAN: Deep Light Enhancement without Paired Supervision - 图4](/uploads/projects/grace-gu2@cv/bfc9e2c702da273d543b313b40218a9a.png)

Self Feature Preserving Loss

非监督训练中,保持细节非常重要。作者提出了self feature preserning loss,通过自我约束的方式保持图像增强前后的内容不变,其定义为:![[EnlightenGAN]EnlightenGAN: Deep Light Enhancement without Paired Supervision - 图5](/uploads/projects/grace-gu2@cv/2a2b50c914ac4cdef0928e4a82ba9d4d.png)

I^L: 输入图像,G(I^L):输出图像,将两者都送入VGG16网络算一个差距。i=5, j=1

说的花里胡哨就是就是vgg loss改了改。我看作者还解释了一下证明VGG对强度不敏感啥的,在16年的风格化经典paper《Image Style Transfer Using Convolutional Neural Networks》里已经讲的很透了,这儿没啥意思。

最后整个LOSS由四部分组成:![[EnlightenGAN]EnlightenGAN: Deep Light Enhancement without Paired Supervision - 图6](/uploads/projects/grace-gu2@cv/816f22d791c786c83f4d287e004f1067.png)

U-Net Generator Guided with Self-regularized Attention

从输入图像中提取光照通道I归一化到[0,1], 全长1-I作为self-regularized attention map。

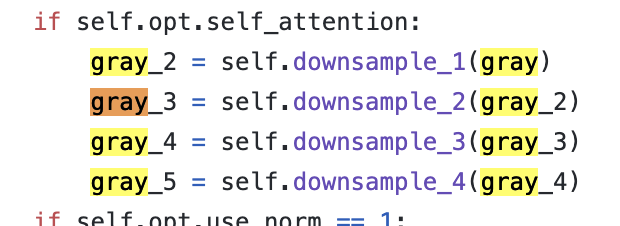

去看了下代码

作者相当于将光照信息(1-I)作为权重,实现了attention

Notes

之前遇到过的由deconv带来的生成图像上有网格形状,找到规范说法了:checkerboard artifacts 棋盘伪影

Criticism

作者的local discriminator是真-local,不像path gan里面对应的感受野。

能学到的点比较少。