王啸-图神经网络的两面性:特性与问题

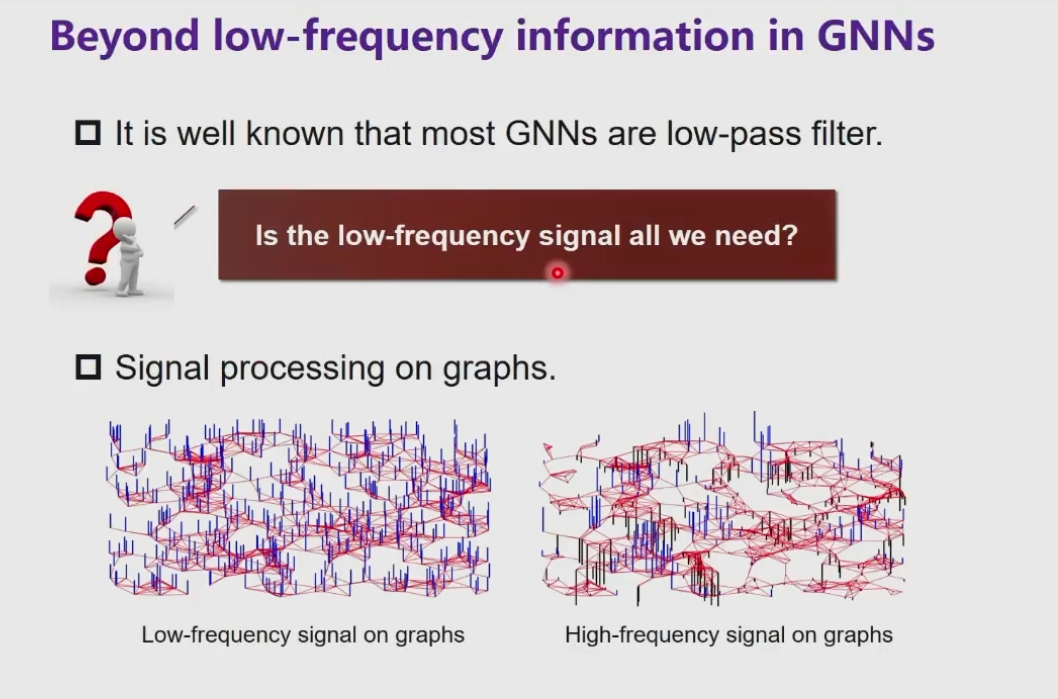

图卷积网络多层之后的表示(结点最后的embedding)刻画了结点的 低频 信息。高频的信息就过滤了。

低频信息:低频的信号,结点之间的共性。

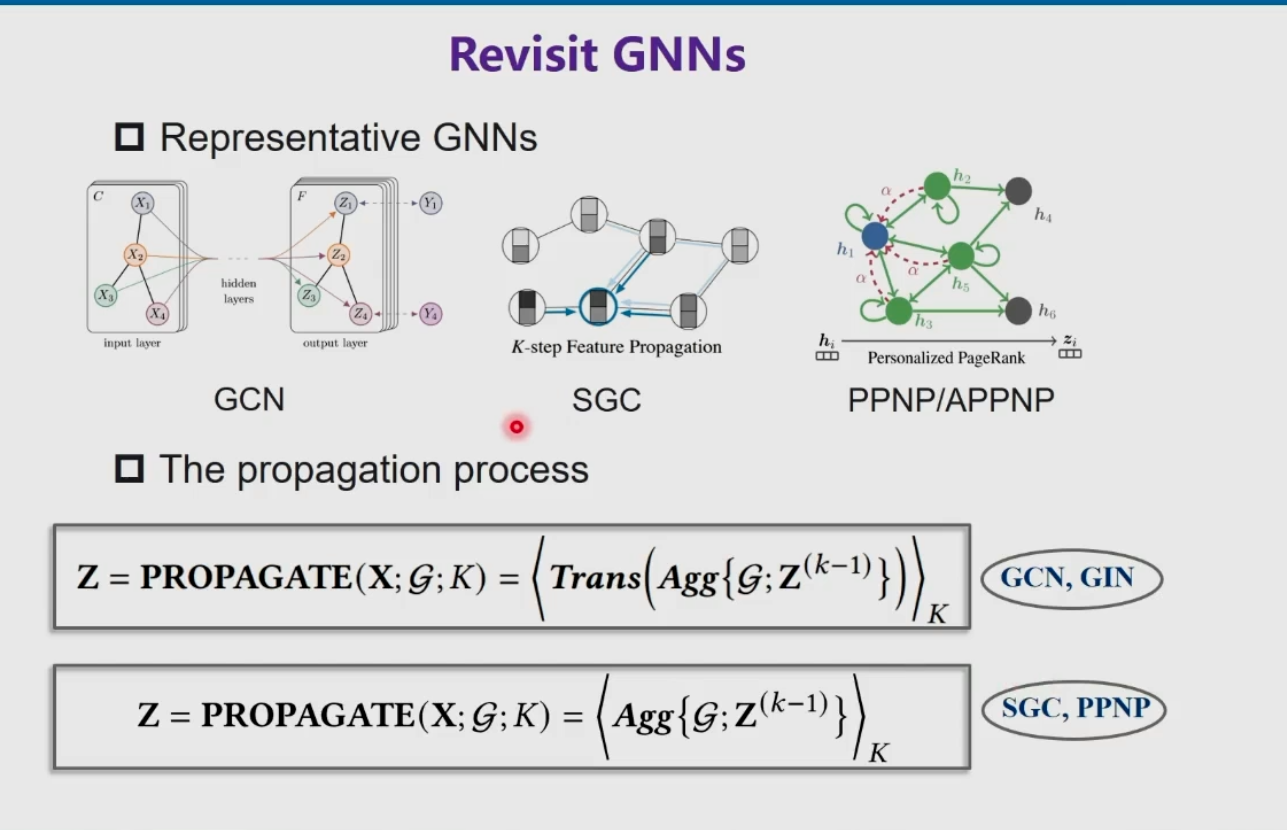

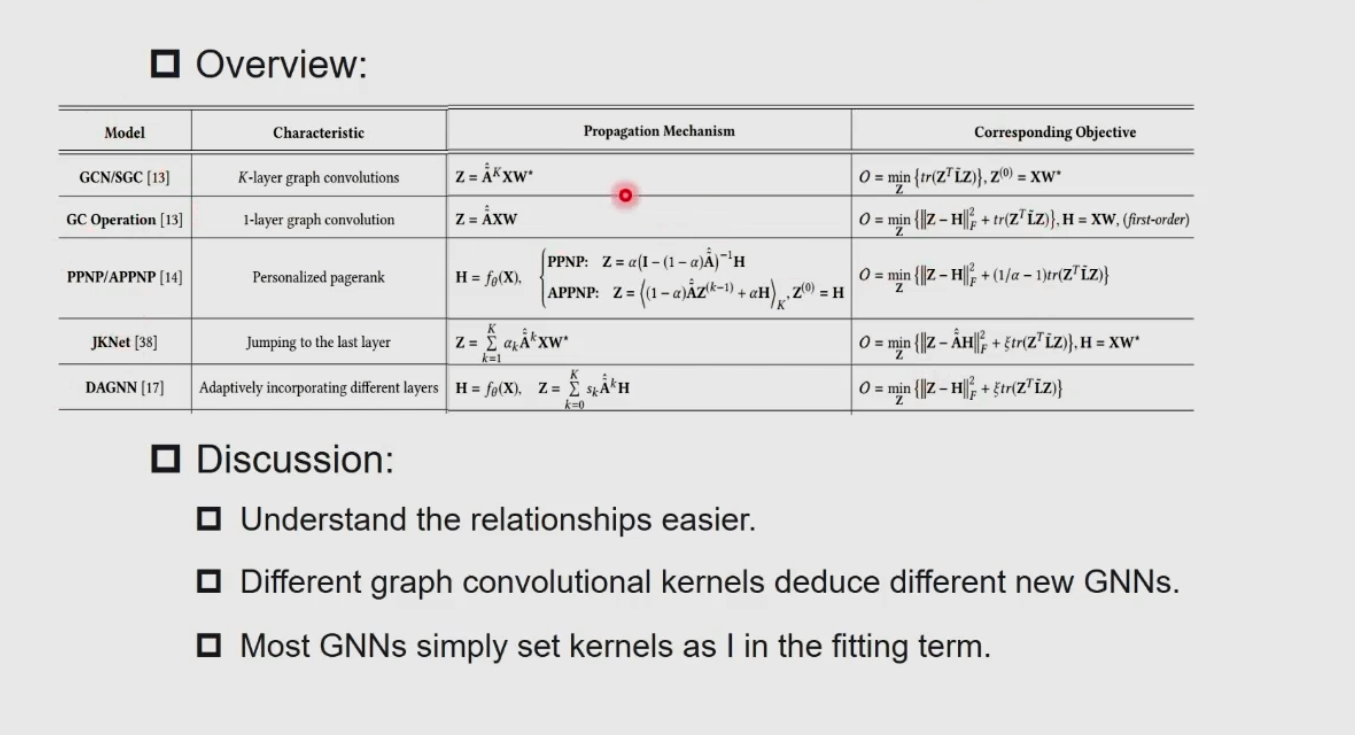

从这个消息传递框架,衍生出了许多框架。

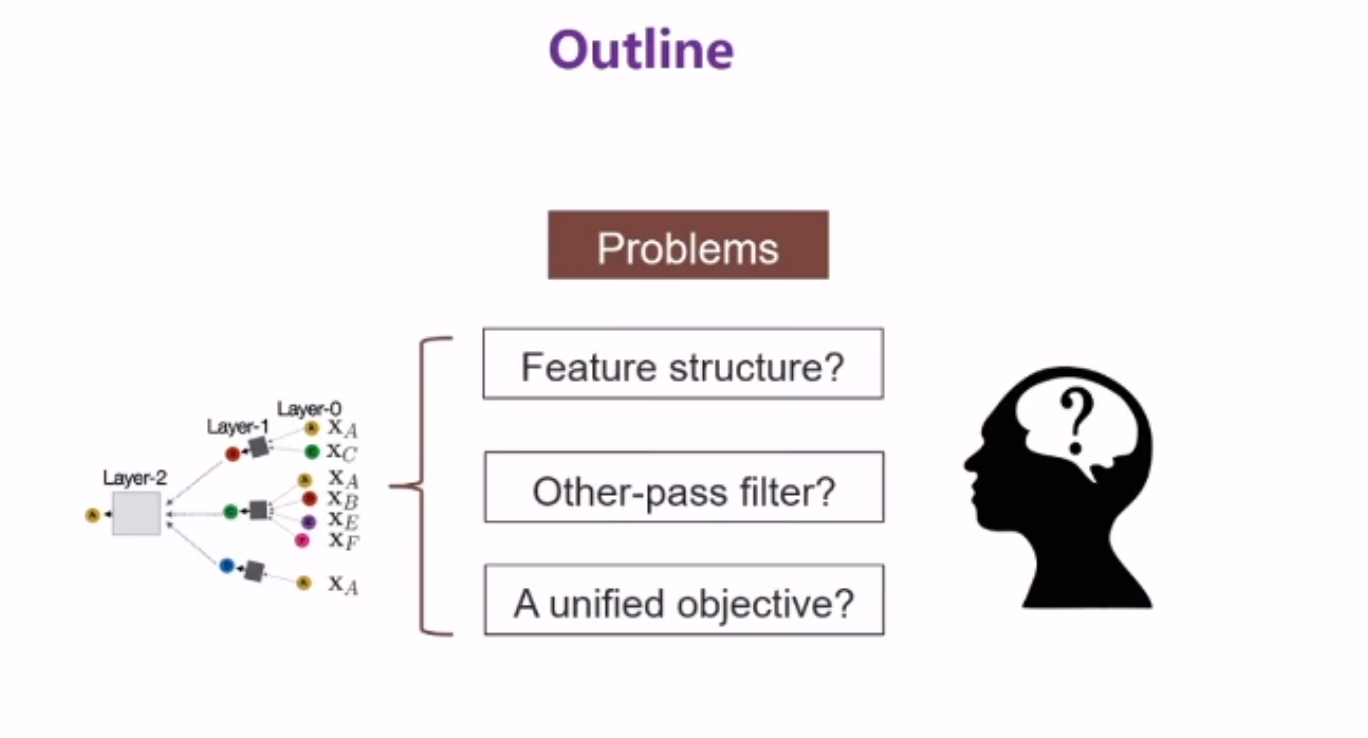

问题:

- 没有考虑到feature的结构;

- 低通滤波,其他信息是否有用,还是只是说是噪音,如果有用,要如何使用;

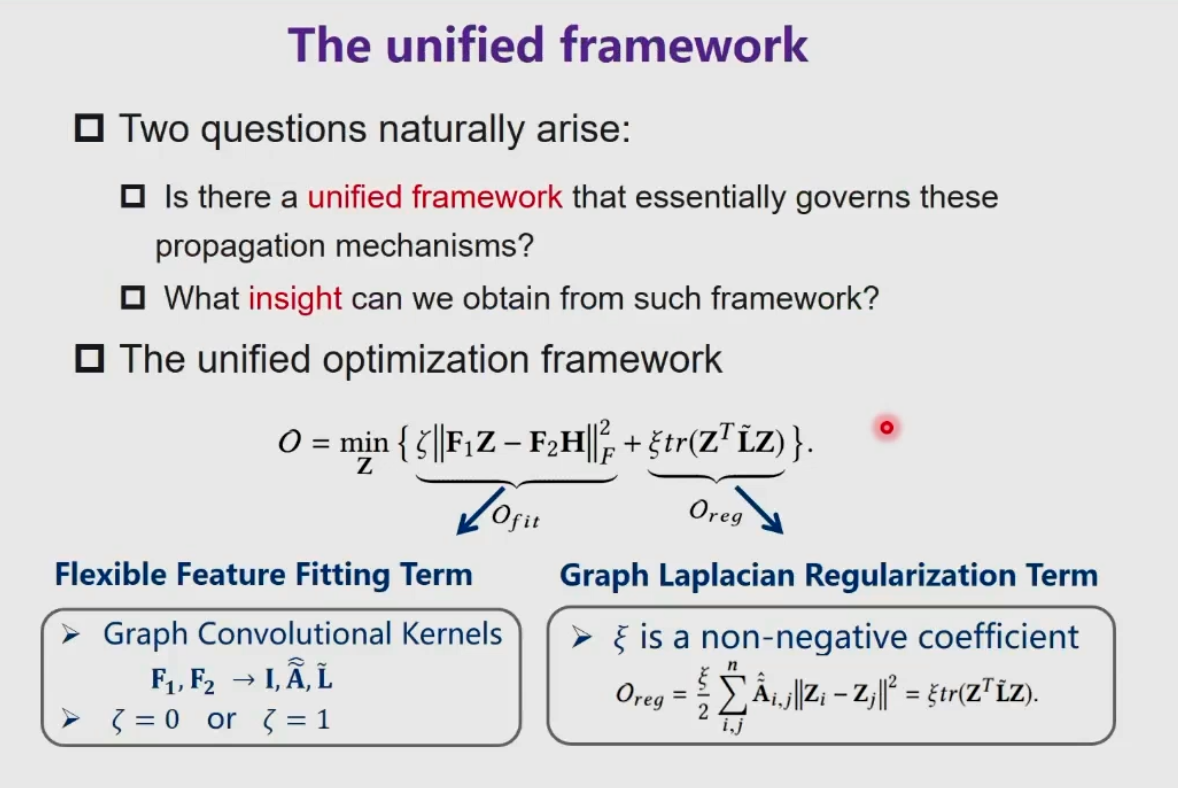

- 是否有统一的公式?

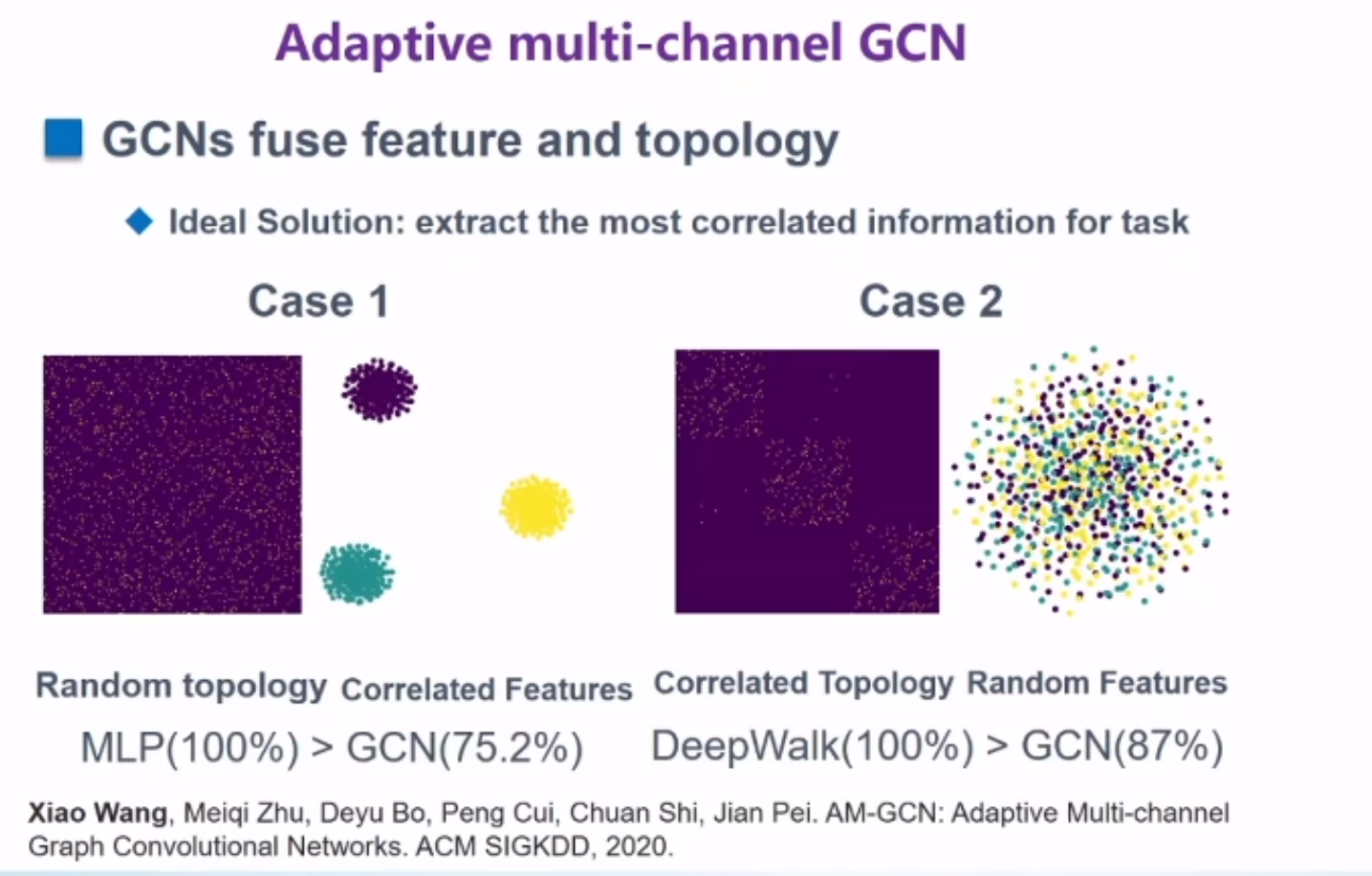

图神经网络本质上是融合了 拓扑和特征信息。

但是这种融合是否有用?有用意味着能为任务提取到最相关的信息。

以这两个case为例

case1:拓扑结构随机,features具有判别性。

GCN表现差。

结论:features判别性强,但是结构不行,会影响到性能

Feature Structure

AM-GCN

用KNN图构造feature Graph

最后得到2个特有的embedding和1个common 的embedding。然后用attention学习。自适应地学到和任务最相关的

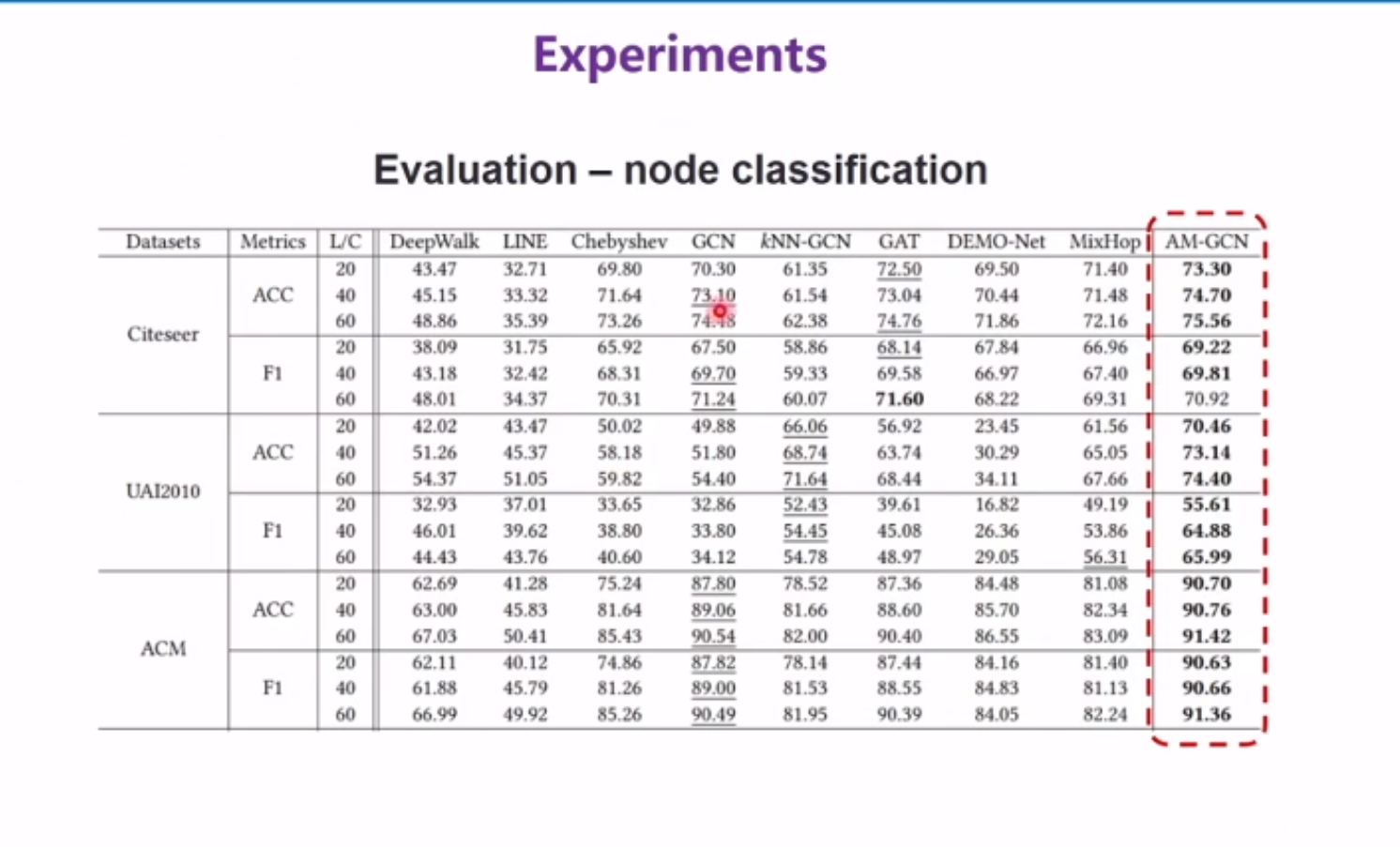

结果

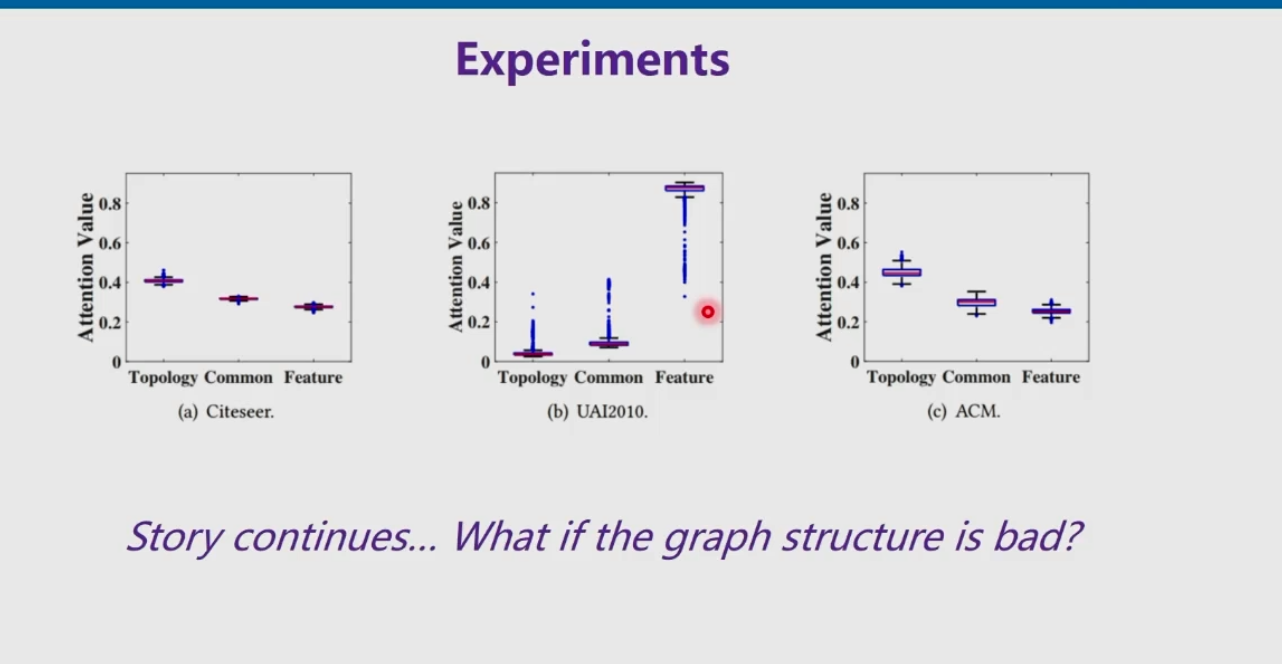

不同的数据集对拓扑,feature“敏感性”不同

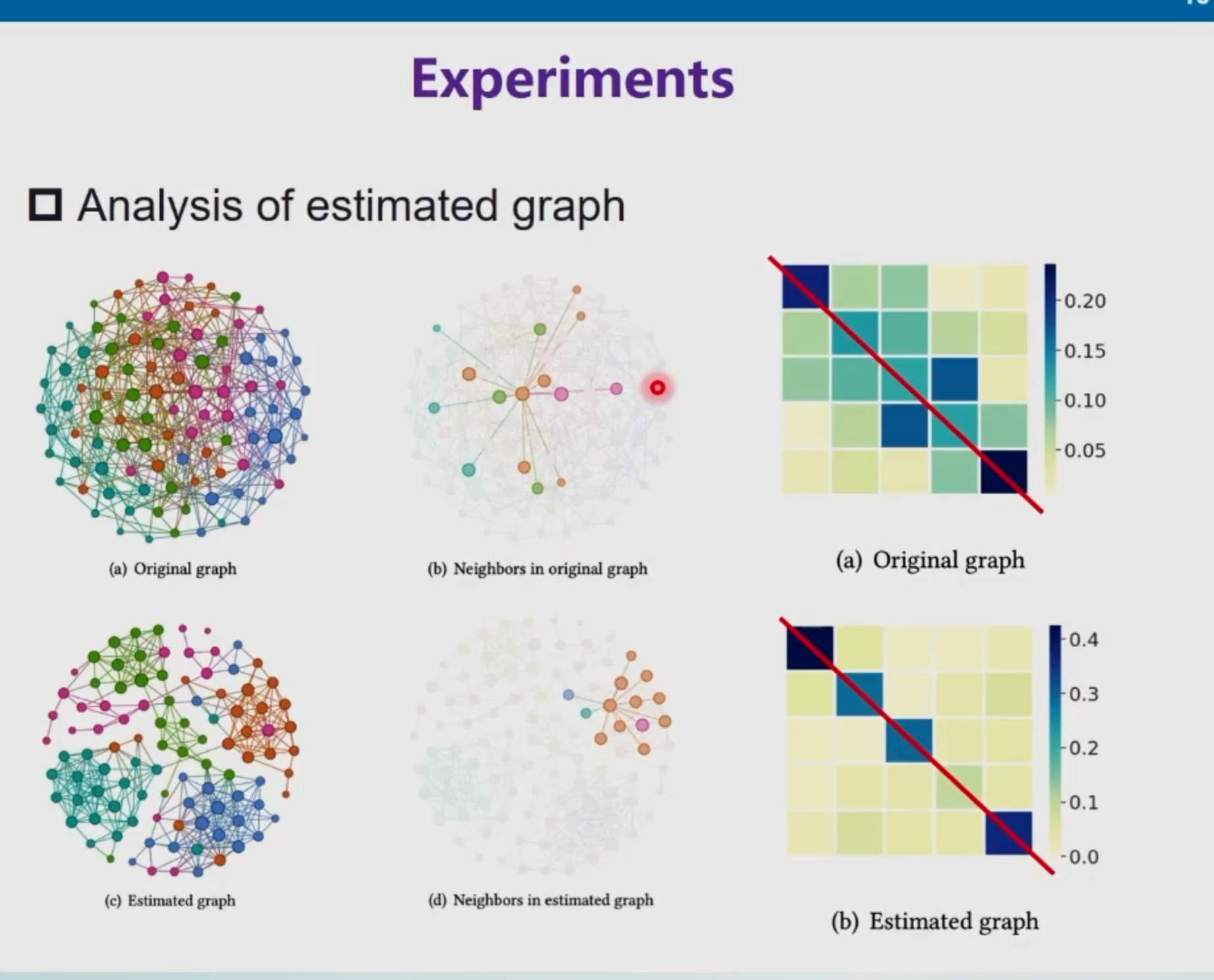

如果拓扑也是不好的呢?

Graph Structure Estimation Neural Networks

希望图神经网络能够学习到一个比较好的结构

预测某条边是否存在。如果多种度量下,这条边都出现了。那么这条边大概率存在。

先验信息,似然信息 →后验概率最大化

em算法?

先验信息:structure结构

观测信息(似然信息):从图神经网络的embedding学来的。一阶embedding,二阶embedding(聚合了1,2阶邻居)就代表了不同的观测角度

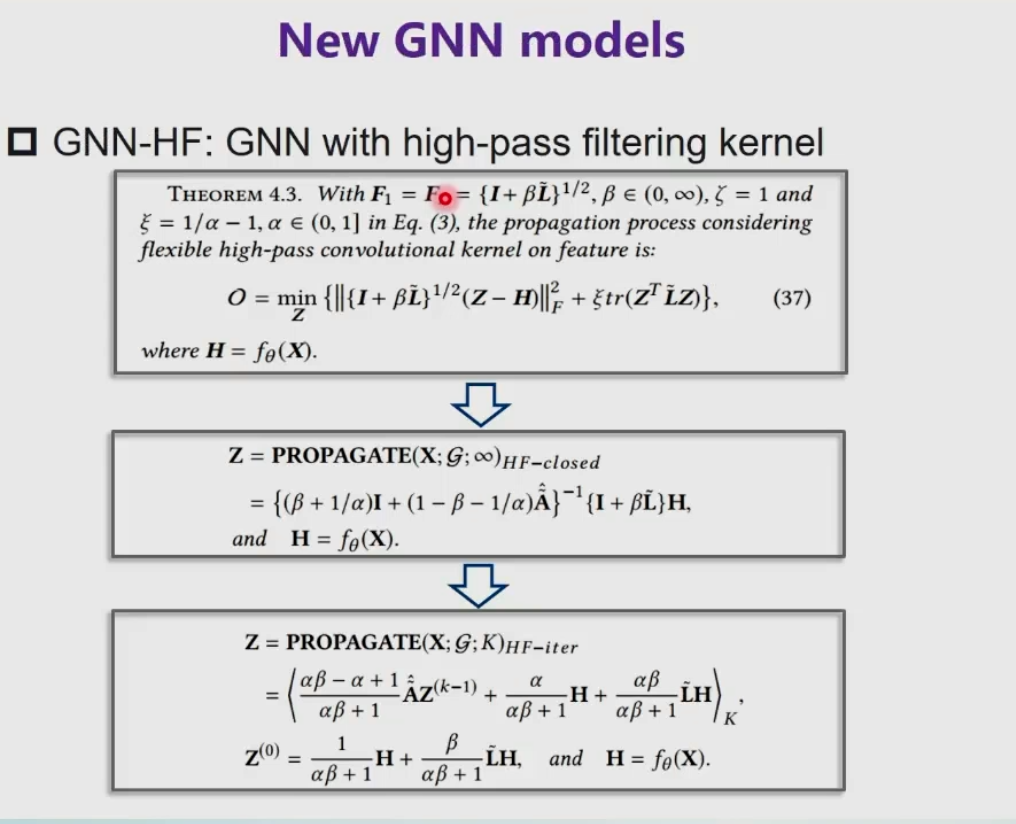

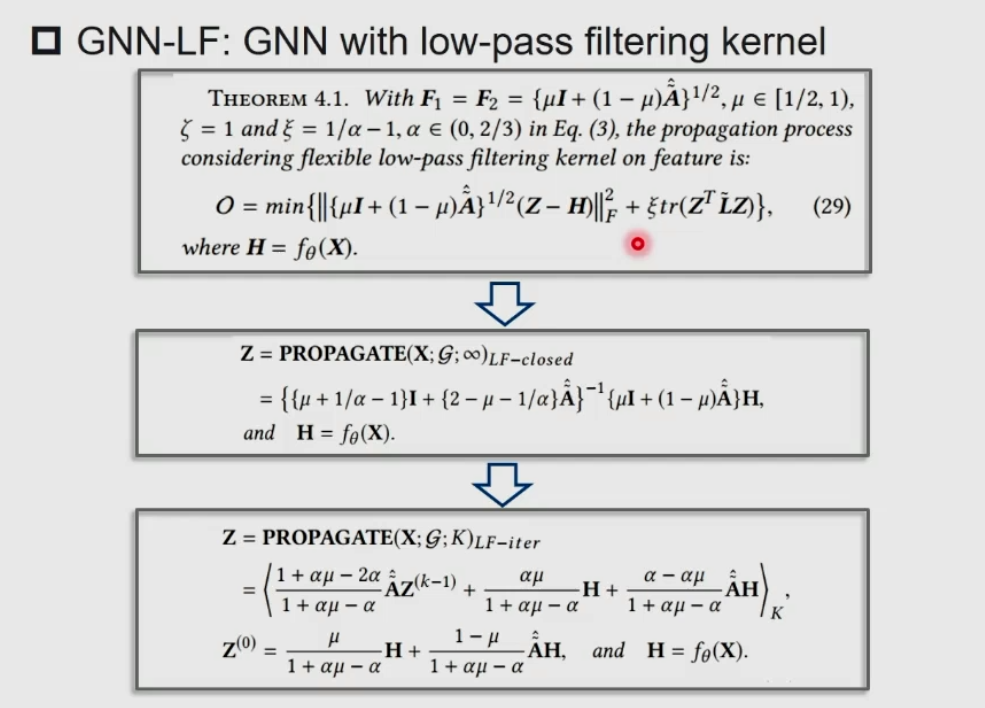

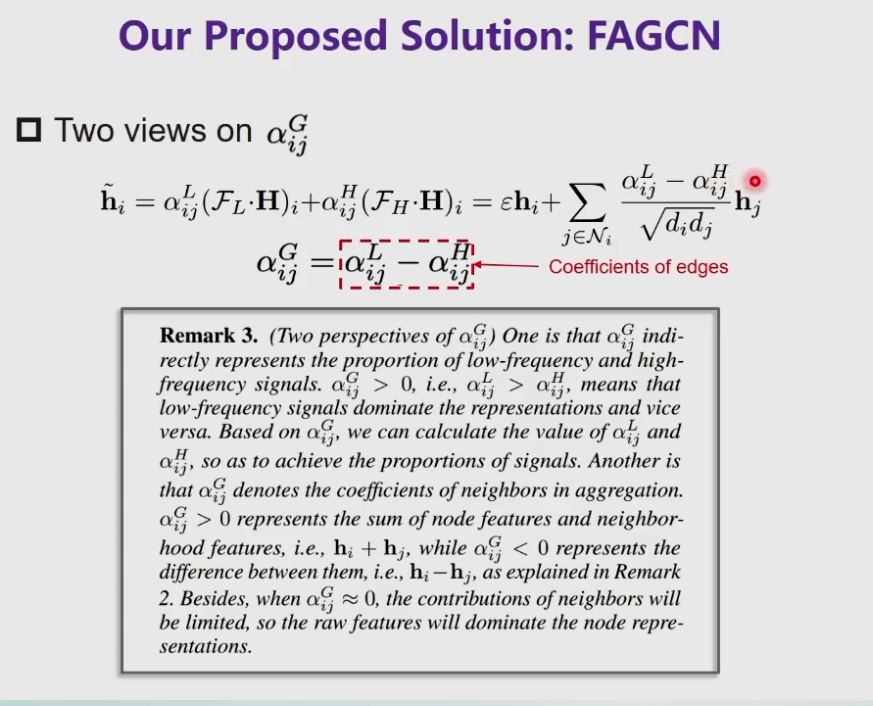

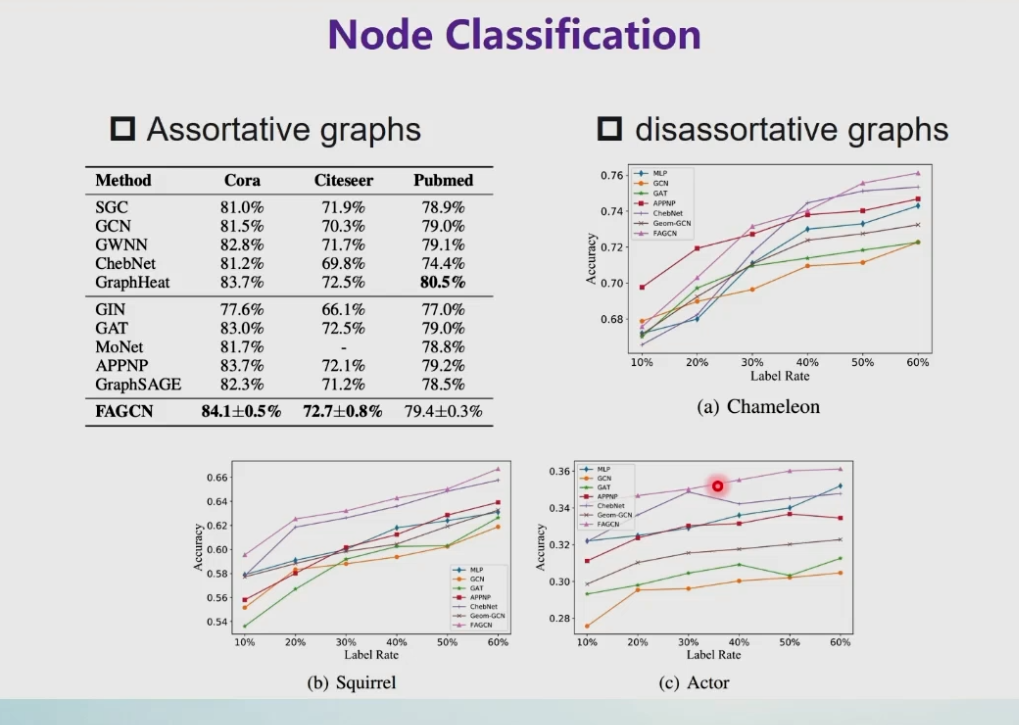

other-pass filter

大部分的GNN是一个低通滤波器

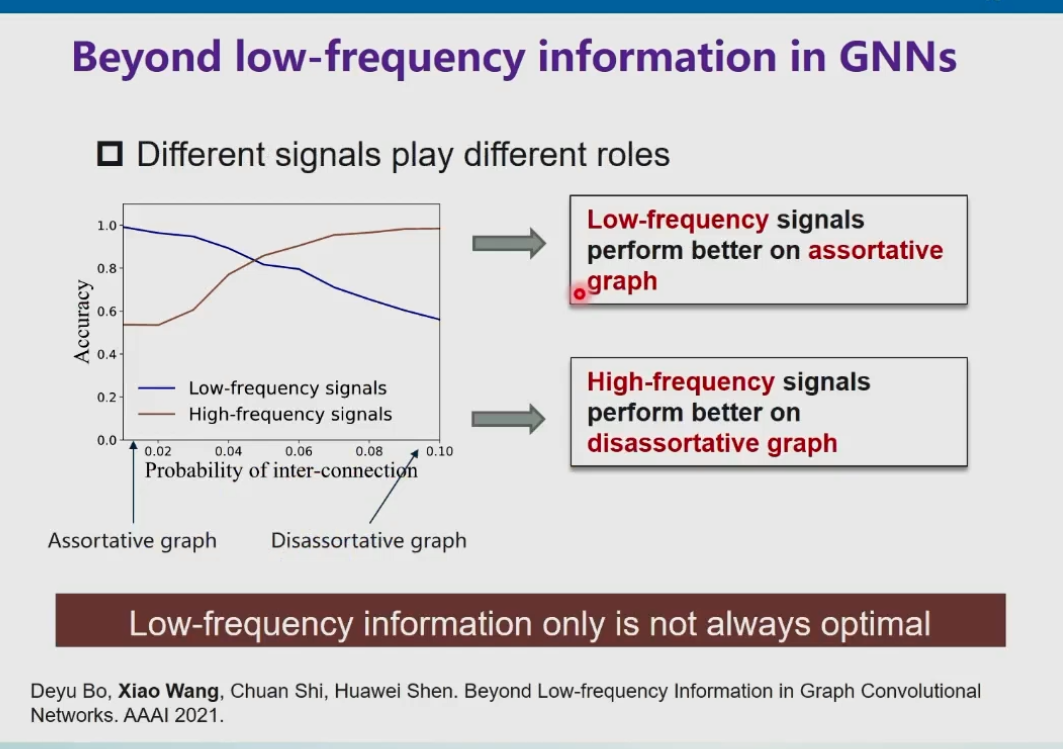

同配性图(和邻居比较相似)和异配性图(和邻居比较不相似)

希望图神经网络在 相似结点 之间 刻画低频信息,不相似结点 刻画 高频信息

自适应的信息提取

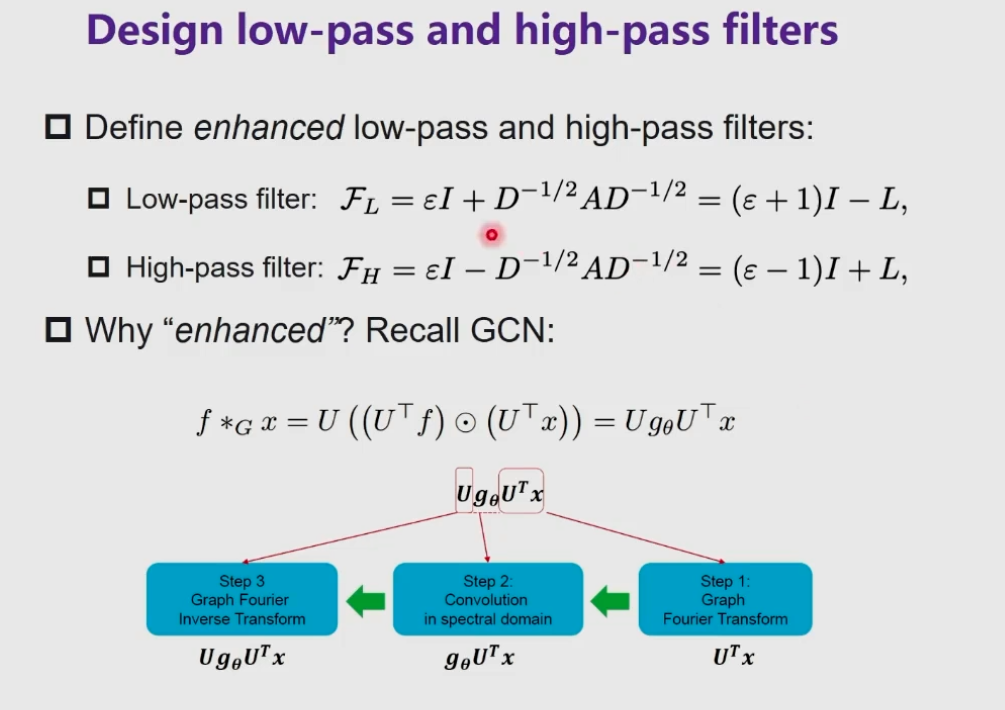

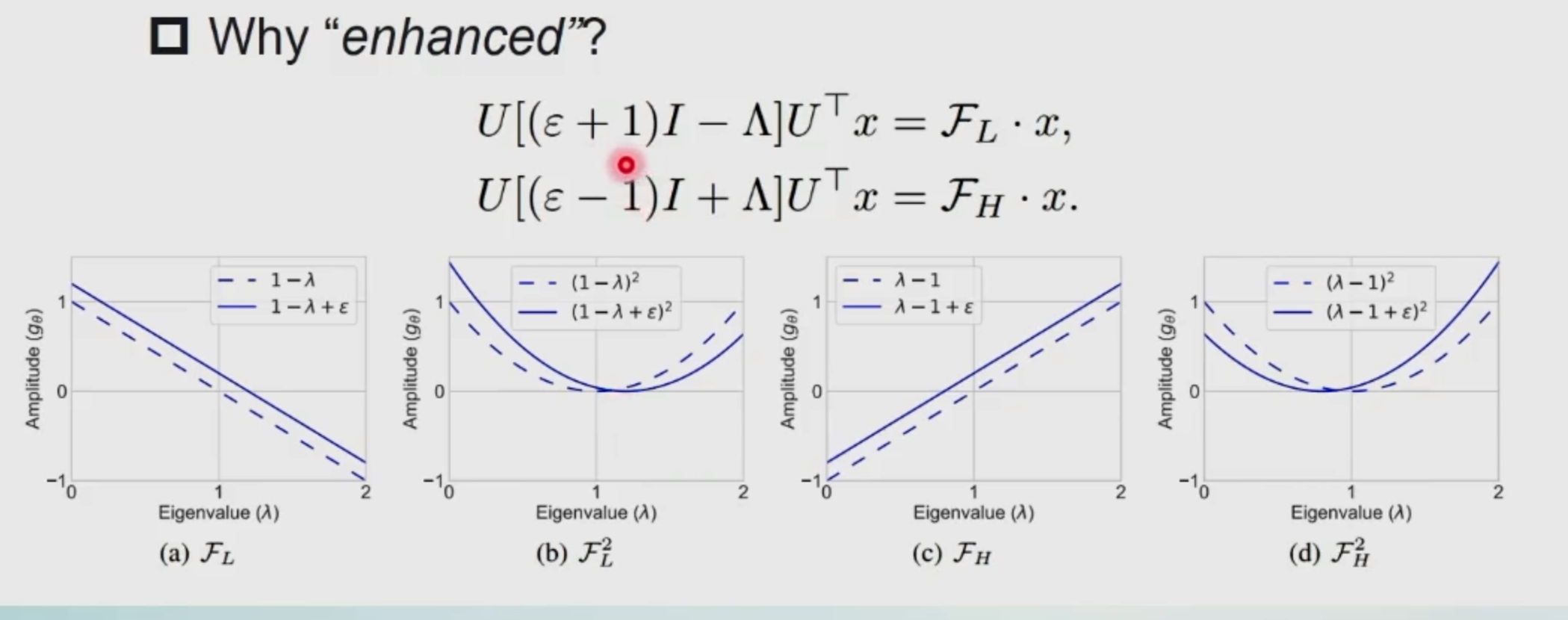

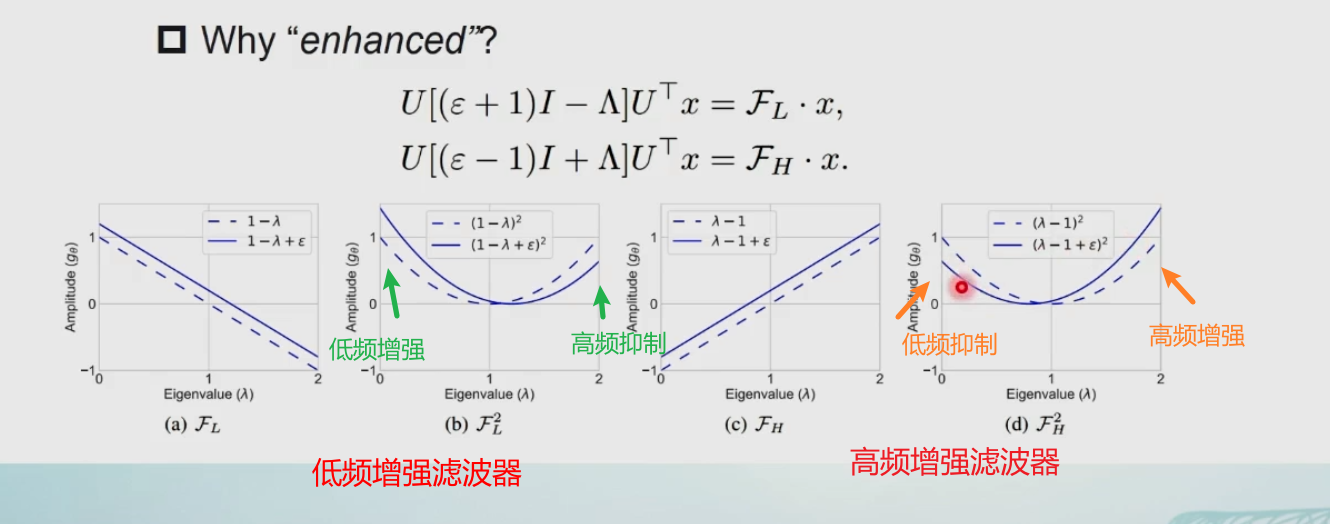

2个增强的滤波器。一个低通,一个高通

增强是相对于 原始的GCN

空域→谱域→变化(增强)函数 →空域

倒三角 是 特征值

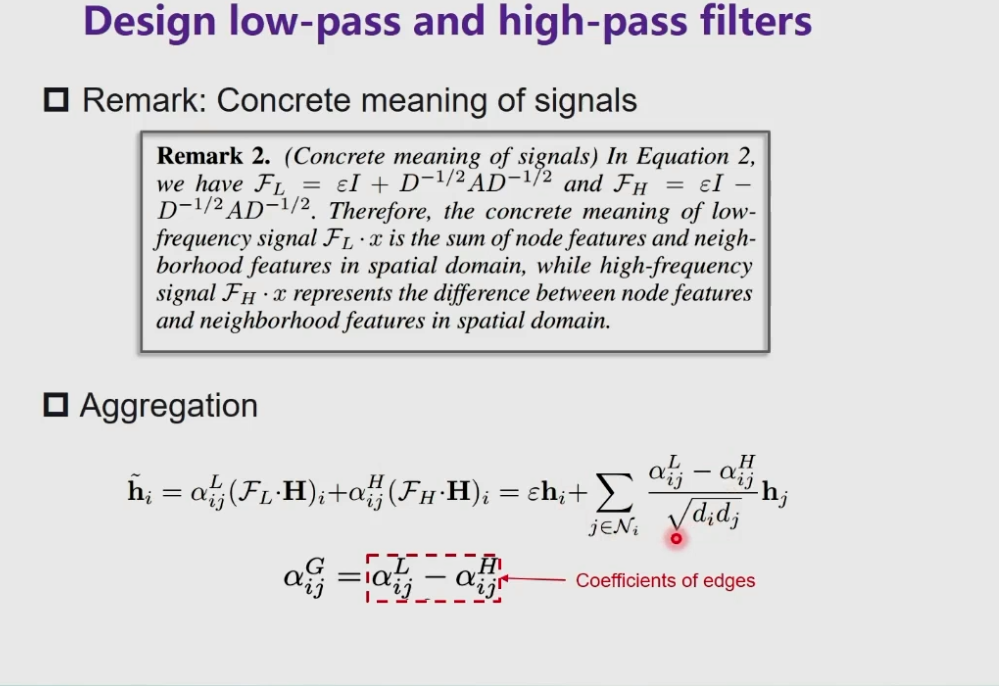

空域解释

低频 加号 自己的加上邻居的特征,不断融合

高频 减号 自己的减去邻居的特征(减去共性)。如果和邻居不相似,留下的就是差异的

最后用注意力机制结合起来

和图注意力机制区别:FAGCN 里的“注意力” 有正有负,也可以等于0。是更为广义的注意力

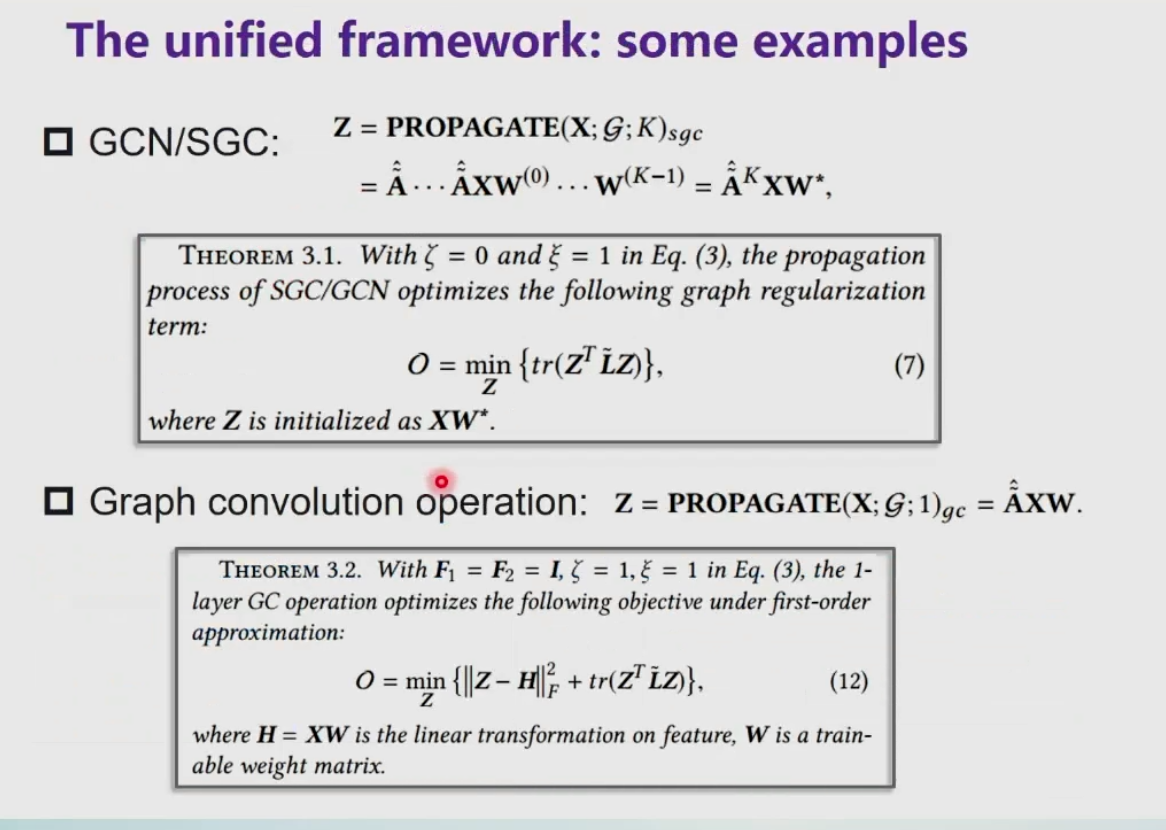

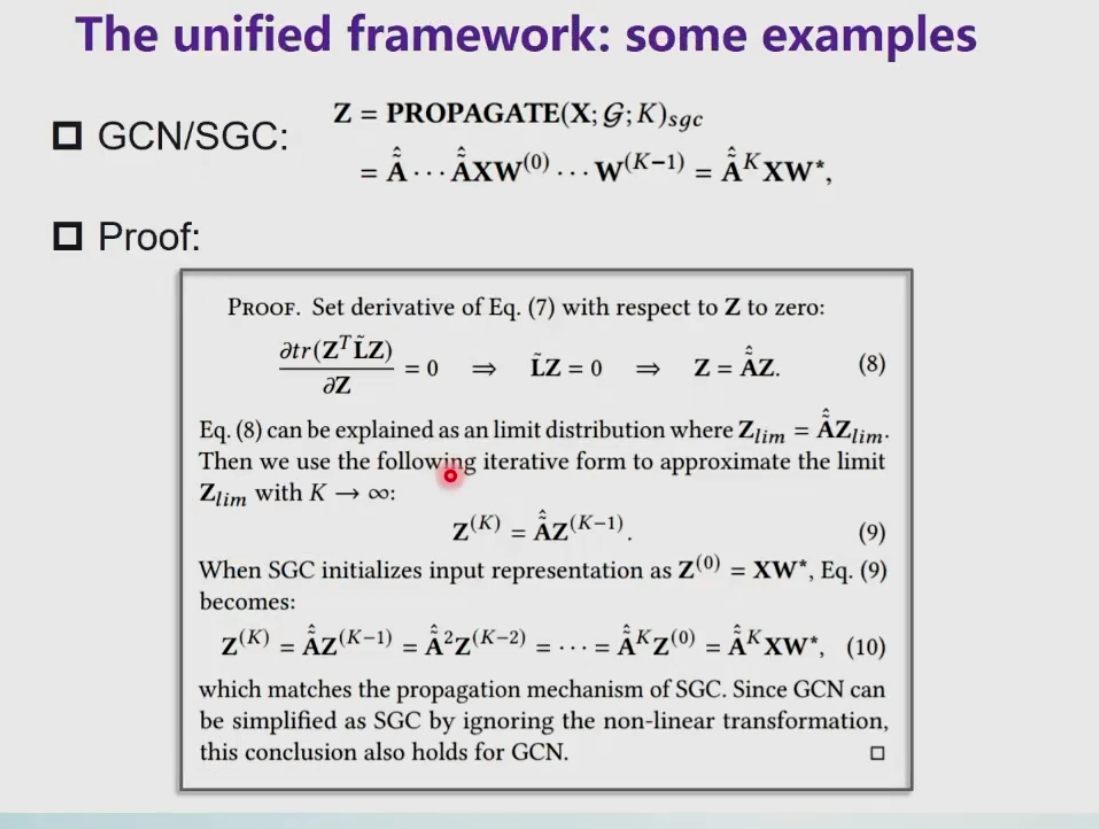

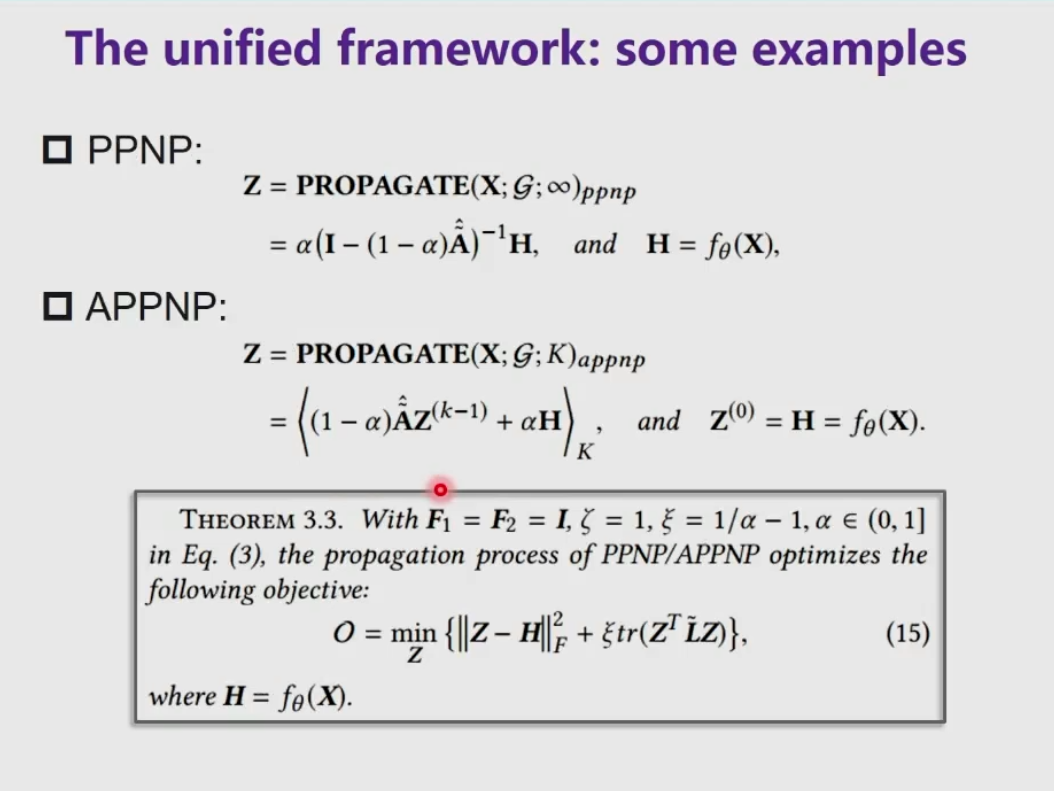

统一公式

总结