论文调研

第五篇:Improving Adversarial Robustness via Promoting Ensemble Diversity-ICML2019

标题:通过提升集合多样性来提高对抗鲁棒性

该paper探索了单一网络之间的交互,定义了集成多样性(ensemble diversity),并且采用了ADP正则器(Adapative Diversity Promoting regularizer)来鼓励多样性。

LINK:https://arxiv.org/pdf/1901.08846.pdf CODE:https://github.com/P2333/Adaptive-Diversity-Promoting

摘要:虽然通过模型集合的方式,深度神经网络在各种任务上取得了显著进展,但现有的高性能模型却很容易受到对抗样本攻击。许多研究聚焦于提高单个神经网络模型的鲁棒性和可靠性,然后直接构造一个模型集成策略,例如直接平均输出的方法,而忽略模型集成中各个子模型之间的相互作用。本文提出了一种新的方法来研究神经网络间的相互作用,以提高模型集成方法的鲁棒性。从技术上讲,我们将对抗环境下的集合多样性重新定义为单个网络模型的非最大预测之间的差异,并提出了一种自适应多样性促进(ADP)正则化器来提升多样性,这使得对抗样本很难在各个单独的网络模型之间迁移,从而使整个模型集成具有更好的鲁棒性。我们的方法计算效率高,并且兼容于单个网络模型的防御方法。在不同数据集上的实验结果表明,我们的方法可以有效提高对抗鲁棒性,同时在正常情况下能够保持领先准确性。

分类

一:简单集成神经网络-集成方法提高神经网络的对抗鲁棒性

Ensemble Methods as a Defense to Adversarial Perturbations Against Deep Neural Networks 2017. 【reject ICLR2018】被引:60 本文对集成神经网络对抗对抗样本的有效性进行了实证评价。 1.本文对现有文献的补充很少: 已经有关于“集体对抗训练”的详细研究 2.本文的实验评估仅限于 MNIST 和 CIFAR (这些数据集的结果不一定能很好地传递到更高维度的数据集,如 ImageNet)。 3.此外,评论者还指出了本文实验装置中的几个不足之处

WHY?

深度神经网络(DNNs)对对抗样本的脆弱性,需要防御策略。(应用需求)

我们建议使用集成方法作为对抗对抗扰动的防御策略。

WHAT?

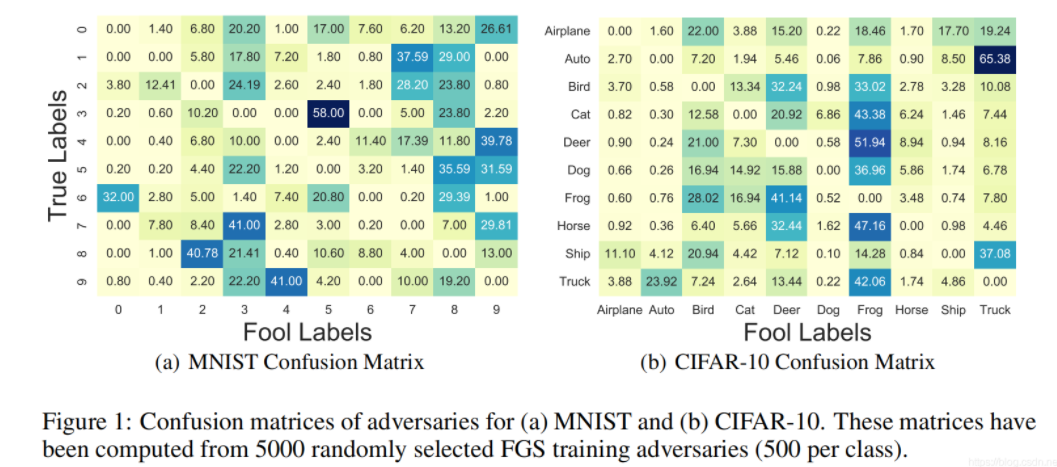

通过MNIST和CIFAR-10数据集上实验证明

集成神经网络不仅能够提高测试精度,而且能够提高分类器对对抗样本的鲁棒性

HOW?

1.攻击方法(1)FGSM(2)BIM

2.集成模型

(1)多个分类器具有相同的网络结构,但是具有不同的初始化权重;

(2)多个分类器具有相似的网络结构;

(3)bagging,即对训练数据集采样产生多个训练子集,分别在各个子集上训练分类器;

(4)对训练数据集添加高斯噪声。

3.计算梯度(1)使用第i个分类器的梯度(2)使用所有分类器梯度的平均(实验结果显示该方法更好)

4.实验所有实验都是10个分类器的集成。

RESULET?

5.结论:集成神经网络不仅能够提高测试精度,而且能够提高分类器对对抗样本的鲁棒性。

FUTURE?

将集成方法与其他防御机制(如对抗训练)相结合可以获得更鲁棒的分类器

二:集成SPECIALISTS-ICLR2017

ROBUSTNESS TO ADVERSARIAL EXAMPLES THROUGH AN ENSEMBLE OF SPECIALISTS https://arxiv.org/abs/1702.06856被引次数:67 本文认为对抗样本通常将神经网络的分类结果引导为一个类别子集中去,将分类结果分为若干子类集合,然后通过投票的方式去得到最终的结果,通过这种方式来抵御不确定性的发生。

WHY?

针对某些类型对抗训练存在各种问题

WHAT?

本文认为对抗样本通常将神经网络的分类结果引导为一个类别子集中去,将分类结果分为若干子类集合,然后通过投票的方式去得到最终的结果,通过这种方式来抵御不确定性的发生。

HOW?

1.利用FGSM方法得到模型的混淆矩阵:

根据混淆矩阵将数据分为2K+1个子集,在每个子集上训练分类器。

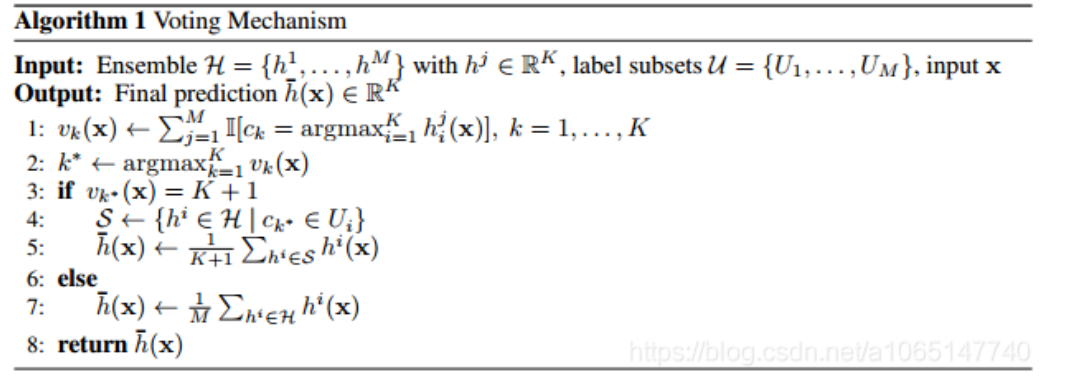

2.伪代码如下:

2k个专家子集和一个训练10分类的cnn ensemble

3.实验考虑三种模型

单个CNN,简单集成CNN,specialists +1,其中每个卷积网都是(32+32+64+全连接+softmax)。

RESULT?

specialists +1方法能够很好地区分对抗样本和干净样本,拒绝可疑的样本,从而提高对各种对抗样本的稳定性。

FUTURE?

我们将比较我们的方法与CNN明确(explicitly)训练,以稳健地应对特定类型的对手。

医学 分类 对抗 鲁棒(防御) 集成

三:多个弱防御的集成不能形成强防御-acm2017

参考文献:Adversarial Example Defenses: Ensembles of Weak Defenses are not Strong. .被引次数:226 https://arxiv.org/abs/1706.04701

WHY?

目前防御方法五花八门,却还没有强有力的防御来对抗对手。

我们问是否可以通过组合多个(可能是较弱的)防御来创建强大的防御。 为了解答进行研究。

WHAT?

研究了将多个防御要素组合在一起的三种防御措施 的防御效果:两种是最近提出的防御措施(设计原理是为什么它们的各个组件应该协同工作);另一种结合了不相关的新提出的探测器。

HOW?

1.攻击者

假设攻击者知道模型的各种信息,包括模型架构、参数、以及模型的防御策略(白盒攻击)。

考虑两种白盒攻击者:

(1)静态

不知道模型的防御策略,因此静态攻击者可以利用现有的方法生成对抗样本,但不针对特定的防御策略。

(2)动态

知道模型的防御策略,可以自适应地制定攻击方法,比静态攻击者更强大。

2.防御策略

(1)feature squeezing

包括两个检测组件:reducing the color depth to fewer bits 和spatially smoothing the pixels with a median filter

- 降低色深方法(color-depth-reduction defense,能够减少对大量像素的微小改动,是效果较弱的特征压缩方法)

- 空间平滑方法(spatial smoothing,能够减少对少量像素的大幅改动,是效果较弱的特征压缩方法)

- 降低色深和空间平滑这两者的组合(“combination of multiple squeezing techniques”,标题所指的“弱的防御方式的组合”)

(2)specialist+1 ensemble method

根据对抗混淆矩阵将数据集分成K+1个子集,形成由K+1个分类器组成的一个集成分类器

- 使用一组专用识别器,对分类后的图像再次检测攻击性;如果其中有识别器检测到其对应的攻击性特征,就可以通过对分类结果的置信度体现出来(“ensemble of specialists”)

(3)多个检测器集成

- 使用三种对抗性攻击检测器的组合(“ensemble of detectors”,三种检测器分别为Gong、Metzen和Feinman)。

其中(1)和(2)都是前人特意构造的由多个组件构成的防御策略,并且对于静态攻击的产生的低干扰对抗样本的防御效果很好。(3)是本文作者将现有的多个检测器集成起来的防御策略。

3.对抗样本生成方法

利用优化方法生成对抗样本,最小化如下损失函数:

其中c为超参数,该方法也称为CW攻击方法。

4.干扰大小的度量

用下式度量对抗样本与干净样本之间差异:

其中样本点都被归一化[0,1]之间。

5.实验

5.1 攻击 feature squeezing

结论:feature squeezing 不是一种有效的防御方法。首先单独用某种squeeze方法都仍然可以生成对抗样本对模型产生攻击,其次多种squeeze结合也会收到对抗样本的攻击。

5.2 攻击 ensemble of specialists

ensemble of specialists+1也不能保证对抗样本具有很低的分类置信度。

降低色深和空间平滑组合防御CIFAR-10图像(左),专用识别器防御MNIST图像(右) 可以直观地看到,2种防御方式的效果都非常有限,每一组中的第二行图片只有不大的改动,就已经可以导致分类器对样本的误判。由于MNIST图像比较简单,对于几种防御方式,对抗性处理带来的失真许多时候已经可以看得出来;但CIFAR-10的图像来说,能够骗过分类器的变化仍然都是人眼察觉不到的。

5.3 攻击多个检测器集成

在一定程度上会提高对抗样本与干净样本的距离,但是不是很显著。

RESULT

现有结果表明弱防御方式的组合并不能显著提高系统的鲁棒性

- 自适应的攻击方法可以设计出具有很小扰动的对抗样本来攻击这三种防御方法和其组件,因此对抗样本在各个防御组件之间具有迁移性。

- 在评价模型的防御效果时,应该考虑两方面:

- 评估防御能力的时候要想办法生成比较强的攻击图像,最好不要用FGSM这样图快的方法;

- 评估防御能力的时候最好用自适应的攻击图像生成器,这样对于攻击者知道防御手段的情况也能够提高安全性。

FUTURE

制定有效的防御措施来对抗对抗样本是一个重要的话题。 我们希望我们的工作为该领域的未来工作提供启发。

医学 分类 对抗 鲁棒(防御) 集成

四:随机自集成-eccv2018

Towards Robust Neural Networks via Random Self-ensemble 被引:160 https://arxiv.org/abs/1712.00673

WHY?

- 最近的几种防御方法不给力。

- 已知集成多个训练过模型可以提高鲁棒性,但会使模型大小增加k倍。

WHAT?

- 提出了随机自集成(RSE)方法:通过给神经网络中加入噪声层来使得神经网络对对抗干扰更加稳定。(该算法等价集成无穷个噪声模型,并且不会增加内存消耗)。

- 解释了为什么RSE可以显著提高对对抗攻击的鲁棒性。RSE等价于Lipschitz正则。

- RSE性能优越且易于实现(可以与任何神经网络相结合)。

HOW?

1.taget攻击与untarget攻击

对于攻击者:target攻击比untarget攻击更难;对于防御者,untarget攻击比target攻击更难。

2.网络设计

在每个卷积层前都加入噪声层:![[汇总]集成方法提高神经网络的对抗鲁棒性 - 图6](/uploads/projects/kaiba-20hbu@aev2fm/831b39353ffa954b914e1076a99e7f3a.png)

3.伪代码如下:![[汇总]集成方法提高神经网络的对抗鲁棒性 - 图7](/uploads/projects/kaiba-20hbu@aev2fm/9971a604269fc6b3a330029ec272ef47.png)

4.理论分析

RSE可以达到原来网络预测精度的原因是:在训练过程中相当于最小化测试误差的上界。

RSE等价于Lipschitz正则。

RESULT?

RSE可以提高神经网络的鲁棒性,对于十分强大的白盒攻击十分鲁棒。方法简单,可以嵌入到任何神经网络。

FUTURE?

no

医学 分类 对抗 鲁棒(防御) 集成

五:集成对抗训练: 攻击与防御-ICLR2018

Ensemble Adversarial Training: Attacks and Defenses 被引:1136 https://arxiv.org/abs/1705.07204

WHY?

利用快速一步生成对抗样本来进行对抗训练仍然受到黑盒攻击的威胁

WHAT?

提出了一种集成对抗训练的方法,它是利用其它模型产生的干扰来生成对抗样本

HOW?

1.前言

利用快速一步生成对抗样本来进行对抗训练仍然受到黑盒攻击的威胁,原因是这种形式的对抗训练会收敛到退化全局最小值,数据点附近的小曲率模糊了损失函数的线性近似。论文提出了一种集成对抗训练的方法,它是利用其它模型产生的干扰来生成对抗样本。在ImageNet上,集成对抗训练产生的模型对黑盒攻击表现出了强大的鲁棒性。

2.对抗训练

Mardry(2017)提出,对抗训练可以解释为一个给定的攻击在数据集上的最大化问题和最小化问题:

但是在本文实验中,采用Szegedy(2013)和GoodFellow(2014)提出的同时用干净样本和对抗样本来训练。

3.集成对抗训练

本文提出了一种简单的方法来解耦对抗样本的生成和模型的训练,同时可以明确地将黑盒攻击的鲁棒性联系起来。该方法称为“集成对抗训练”。用其它模型产生的对抗样本来训练。由于对抗样本具有迁移性,因此其它模型产生的对抗干扰近似上述目标函数中的最大化问题。最小化训练误差意味着增加模型对黑盒攻击的鲁棒性。

以前关于大规模对抗性训练的工作已经产生了令人鼓舞的结果,显示出对(单步)对抗性例子的强大鲁棒性。然而,这些结果具有误导性,因为对抗性训练的模型仍然容易受到简单的黑盒和白盒攻击。结果表明,对抗性训练可以通过将生成的对抗性实例与所训练的模型解耦而得到改善。通过对综合对抗训练的实验,证明了该方法的有效性。

参考

博客1

医学 分类 对抗 鲁棒(防御) 集成

六:对抗训练贝叶斯神经网络(adv-BNN)-ICLR 2019

ADV-BNN: IMPROVED ADVERSARIAL DEFENSE THROUGH ROBUST BAYESIAN NEURALNETWORK.2018. 被引:48 本文没有提出原创的方法,而是结合两种现有的方法进行了组合测试,取得了不错的效果。

WHY?

WHAT?

1.攻击方法

PGD

2.BNN

3.adv-BNN

我们将对抗训练(Mardry 2017)与BNN结合起来。![[汇总]集成方法提高神经网络的对抗鲁棒性 - 图8](/uploads/projects/kaiba-20hbu@aev2fm/9e2917fc4011af0a8885248c90315f03.png)

RESULT?**

FUTURE?

分割

一:集成各种分割网络-脑肿瘤分割的鲁棒

Ensembles of Multiple Models and Architectures for Robust Brain Tumour Segmentation MICCAL2017 被引:240 https://arxiv.org/abs/1711.01468 三个模型(DeepMedic、FCN、u-net)的代码开源,但是这个方法的整体不开源

WHY?

一个应用于脑部肿瘤分割的任务,由于不同的神经网络有不同的性能,表现很容易受不同的网络结构和不同的数据集影响。

WHAT?

采用多个神经网络集成,这样就减少了不同网络元参数(超参)的影响,和防止对一些特定数据集的过拟合。

HOW?

1.为什么选择集成模型

- 神经网络存在偏差和方差问题。

- 一个解决模型偏置和方差困境的方法就是集成(平均是最受欢迎的集成方式,它对单个不一致的错误不敏感)

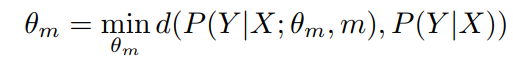

2.选择集成模型的数学推导(好发文章)

单个:

θ 表示的是各种超参,m表示的各种超参的选择,这个公式的意思就是在θ m和真实数据X的情况下,使得模型预测出的分布与真实分布P(Y|X)差距最小,这是普通的单个模型所做的事。

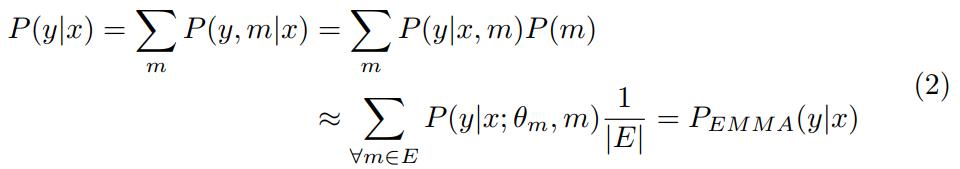

集成: (没有理解这个公式)

(没有理解这个公式)

这里是条件概率分布,意思就是在m存在的情况下y的分布,可以约等于下面这个公式,E表示的是各种模型![[汇总]集成方法提高神经网络的对抗鲁棒性 - 图11](/uploads/projects/kaiba-20hbu@aev2fm/f704f38c457a535e012d567f3db916bb.png)

图2:我们的EMMA(红,集成了不同的网络),对各个模型配置m所注入的偏差进行平均,以更可靠地近似真实后验(黑),同时对次优配置具有鲁棒性。 左侧的后验者是从多个感知器获得的,经过训练后将以10和-10为中心的聚类分类为一个示例,训练标签中具有不同的损失,正则化和噪声。 它们的集成提供了可靠的估计。

3.集成使用的网络结构:

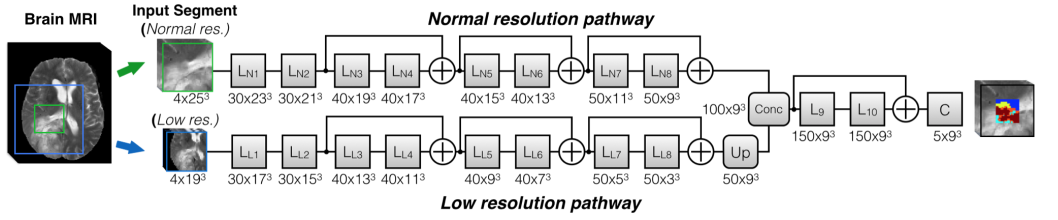

DeepMedic:

3D多尺度cnn,两个版本,一个是基于残差块的,一个是加宽网络宽度:

图3:我们在实验中使用了两个DeepMedics [13]。 描绘了两者中较小的一个,其中特征图的数量及其在每一层的尺寸以格式(Num×Size)描绘。 集成中使用的第二个模型更宽,每层的特征图数量增加了一倍。所有内核和特征图都是3D的(为简单起见没有描述)

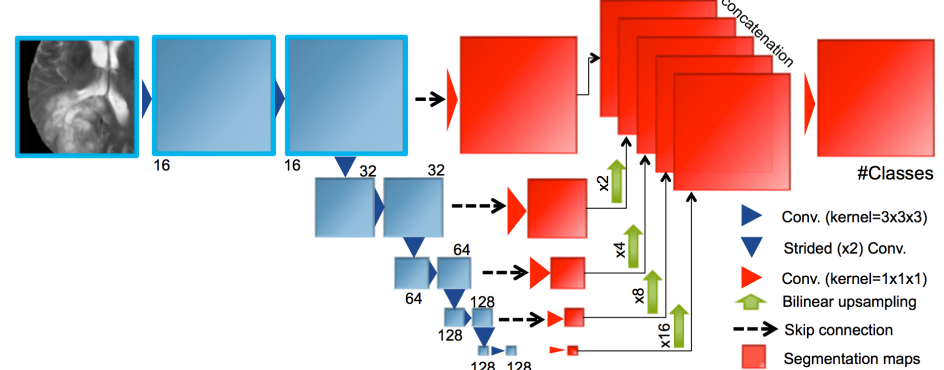

FCN:

图4:所有内核和特征图都是3D的(为简单起见没有描述)

使用了3个3D的FCN,所有的都使用了BN,relu,和0填充

- 第一个结构如上图4所示,IoU loss,64size的块

- 第二个用两个卷积的残差块代替了普通的卷积块,Dice-loss,80size的块

- 第三个也是基于残差块的,但是少了一个下采样步骤。Dice-loss,80size的块

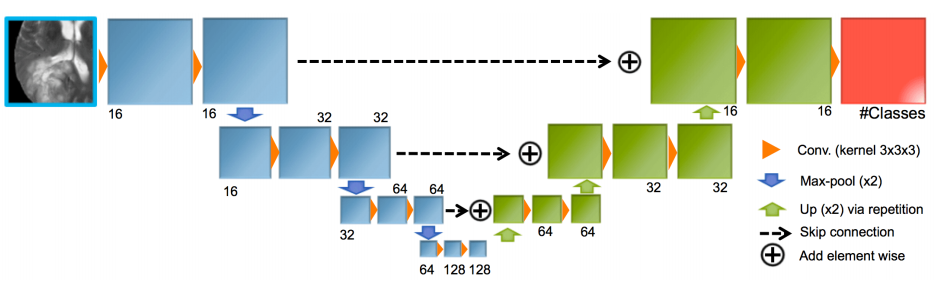

U-net:

**

图5:在我们的实验中使用的改编Unet的示意图。 描述了每层特征地图的数量。 所有内核和特征图都是3D的(为简单起见并未进行描述)

使用了两个版本的U-net,采用64x64x64的块,四个标签取的块的数量相等,使用Relu,0pad和BN

- 第一个使用的相加模块,而不是传统的concate,使用[25]减少复杂性,AdaDelta学习率策略

- 第二个使用了concate,并且用带步长的卷积取代了空间池化,Adam学习率策略

4.如何集成:

- 分开训练,

- 分别测试,然后算出置信度图(在这里的置信图指的是什么?)

- 再像上面公式2那样创造一个平均置信度,得出某一个体素属于哪一类,

RESULT?

在Brats2017上得到了第一名的位置,共50位参赛者。

**

通过对组件的次优配置具有鲁棒性,EMMA可以在不同任务上提供可重用性,我们打算在将来进行探索。

EMMA还可以用于无偏见地研究诸如CNN对域迁移的不同来源的敏感性等因素,这些因素对大规模研究有很大影响[30],或者估计一项任务所需的训练数据量。 最后,EMMA的不确定性可以更客观地衡量哪种类型的患者或肿瘤最难以学习。

医学 分割 对抗 鲁棒(防御) 集成

参考

博客1

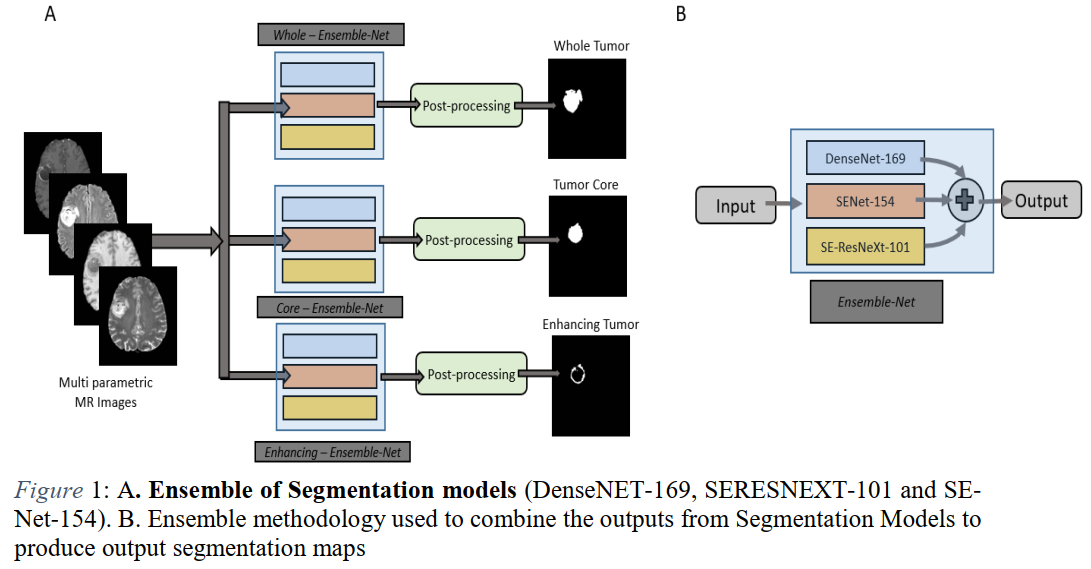

二:集成各种分割网络-脑肿瘤分割

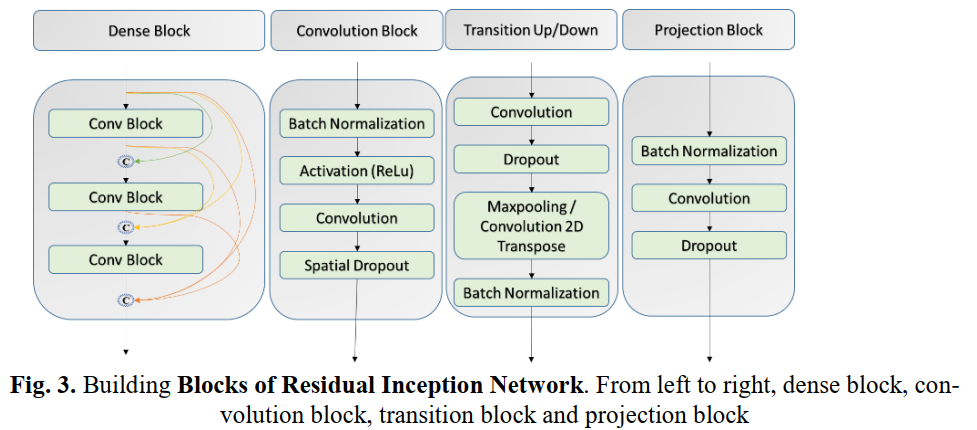

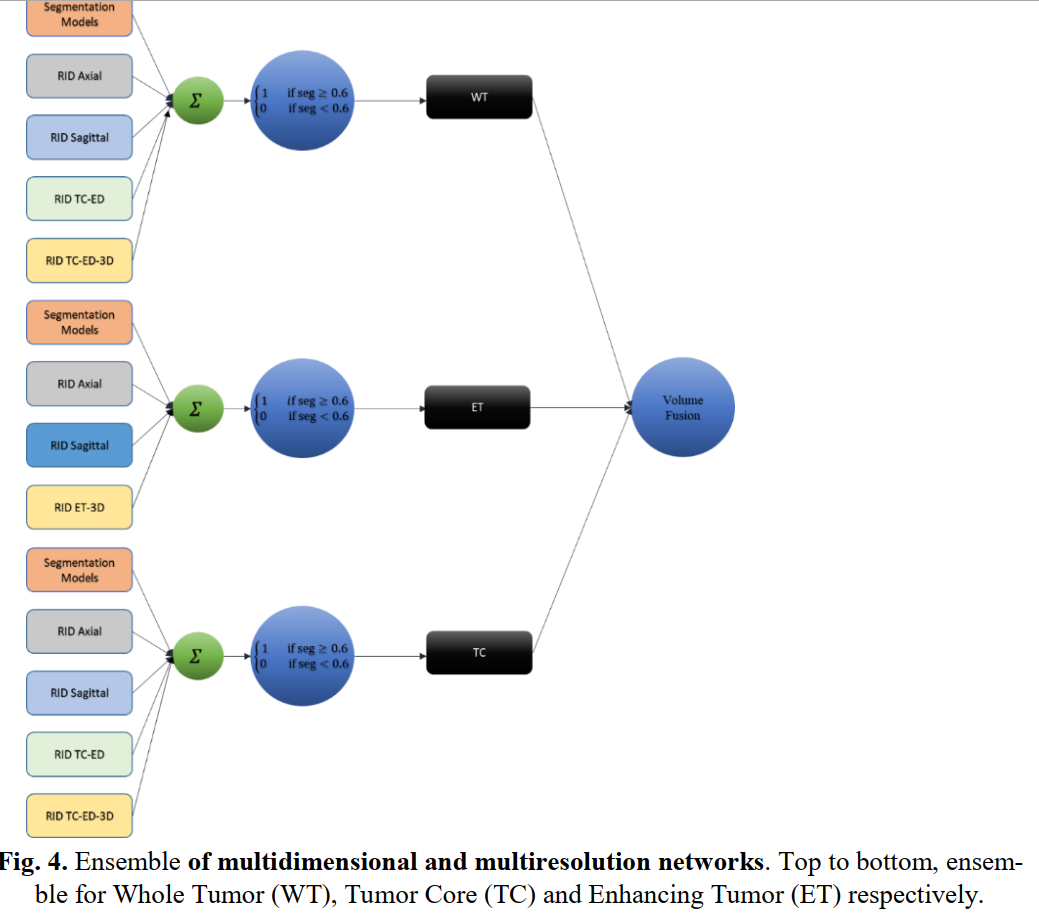

Multidimensional and Multiresolution Ensemble Networks for Brain Tumor Segmentation MICCAL2019 被引:3 脑肿瘤相关的概念

WHY?

MRI分割脑肿瘤仍是一项艰巨的任务。

开发针对脑肿瘤的自动化,半自动化和交互式分割方法具有巨大的临床意义

WHAT?

我们建议对多分辨率和多维模型的输出进行集成以获得鲁棒的肿瘤分割。

- 利用现成的模型架构(DensNET-169,SERESNEXT-101和SENet-154)使用2D输入进行分割。

- 还实现了二维和三维残差起始Densenet(RID)网络,以基于补丁的输入(64x64和64x64x64)执行肿瘤分割。

HOW?

数据集:

Brats 2019数据集

网络架构:

训练了几种模型来产生鲁棒的肿瘤子成分分割。

RESULT?

BRATS 2019验证数据集的初步结果证明了该方法可以实现出色的性能

FUTURE?

no

医学 分割 对抗 鲁棒(防御) 集成

三:网络中不同组成部分的集成学习-不平衡医学图像语义分割

Conditional Generative Refinement Adversarial Networks for Unbalanced Medical Image Semantic Segmentation-2018 被引:14

WHY?

用不平衡数据训练的模型在临床应用中并不理想

数据不平衡:医学图像语义分割中大部分像素属于健康区域,小部分像素属于病变或非健康区域

WHAT?

提出了一种新的条件生成式精化网络,它包含三个组成部分:生成式、判别式和精化网络,通过集成学习来缓解数据不平衡问题。

HOW?![[汇总]集成方法提高神经网络的对抗鲁棒性 - 图18](/uploads/projects/kaiba-20hbu@aev2fm/6107395bb880c10c23578ab02a65c7da.png)

RESULT?

进行了三个实验

- 异质性脑肿瘤分割

- 肝和病变同时分割

- 微观细胞分割

在显微细胞分割、肝损伤分割、脑肿瘤分割和肝脏分割方面显示了出色的结果。

FUTURE?

计划研究当前网络在学习多种临床任务(如疾病分类和语义细分)方面的潜力

医学 分割 对抗 鲁棒(防御) 集成

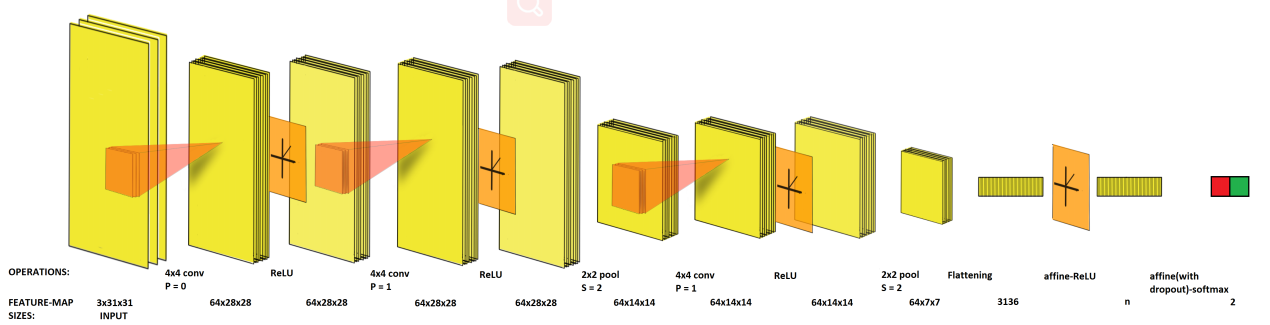

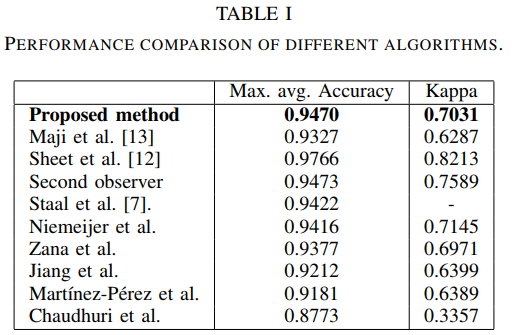

四:集成多个CNN(同构不同参)-检测眼底图像中的视网膜血管

Ensemble of Deep Convolutional Neural Networks for Learning to Detect Retinal Vessels in Fundus Images Published 2016,Computer Science, Mathematics-ArXiv。被引:107 https://arxiv.org/abs/1603.04833

WHY?

通过眼底彩色成像的定期筛查可以很大程度上预防由于视网膜的病理损伤而导致的视力障碍。

但大规模筛查难在无法彻底检测对疾病诊断至关重要的**细血管**

传统血管检测和分割方法(图像滤镜,矢量几何等)没有被普遍用于从数据本身中学习模式属性

- 最近提出的(完全数据驱动的基于深度学习的模型)性能较弱

WHAT?

使用卷积神经网络,基于“端到端”的思想,不做任何预处理,逐像素地预测该像素处有没有血管

HOW?

1.具体操作方法

逐像素地裁剪出周围的31313(WidthHeightChannel)的小块,送入训练好的CNN,输出预测值是0还是1。

2.使用的CNN网络结构

[conv-relu]-[conv-relu-pool]*2-fc-relu-fc-最后接一个softmax二分类器,用RMSProp方法,minibatch取200,学习率1e-4,动量项0.95,倒数第二个全连接层采用Dropout,概率为0.5,采用二范数形式的正则项,系数为1e-3。

图2.提出的集成卷积网络中的层组织。 S-步长,P-零填充,n-不同ConvNet中倒数第二个仿射层变量中的隐藏单位数(有关详细信息,请参见V)

3.如何集成

改变上面那些参数,独立训练了12个网络,每个网络分别做预测最后取平均值

RESULT?

达到了血管检测的目的,最大平均准确度为94.7%,ROC曲线下面积为0.9283。

显然,尽管我们的方法与其他方法相比没有最高的准确性,但它的确比以前提出的基于深度学习的方法从数据中学习血管表示具有更好的性能[13]。kappa评分是观察者一致性的研究,表明该技术检测粗血管和细血管的灵敏度。

FUTURE?

本方法提供了一种强大的替代方法,可通过深度学习与集成学习的强大功能来解决复杂的医学数据分析问题。

医学 分割 对抗 鲁棒(防御) 集成

参考

博客1

五.语义分割中对抗样本的鲁棒性估量

On the Robustness of Semantic Segmentation Models to Adversarial Attacks 被引:121 -CVPR2018 https://arxiv.org/pdf/1711.09856.pdf 牛津大学&Emotech 实验室合作的一篇论文首次严谨评估了义分割模型对对抗攻击的鲁棒性。该研究分析了不同网络架构、模型容量和多尺度处理的影响,展示了分类任务上的很多观测结果未必会迁移到更复杂的任务上,并展示了哪种分割模型目前更适合安全性应用。

WHY?

- DNNs对对抗样本的脆弱性,故DNN 对对抗扰动的鲁棒性可能与在干净输入上的预测准确率同样重要。但大部分防御方法常常损害在干净输入上的性能

- 对抗样本尚未在分类外(如语义分割)进行广泛分析。

- 语义分割模型通常添加额外组件(空洞卷积、跳过连接、条件随机场(CRF)和/或多尺度处理等)对鲁棒性的影响尚未经过深入研究

WHAT?

(没有提出什么方法,主要是通过实验分析,从而对不同的语义分析模型进行鲁棒性分析)

利用两个大规模数据集首次严谨评估了对抗攻击对现代语义分割模型的影响,

并分析了不同模型架构、容量、多尺度处理和结构化预测的影响

HOW?

2 实验设置

数据集。本研究使用 Pascal VOC 和 Cityscapes 验证集。Pascal VOC 共包含 21 个类别的网络图像,而 Cityscapes 包括一辆车捕捉到的 19 个类别的街景。

模型。本研究基于 VGG [10] 和 ResNet [4] 骨干网络评估模型。研究者还考虑自定义 ENet 和 ICNet 架构用于实时应用。研究者选择的网络展示了多种语义分割模型独有的方法,如专门池化(PSPNet、DeepLab)、编码器-解码器架构(SegNet、E-Net)、多尺度处理(DeepLab)、CRF(CRFRNN)、空洞卷积(DilatedNet、DeepLab)和跳过连接(FCN)。

对抗攻击。研究者使用 FGSM、FGSM ll 及其迭代变体,迭代次数,步长 α = 1 [7]。扰动的范数被设置为 {0.25, 0.5, 1, 2, 4, 8, 16, 32} 的每个值。

评估指标。由于模型在干净输入上的准确率会发生变化,因此研究者使用 IoU 来调整相对指标 [7],衡量对抗鲁棒性,从网络在对抗攻击上的 IoU 到在整个数据集干净图像上的 IoU。

**

- 架构 具有残差连接的模型本身就比链状网络具有更强的鲁棒性(虽然它们在干净输入的情况下可能精度差不多,但是在攻击下有差距)

- 数据集 攻击Cityscapes要比Pascal VOC来得有效很多。

- 模型容量 主要是通过卷积核的数量来衡量的。轻量级模型参数量少,鲁棒性异常得差

- 多尺度处理。Deeplab v2 的多尺度处理使其更加鲁棒。

- CRF 与平均场推断。执行 DenseCRF 端到端平均场推断的 CRF-RNN 对无目标攻击更加鲁棒.原因:

短期来看,基于 ResNet、执行多尺度处理的 Deeplab v2 等网络内在鲁棒性更强

FUTURE?

对抗攻击可以说是影响DNN的最大挑战。最近对这种现象的兴趣只是一项重要的长期工作的开始,作者认为还应该研究其他因素的影响,例如训练制度和针对评估指标量身定制的攻击。在本文中,作者进行了无数次观察并提出了问题,这些将有助于将来的工作来理解对抗样本并开发更有效的防御措施。

医学 分割 对抗 鲁棒(防御) 集成

参考

机器之心

知乎:咫尺小厘米

视网膜血管分割的无监督集成策略-

MICCAL2019

作者提出了一种新颖而简单的策略来整合多种方法的预测结果,以实现视网膜血管的精确分割。

参考

博客1

多任务学习-A Novel Multi-task Deep Learning Model for Skin Lesion Segmentation and Classification-2017

多任务:分割+分类

结论:多任务的架构比单个任务学习准确率更高。

参考

博客1

参考

[论文笔记]集成方法提高神经网络的对抗鲁棒性

科研篇四:对抗样本20篇-ICML2019

对抗防御综述-新网络安全军备竞赛场:对抗样本防护

学界 | Ian Goodfellow推荐论文:增加机器学习的防御就能解决鲁棒性问题?天真!

WHY?

WHAT?

HOW?

RESULT?

FUTURE?