Mitigating Adversarial Attacks on Medical Image Understanding Systems 被引8 @inproceedings{paul2020mitigating, title={Mitigating adversarial attacks on medical image understanding systems},

author={Paul, Rahul and Schabath, Matthew and Gillies, Robert and Hall, Lawrence and Goldgof, Dmitry},

booktitle={2020 IEEE 17th International Symposium on Biomedical Imaging (ISBI)},

pages={1517—1521},

year={2020},

organization={IEEE}

}

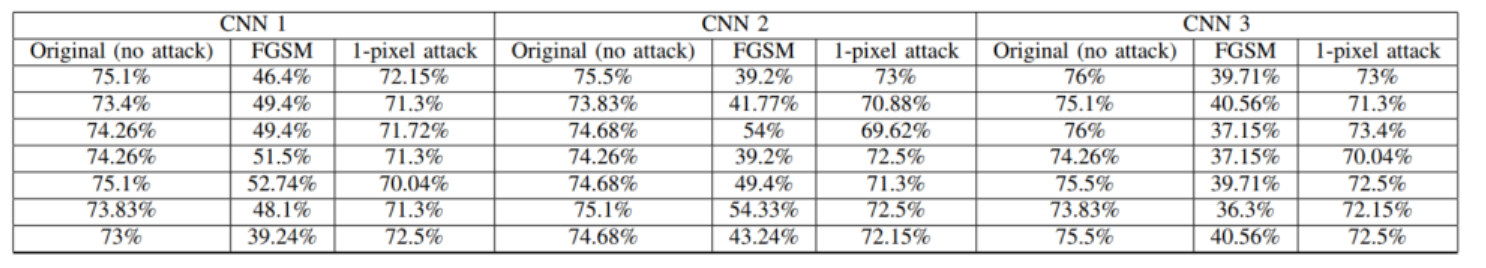

我们对每种CNN架构进行了多次训练(七次)使用不同的种子点进行权重初始化,以验证对抗攻击的稳定性和性能variability。集成防御策略使用多个CNN,以增强单个CNN体系结构的分类性能和鲁棒性。为了进行比较,我们分析了原始群组2图像上CNN的性能。表2中显示了使用七个初始化训练后从3个CNN获得的详细结果。

图二:使用三个使用七个不同种子点初始化训练的CNN进行对抗性攻击的分类性能:仅针对同类群组1的原始图片进行训练,以及针对同类群组2的对抗图片进行测试

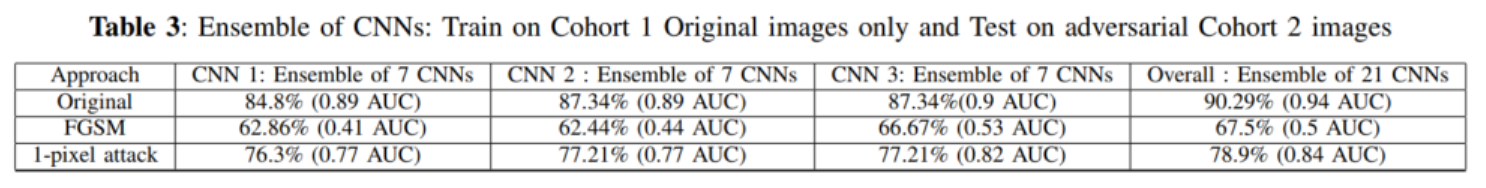

然后,我们通过平均21个CNN(3个CNN和7个初始化)输出的伪概率来创建集成。可以观察到对抗 对抗攻击的性能提高。使用集成,获得了67.51%的分类准确度,与表3所示结果相比提高了12-25%。

然后,针对单像素攻击分析了对抗攻击的稳定性和CNN分类性能的variability。表2中显示了使用七个初始化训练后从3个CNN获得的详细结果。然后,我们通过平均21个CNN的伪概率来创建集成。使用集成可达到78.9%的准确度,这是对表2中显示的结果的改进。集成结果示于表3。

在我们的研究中,我们为Cohort1生成了对抗图像(FGSM和单像素攻击)。然后,将Cohort1的对抗图像分为70%训练集和30%验证集,以执行数据增强,如前所述,并将对抗图像添加到队列的原始图像Cohort1中.

在增强型队列中进行了CNN培训1个数据集。现在,经过重新训练的CNN分别在原始和对抗的Cohort2图像上进行了测试。进行此分析以检查减少多少(针对Cohort2原始图片)或 取得了性能提升(针对Cohort2对抗图片)。对于FGSM,在增强训练集上进行训练并对Cohort2图像进行测试后,我们发现所有CNN的分类性能均降低了2-3%。在对抗性同类群组2进行测试后,我们观察到分类准确度提高了15-20%。对于单像素攻击,在使用增强型训练集进行训练并在原始同类群组2进行测试后,我们发现所有CNN的分类准确度减少了2-4%。对Cohort2对抗图片测试后,我们观察到分类准确性提高了1-3%,详细结果如表4-7所示。

在训练中使用对抗图像加上集成分类器的结果比在干净数据上使用单个分类器的结果更准确。但是,对于FGSM,此数据的准确性比整体数据准确度低13%,对于单像素攻击的准确性则低10%。不过,与未安装防御的FGSM相比下降了30%相比,这还是一个很大的改进。