一种用于移动虹膜生物识别的轻量化多标记分割网络

Caiyong Wang, Yunlong Wang , Boqiang Xu, Yong He , Zhiwei Dong , Zhenan Sun

School of Artificial Intelligence, University of Chinese Academy of Sciences, China

CRIPAC, NLPR, CASIA, China

University of Science and Technology Beijing, China

caiyong.wang@cripac.ia.ac.cn, znsun@nlpr.ia.ac.c

Abstract

本文提出了一种新颖的、轻量级的深度卷积神经网络,专门针对移动设备采集的含噪图像进行虹膜分割。与以往的研究不同,只专注于使用流行的CNN技术提高segmentation mask的准确性,我们的方法是一个完整的end-to-end虹膜分割方案,即同时获得segmentation mask和参数化的瞳孔和虹膜边界,这进一步使CNN-based虹膜分割应用在任何常规的虹膜识别系统。通过引入一种中间图像边界表示,虹膜边界预测和segmentation mask共同构成了一个多标签语义分割问题,该问题可以通过精心调整的stacked hourglass network得到很好的解决。实验结果表明,该方法在两个具有挑战性的移动虹膜数据库中,无论是虹膜分割还是虹膜定位,都取得了较好的或SOTA性能。

Index Terms—— iris segmentation, iris localization, mobile iris biometrics, multi-label learning, stacked hourglass network

1. Introducation

移动虹膜生物识别技术已经成为一种可靠的个人识别方法,在智能解锁、出入境管理、银行、社交网络、移动支付等领域有着广泛的应用。然而,less-constrained约束少的移动环境中,例如,照明扭曲,有限的用户合作,移动的,会导致很多不良噪音,比如失焦,运动模糊,目光偏移,闭塞,镜面反射和旋转[1, 2, 3],从而显著的恶化虹膜分割的效果,从而影响虹膜识别的准确率。因此,需要更具有鲁棒性和高校的虹膜分割方法,不仅要提高分割和识别性能,还要降低模型的复杂性,便于在移动设备上部署。

近年来,在深度学习特别是卷积神经网络(CNN)成功的鼓舞下,许多方法都采用了现有的或新的语义分割模型,如MFCNs[4]、SegNet[5]、UNet[6]用于虹膜分割,并取得了SOTA性能。然而,大多数基于cnn的虹膜分割方法只获得分割掩膜,这对于一般的虹膜识别系统是可选的。相比之下,最不可或缺的虹膜定位函数,即参数化的瞳孔和虹膜边缘边界的估计,长期以来被忽略,导致优越的CNN-based虹膜分割在虹膜识别中没有得到充分的利用。为了解决这一问题,CNNHT[7]首次应用圆形霍夫变换来处理由RetinaNet生成的segmentation mask来生成候选虹膜边界,然后提出几种质量测量值来选择最佳的定位结果。但是,这种方法仍然是一种后处理post-processing操作,它对segmentation mask的质量有很大的依赖性,当遇到非常不规则或噪声非常大的segmentation mask时,很容易失败。

为了在设计CNN模型时明确考虑虹膜的定位问题,本文引入了一种新的图像边界表示方法irismaps,它是对瞳孔或虹膜边缘边界的二进制填充掩膜。这样,虹膜边界和分割掩码的预测可以被建模为一个多标签的语义分割问题,该问题可以通过一种adapted lightweight stacked hourglass network来解决。然后,通过少量简单的后处理操作,得到最终的参数化定位结果。为了训练和评估所提出的模型,我们使用了两个具有挑战性的移动虹膜数据库,并对分割面具和虹膜边界进行了细致的手工标注,并在需要时免费提供给研究团体。实验结果表明,该方法在虹膜分割和虹膜定位两方面都有SOTA性能或优于目前的几种方法。

国家自然科学基金项目(no . U1836217, no . 61427811);国家重点研发计划项目(no . 2017YFC0821602)。关键词:岩石力学,岩石力学特性,岩石力学特性通讯作者:Zhenan Sun

2. Technical Details

2.1. Pictorial representation of iris localization

在虹膜定位的任务中,虹膜的参数化的瞳孔或边缘边界,是从输入虹膜图像获得的,这些边界通常被认为是圆或者椭圆。如果我们将输入虹膜图像表示为 x ,参数化虹膜边界为 b,传统的虹膜定位模型表示为 f:x→b。对映射到 f 的直接评估显然是复杂的,因为虹膜图像经常遭受各种类型的噪声,特别是眼睑、睫毛、眼镜这样的严重遮挡,并且这样一个高度非线性回归模型很难收敛。由于虹膜定位与虹膜边界直接相关,可以合理的假设,一个虹膜边界的图像表征可以有助于避免分散虹膜图像中纹理细节,并且桥接输入 x 和参数化虹膜边界 b。也就是说,模型重新组成为b = k ◦ j (x),在j: x→m和k : m→b的地方。具体而言,m是精确的密集的虹膜边界的图形表示,和输入虹膜图像 x有相同的size。因此,我们虹膜定位的任务分割成两个子任务:

(a)输入虹膜图像x到m的推理

(b) m的后处理得到参数化虹膜边界。

图1 - 提出的虹膜图,本质上是一个虹膜的瞳孔(内)或边缘(外)边界的binary filled mask。提出了两类参数化边界:(a)圆形边界,(b)椭圆边界。

显然,m可以直接表示为虹膜边界图,如图1第二列所示。然而,我们的实践经验表明,由于正(边界)和负(无边界)样本的不平衡问题,预测结果容易出现模糊、粗糙和噪声,因此直接估计虹膜边界图是不具备鲁棒性的。

为了解决这个难题,我们建议评估irismaps,并从那里获得参数化边界。给定输入的irismaps是填充后的虹膜瞳孔和边缘边界的密集binary masks,如图1第三列所示。与直接估计虹膜边界相比,irismaps的估计更简单、更容易,因为它缓解了正/负不平衡问题。

2.2. Unified iris segmentation and localization framework

为了同时获得 irismaps 和iris segmentation mask,对j进行了扩展,形成了一种多标签语义分割模型。与一般语义分割问题中常用的多类设置不同(将每个像素分配到多个类的唯一标签中),多标签模型为每个类学习一个独立的二分类器,并分配每个像素到多个二分类标签[8]。特别是外irismap分割,其前景区域与虹膜分割掩膜和内irismap重合,即被标记为虹膜或瞳孔mask的像素也有边缘mask的label。由于标注错误和natural ambiguity的问题,在虹膜分割掩膜的边界和irismap的内部也可能出现类似的情况。

为了解决这一多标签密集预测问题,采用了一种经过精心调整的stacked hourglass network[9]。与U-Net[10]类似,hourglass network是一种对称的全卷积架构,其中特征图通过池操作下采样,然后使用最近邻上采样方法进行上采样。在每个尺度水平上,一个残差的跳跃连接被应用到hourglass两边的所对应的层之间。这种自底向上、自顶向下的结构被多次堆叠,以捕捉大范围的上下文信息,因此即使是闭塞的irismaps也可能通过捕捉瞳孔边界、虹膜纹理和边缘边界之间的空间关系来预测。

另外,为了在整个网络中保持输入的大小不变,并且使网络轻量级化,受[11,12]的启发,我们对原有的沙漏网络hourglass进行了四个调整:(1)初始卷积与内核层大小的步幅7×7从2改为1,(2)最初max-pooling层移除,(3)网络的每层通道数量从256减少到64,(4)每个hourglass模块会在4中不同的图像比例下处理,并且堆叠3次。在每个沙漏hourglass模块的末尾,64个refined的特征图与1 x 1的卷积层结合生成6个maps:2个用于分割掩模,2个用于内irismap,其余2个用于外irismap。每一对包括前景图和背景图,通过softmax层进一步处理以获得二进制掩码。

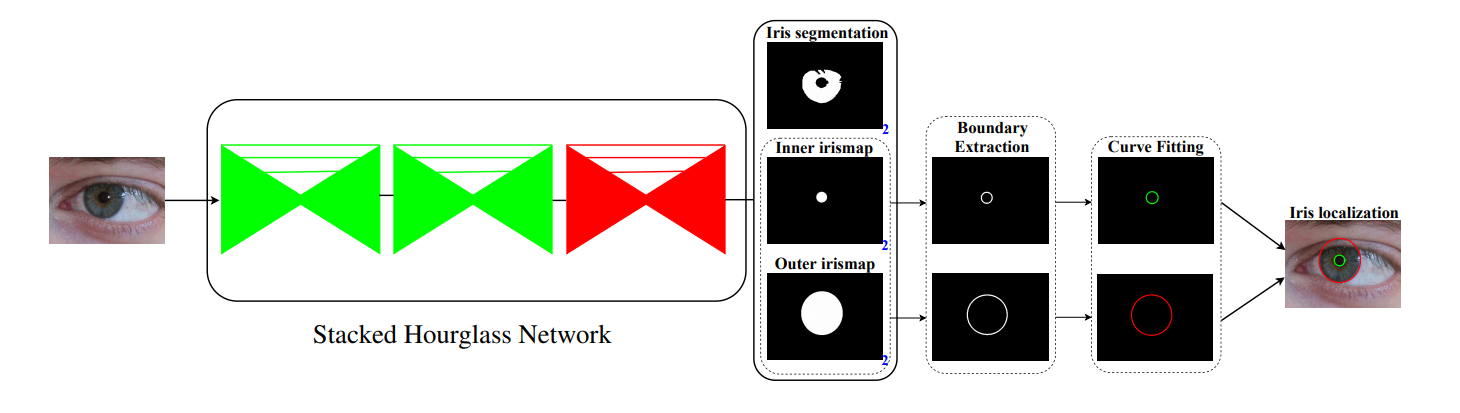

在生成irismaps后,完成任务(b)无非是采用简单的形态学边界提取和曲线拟合运算,得到参数化的虹膜边界。统一的虹膜分割和定位框架如图2所示。

图2 - 提出的统一的虹膜分割和定位框架。该模型首先利用堆叠沙漏网络stacked hourglass network预测分割掩模,虹膜的内外irismaps,然后通过简单的后处理操作得到最终的参数化虹膜边界。以彩色观看最佳

2.3. Training

Implementation details。该模型在Pytorch[13]中实现。我们使用Adam[14]来优化网络,并且使用大小为10的mini-batch size和L2权值正则化系数为5 x 10-4,训练2000个epoches。初始化的学习率为2 × 10−4,当验证损失达到稳定水平时,学习率降低了0.4倍。在实验中,根据8 :2的设置,将原始训练集分成两部分进行训练和验证。

Loss function。所提出的模型的损失函数表达式如下所示:

L,L,L,分别代表segmentation mask,内irismap和外irismap的loss,实现为前景和背景两类的交叉熵损失。系数入1,入2,入3在我们的实验中设置为1,为了使这些loss值范围有可比性。上述的loss应用在最后的hourglass模块中,如图2中的红色高亮所示。

3. Experiments

3.1. Database

CASIA-Iris-M1:一个大型的近红外移动虹膜数据库,包含来自630个亚洲受试者[15]的11000张图像,分为三个子集:CASIA-Iris-M1-S1(1400张图像),CASIAIris-M1-S2(6000张图像)和CASIA-Iris-M1-S3(3600张图像)。在实验中,我们对每幅图像手动提取出分辨率为400×400像素的眼睛区域。从每个子集中随机选取500张虹膜图像混合形成1500张图像的大训练集。同样的,另外选取1500张不相交(不在训练集里面的)的图像组成测试集。分割掩模和irismap由我们手工标记。

MICHE-I:一个由三个移动设备收集的大型VIS移动虹膜数据库,包括iPhone5(1262张图片),三星Galaxy S4(1297张图片),和三星Galaxy Tab2(632张图片)在不受控制的情况下(无配合拍摄)[2]。我们将Hu等人的带标记虹膜分割掩膜的虹膜图像和Bezerra等人的虹膜分割掩膜图像组成一个包含871张不同分辨率图像的大数据库。随机选取680幅图像进行训练,其余191幅图像进行测试。Irismaps是我们手工标记的。

3.2. Evaluation Protocols

Iris segmentation:虹膜分割的性能使用与NICE.I比赛中相同的协议进行评估,其中平均分割错误率的表达式如下所示:

n是r行和c列的虹膜图像的个数,G和M表示gt mask和预测到的segmentation mask,c’和r’表示像素的列和行。⊗操作符代表XOR操作,评估G和M之间不一致的像素。E1的值的范围是[0, 1],并且值越小,分割结果越好。

Iris localization:受[19]的启发,我们计算预测的参数化瞳孔或边缘边界(记为B)与相应标记的边界(记为G)之间的Hausdorff距离,来衡量它们的形状相似性,定义为:

并且,利用水平眼宽来对Hauxdorff距离进行归一化,来消除不同图片大小带来的影响。

Hausdorff距离越小,预测的虹膜边界与其ground truth的形状相似度越高,检测精度越高。我们计算瞳孔和边缘边界的平均归一化Hausdorff距离(mHdis),然后两个归一化Hausdorff距离的平均值证明虹膜定位的整体精度。

此外,我们根据预测瞳孔和边缘边界之间的归一化Hausdorff距离及其ground truth给出的误差阈值来评估不同的虹膜定位成功率,并绘制相应的正确定位百分比(PCL)曲线。还报告了进一步的统计,即与最大阈值(τ)相对应的曲线下面积(area- below - The -curve, AUC),公式为AUC@τ。

3.3. Performance Evaluation

Comparison to State-Of-The-Arts。我们选取了几种最先进的方法作为基线,其中RTV-L 1[20]是传统的虹膜分割和定位方法,其余方法都是基于深度CNN的。另外,由于RTVL 1[20]和CNNHT[7]可以同时产生分割的mask和圆形的虹膜边界,它们被用来作为虹膜分割和定位的标杆。MFCNs[4]仅用于虹膜分割的比较。对于我们的方法,应用基于最小二乘的圆拟合[21]来获得最终的圆形虹膜边界。此外,我们多次使用官方提供的代码进行实践尝试,结果表明RTV-L 1[20]可能不适用于CASIA-IrisM1,因此相应的结果没有包含在基准测试中。

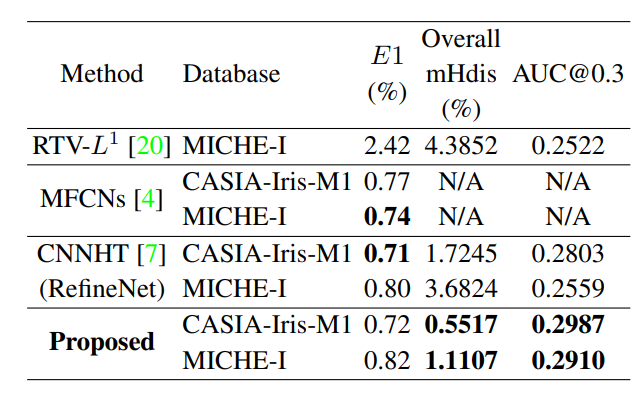

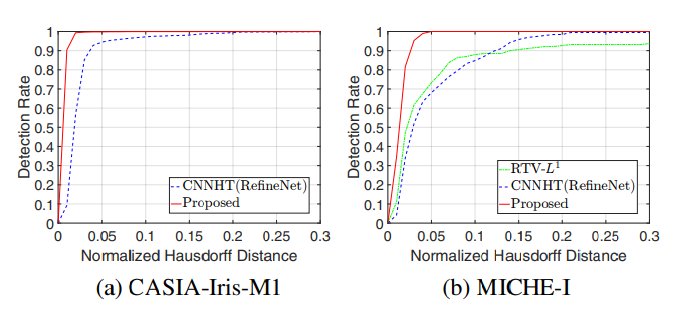

比较结果见表1和图3。从这些结果可以看出,基于cnn的虹膜分割和定位方法在所有指标上都优于传统方法,表明了基于cnn的方法的优越性。特别是在虹膜分割方面,我们的方法与目前最先进的方法相比,取得了具有可比较性的结果;在虹膜定位方面,我们的方法在所有数据库的所有指标上都明显优于其他方法,证明了本文方法的准确性和优越性。

表1 - 不同的方法下,虹膜分割和定位(圆形边界)额比拼

图3 - 不同方法下,运用所提出的PCL曲线,虹膜定位的比拼

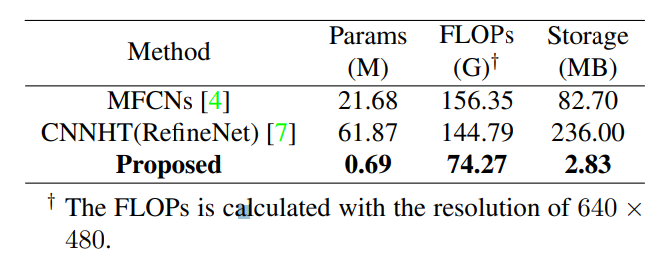

表2 - 不同方式下,模型复杂度的比拼

Evaluation of model complexity。

由于移动虹膜识别系统需要考虑计算量(见FLOPs)和模型参数,因此我们将其纳入评估指标,如表2所示。可以看出,由于lightweight adaption,我们的模型只有0.69M的参数,74.27G FLOPs,占用2.83MB的存储空间,远远少于其他模型。这种轻量级和高效率的模型使得在移动设备上的实际部署成为可能。

4. Conclusion

本文提出了一种新颖的、统一的、多标签的学习框架,用于解决在约束较小的移动环境下的虹膜分割和定位问题。提出一种虹膜定位的中间图形表示(即irismaps),并将其集成到适应的轻量级堆叠沙漏网络中adapted lightweight stacked hourglass network,然后通过简单的后处理操作获得参数化的虹膜边界。大量的实验证明了该方法的有效性。在未来的工作中,我们打算进一步提高模型的准确性和运行效率,以实现在移动设备上的实际部署。

5. References

[1] Jin-Suk Kang, “Mobile iris recognition systems: An emerging biometric technology,” Procedia Computer Science, vol. 1, no. 1, pp. 475–484, 2010. 1

[2] Maria De Marsico, Michele Nappi, Daniel Riccio, and Harry Wechsler, “Mobile iris challenge evaluation (miche)-i, biometric iris dataset and protocols,” Pattern Recognition Letters, vol. 57, pp. 17–23, 2015. 1, 3

[3] Ruggero Donida Labati, Enrique Munoz, Vincenzo Pi- ˜ uri, Arun Ross, and Fabio Scotti, “Non-ideal iris segmentation using polar spline ransac and illumination compensation,” Computer Vision and Image Understanding, p. 102787, 2019. 1

[4] Nianfeng Liu, Haiqing Li, Man Zhang, Jing Liu, Zhenan Sun, and Tieniu Tan, “Accurate iris segmentation in non-cooperative environments using fully convolutional networks,” in IAPR International Conference on Biometrics, 2016, pp. 1–8. 1, 4

[5] Ehsaneddin Jalilian and Andreas Uhl, “Iris segmentation using fully convolutional encoder–decoder networks,” in Deep Learning for Biometrics, pp. 133–155. Springer, 2017. 1

[6] Sheng Lian, Zhiming Luo, Zhun Zhong, Xiang Lin, Songzhi Su, and Shaozi Li, “Attention guided u-net for accurate iris segmentation,” Journal of Visual Communication and Image Representation, vol. 56, pp. 296– 304, 2018. 1

[7] Heinz Hofbauer, Ehsaneddin Jalilian, and Andreas Uhl, “Exploiting superior cnn-based iris segmentation for better recognition accuracy,” Pattern Recognition Letters, 2018. 1, 4

[8] Huazhu Fu, Jun Cheng, Yanwu Xu, Damon Wing Kee Wong, Jiang Liu, and Xiaochun Cao, “Joint optic disc and cup segmentation based on multi-label deep network and polar transformation,” IEEE transactions on medical imaging, vol. 37, no. 7, pp. 1597–1605, 2018. 2 [9] Alejandro Newell, Kaiyu Yang, and Jia Deng, “Stacked hourglass networks for human pose estimation,” in European Conference on Computer Vision. Springer, 2016, pp. 483–499. 2

[10] Olaf Ronneberger, Philipp Fischer, and Thomas Brox, “U-net: Convolutional networks for biomedical image segmentation,” in International Conference on Medical image computing and computer-assisted intervention. Springer, 2015, pp. 234–241. 2

[11] Feng Zhang, Xiatian Zhu, and Mao Ye, “Fast human pose estimation,” CoRR, vol. abs/1811.05419, 2018. 2

[12] Seonwook Park, Adrian Spurr, and Otmar Hilliges, “Deep pictorial gaze estimation,” in European Conference on Computer Vision. Springer, 2018, pp. 741–757. 2

[13] Adam Paszke, Sam Gross, Soumith Chintala, Gregory Chanan, Edward Yang, Zachary DeVito, Zeming Lin, Alban Desmaison, Luca Antiga, and Adam Lerer, “Automatic differentiation in pytorch,” 2017. 3

[14] Diederik P Kingma and Jimmy Ba, “Adam: A method for stochastic optimization,” CoRR, vol. abs/1807.04058, 2014. 3

[15] Qi Zhang, Haiqing Li, Zhenan Sun, and Tieniu Tan, “Deep feature fusion for iris and periocular biometrics on mobile devices,” IEEE Transactions on Information Forensics and Security, vol. 13, no. 11, pp. 2897–2912, 2018. 3

[16] Yang Hu, Konstantinos Sirlantzis, and Gareth Howells, “Improving colour iris segmentation using a model selection technique,” Pattern Recognition Letters, vol. 57, pp. 24–32, 2015. 3

[17] Cides S Bezerra, Rayson Laroca, Diego R Lucio, Evair Severo, Lucas F Oliveira, Alceu S Britto, and David Menotti, “Robust iris segmentation based on fully convolutional networks and generative adversarial networks,” in SIBGRAPI Conference on Graphics, Patterns and Images. IEEE, 2018, pp. 281–288. 3

[18] Hugo Proenc¸a and Lu´ıs A Alexandre, “The nice. i: noisy iris challenge evaluation-part i,” in IEEE International Conference on Biometrics: Theory, Applications, and Systems. IEEE, 2007, pp. 1–4. 3

[19] Korsuk Sirinukunwattana, Josien P W Pluim, et al., “Gland segmentation in colon histology images: The glas challenge contest,” Medical Image Analysis, vol. 35, pp. 489–502, 2017. 3

[20] Zijing Zhao and Kumar Ajay, “An accurate iris segmentation framework under relaxed imaging constraints using total variation model,” in IEEE International Conference on Computer Vision, 2015, pp. 3828–3836. 4

[21] N Chernov and Claire Lesort, “Least squares fitting of circles,” Journal of Mathematical Imaging and Vision, vol. 23, no. 3, pp. 239–252, 2005. 4