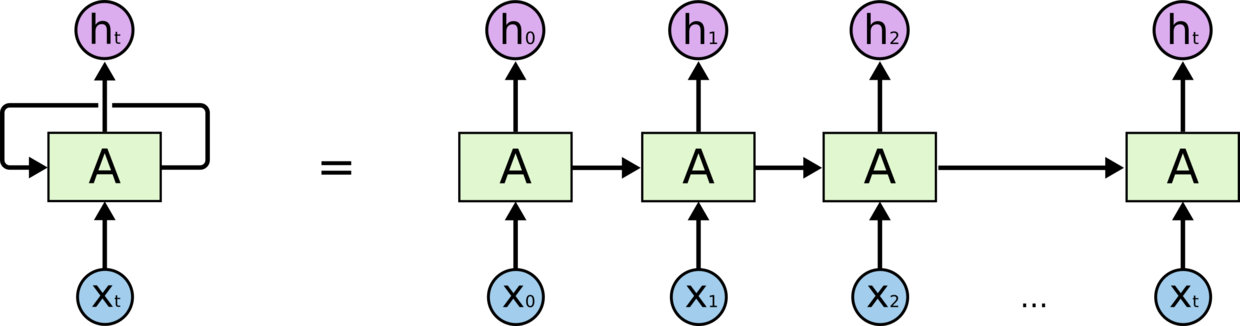

如上图所示,RNN在一定程度上是同一网络的多次复制,将上一时刻的状态信息重新作为下一时刻的输入数据,体现了时间上的顺序关系,但是这存在大问题:

1.输入数据与之前的状态存在关系,对当下状态dt的计算还要将dt-1的状态加入计算,当步数达到10以上时会出现梯度爆炸(消失),也就是简单RNN的长时依赖问题,这种情况之下,RNN会丧失对长时间关系的连接能力。

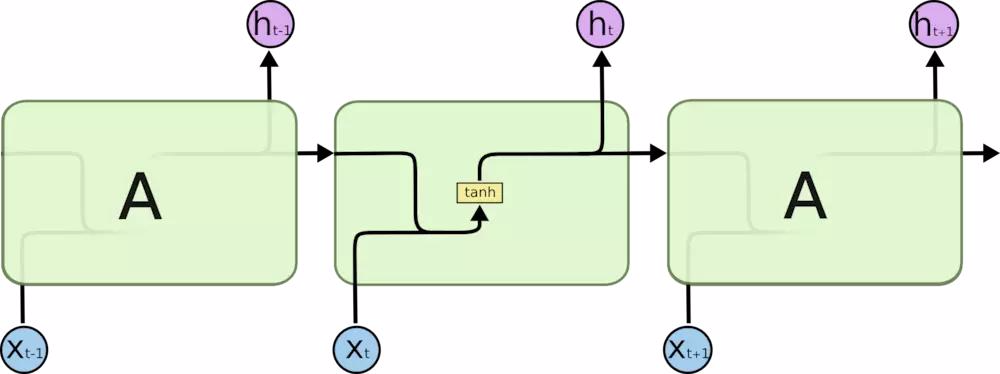

LSTM(长短时间记忆):

是对RNN长依赖问题的解决:

比起上边简单的RNN的重复链式结构;

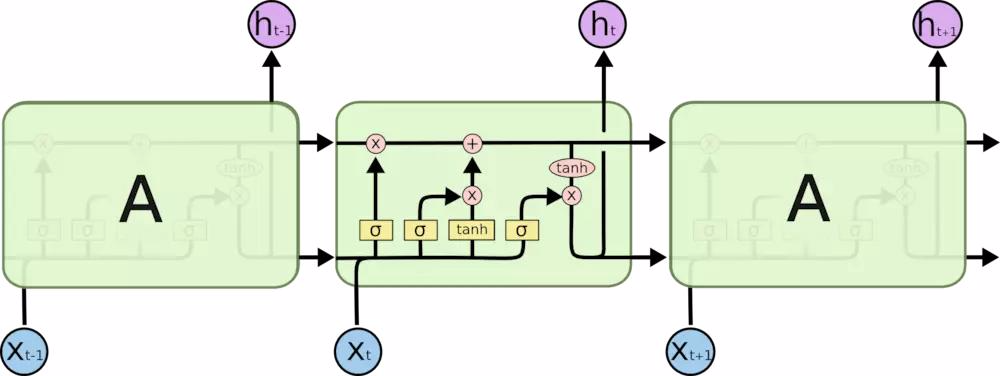

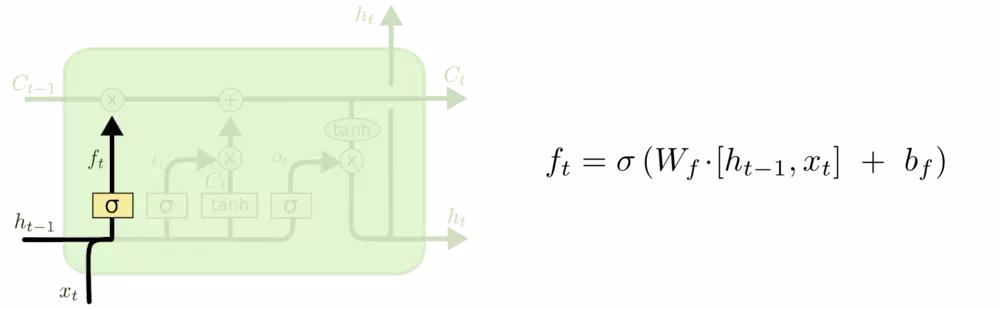

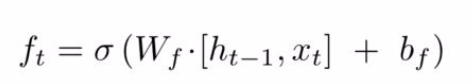

LSTM第一点就是引入遗忘门:

旧状态与ft相乘丢弃掉需要遗忘的信息, (

)

)

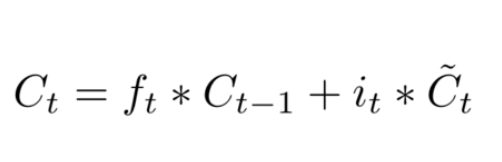

可知ft由t-1时刻的输出和t时刻的输入决定,其中wf和bf是计算中的定量,输出的ft为0或1,为0时完全舍弃,为1时完全保留, ,后边的it和Ct就是

,后边的it和Ct就是