简介:

一、LVS是什么?

LVS,全称Linux Virtual Server,是国人章文嵩发起的一个开源项目。 在社区具有很大的热度,是一个

基于四层(传输层)、具有强大性能的反向代理服务器。 早期使用lvs需要修改内核才能使用,但是由于性能优异,现在已经被收入内核。 LVS通过工作于内核的ipvs模块来实现功能,其主要工作于netfilter 的INPUT链上。 而用户需要对ipvs进行操作配置则需要使用ipvsadm这个工具。 ipvsadm主要用于设置lvs模型、调度方式以及指定后端主机。 注: LVS一般与Keepalived配置使用 目前有三种IP负载均衡技术(VS/NAT、VS/TUN和VS/DR);八种调度算法(rr,wrr,lc,wlc,lblc,lblcr,dh,sh)。

参考:LVS原理介绍

二、Keepalived是什么?

Keepalived是在

LVS基础之上实现心跳检测、监控服务器实现故降转移,如果服务器发生宕机的时候,可以尝试自动重试脚本。如果多次重试还是失败状态,会发送邮件给运维人员,实现高可用。Nginx的故障转移就是通过Keppalived实现的。

三、LVS与Nginx的区别:

LVS是一种四层负载均衡器,(传输层)其实软负载均衡,完成所有负载均衡业务需求:比如数据库、web服务,虚拟化技术,虚拟VIPlp地址。

- Nginx是七层负载均衡主要针对于应用层负载均衡(Http),在1.9之后开始支持对四层负载均衡支持。

- LVS是四层负载均衡,主要针对传输层负载均衡。

- LVS应用场景比Nginx负载均衡应用场景更加广泛,而且LVS支持所有服务负载均衡业务功能。

题外话:

为什么使用LVS:

LVS抗负载能力比Nginx强,而且LVS可以管理Nginx集群的关系。 因为Nginx实现集群,客户端不知道访问哪台Nginx服务器,而LVS通过VIP(Virtual IP)技术生成一个虚拟IP,我们客户端就这个虚拟IP,LVS通过负责均衡算法帮我们找对应的Nginx服务器。

关于为什么是7*24小时运行

为啥不是365*24呢,这其实跟开发模式有关,目前大多数公司都采用

敏捷开发,简单的说就是将一个大项目开发分成多个版本迭代,最开始可以上一个不太完美的初始版本,后面再慢慢迭代完善。 敏捷开发有两个好处:

- 早期交付,从而大大降低成本

- 及时了解市场需求,降低产品不适用的风险。

虽然敏捷开发将软件开发分成多个迭代,但是也要求,每次迭代都是一个完整的软件开发周期,必须按照软件工程的方法论,进行正规的流程管理。 具体来说,每次迭代都必须依次完成以下五个步骤。

- 需求分析(requirements analysis)

- 设计(design)

- 编码(coding)

- 测试(testing)

- 部署和评估(deployment / evaluation)

参考:敏捷开发入门教程

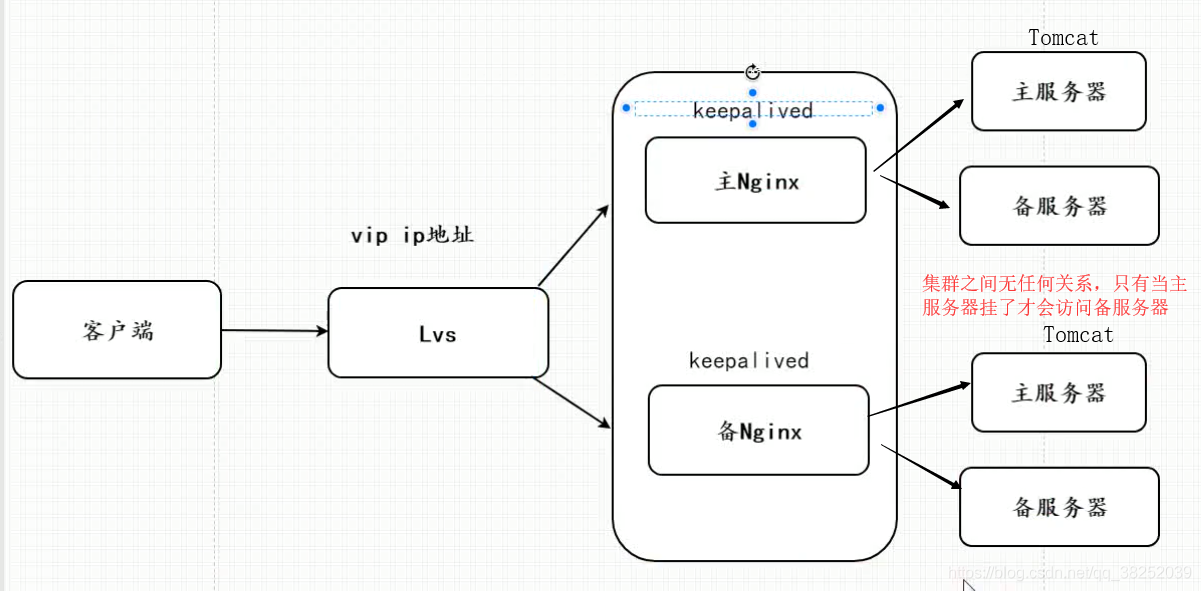

四、LVS+Keepalived+Nginx主从双机热备架构图:

环境搭建

一、Linux环境安装Keepalived

注意:LVS不用安装,Linux2.4开始都自行支持,需要在主服务器(Master)和从服务器(Backup)都安装Keepalived,而且两台服务器必须在同一网段内,因为LVS 。Nginx肯定也要提前安装好,这里就不介绍Nginx如何安装了。

提示:如果使用VM的话可以直接克隆安装好了的虚拟机,这样不用重复安装了。

报错: keepalived执行./configure –prefix=/usr/local/keepalived时报错:configure: error: Popt libraries is required 出现此错误的原因: 未安装popt的开发包 解决方法:

yum install popt-devel安装好popt的开发包。重新./configure 即可。

keepalived安装成Linux系统服务

将keepalived安装成Linux系统服务实现开机自启,因为没有使用keepalived的默认安装路径(默认路径:/usr/local),安装完成之后,需要做一些修改工作:

- 首先创建文件夹,将keepalived配置文件进行复制:

mkdir /etc/keepalivedcp /usr/local/keepalived/etc/keepalived/keepalived.conf /etc/keepalived/ - 然后复制keepalived脚本文件:

cp /usr/local/keepalived/etc/rc.d/init.d/keepalived /etc/init.d/cp /usr/local/keepalived/etc/sysconfig/keepalived /etc/sysconfig/ln -s /usr/local/sbin/keepalived /usr/sbin/ln -s /usr/local/keepalived/sbin/keepalived /sbin/ - 可以设置开机启动:

chkconfig keepalived on,到此我们安装完毕!

keepalived 常用命令

service keepalived start #启动keepalivedservice keepalived stop #关闭keepalived

启动报错Starting keepalived (via systemctl): Job for keepalived.service failed. See ‘systemctl status keepalived.service’ and ‘journalctl -xn’ for details. 解决办法 [root@edu-proxy-01 sbin]#

cd /usr/sbin/[root@edu-proxy-01 sbin]#rm -f keepalived[root@edu-proxy-01sbin]#cp /usr/local/keepalived/sbin/keepalived /usr/sbin/使用keepalived虚拟VIP vi /etc/keepalived/keepalived.conf

二、使用keepalived虚拟VIP,使用LVS+Keepalived实现Nginx主从双机热备

提示:

- 如果要实现一主一备,虚拟VIP只能在一台服务器存放。

- 如果要实现多主多备,虚拟VIP可以在多台服务器存放。

主服务器配置(MASTER):

- 修改keepalived配置文件:

vi /etc/keepalived/keepalived.conf - 配置文件如下:

# 检测nginx健康,若宕机则执行重启脚本 (脚本需提前定义)vrrp_script chk_nginx {script "/etc/keepalived/nginx_check.sh" #运行脚本,脚本内容下面有,就是起到一个nginx宕机以后,自动开启服务interval 2 #检测时间间隔weight -20 #如果条件成立的话,则权重 -20}# 定义虚拟路由,VI_1 为虚拟路由的标示符,自己定义名称vrrp_instance VI_1 {state MASTER #来决定主从interface ens33 # 绑定虚拟 IP 的网络接口,根据自己的机器填写 (ip a命令查看)virtual_router_id 121 # 虚拟路由的 ID 号(自定义), 两个节点设置必须一样mcast_src_ip 192.168.0.102 #填写本机ippriority 100 # 节点优先级,主要比从节点优先级高nopreempt # 优先级高的设置 nopreempt 解决异常恢复后再次抢占的问题advert_int 1 # 组播信息发送间隔,两个节点设置必须一样,默认 1sauthentication { #生产中会用到auth_type PASSauth_pass 1111}# 将 track_script 块加入 instance 配置块track_script {chk_nginx #执行 Nginx 监控的服务}virtual_ipaddress {192.168.0.110 # 虚拟ip(注意:VIP与Nginx的ip地址网段要一样),也就是解决写死程序的ip怎么能切换的ip,也可扩展,用途广泛。可配置多个。}}

- 记得关闭防火墙

systemctl stop firewalld - 修改配置以后通过

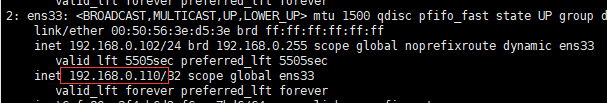

service keepalived start启动Keepalived,通过ip addr命令可以看到多了一个VIP(虚拟ip),即我们在配置文件virtual_ipaddress中设置的ip

- 小测:此时我们启动Nginx,通过Nginx地址和VIP地址都能访问Nginx服务

备服务器配置(BACKUP):

在同网段的另外一台从服务器配置,所有步骤与MASTER一致,注意keepalived.conf配置文件需要修改两个地方:

state BACKUP #来决定主从,BACKUP表示从服务器mcast_src_ip 192.168.0.104 #填写本机ippriority 50 # 节点优先级,主要比主节点优先级低 *****很重要,否则主故障恢复后不会切换到主******

提示:如果使用VM的话可以直接克隆第一个虚拟机(主服务器),然后直接改这两项配置。

测试:

- 我们将主服务器停了

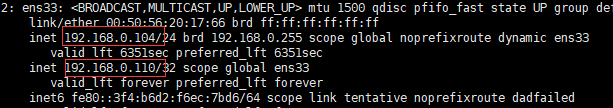

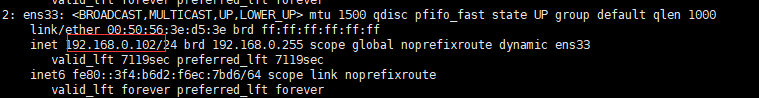

service keepalived stop,发现VIP已将切换到ip为192.168.0.104这台从服务器,而主服务器则没有VIP了

从服务器:

主服务器:

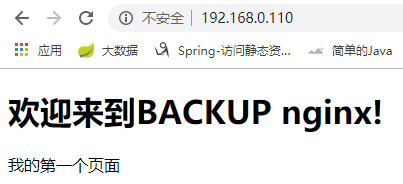

- 浏览器访问VIP地址 ,发现则访问到BACKUP nginx

- 再次启动主服务器

service keepalived start,再次访问VIP地址,这时主服务器故障恢复了,又访问到Master ngixn

三、Nginx+Keepalived实现高可用

keepalived.conf配置文件

vrrp_script chk_nginx处使用了该脚本文件 Keepalived会定时检测Nginx的健康状况,若Nginx发生宕机,则会执行脚本重启Nginx(若重启几次还是失败,可以配置发送邮件,这里再介绍)

将下面脚本写入nginx_check.sh vim /etc/keepalived/nginx_check.sh

#!/bin/bashA=`ps -C nginx –no-header |wc -l`if [ $A -eq 0 ];then/usr/local/nginx/sbin/nginxsleep 2if [ `ps -C nginx --no-header |wc -l` -eq 0 ];thenkillall keepalivedfifi

如果Nginx是Docker运行,则脚本内容如下:

#! /bin/bashecho "重启Docker容器:mynginx"docker restart mynginxif [[ $? -eq 0 ]]; thenecho "执行成功!"elseecho "执行失败!"exitfiecho "重启Docker容器:mynginx 完毕!"

注意该脚本一定要授权

chmod 777 nginx_check.sh

四、Nginx Upstream 实现Tomcat简单双机主从热备

上面我们使用LVS+Keepalived对Nginx做了主从双机热备,并且实现了对Nginx的健康监测(Nginx宕机执行重启脚本),现在我们使用Nginx对Tomcat(即我们的服务)做主从双机热备,需要提前启动两个端口8080、8081,Nginx配置如下:

upstream testproxy {server 127.0.0.1:8080; #主Tomcatserver 127.0.0.1:8081 backup; #备用Tomcat,一般不会访问,只有主tomcat挂了才会访问备Tomcat,等主Tomcat恢复了则继续访问主Tomcat}server {listen 80;server_name localhost;location / {proxy_pass http://testproxy;index index.html index.htm;}###nginx与上游服务器(真实访问的服务器)超时时间 后端服务器连接的超时时间_发起握手等候响应超时时间proxy_connect_timeout 1s;###nginx发送给上游服务器(真实访问的服务器)超时时间proxy_send_timeout 1s;### nginx接受上游服务器(真实访问的服务器)超时时间proxy_read_timeout 1s;}

注:

- 只要在希望成为后备的服务器 ip 后面多添加一个 backup 参数,这台服务器就会成为备份服务器。

- 在平时不使用,nginx 不会给它转发任何请求。只有当其他节点全部无法连接的时候,nginx 才会启用这个节点。

- 一旦有可用的节点恢复服务,该节点则不再使用,又进入后备状态

加上这总方案,架构图如下:

注意: 阿里云默认不支持虚拟VIP技术,可以购买负载均衡(Server Load Balancer,简称SLB)