1. Abstract

多任务学习模型对任务间相关性非常敏感,受限于共享层表达能力有限,任务相关性较低时会影响多任务学习模型的效果,为此提出MMOE,主要方法有:

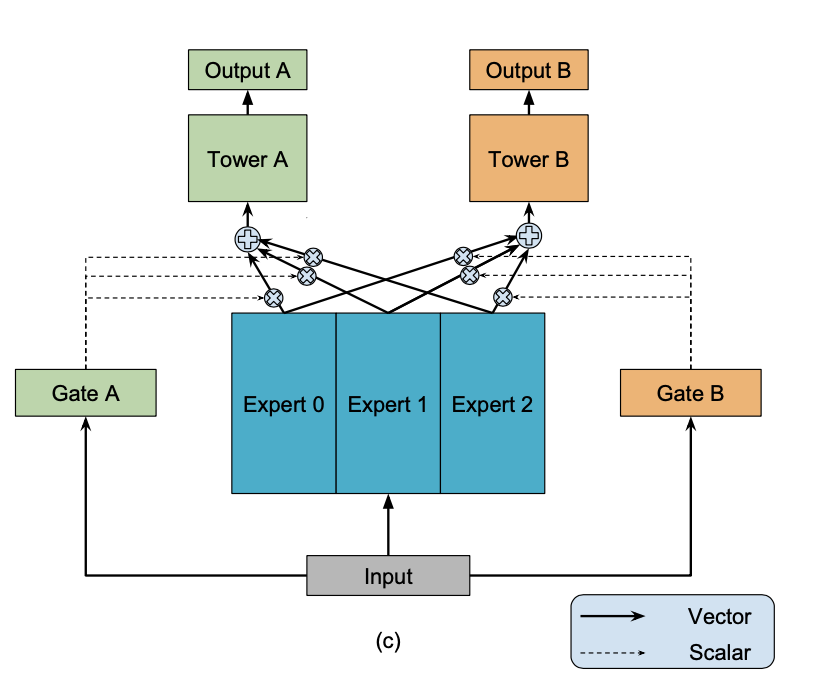

- Experts网络:将共享网络解耦为多个expert网络,提高共享层表达能力;

- Gates网络:从输入数据学习多任务间的相关性,指导共享层的信息提取权重。

2. Shared-bottom Multi-task Model

2.1 传统模型:

其中分别为shared-bottom network和tower network。

2.2 One-gate MoE

2.3 Multi-gate Mixture-of-Experts

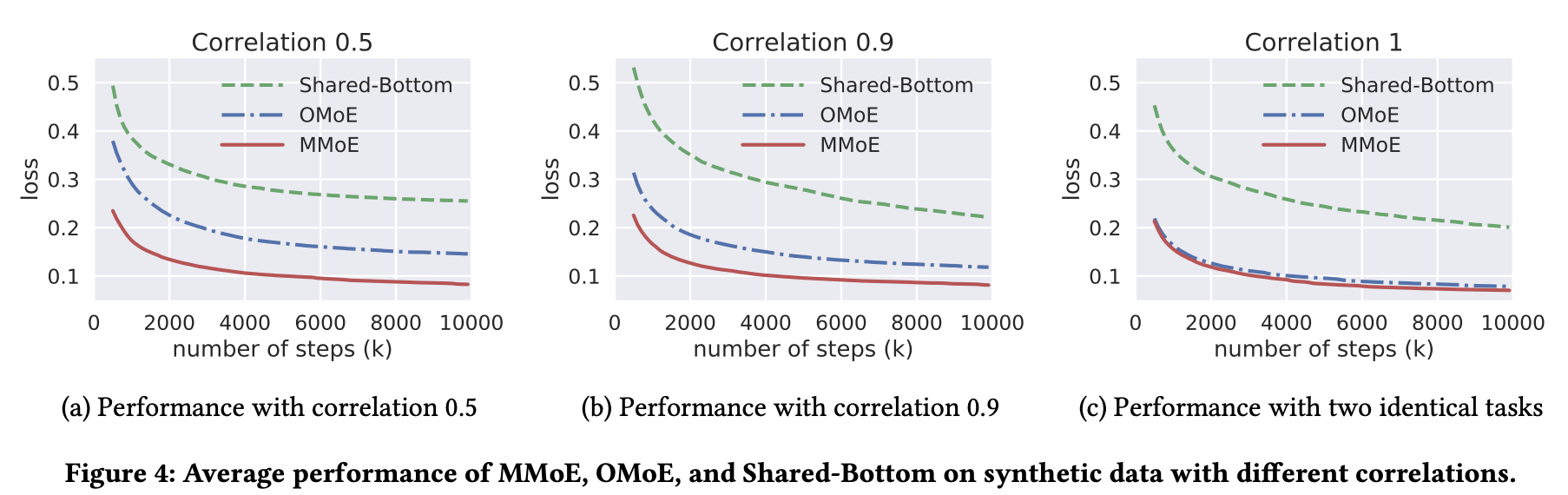

3. Average performance with different correlations

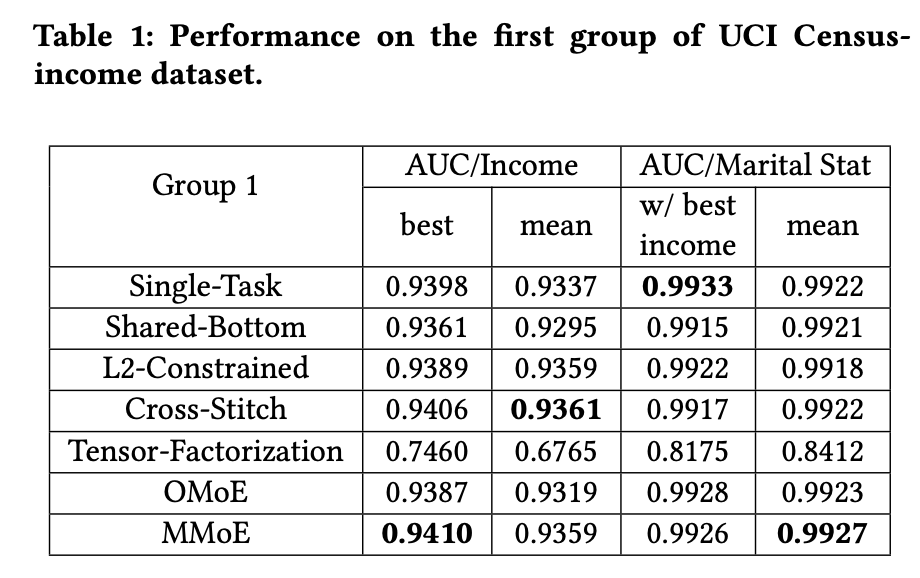

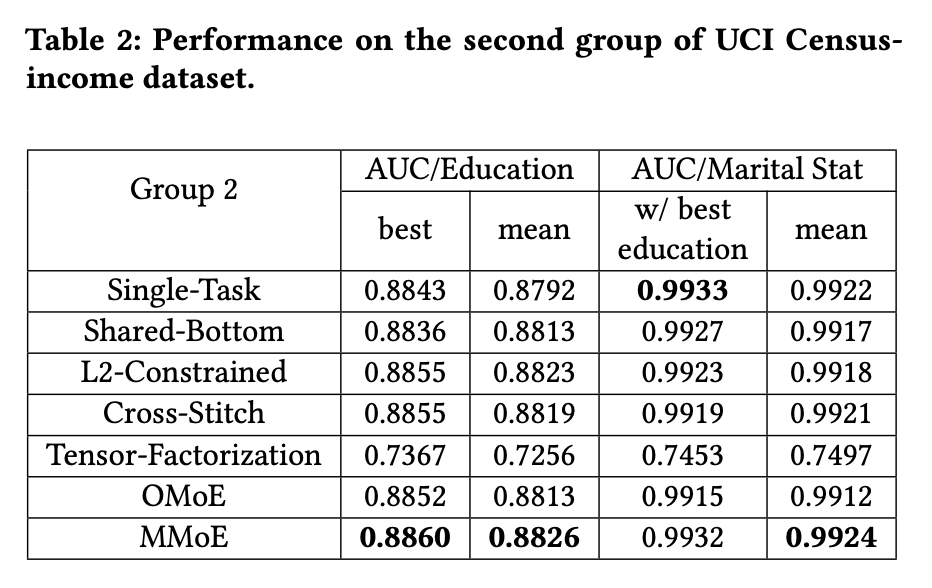

4. Performance on dataset