学习目标

- 目标

- 说明岭回归的原理即与线性回归的不同之处

- 说明正则化对于权重参数的影响

- 说明L1和L2正则化的区别

应用

sklearn.linear_model.Ridge(alpha=1.0, fit_intercept=True,solver=”auto”, normalize=False)

- 具有l2正则化的线性回归

- alpha:正则化力度,也叫 λ

- λ取值:0~1 1~10

- solver:会根据数据自动选择优化方法

- sag:如果数据集、特征都比较大,选择该随机梯度下降优化

- normalize:数据是否进行标准化

- normalize=False:可以在fit之前调用preprocessing.StandardScaler标准化数据

- Ridge.coef_:回归权重

- Ridge.intercept_:回归偏置

All last four solvers support both dense and sparse data. However,only 'sag' supports sparse input when `fit_intercept` is True.

Ridge方法相当于SGDRegressor(penalty=’l2’, loss=”squared_loss”),只不过SGDRegressor实现了一个普通的随机梯度下降学习,推荐使用Ridge(实现了SAG)

sklearn.linear_model.RidgeCV(_BaseRidgeCV, RegressorMixin)

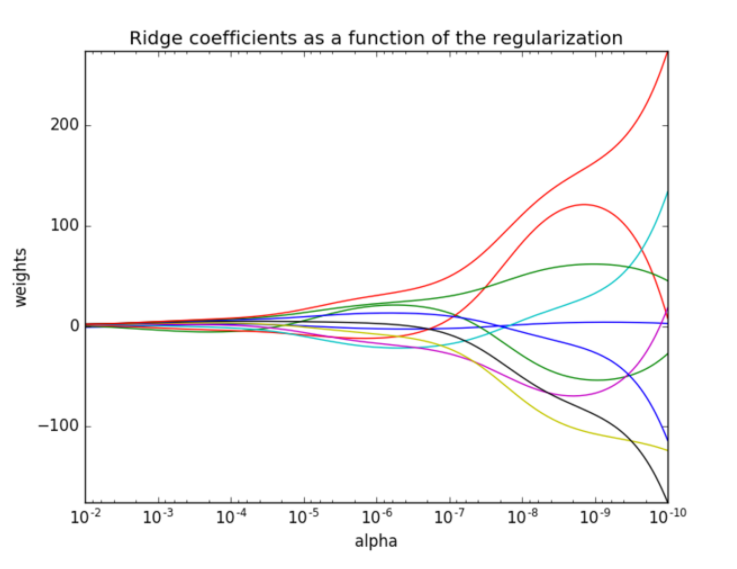

正则化力度越大,权重系数会越小

- 正则化力度越小,权重系数会越大

1.3 波士顿房价预测

rd = Ridge(alpha=1.0) rd.fit(x_train, y_train) print("岭回归的权重参数为:", rd.coef_) y_rd_predict = std_y.inverse_transform(rd.predict(x_test)) print("岭回归的预测的结果为:", y_rd_predict) print("岭回归的均方误差为:", mean_squared_error(y_test, y_rd_predict))