两年前在知乎问的一个问题终于被解答了orz,感谢大佬提供的方法。

1803.09337.pdf

论文原文:https://arxiv.org/abs/1803.09337

Github 实现:https://github.com/koomri/text-segmentation/

摘要

文本分割是基于语义结构将文档划分为连续片段的任务,是语言理解中的一个长期挑战。由于标记数据的缺乏,以前关于文本分割的工作集中在无监督方法上,如聚类或图搜索。在这项工作中,我们将文本分割制定为一个监督学习问题,并提出了一个用于文本分割的大型新数据集,该数据集从维基百科中自动提取并标记。此外,我们基于该数据集开发了一个分段模型,并表明它很好地概括为看不见的自然文本。

1 介绍

文本分割是将文本分割的任务,使得每个片段局部是一致的,截止点表明了主题的变化 (赫斯特,1994; 乌提亚马和伊萨哈拉,2001; brants等,2002)。这为文档提供了基本结构,其方式可供下游应用程序 (如摘要和信息提取) 使用。用于文本分割的现有数据集很小。

自然语言处理的最新发展已经证明,与基于启发式的系统或无监督算法相比,将问题作为有监督的学习任务处理大量标记的数据是非常有效的 (Mikolov et等,2013; 彭宁顿等人,2014)。因此,在这项工作中,我们 (a) 将文本分割制定为一个监督学习问题,其中文档中每个句子的标签表示它是否结束一个分割,(b) 描述用于训练文本分割模型的新数据集WIKI-727K。

WIKI-727K由来自英语维基百科的727,000多个文档组成,其中每个文档的目录用于自动分割文档。由于这个数据集很大,很自然,并且涵盖了各种各样的主题,我们希望它能很好地推广到其他自然文本中。此外,与现有数据集相比,WIKI-727K为评估文本分割模型提供了更好的基准。我们在github上公开发布WIKI-727K和代码

为了证明该数据集的有效性,我们开发了一个分层神经模型,其中a的大小 (崔,2000;Glavas等人,2016),以及较低级别的双向LSTM创建句子.

并且主要用于评估seg- mentation算法的性能。此外,一些数据集 (崔,2000) 是自动合成的,因此不代表文档中文本的自然分布。因为没有大的标记数据集存在,先前关于文本分割的工作试图提出启发式方法来验证两个句子是否讨论同一主题 (崔,2000;Glava · 等人,2016),或使用诸如LDA (Blei等,2003) 之类的方法明确地对主题进行建模,这些方法将主题分配给每个段落或句子(陈等人,2009年)。

∗两位作者对本文的贡献相同,作者顺序是随机确定的。

来自单词令牌的表示,然后更高级别的LSTM使用句子表示和标记每个句子。我们展示了我们的模型优于先前的方法,证明了我们的数据集对文本分割未来进展的重要性。

2 相关工作

2.1 现有文本分割数据集

用于评估文本分割性能的最常见数据集是choi (2000) 创建的。这是一个包含920个文档的合成数据集,其中每个文档包含10个来自棕色区域的随机段落。glava等人 (2016年) 创建了他们自己的数据集,该数据集由来自宣言项目的5个手动分段的政治宣言组成。1 (陈等人,2009年) 还使用英语维基百科文档来评估文本分段。他们改进了两个数据集,一个有100份关于主要城市的文件,一个有118份关于化学元素的文件。表1提供了每个数据集的其他统计信息。

因此,所有现有的用于文本分割的数据集都很小,并且不能受益于训练监督模型相对于标记数据的优势。

2.2 以前的方法

贝叶斯文本分割方法 (陈等人,2009;Riedl和Biemann,2012) 采用文本的一般概率模型。在这些模型中,文档被表示为一组主题,这些主题是从主题分布中采样的,并且每个主题都在词汇上强加了一个分布。riedlBiemann(2012) 在这一系列方法中表现最好,他们定义了成对句子之间的连贯性得分,并通过寻找相邻句子对之间的相关分数下降来计算分割。

另一个值得注意的文本分割方法是GRAPHSEG (glavas等人,2016),一种无监督图方法,它在合成数据集上具有竞争力,在宣言数据集上优于贝叶斯方法。GRAPHSEG的工作原理是建立一个图表,其中节点是句子,两个句子之间的边表示句子在本质上是相似的。然后通过找到相邻句子的最大团来确定分割,并启发式地完成分割。

3 数据集WIKI-727K

对于这项工作,我们创建了一个新的数据集,我们将其命名为WIKI-727K。它是727,746个英语维基百科文档的集合,以及它们在内容中出现的层次分割。我们将文档随机划分为训练集 (80%),开发 (10%),

不同的文本分割用例需要不同级别的粒度。例如,对于通过总体主题来分割文本,训练一个只预测顶级细分的模型是有意义的,顶级细分通常因主题而异 — 例如,“历史”,“地理” 和 “演示图形”。为了将广播分割成单独的新闻故事,这需要更好的粗俗,训练一个模型来预测子片段是有意义的。我们的数据集提供了整个细分信息,应用程序可以选择适当的粒度级别。

为了生成数据,我们对每个维基百科文档执行了以下预处理步骤:

- 删除了所有照片、表格、维基百科模板元素和其他非文本元素。

- 删除单句段、少于三个段的文档以及过滤大多数段的文档。

- 使用NLTK库的PUNKT标记器将每个部分分成句子 (Bird等人,2009年)。这对于使用我们的数据集作为基准是必要的,因为没有明确定义的句子分割,就不可能评估不同的模型。

我们认为WIKI-727K适合文本选择,因为它是自然的、开放域的,并且具有定义明确的分割。此外,神经网络模型通常受益于丰富的训练数据,并且我们的数据集可以很容易地以非常低的成本进一步扩展。

4 文本分割的神经模型

我们将文本分割视为监督学习任务,其中输入x是文档,表示为n个句子的序列s1,…,sn,

并且标签y = (y1,…,yn-1) 是文档的分段,由n 1二进制值表示,其中yi表示si是否结束段。

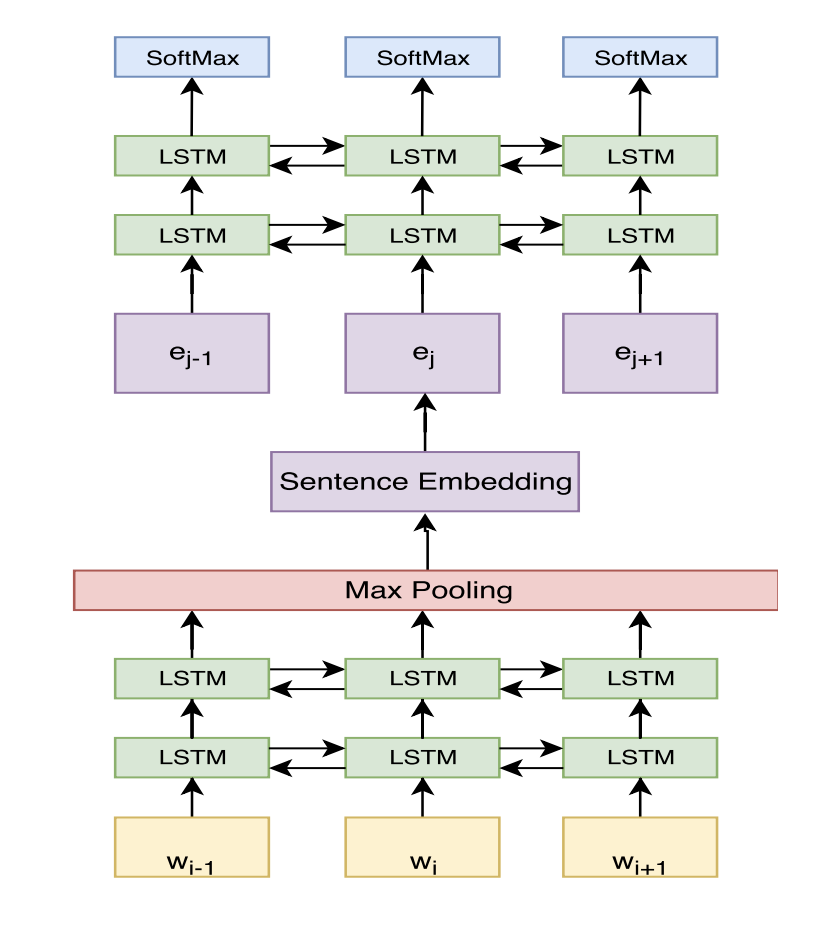

我们现在描述我们的文本分割模型。我们的神经模型是由两个基于LSTM体系结构的子网络组成的 (Hochreiter和Schmidhuber,1997)。较低级别的子网络是一个两层双向LSTM,它生成句子表示: 对于每个句子si,网络包含单词w(i),……,si的w(i) 一个接一个,最后的句子表示ei是通过LSTM输出的最大集合来计算的。

更高级别的子网络是分段预测网络。该子网络将一系列句子嵌入e1,…,en作为输入,并将它们馈送到两层双向

LSTM。然后,我们在每个LSTM输出上应用一个完全连接的层,以获得r2中的n个向量序列。我们忽略最后一个向量 (对于en),并应用softmax函数获得n 1

分段概率。

图1说明了整体神经网络架构。

4.1 Training

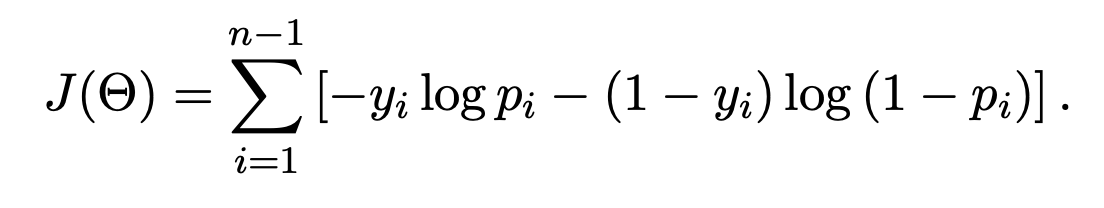

我们的模型预测对于每个句子si,它结束一段的概率pi。对于n句文档,我们将n-1相关句子中每个句子的交叉熵误差之和最小化:

训练是通过端到端的随机梯度下降来完成的。对于单词嵌入,我们使用GoogleNews word2vec预训练模型。我们训练我们的系统只预测顶级细分 (其他粒度是可能的)。此外,在培训期间,我们从每个文档中删除了第一部分,因为在维基百科中,它通常是一个涉及许多不同主题的摘要,并且因此对于训练分割模型的用处较小。我们还省略了列表和代码片段令牌。

4.2 推理

在测试时间,该模型采用一系列单词嵌入,分为句子,并返回句子之间截止概率的向量p。我们使用贪婪解码,即每当pi大于阈值 τ 时,我们就创建一个新的序列。我们在验证集中优化参数 τ,并在测试时使用最佳值。

5 实验细节

我们评估方法WIKI-727测试套装,崔合纤数据集,两个小维基百科数据集 (城市,元素) 介绍陈等人 (2009)。我们将我们的模型性能陈等人 (2009) 和GRAPHSEG的报告进行了比较。此外,我们评估随机基线模型的性能,该模型在每个句子之后以1 k的概率开始一个新的片段,其中k是数据集中的平均片段大小。

因为我们的测试集很大,所以很难评估一些计算要求很高的现有方法。因此,我们介绍了WIKI-50,这是一组来自WIKI-727K的50个随机抽样的测试文档。我们使用WIKI-50来评估系统,这些系统速度太慢,无法对整个测试集进行评估。我们还提供WIKI-50的人类个体绩效结果。

我们使用inBeeferman等人 (1999) 定义的Pk度量来评估我们模型的性能。Pk是当通过大小为k的滑动窗口超过句子时,窗口边界处的传感器将被正确分类为属于同一部分 (反之亦然)。为了匹配chen等人 (2009) 的设置,当评估他们论文中的数据集时,我们也为字数滑动窗口提供Pk度量。接下来 (glavas等人,2016),我们将k设置为地面真实分割中平均分割大小的一半。对于评估,我们使用了SEGEVAL包 (Fournier,2013)。

除了分段精度之外,我们还报告在中档笔记本电脑上运行时的运行时间。

我们注意到分割结果不是直接可比的。例如陈等人 (2009) 要求数据集中的所有文档讨论同一主题,因此他们的方法并不直接适用于WIKI-50。不过,我们尝试在表2中进行比较。

5.1 Accuracy

将我们的方法与GRAPHSEG进行比较,我们可以看到GRAPHSEG在合成崔数据集上给出了更好的结果,但是这种成功并没有延续到自然维基百科数据上,在那里它们的表现低于随机基线。我们通过指出,由于数据集是相互关联的,并且是通过连接不相关的文档创建的,因此即使是简单的字数计算方法inChoi(2000) 也可以获得合理的成功。GRAPHSEG使用词嵌入向量之间的相似性测量来超越字数计算方法,但是在自然文档中,单词相似性可能不足以检测单个文档中主题的变化。在word级别,涉及完全不同主题的两个文档比一个文档中的两个部分更容易区分。

Table 1:各种文本分割数据集的统计信息。

| WIKI-727K | CHOI | MANIFESTO | CITIES | ELEMENTS | |

|---|---|---|---|---|---|

| Documents | 727,746 | 920 | 5 | 100 | 118 |

| Segment Length2 | 13.6 ± 20.3 | 7.4 ± 2.96 | 8.99 ± 10.8 | 5.15 ± 4.57 | 3.33 ± 3.05 |

| Segments per document2 | 3.48 ± 2.23 | 9.98 ± 0.12 | 127 ± 42.9 | 12.2 ± 2.79 | 6.82 ± 2.57 |

| Real-world | ✓ | ( | ✓ | ✓ | ✓ |

| Large variety of topics | ✓ | ( | ( | ( | ( |

Table 2: Pk 测试集的结果。

| Pk variant | WIKI-727K __sentences |

WIKI-50 sentences |

CHOI __sentences |

CITIES sentences __words |

ELEMENTS sentences __words |

||

|---|---|---|---|---|---|---|---|

| (Chen et al.,2009) | - | - | - | - | 22.1 | - | |

| GraphSeg | - | 63.56 | 39.95 - | 49.12 - | |||

| Our model | 22.13 | 26.263 | 33.82 | ||||

| Random baseline | 53.09 | 52.65 | 49.43 | 47.14 | 44.14 | 50.08 | 42.80 |

| Human performance | - | 14.97 | - | - | - | - | - |

我们将toChen等人 (2009) 的方法从他们的pa- per的两个小维基百科数据集进行比较。我们的方法在城市上优于他们的方法,在元素上获得了更差的结果,在这些元素上,我们的单词嵌入质量可能较低,已经在谷歌新闻上接受过培训,人们可能期望化学领域的技术词汇很少被使用。我们认为这个结果令人信服,因为我们没有证明所有的文件有陈等人 (2009) 的相似结构这一事实,并且没有针对这些数据集进行特定的训练,但是仍然能够证明有竞争力的表现。

有趣的是,人类在WIKI-50上的表现仅比我们的模型略好。我们假设,因为注释者只注释了少量的文档,他们仍然不熟悉分段的正确粒度级别,因此,与已经看到许多文件的模型相比,它们处于劣势。

5.2 Run Time

我们方法的运行时间在文档中的字数和句子数上是线性的 O(N + V) 的渐近复杂度,其中N是最长句子的长度,V是句子的数量,k是最大的团大小。此外,神经网络模型是高度可并行的,并受益于在图形处理器上运行。

Table 3: 每个文档的平均运行时间 (秒)。

| WIKI-50 | |

|---|---|

| Our model (CPU) | 1.6 |

| GRAPHSEG (CPU) | 23.6 |

6 结论

在这项工作中,我们提出了一个用于文本分割的大型标记数据集WIKI-727K,该数据集能够使用监督学习方法来训练神经模型。这缩小了在文学中存在的差距,到目前为止,文本分割模型是以无监督的方式训练的。

我们的文本分割模型在维基百科文档上优于先前的方法,并且在先前的基准上具有竞争力。此外,我们的系统在文本长度上具有线性运行时间,并且可以在现代GPU硬件上运行。我们认为,为了使文本分割系统在现实世界中有用,它们必须能够分割必要的自然文本,并且这项工作提供了实现该目标的途径。

在今后的工作中,我们将在句子层面探索更丰富的神经模型。另一个重要的方向是开发一个结构化的全局模型,该模型将考虑所有局部预测,然后执行全局细分决策。

鸣谢

我们感谢匿名评论者的建设性反馈。这项工作得到了以色列科学基金会942/16号拨款的支持。

References

Doug Beeferman, Adam Berger, and John Lafferty. 1999. Statistical models for text segmentation. Ma- chine learning 34(1):177–210.

S. Bird, E. Loper, and E. Klein. 2009. Natural Lan- guage Processing with Python. OReilly Media Inc.

D. Blei, A. Ng, and M. I. Jordan. 2003. Latent Dirichlet allocation. Journal of Machine Learning Research (JMLR) 3:993–1022.

Thorsten Brants, Francine Chen, and Ioannis Tsochan- taridis. 2002. Topic-based document segmentation with probabilistic latent semantic analysis. In Pro- ceedings of the eleventh international conference on Information and knowledge management. ACM, pages 211–218.

Harr Chen, SRK Branavan, Regina Barzilay, and David R Karger. 2009. Global models of document structure using latent permutations. In Proceedings of Human Language Technologies: The 2009 An- nual Conference of the North American Chapter of the Association for Computational Linguistics. As- sociation for Computational Linguistics, pages 371– 379.

Freddy YY Choi. 2000. Advances in domain indepen- dent linear text segmentation. In Proceedings of the 1st North American chapter of the Association for Computational Linguistics conference. Association for Computational Linguistics, pages 26–33.

Chris Fournier. 2013. Evaluating Text Segmentation using Boundary Edit Distance. In Proceedings of 51st Annual Meeting of the Association for Compu- tational Linguistics. Association for Computational Linguistics, Stroudsburg, PA, USA, page to appear.

Goran Glavasˇ, Federico Nanni, and Simone Paolo Ponzetto. 2016. Unsupervised text segmentation us- ing semantic relatedness graphs. Association for Computational Linguistics.

Marti A Hearst. 1994. Multi-paragraph segmentation of expository text. In Proceedings of the 32nd an- nual meeting on Association for Computational Lin- guistics. Association for Computational Linguistics, pages 9–16.

Sepp Hochreiter and Ju¨rgen Schmidhuber. 1997. Long short-term memory. Neural computation 9(8):1735–1780.

T. Mikolov, W. Yih, and G. Zweig. 2013. Linguis- tic regularities in continuous space word represen- tations. In hlt-Naacl. volume 13, pages 746–751.

Jeffrey Pennington, Richard Socher, and Christo- pher D. Manning. 2014.Glove: Global vectors for word representation. In Empirical Methods in Natural Language Processing (EMNLP). pages

1532–1543. http://www.aclweb.org/anthology/ D14-1162.

Martin Riedl and Chris Biemann. 2012. Topictiling: a text segmentation algorithm based on lda. In Pro- ceedings of ACL 2012 Student Research Workshop. Association for Computational Linguistics, pages 37–42.

Masao Utiyama and Hitoshi Isahara. 2001. A statis- tical model for domain-independent text segmenta- tion. In Proceedings of the 39th Annual Meeting on Association for Computational Linguistics. Associa- tion for Computational Linguistics, pages 499–506.