主要工作

这是商汤科技CVPR 2017的一篇工作。

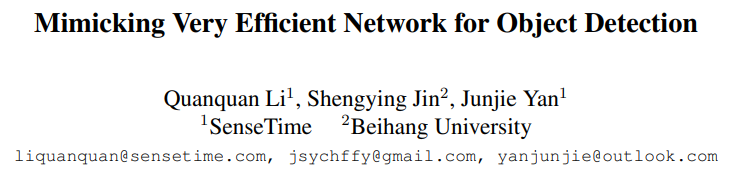

文章中mimic的方法在使用本身ground-truth监督小模型训练的同时,加入大小模型之间feature map的监督,使得mimic的效果会更好。 由于feature map的维度太高,包含太多全局的信息,而对于仅有少量目标的feature map,通常只有微弱的响应。因此,将学习整个feature map变为学习proposal采样之后的feature来简化任务。 在由小网络生成的proposal中,使用spatial pyramid pooling方法在大小网络上进行局部特征采样,然后通过L2 loss减小二者之间的差别。

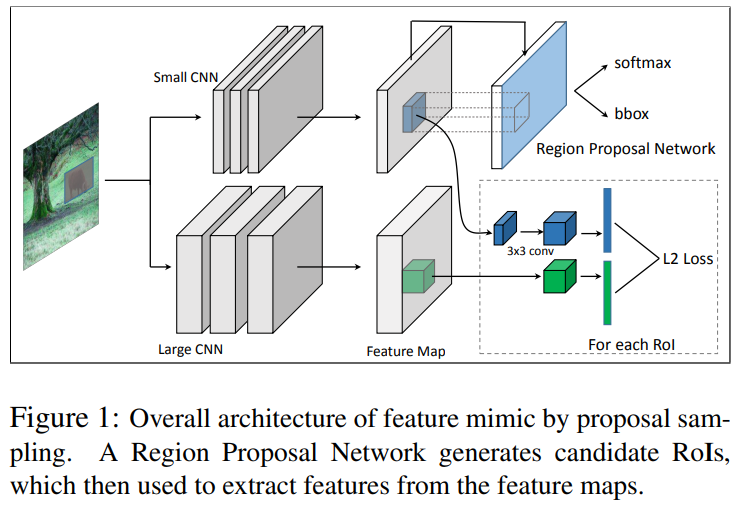

主要结构

对于不同尺寸输入的学生网络和教师网络,这时的模型需要进行尺寸的匹配。

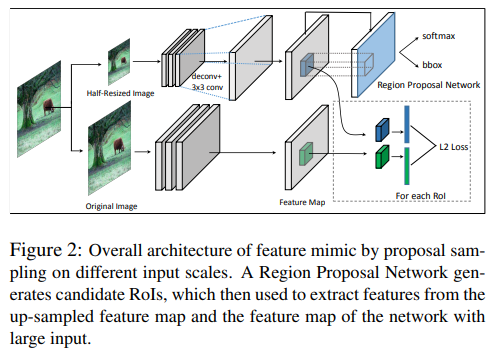

损失函数

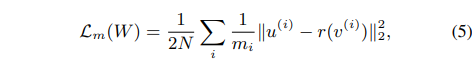

这里的Lm中的ui表示从大模型特征图中第i个提案区域中采样的特征。vi表示从小模型中采样特征,而这里的r表示一个回归函数来转换vi到与ui相同的维度。

这里的Lm表示mimick损失,使用L2损失,Lgt表示区域提案网络的分类和回归损失。作者在实验中发现,对于mimic loss进行normalization可以取得更为稳定的mimic结果,而且这时候只需要简单的将平衡权重设置为1即可:

另外,在faster rcnn中stage2 fast rcnn的训练过程中,也可以添加大网络的监督信号(监督框的classification以及regression),使得小网络可以学习到更多大网络的有效信息,得到更好的结果。