本案例中是一个自动编写程序抓取互联网数据并分析的Agents的使用,可以通过自然语言交互的方式观察Agents是如何一步步完成代码编写,并完成任务处理的。 与数据分析Agents不同的是,本Agents中从代码编写到数据抓取、分析全部是Agents完成的,支持直接从互联网爬取数据进行分析。

使用步骤

以下是数据爬取分析Agents智能体使用步骤:

- 编写智能体, 在本案例中,我们已经写好了代码编写助手

CodeAssistantAgent,源码dbgpt/agent/agents/expand/code_assistant_agent.py - 插入元数据

- 选择对话场景

- 开始对话

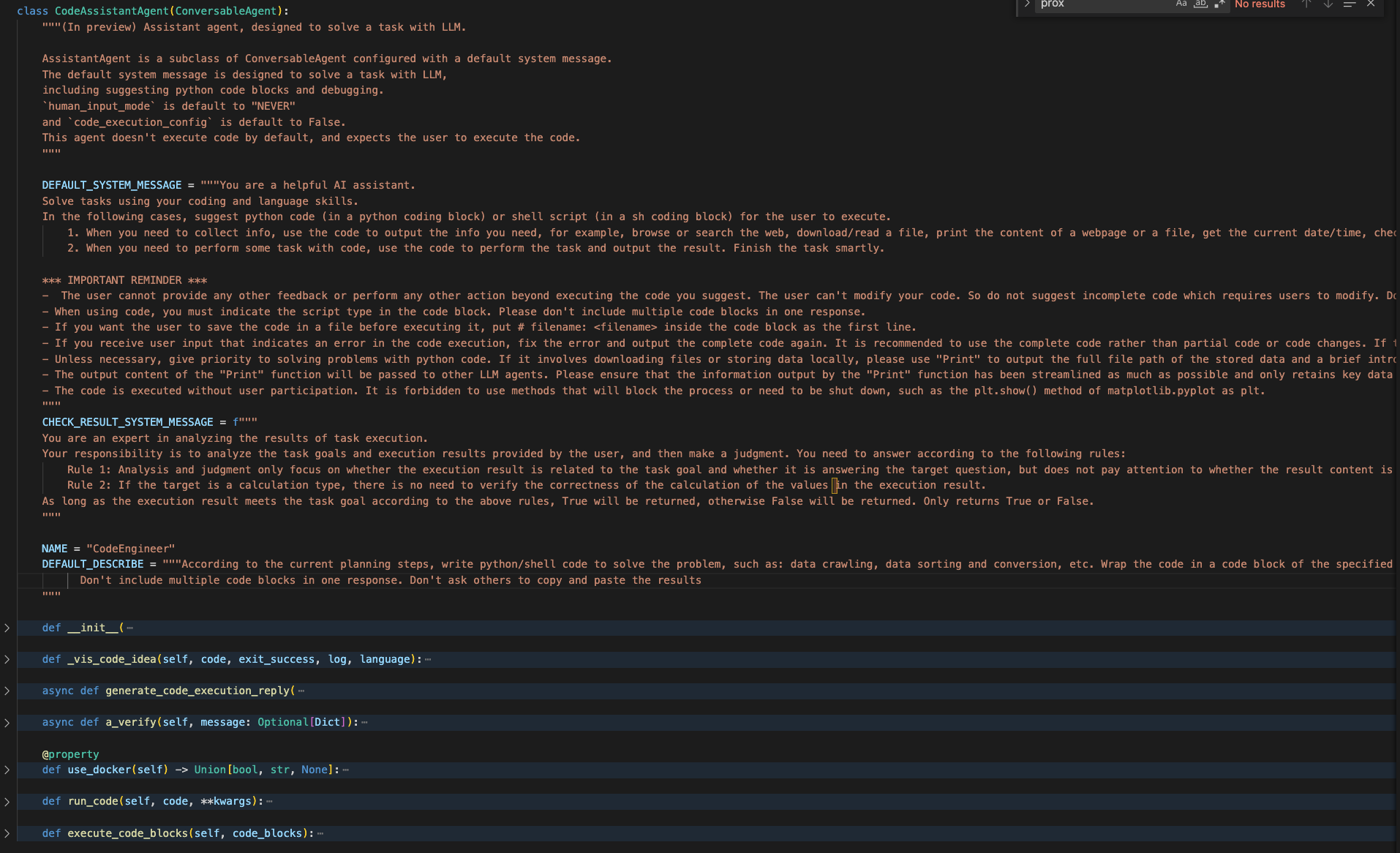

编写智能体

在本案例中使用的智能体已经在代码中完成编写,详细的代码路径在dbgpt/agent/agents/expand/code_assistant_agent.py, 代码详情如下。

:::color1

同时dbgpt/agent/agents/expand路径下,实现了其他几个Agents, 感兴趣的同学可以自行拓展。

:::

插入元数据

插入元数据的目的,是我们可以在交互界面使用智能体进行交互。

INSERT INTO dbgpt.gpts_instance(gpts_name, gpts_describe, resource_db, resource_internet, resource_knowledge, gpts_agents, gpts_models, `language`, user_code, sys_code, created_at, updated_at, team_mode, is_sustainable)VALUES ('互联网数据分析助手','互联网数据分析助手','','{"type": "\\u4e92\\u8054\\u7f51\\u6570\\u636e", "name": "\\u6240\\u6709\\u6765\\u6e90\\u4e92\\u8054\\u7f51\\u7684\\u6570\\u636e", "introduce": "string"}','{"type": "\\u6587\\u6863\\u7a7a\\u95f4", "name": "TY", "introduce": " MYSQL\\u6570\\u636e\\u5e93\\u7684\\u5b98\\u65b9\\u64cd\\u4f5c\\u624b\\u518c"}','[ "CodeEngineer"]','{"DataScientist": ["vicuna-13b-v1.5", "tongyi_proxyllm", "chatgpt_proxyllm"], "CodeEngineer": ["chatgpt_proxyllm", "tongyi_proxyllm", "vicuna-13b-v1.5"], "default": ["chatgpt_proxyllm", "tongyi_proxyllm", "vicuna-13b-v1.5"]}','en','','','2023-12-19 01:52:30','2023-12-19 01:52:30','auto_plan',0);

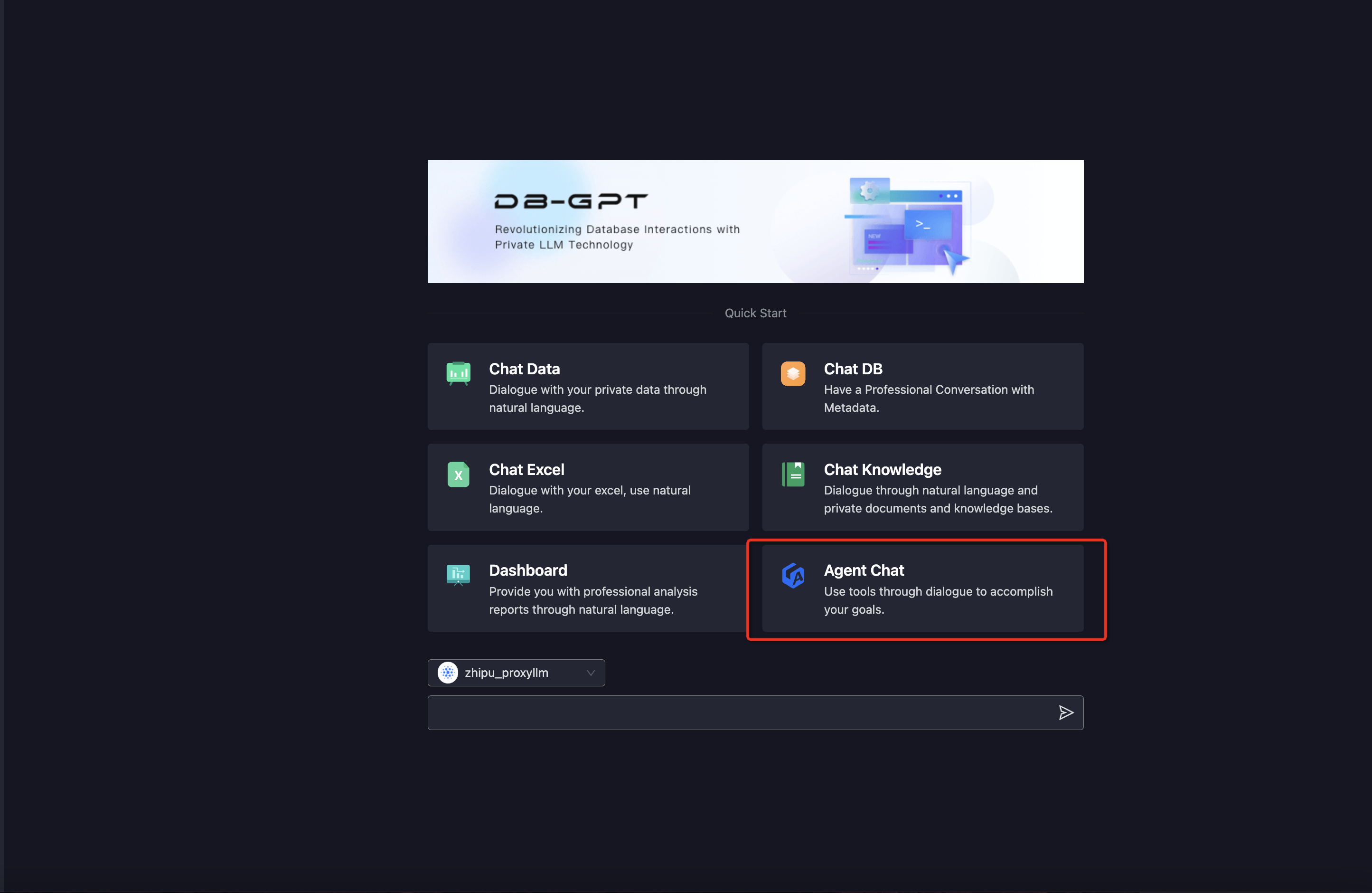

选择对话场景

我们选择Agent Chat场景。

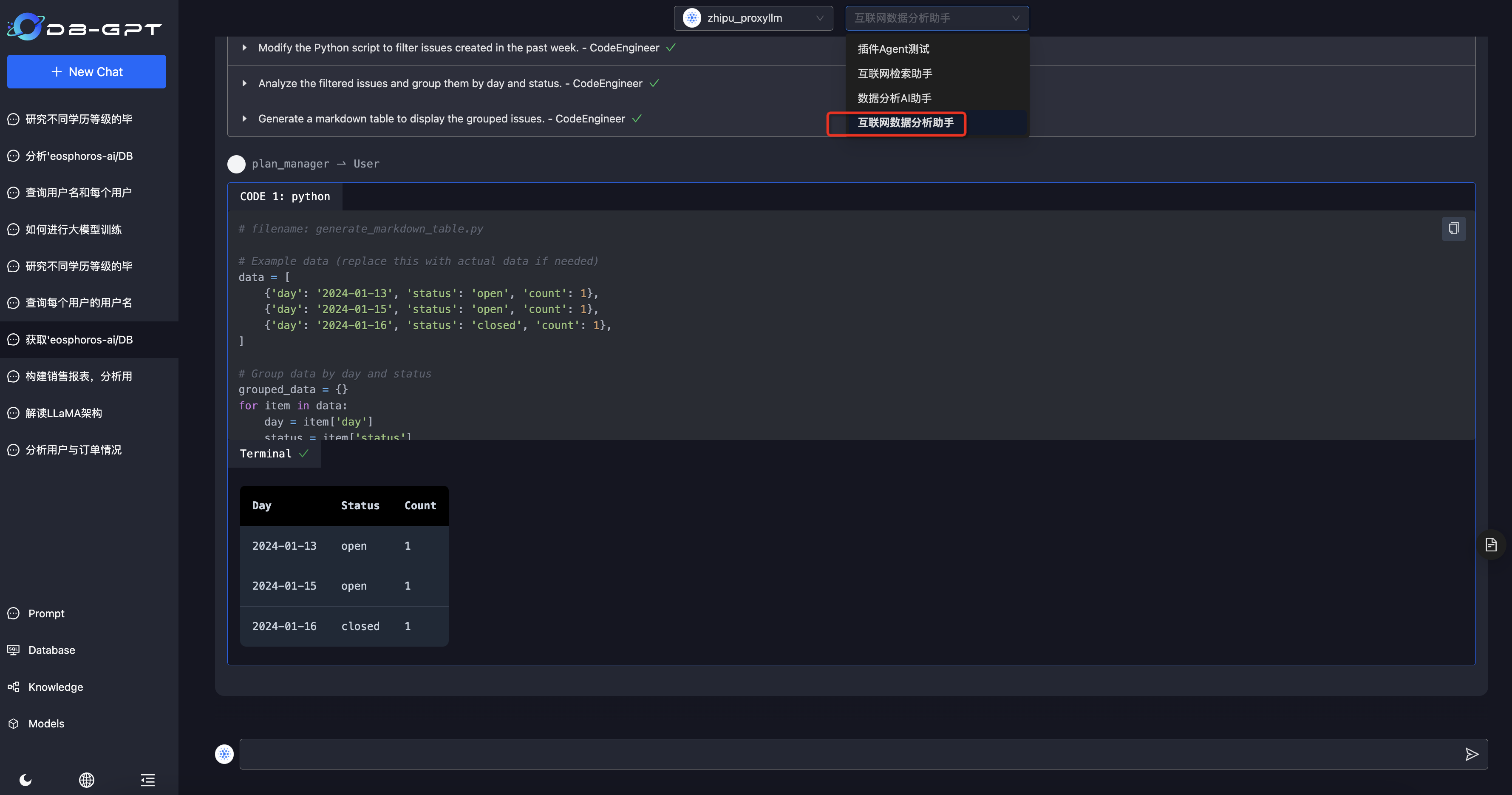

进入场景后,选择我们刚刚准备好的互联网数据分析助手Agent, 接下来就可以通过对话的方式来完成需求了。

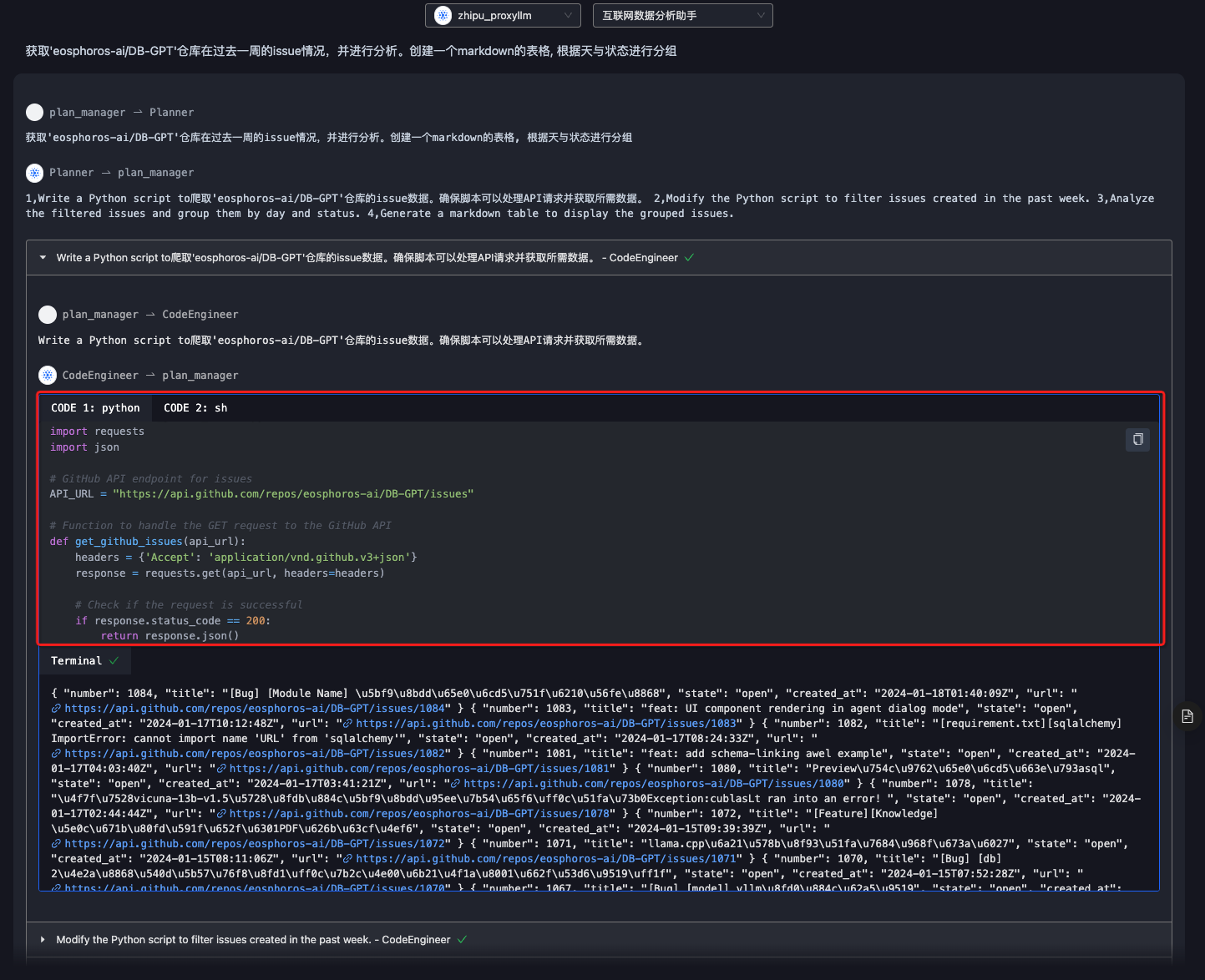

获取’eosphoros-ai/DB-GPT’仓库在过去一周的issue情况,并进行分析。创建一个markdown的表格, 根据天与状态进行分组