最佳实践

Ubuntu

Ubuntu下nfs的服务端是nfs-kernel-server客户端是nfs-common

所以共享源只需要安装nfs-kernel-server即可

客户端服务器安装好nfs-common 之后 mount -t nfs <共享源主机名或IP地址>:<共享目录> <挂载点目录> 即可

Centos/Rockylinux

centos 服务端需要安装nfs-utils 和rpcbind客户端只需要安装nfs-utils

挂载方式同Ubuntu

重启之后挂载失效

修改客户端 /etc/fstab

<共享源主机名或IP地址>:<共享目录> <挂载点目录> nfs defaults 0 2

一、NFS工作原理

1、什么是NFS服务器

NFS就是Network File System的缩写,它最大的功能就是可以通过网络,让不同的机器、不同的操作系统可以共享彼此的文件。

NFS服务器可以让PC将网络中的NFS服务器共享的目录挂载到本地端的文件系统中,而在本地端的系统中来看,那个远程主机的目录就好像是自己的一个磁盘分区一样,在使用上相当便利;

2、NFS挂载原理

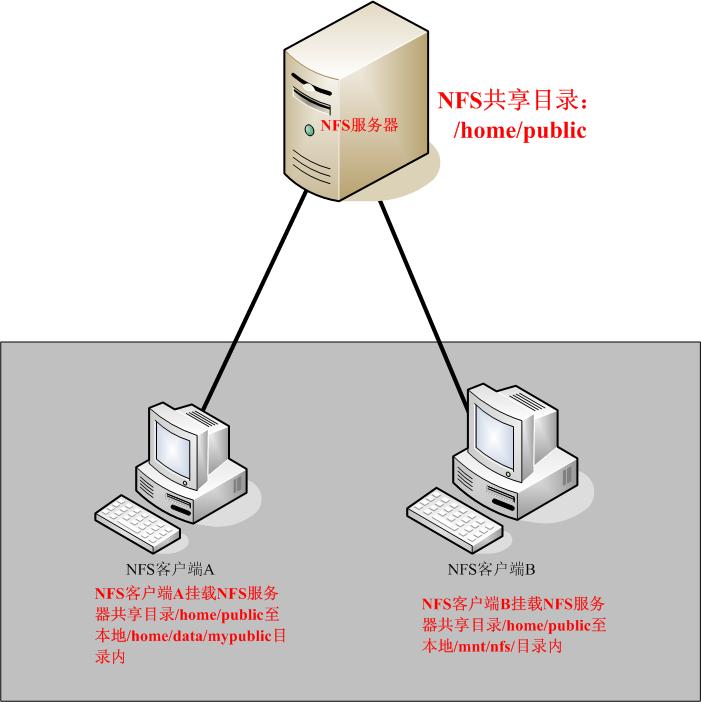

NFS服务器的挂载结构图:

如上图示:

当我们在NFS服务器设置好一个共享目录/home/public后,其他的有权访问NFS服务器的NFS客户端就可以将这个目录挂载到自己文件系统的某个挂载点,这个挂载点可以自己定义,如上图客户端A与客户端B挂载的目录就不相同。并且挂载好后我们在本地能够看到服务端/home/public的所有数据。如果服务器端配置的客户端只读,那么客户端就只能够只读。如果配置读写,客户端就能够进行读写。挂载后,NFS客户端查看磁盘信息命令:#df –h。

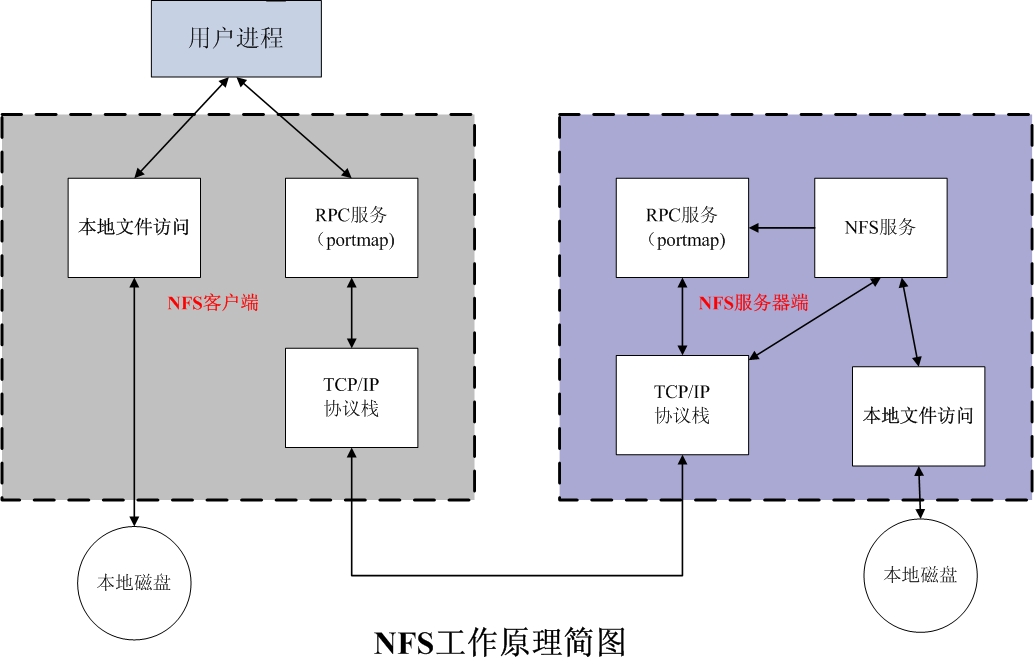

既然NFS是通过网络来进行服务器端和客户端之间的数据传输,那么两者之间要传输数据就要有想对应的网络端口,NFS服务器到底使用哪个端口来进行数据传输呢?基本上NFS这个服务器的端口开在2049,但由于文件系统非常复杂。因此NFS还有其他的程序去启动额外的端口,这些额外的用来传输数据的端口是随机选择的,是小于1024的端口;既然是随机的那么客户端又是如何知道NFS服务器端到底使用的是哪个端口呢?这时就需要通过远程过程调用(Remote Procedure Call,RPC)协议来实现了!

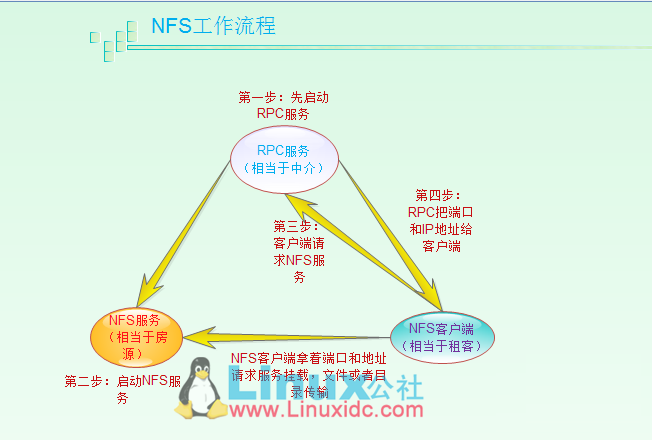

3、RPC与NFS如何通讯

因为NFS支持的功能相当多,而不同的功能都会使用不同的程序来启动,每启动一个功能就会启用一些端口来传输数据,因此NFS的功能对应的端口并不固定,客户端要知道NFS服务器端的相关端口才能建立连接进行数据传输,而RPC就是用来统一管理NFS端口的服务,并且统一对外的端口是111,RPC会记录NFS端口的信息,如此我们就能够通过RPC实现服务端和客户端沟通端口信息。PRC最主要的功能就是指定每个NFS功能所对应的port number,并且通知客户端,记客户端可以连接到正常端口上去。

那么RPC又是如何知道每个NFS功能的端口呢?

首先当NFS启动后,就会随机的使用一些端口,然后NFS就会向RPC去注册这些端口,RPC就会记录下这些端口,并且RPC会开启111端口,等待客户端RPC的请求,如果客户端有请求,那么服务器端的RPC就会将之前记录的NFS端口信息告知客户端。如此客户端就会获取NFS服务器端的端口信息,就会以实际端口进行数据的传输了。

提示:在启动NFS SERVER之前,首先要启动RPC服务(即portmap服务,下同)否则NFS SERVER就无法向RPC服务区注册,另外,如果RPC服务重新启动,原来已经注册好的NFS端口数据就会全部丢失。因此此时RPC服务管理的NFS程序也要重新启动以重新向RPC注册。特别注意:一般修改NFS配置文档后,是不需要重启NFS的,直接在命令执行/etc/init.d/nfs reload或exportfs –rv即可使修改的/etc/exports生效。

4、NFS客户端和NFS服务端通讯过程

1)首先服务器端启动RPC服务,并开启111端口

2)服务器端启动NFS服务,并向RPC注册端口信息

3)客户端启动RPC(portmap服务),向服务端的RPC(portmap)服务请求服务端的NFS端口

4)服务端的RPC(portmap)服务反馈NFS端口信息给客户端。

5)客户端通过获取的NFS端口来建立和服务端的NFS连接并进行数据的传输。

二、entos 安装配置nfs

1、 查看系统信息

[root@server7 ~]# cat /etc/redhat-releaseCentOS release 7.3.1611 (AltArch)root@server7 ~]# uname -aLinux server7.ctos.zu 3.10.0-514.el7.centos.plus.i686 #1 SMP Wed Jan 25 12:55:04 UTC 2017 i686 i686 i386 GNU/Linux

要养成一个习惯,就是先查看系统版本和内核参数。同一个软件在不同版本,内核之间是有差异的,所以部署的方法也不一样,不要因为这个而造成不必要的错误。

2、NFS软件安装

要部署NFS服务,必须安装下面两个软件包:nfs-utils:NFS主程序,rpcbind:PRC主程序;

NFS服务器端和Client端都需要这安装这两个软件。

注意:NFS的RPC服务器,Centos5下名字为portmap,CentOS6和CentOS7下名称为rcpbind

NFS软件包

nfs-utils:NFS主程序,包含rpc.nfsd rpc.mount两个deamons

rpcbind:RPC主程序

2.1、查看NFS软件包

[root@server7 ~]# rpm -qa | egrep "nfs|rpcbind"[root@server7 ~]#

我的CentOS release 7.3.1611是最小化安装,默认没有安装nfs和rpcbind

Yum搜寻下安装包是否存在

[root@server7 ~]# yum search nfs-utils rpcbind

2.2、安装NFS和RPC服务

[root@server7 ~]# yum install nfs-utils rpcbind[root@server7 ~]# rpm -qa | egrep "nfs|rpcbind"rpcbind-0.2.0-38.el7_3.1.i686nfs-utils-1.3.0-0.33.el7_3.i686libnfsidmap-0.25-15.el7.i686

查看这两个软件包在电脑里都安装了什么文件;

[root@server7 ~]# rpm -ql nfs-utils

3、启动NFS服务

3.1、启动NFS服务之前先启动rpcbind服务

查看rcpbind状态

[root@server7 ~]# systemctl status rpcbind● rpcbind.service - RPC bind serviceLoaded: loaded (/usr/lib/systemd/system/rpcbind.service; indirect; vendor preset: enabled)Active: active (running) since 一 2017-09-04 10:03:20 CST; 1s agoProcess: 3583 ExecStart=/sbin/rpcbind -w $RPCBIND_ARGS (code=exited, status=0/SUCCESS)Main PID: 3584 (rpcbind)CGroup: /system.slice/rpcbind.service└─3584 /sbin/rpcbind -w9月 04 10:03:19 server7.ctos.zu systemd[1]: Starting RPC bind service...9月 04 10:03:20 server7.ctos.zu systemd[1]: Started RPC bind service.

注:rpcbind安装成功后默认已经开启,并且为开机自动启动。如果没有启动的话,我们来重新启动rcpbind服务

[root@server7 ~]# systemctl restart rpcbind

查看PRC端口

[root@server7 ~]# yum install net-tools lsof[root@server7 ~]# lsof -i:111COMMAND PID USER FD TYPE DEVICE SIZE/OFF NODE NAMEsystemd 1 root 56u IPv6 43164 0t0 TCP *:sunrpc (LISTEN)systemd 1 root 57u IPv4 43165 0t0 TCP *:sunrpc (LISTEN)rpcbind 3584 rpc 4u IPv6 43164 0t0 TCP *:sunrpc (LISTEN)rpcbind 3584 rpc 5u IPv4 43165 0t0 TCP *:sunrpc (LISTEN)rpcbind 3584 rpc 8u IPv4 44975 0t0 UDP *:sunrpcrpcbind 3584 rpc 10u IPv6 44977 0t0 UDP *:sunrpc[root@server7 ~]# netstat -tlunp |grep rpcbindudp 0 0 0.0.0.0:111 0.0.0.0:* 3584/rpcbindudp 0 0 0.0.0.0:791 0.0.0.0:* 3584/rpcbindudp6 0 0 :::111 :::* 3584/rpcbindudp6 0 0 :::791 :::* 3584/rpcbind

未启动NFS之前查看NFS服务向PRC注册的端口信息

[root@server7 ~]# rpcinfo -p localhostprogram vers proto port service100000 4 tcp 111 portmapper100000 3 tcp 111 portmapper100000 2 tcp 111 portmapper100000 4 udp 111 portmapper100000 3 udp 111 portmapper100000 2 udp 111 portmapper

3.2、RPC服务启动后再启动NFS服务

查看状态

[root@server7 ~]# systemctl status nfs● nfs-server.service - NFS server and servicesLoaded: loaded (/usr/lib/systemd/system/nfs-server.service; disabled; vendor preset: disabled)Active: inactive (dead)

默认未启动,系统开机重启后不启动,启动nfs服务,将设置为开机启动。

[root@server7 ~]# systemctl start nfs[root@server7 ~]# systemctl enable nfsCreated symlink from /etc/systemd/system/multi-user.target.wants/nfs-server.service to /usr/lib/systemd/system/nfs-server.service.[root@server7 ~]# systemctl status nfs● nfs-server.service - NFS server and servicesLoaded: loaded (/usr/lib/systemd/system/nfs-server.service; enabled; vendor preset: disabled)Active: active (exited) since 一 2017-09-04 10:15:21 CST; 19s agoMain PID: 3654 (code=exited, status=0/SUCCESS)CGroup: /system.slice/nfs-server.service9月 04 10:15:21 server7.ctos.zu systemd[1]: Starting NFS server and services...9月 04 10:15:21 server7.ctos.zu systemd[1]: Started NFS server and services.

启动NFS后我们再次查看rpc注册的端口信息

[root@server7 ~]# rpcinfo -p localhostprogram vers proto port service100000 4 tcp 111 portmapper100000 3 tcp 111 portmapper100000 2 tcp 111 portmapper100000 4 udp 111 portmapper100000 3 udp 111 portmapper100000 2 udp 111 portmapper100024 1 udp 56626 status100024 1 tcp 42691 status100005 1 udp 20048 mountd100005 1 tcp 20048 mountd100005 2 udp 20048 mountd100005 2 tcp 20048 mountd100005 3 udp 20048 mountd100005 3 tcp 20048 mountd100003 3 tcp 2049 nfs100003 4 tcp 2049 nfs100227 3 tcp 2049 nfs_acl100003 3 udp 2049 nfs100003 4 udp 2049 nfs100227 3 udp 2049 nfs_acl100021 1 udp 57225 nlockmgr100021 3 udp 57225 nlockmgr100021 4 udp 57225 nlockmgr100021 1 tcp 35665 nlockmgr100021 3 tcp 35665 nlockmgr100021 4 tcp 35665 nlockmgr

在确认启动没用问题后我们看一看NFS到底开了哪些端口

[root@server7 ~]# netstat -tulnp |grep -E '(rpc|nfs)'tcp 0 0 0.0.0.0:42691 0.0.0.0:* LISTEN 3634/rpc.statdtcp 0 0 0.0.0.0:20048 0.0.0.0:* LISTEN 3642/rpc.mountdtcp6 0 0 :::39614 :::* LISTEN 3634/rpc.statdtcp6 0 0 :::20048 :::* LISTEN 3642/rpc.mountdudp 0 0 127.0.0.1:842 0.0.0.0:* 3634/rpc.statdudp 0 0 0.0.0.0:20048 0.0.0.0:* 3642/rpc.mountdudp 0 0 0.0.0.0:111 0.0.0.0:* 3584/rpcbindudp 0 0 0.0.0.0:791 0.0.0.0:* 3584/rpcbindudp 0 0 0.0.0.0:56626 0.0.0.0:* 3634/rpc.statdudp6 0 0 :::56122 :::* 3634/rpc.statdudp6 0 0 :::20048 :::* 3642/rpc.mountdudp6 0 0 :::111 :::* 3584/rpcbindudp6 0 0 :::791 :::* 3584/rpcbind

4、NFS常见进程详解

[root@server7 ~]# ps -ef |egrep "rpc|nfs“rpc 3584 1 0 10:03 ? 00:00:00 /sbin/rpcbind -wrpcuser 3634 1 0 10:15 ? 00:00:00 /usr/sbin/rpc.statd --no-notifyroot 3637 2 0 10:15 ? 00:00:00 [rpciod]root 3642 1 0 10:15 ? 00:00:00 /usr/sbin/rpc.mountdroot 3652 1 0 10:15 ? 00:00:00 /usr/sbin/rpc.idmapdroot 3657 2 0 10:15 ? 00:00:00 [nfsd4_callbacks]root 3663 2 0 10:15 ? 00:00:00 [nfsd]root 3664 2 0 10:15 ? 00:00:00 [nfsd]root 3665 2 0 10:15 ? 00:00:00 [nfsd]root 3666 2 0 10:15 ? 00:00:00 [nfsd]root 3667 2 0 10:15 ? 00:00:00 [nfsd]root 3668 2 0 10:15 ? 00:00:00 [nfsd]root 3669 2 0 10:15 ? 00:00:00 [nfsd]root 3670 2 0 10:15 ? 00:00:00 [nfsd]root 3705 3267 0 10:23 pts/0 00:00:00 grep -E --color=auto rpc|nfs

- nfsd

最主要的NFS服务提供程序,这个daemon主要的功能就是管理客户端是否能够使用服务器文件系统挂载信息,其中还包含判断这个登录用户的ID。

- rpc.mountd

这个daemon主要功能则是管理NFS的文件系统。当client端顺利通过rpc.nfsd登入主机后,在它可以使用NFS服务器提供规定文件之前,还会经过文件使用权限的认证程序。它会去读取NFS的配置 文件/etc/exports来对比客户端的权限,当通过这一关之后,client端也就取得使用NFS文件的权限。

- rpc.lockd (非必要)

这个daemon用于管理文件的锁定方面,当多个客户端同时尝试写入某个文件时就可以对该文件造成一些问题。rpc.lockd则可以用来克服这此问题。但rpc.lockd必须要同时在客户端和服务器端都开 启才行。

- rpc.statd(非必要)

这个daemon可以用来检查文件的一致性,若发生因为客户端同时使用同一个文件造成文件损坏时,rpc.statd可以用来检测并尝试恢复该文件

5、配置NFS服务

NFS软件很简单,主要配置文件:/etc/exports,默认这个里面内容是空的,如果没有这个文件,可以使用vim主动建立这个文件。至于NFS服务器的搭建也很简单,只要编辑好主要配置文件/etc/exports之后,先启动rpcbind(若已经启动了,就不要重新启动),然后再启动nfs,NFS就成功了。

那么/etc/exports应该如何设置?

[root@server7 etc]# vi /etc/exports/tmp/data 192.168.1.0/24(ro) client-A.ctos.zu(rw,sync)#[共享目录] [客户端地址1(权限)] [客户端地址2(权限)]

以上是一个简单案例配置,每一行最前面是要共享出来的目录,注意是以目录为单位的

共享目录:存在于我们本机上的目录,我们想共享给网络上的其他主机使用。如我要共享/tmp/data目录,那么此选项可以就直接写/tmp/data目录,这个目录可以依照不同的权限共享给不同的主机。

客户端地址1(参数1,参数2):客户端地址能够设置一个网络,也可以设置单个主机。参数:如读写权限rw,同步更新sync,压缩来访账号all_squash,压缩后的匿名账号anonuid=uid,anongid=gid等等;

客户端地址的设置主要有以下几种方式:

1)、 可以使用完整的IP或者是网络号,例如192.168.100.100 或 192.168.8.0/24

2)、 可以使用主机名,但这个主机名必须要在/etc/hosts内,或可以使用DNS找到该名称才行,反正重点是可找到IP就行,如果是主机名的话,还可以支持通配符,例如‘*’或‘?’均可接受;例如:host[1-8].ctos.zu,server?.test.com

NFS权限设置

NFS配置权限设置,即/etc/exports文件配置格式中小括号()里的参数集;

| 参数命令 | 参数用途 |

|---|---|

| rw | 表示可读写 |

| ro | Read-only表示只能读权限 |

| Sync | 请求或者写入数据时,数据同步写入到NFS server的硬盘中后才会返回 |

| no_root_squas | 访问nfs server共享目录的用户如果是root的话,它对该目录具有root权限。这个配置原本为无盘用户准备的。用户应避免使用! |

| root_squash | 对于访问NFS server共享目录的用户,如果是root的话会被压缩成为nobody用户身份。 |

| all_squash | 不管访问nfs server共享目录的用户身份如何包括root,它的权限都将被压缩成为匿名用户,同时他们的udi和gid都会变成nobody或nfsnobody账户的uid,gid。在多个nfs客户端同时读写nfs server数据时,这个参数很有用可以确保大家写入的数据的权限是一样的。 但不同系统有可能匿名用户的uid,gid不同。因为此处我们需要服务端和客户端之间的用户是一样的。比如说:服务端指定匿名用户的UID为2000,那么客户端也一定要存在2000这个账号才可以 |

| anonuid | anonuid就是匿名的uid和gid。说明客户端以什么权限来访问服务端,在默认情况下是nfsnobody。Uid65534. |

| anongid | 同anongid,就是把uid换成gid而已 |

配置实例:

/home/test 1192.168.1.0/24(rw,sync,all_squash,anonuid=2000,anongid=2000)

注意红色部分不能有空格!!生产环境中常用的一种配置,适合多客户端共享一个NFS目录。All_squash 也就是说不管客户端是以什么样的身份来进行访问的,都会被压缩成为all_squash后面所接的用户和群组身份。这边用anonuid、anongid编号来标示。=

服务器共享配置格式:

1)基本格式:共享目录 ip/24(共享属性) ->注意无空格

2)共享权限设置:

rw读写属性

sync文件实际写入磁盘后才返回

all_squash:所有访问用户均被压缩成后续接的用户。

anonuid:默认压缩的用户

anongid:默认压缩的用户组

那么客户端以什么身份来访问?

客户端访问服务端默认是使用nfsnobody这个用户来进行访问的。uid和gid为65534。服务器默认共享时,也是加上了all_squash这个参数。并制定anonuid为65534(也就是nfsnobayd用户)。当然如果系统中nfsnobody是其他的uid,那么就有可能造成访问权限出现问题。所以最好我们可以通过一设置一个用户来访问,统一UID、GID。

挂载情况怎样呢?

有两个重要的文件,能够解决这个疑问。/var/lib/nfs/etab、/var/lib/nfs/rmtab这两个文件就能够查看服务器上共享了什么目录,到底有多少客户端挂载了共享,能查看到客户端挂载的具体信息。

1、etab这个文件能看到服务器上共享了哪些目录,执行哪些人可以使用,并且设定的参数为何。

2、rmtab这个文件就是能够查看到共享目录被挂载的情况。