GRU/LSTM/深层RNN/双向RNN

GRU

RNN存在的问题:梯度较容易出现衰减或爆炸(BPTT)

⻔控循环神经⽹络:捕捉时间序列中时间步距离较大的依赖关系

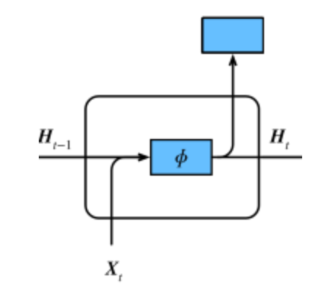

RNN:

Ht=ϕ(XtWxh+Ht−1Whh+bh)

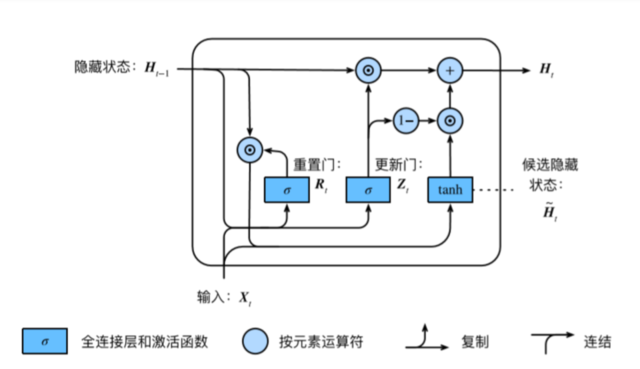

GRU:

Rt=σ(XtWxr+Ht−1Whr+br)

Zt=σ(XtWxz+Ht−1Whz+bz)

H~t=tanh(XtWxh+(Rt⊙Ht−1)Whh+bh)

Ht=Zt⊙Ht−1+(1−Zt)⊙H~t

• 重置⻔有助于捕捉时间序列⾥短期的依赖关系;

• 更新⻔有助于捕捉时间序列⾥⻓期的依赖关系。

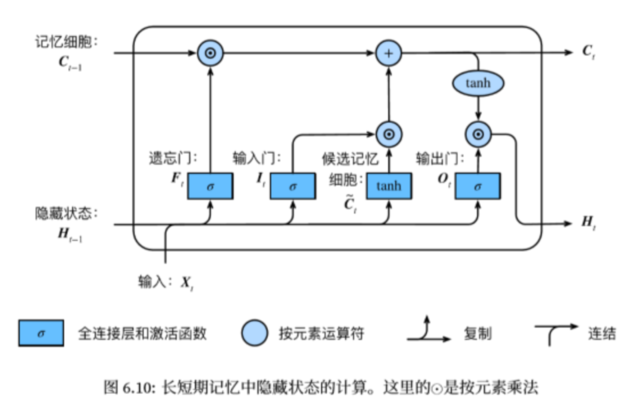

LSTM

长短期记忆long short-term memory :

遗忘门:控制上一时间步的记忆细胞

输入门:控制当前时间步的输入

输出门:控制从记忆细胞到隐藏状态

记忆细胞:⼀种特殊的隐藏状态的信息的流动

It=σ(XtWxi+Ht−1Whi+bi)

Ft=σ(XtWxf+Ht−1Whf+bf)

Ot=σ(XtWxo+Ht−1Who+bo)

C~t=tanh(XtWxc+Ht−1Whc+bc)

Ct=Ft⊙Ct−1+It⊙C~t

Ht=Ot⊙tanh(Ct)

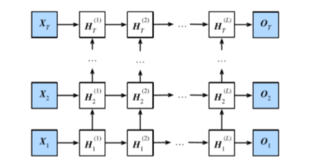

深度循环神经网络

Ht(1)=ϕ(XtWxh(1)+Ht−1(1)Whh(1)+bh(1))

Ht(ℓ)=ϕ(Ht(ℓ−1)Wxh(ℓ)+Ht−1(ℓ)Whh(ℓ)+bh(ℓ))

Ot=Ht(L)Whq+bq

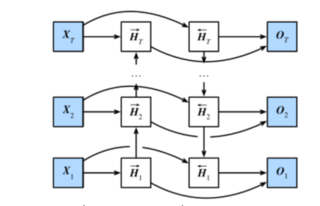

双向循环神经网络

H→t=ϕ(XtWxh(f)+H→t−1Whh(f)+bh(f))

H←t=ϕ(XtWxh(b)+H←t+1Whh(b)+bh(b))

Ht=(H→t,H←t)

Ot=HtWhq+bq